Dalam repositori koleksi mandiri yang penuh gairah ini, Anda akan menemukan banyak pembelajaran mesin, penambangan data, dan tantangan rekayasa data yang telah saya tangani, sejauh ini. Sepanjang pedoman ini Anda akan berjalan melalui rincian proyek dan repositori.

Saya harap Anda akan menikmati saat memeriksa repositori yang terkait dengan ML, penambangan data dan rekayasa data di atas meja, di bawah ini.

Anda dapat menghubungi saya kapan pun Anda ingin mendapatkan informasi lebih lanjut tentang proyek.

| Masalah | Metode | Libs | Repo |

|---|---|---|---|

| Konversi halaman arahan | AB Testing , Z test | pandas , statsmodel | Klik |

| Integrasi Model Fashion Mnist (CNN) ke dalam Tensorboard dan MLFLOW | CNN , Deep Learning | Keras , MLflow , Pandas , Sklearn | Klik |

| Dockerize Application Apache Flink melalui Docker | Apache Flink Table & SQL | Apache Flink Table & SQL , Docker , Docker-Compose | Klik |

| Crawler sebagai layanan | Pencarian ( DFS , BFS ) | GO , Neo4j , Redis , Docker , Docker-Compose | Klik |

| Prediksi melompati aksi pada dataset musik | LightGBM , Linear Reg , Logistic Reg. | Sklearn , LightGBM , Pandas , Seaborn | Klik |

| Klasifikasi gaya rambut | LightGBM , TF-IDF | Sklearn , LightGBM , Pandas , Seaborn | Klik |

| Analisis Seri Waktu oleh Sarimax | ARIMA , SARIMAX | statsmodels , pandas , sklearn , seaborn | Klik |

| Masalah klasifikasi multi-bahasa dan multi-label pada dataset mode | LightGBM , TF-IDF | Sklearn , LightGBM , Pandas , Seaborn | Klik |

| Mana yang menangkap seluruh* SMS spam? | Naive Bayesian , SVM , Random Forest Classifier , Deep Learning - LSTM , Word2Vec | Sklearn , Keras , Gensim , Pandas , Seaborn | Klik |

| Novel mana yang saya miliki? | Deep Learning - LSTM , Word2Vec | Sklearn , Keras , Gensim , Pandas , Seaborn | Klik |

| Mengapa pelanggan memilih dan memesan kendaraan tertentu? | Random Forest Classifier | Sklearn , Pandas , Seaborn | Klik |

| Peramalan Dampak Promo (Promo1, Promo2) pada Penjualan di Jerman, Austria, dan Prancis | Random Forest Regressor , ARIMA , SARIMAX | statsmodels , pandas , sklearn , seaborn | Klik |

| Tutorial klasifikasi hutan acak di pyspark | Random Forest Classifier | Spark (PySpark) , Sklearn , Pandas , Seaborn | Klik |

| Pengayaan Data Spasial: Bergabunglah dengan dua dataset geolokasi dengan menggunakan KDTREE | Kd-tree | cKDTree | Klik |

| Implementasi algoritma K-Means dari awal di Java | K-Means | Java SDK | Klik |

| Peramalan harga spot AWS dengan menggunakan Adaboostting di RapidMiner | Adaboost Classifier , Decision Tree | Rapidminer | Klik |

Tolong, gulir ke bawah untuk melihat detail proyek secara komprehensif dan kunjungi repositori mereka.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Conversion | Pengecer | AB Testing , Z test | pandas , statsmodel | https://github.com/ERDIOLMEZOGULLARI/ML-AB-TESTING |

Dalam proyek ini, pengujian A/B dilakukan pada dataset kursus Udacity. Terdiri dari 5 kolom, <user_id, timestamp, group, landing_page, converted> . Dalam pengujian A/B, kami menggunakan 3 kolom dari mereka, group, landing_page, and converted .

Kami pernah mensimulasikan beberapa percobaan n kali sehubungan dengan tingkat konversi ( control, treatment ) yang sudah diperoleh melalui dataset. Setelah mendapatkan ide lebih lanjut tentang dataset dengan simulasi ini, kami menduga hipotesis nol dan tesis alternatif. Untuk mengklaim kelembagaan hipotesis alternatif kami, kami menghitung skor kritis Z dengan menggunakan metode Z test sehubungan dengan alpha (0,05), dan kemudian kami memeriksa beta, dan daya sehubungan dengan ukuran efek percobaan.

Harap perhatikan bahwa Anda dapat memeriksa ab_test.md untuk mendapatkan informasi lebih lanjut tentang tes hipotesis dan pengujian A/B dengan beberapa foto penting.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Prediction | Fashion Mnist | CNN , Deep Learning | Keras , MLflow , Pandas , Sklearn | https://github.com/erdiolmezogullari/ml-fmnist-mlflow-tensorboard |

Dalam proyek ini, kami menggunakan Docker Container Technologies untuk membuat platform ML dari awal. Ini terdiri dari empat wadah Docker yang berbeda (MLFLOW, Notebook, Postgres, Tensorboard) yang sudah dibangun di docker-compose.yml

Rincian kontainer dapat ditemukan di bawah direktori ./platform . Setiap layanan kontainer memiliki DockerFile khusus yang sesuai dengan direktori (MLFLOW, Notebook, Postgres, Tensorboard) di bawah Direktori Platform

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Implementation | Klik Dataset Stream | Apache Flink Table & SQL | Apache Flink Table & SQL , Docker , Docker-Compose | https://github.com/erdiolmezogullari/de-flink-sql-as-a-docker |

Dalam proyek ini, kami menggunakan Docker Container Technologies untuk meluncurkan Flink Cluster dan Flink App secara terpisah dari awal. Flink Cluster (platform) terdiri dari dua wadah Docker yang berbeda (JobManager, TaskManager) yang sudah dibangun di Docker-compose.flink.yml. Aplikasi Flink terdiri dari satu wadah Docker yang sudah menggunakan DockerFile (./app-flink-base/dockerfile) dan skrip shell (./app-flink-base/run.sh) untuk mengirimkan file jar ke cluster di Docker-compose-app-flink.yml.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Implementation | N/a | Pencarian ( BFS , DFS ) | GO , Neo4j , Redis , Docker , Docker-Compose | https://github.com/erdiolmezogullari/de-crawler-as-a-service |

Dalam proyek ini, layanan crawler sederhana diimplementasikan dari awal, dan diintegrasikan ke dalam sistem Redis dan Neo4j NoSQL dengan menggunakan Docker dan Docker-compose . Layanan crawler merangkak URL target pertama, dan kemudian, mengunjungi sisa URL dalam dokumen HTML yang diambil, masing -masing dan rekursif. Saat merangkak dokumen HTML yang sesuai dengan URL, itu bisa merujuk pada 1 dari 2 algoritma pencarian yang berbeda ( BFS, DFS ). Algoritma pencarian itu didorong oleh go routines di GO untuk mempercepat layanan merangkak.

Selama merangkak, ada kemungkinan bahwa sekelompok rutinitas GO yang akan dibuat dapat mengambil dan memproses dokumen HTML yang sama pada saat yang sama. Dalam hal ini, crawler dapat membuat data yang tidak konsisten. Dengan demikian, sistem NoSQL nilai kunci Redis lebih disukai menggunakan dalam proyek ini untuk menyelesaikan masalah itu dan membangun sistem yang kuat dan konsisten.

Setiap URL dapat merujuk pada URL lain yang berbeda atau dirinya sendiri dalam dokumen HTML. Hubungan antara dua URL dapat memanggil sebagai tautan. Ada cara mudah sederhana untuk mewakili tautan dan URL yang dirangkak dengan menggunakan struktur data tertentu, yaitu grafik. Dengan demikian, grafik Neo4j NoSQL digunakan untuk mewakili dan memvisualisasikan grafik yang terdiri dari URL dan tautan. Selama merangkak, layanan merangkak adalah membuat simpul baru untuk setiap URL dan tautan baru untuk setiap pasangan URL, atau memperbarui node dan tautan yang ada di Neo4j dengan menggunakan kueri Cypher , juga.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Prediction | Dataset Musik | LightGBM , Linear Reg , Logistic Reg. | Sklearn , LightGBM , Pandas , Seaborn | https://github.com/erdiolmezogullari/ml-prediction-skip-action |

Dalam proyek ini, kita perlu memprediksi probabilitas aksi lewati yang dibuat oleh pendengar, yang mendengarkan musik. Karena kami tidak memiliki kelas yang sudah diberi label oleh siapa pun. Dalam keadaan ini, kita perlu membuat label target yang dapat menyelesaikan masalah. Jadi, setiap variabel target kontinu harus dipilih sebagai fitur target. Menurut fitur yang kami buat, per_listen (percentage of listen) akan lebih cocok untuk masalah itu karena jelas memberikan ide tentang melewatkan tindakan. Jika kita memilihnya sebagai fitur target, masalah ini akan menghasilkan masalah penilaian/probabilitas karena memiliki rasio waktu mendengarkan, yang cenderung antara 0 hingga 1.

Jika kita ingin mengonversi masalah itu menjadi masalah classfication, kita dapat menentukan treshold untuk melewatkan Aciton sebagai aturan thump. per_listen menunjukkan berapa banyak persentase trek yang didengarkan oleh pendengar. Jadi, ambang batas kami bisa 25%, 50% bahkan 51% dan seterusnya. Namun, sebelum membuat keputusan, kami dapat memeriksa fungsi distribusi kumulatif komplementer (CCDF) dari per_listen . Itu akan memberi gambaran tentang ambang batas ReasonAnle kita. Menurut plot berikut, kami memiliki 65% instance, yang nilainya Per_Listen lebih besar dari 0,5. Oleh karena itu, 0,5 masuk akal, ketika kita memikirkannya lebih realistis, kurang dari 0,5 di sekitar 0,25 akan lebih cocok menentukan tindakan melewatkan apa pun.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Classification | Dataset Gaya Rambut | LightGBM , TF-IDF | Sklearn , LightGBM , Pandas , Seaborn | https://github.com/ERDIOLMEZOGULLARI/ML-HAIRSTYLE-CLASSIFIKASI |

Dalam proyek ini, dataset berisi sampel 10000 gambar yang ditambang dari Instagram dan dikelompokkan berdasarkan gaya rambut yang mereka tunjukkan.

cluster variabel mewakili kluster gaya rambut yang telah ditugaskan oleh gambar oleh algoritma pengenalan visual.

Setiap baris berisi url variabel yang merupakan tautan ke gambar dan jumlah suka bersama dengan comments per gambar. user_id adalah ID unik dari akun Instagram dari mana posting berasal dan id variabel adalah pengidentifikasi unik yang terkait dengan posting itu sendiri.

Setiap posting berisi tanggal ( date_unix ) dalam format UNIX ketika gambar diposting di Instagram dan juga tanggal telah dikonversi ke format yang berbeda ( date_week -> Non -ISO Jumlah minggu ini, date_month -> Bulan, date_formated -> Tanggal Lengkap DD/MM/YY) Sebagian untuk digunakan dalam analisis sebelumnya. Jangan ragu untuk mengonversi variabel itu dengan cara yang sesuai dengan analisis Anda.

Selain itu, classifier influencer_flag ditambahkan ke masing -masing gambar yang memiliki lebih dari 500 suka, menandai mereka sebagai posting influencer.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Time Series Analysis | Statistik kerja | ARIMA , SARIMAX | statsmodels , pandas , sklearn , seaborn | https://github.com/ERDIOLMEZOGULLARI/ML-SER-SERIES-ANALYSIS-SARIMAX |

Dalam proyek ini, kami menggunakan teknik analisis deret waktu untuk menguraikan data kami menjadi 3 komponen seperti di bawah ini:

1-Trend (T)

2-Seasonility (S)

3-Residual (R)

Begitu kita perlu mendapatkan dataset statinory sebelum melakukan analisis rangkaian waktu (TSA) dengan sempurna karena akan mudah membuat predikisi atas dataset stasioner karena sudah akan memenuhi preoperti distribusi normal dalam hal rata -rata dan varian, secara kasar. Jadi, kita perlu mempelajari dataset mentah dengan menerapkan beberapa teknik EDA untuk mengekspos wawasan data yang berharga terkait dengan tren, dan musiman jika dimungkinkan untuk mengamati di EDA. Setelah kami menyelesaikan tahap analisis data, kami perlu memilih teknik terbaik yang tersedia (misalnya Arima, Sarimax) untuk tampil pada dataset sesuai dengan pengetahuan kami yang akan kami dapatkan di EDA.

Pada tahap EDA, kami akan menerapkan banyak teknik seperti, boxploting, statictics bergulir (rata -rata, STD) berdasarkan fitur berbasis waktu (tahun, bulan, hari, hari kerja dan kuartal) untuk mencari tahu 2 komponen (tren, musiman) dari 3 komponen seri waktu di atas plot tertentu, kasar. Plot -plot itu akan memberikan umpan balik yang masuk akal untuk TSA sebelum memulainya.

Pada tahap TSA, kami akan membangun model yang berbeda untuk pendekatan non-musim dan musiman dengan menggunakan ARIMA dan SARIMAX dalam paket Statsmodels, masing-masing.

Karena bagian TSA yang paling menantang adalah menemukan parameter optimal (p, d, q) dan (p, d, q, s) dari teknik -teknik tersebut, kami akan mengacu pada autokorelasi (ACF) dan autokorelasi parsial (PACF) untuk mengetahui rata -rata autokresi (PACF) (AR) yang rata -rata dalam hal autokresi (AR). (Sam).

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Classification | Dataset mode | LightGBM , TF-IDF | Sklearn , LightGBM , Pandas , Seaborn | https://github.com/ERDIOLMEZOGULLARI/MULTI-LABEL-CLASSIFIKASI |

Dalam proyek ini, dataset dikumpulkan di berbagai situs Web mode. Ini terdiri dari 7 bidang seperti di bawah ini.

id : Pengidentifikasi produk yang unikname : Judul produk, seperti yang ditampilkan di situs web kamidescription : Deskripsi produkprice : Harga produkshop : Toko tempat Anda dapat membeli produk inibrand : Merek Produklabels : Label kategori yang berlaku untuk produk iniFitur teks (nama, deskripsi) ada dalam bahasa yang berbeda, seperti bahasa Inggris, Jerman dan Rusia. Format fitur target adalah multilabel (60 kategori) yang ditandai sesuai dengan kategori di situs web mode secara berbeda.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

NLP | Teks | Naive Bayesian , SVM , Random Forest Classifier , Deep Learning - LSTM , Word2Vec | Sklearn , Keras , Gensim , Pandas , Seaborn | https://github.com/ERDIOLMEZOGULLARI/ML-PAM-SMS-CLASSIFIKASI |

Dalam proyek ini, kami menerapkan algoritma pembelajaran (klasifikasi) yang diawasi dan pembelajaran mendalam (LSTM).

Kami menggunakan dataset spam SMS publik, yang bukan dataset murni bersih. Data terdiri dari dua kolom (fitur) yang berbeda, seperti konteks, dan kelas. Konteks kolom mengacu pada SMS. Kelas kolom dapat mengambil nilai yang dapat berupa spam atau ham yang sesuai dengan konteks SMS terkait.

Sebelum menerapkan metode pembelajaran yang diawasi, kami menerapkan banyak operasi pembersihan data untuk menghilangkan data yang berantakan dan kotor karena memiliki beberapa konteks yang rusak dan berantakan.

Setelah mendapatkan dataset yang dibersihkan, kami membuat token dan lemma dari SMS corpus secara terpisah dengan menggunakan spacy, dan kemudian, kami masing-masing menghasilkan tas dan TF-IDF dari SMS corpus, masing-masing. Selain transformasi data ini, kami juga melakukan SVD, SVC, PCA untuk mengurangi dimensi dataset.

Untuk mengelola transformasi data dalam fase pelatihan dan pengujian secara efektif dan menghindari kebocoran data, kami menggunakan kelas pipa SkLearn. Jadi, kami menambahkan setiap langkah transformasi data (misalnya bag-of-word , TF-IDF , SVC ) dan Classifier (misalnya Naive Bayesian , SVM , Random Forest Classifier ) ke dalam contoh Pipeline kelas.

Setelah menerapkan metode pembelajaran yang diawasi, kami juga melakukan pembelajaran mendalam. Arsitektur pembelajaran mendalam kami yang kami gunakan didasarkan pada LSTM. Untuk melakukan LSTM mendekati di keras (TensorFlow), kami perlu membuat matriks embedding dari korpus kami. Jadi, kami menggunakan pendekatan Word2VEC Gensim untuk mendapatkan matriks embedding, bukan TF-IDF.

Di akhir setiap pemrosesan dengan classifier yang berbeda, kami merencanakan matriks kebingungan untuk membandingkan mana yang mana yang diklasifikasi terbaik untuk memfilter SMS spam.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

NLP | Teks | Deep Learning - LSTM , Word2Vec | Sklearn , Keras , Gensim , Pandas , Seaborn | https://github.com/erdiolmezogullari/ml-deep-learning-keras-novel |

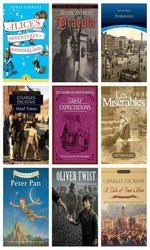

Proyek ini terkait dengan masalah klasifikasi teks yang kami tangani dengan model Deeplearing (LSTM) , yang mengklasifikasikan paragraf sewenang -wenang yang dikumpulkan lebih dari 12 novel yang berbeda secara acak, di atas:

1. alice_in_wonderland

2. dracula

3. dubliners

4. great_expectations

5. hard_times

6. huckleberry_finn

7. les_miserable

8. moby_dick

9. oliver_twist

10. peter_pan

11. talw_of_two_cities

12. tom_sawyer

Dengan kata lain, Anda dapat memikirkan novel -novel itu adalah kelas target kami dari dataset kami. Untuk membedakan kelas paragraf yang sebenarnya, laten semantik di antara paragraf akan memainkan peran penting. Oleh karena itu, kami menggunakan Deeplearing (LSTM) di atas Keras (Tensorflow) setelah membuat matriks embedding oleh Gensim's word2vec .

Jika ada laten semantik di antara kalimat dalam paragraf yang sesuai, kami memikirkan paragraf yang sama dikumpulkan dari sumber daya yang sama (novel) yang paling mungkin.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Imbalanced Data | Pemesanan mobil | Random Forest Classifier | Sklearn , Pandas , Seaborn | https://github.com/ERDIOLMEZOGULLARI/ML-IMHALADED-CAR-BOOKING-Data |

Dalam proyek ini, kami membangun model pembelajaran mesin yang menjawab pertanyaan, -Apa preferensi pelanggan - pada dataset pemesanan mobil.

Kami menjelajahi dataset dengan menggunakan Seaborn , dan mengubah, fitur baru yang diturunkan diperlukan.

Selain itu, bentuk dataset imbalanced . Ini berarti bahwa distribusi variabel target condong. Untuk mengatasi tantangan itu, sudah ada beberapa teknik yang berbeda (misalnya over/under re-sampling techniques ) dan pendekatan intuitif. Kami juga mencoba menyelesaikan masalah itu menggunakan teknik resampling.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Forecasting - Timeseries | Penjualan | Random Forest Regressor | statsmodels , pandas , sklearn , seaborn | https://github.com/ERDIOLMEZOGULLARI/ML-SER-SERIES-ANALYSISTON-SLALES-DATA |

Dalam proyek ini, kita perlu melakukan analisis deret waktu untuk mendapatkan wawasan baru tentang promo. Ada toko -toko yang memberikan dua jenis promo seperti radio, TV yang sesuai dengan Promo1 dan Promo2 sehingga mereka ingin meningkatkan penjualan mereka di Jerman, Austria, dan Prancis. Namun, mereka tidak tahu tentang promo mana yang cukup untuk melakukannya. Jadi, dampak promo pada penjualan mereka adalah peran penting pada preferensi mereka.

Untuk mendefinisikan strategi promo yang terdefinisi dengan baik, kita pernah perlu menganalisis data dalam hal dampak promo. Dalam hal ini, karena data didasarkan pada deret waktu, kami pernah merujuk untuk menggunakan time series decomposition . Setelah kami terurai data observed menjadi trend , seasonal , dan komponen residual , kami mengekspos dampak promo dengan jelas untuk membuat keputusan yang promo mana yang lebih baik di setiap negara.

Selain itu, kami menggunakan Random Forest Regression dalam masalah peramalan ini untuk meningkatkan keputusan kami.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

ML Service | Dihasilkan secara acak | Random Forest Classifier | Flask , Docker , Redis , Sklearn | https://github.com/erdiolmezogullari/ml-dockerized-microservice |

Dalam proyek ini, ML based micro-service dikembangkan di atas REST dan Docker setelah membangun model pembelajaran mesin dengan melakukan Random Forest

Kami menggunakan docker-compose untuk meluncurkan layanan mikro, di bawah ini.

1.Jupyter Notebook,

2.Restful Comm. (Flask),

3.Redis

Setelah kami membuat tiga wadah yang berbeda, Mlass kami akan siap.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

PySpark | Dihasilkan secara acak | Random Forest Classifier | Spark (PySpark) , Sklearn , Pandas , Seaborn | https://github.com/erdiolmezogullari/ml-random-forest-pyspark |

Dalam proyek ini, Anda dapat menemukan banyak kode sampel yang terkait dengan bagaimana Anda dapat menggunakan MLLIB Pyspark Spark (Random Forest Classifier), dan pipa melalui Pyspark.

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Data Enrichment | Spasial | Kd-tree | cKDTree | https://github.com/ERDIOLMEZOGULLARI/ML-JOIN-PATIAL-DATA |

Dalam proyek ini, untuk membangun skrip yang efisien yang menemukan bandara terdekat dengan pengguna yang diberikan berdasarkan geolokasi mereka dan geolokasi bandara.

Untuk membuat pengayaan data itu, kami menggunakan algoritma Kd-tree .

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Implementation | Statistik negara | K-Means | Java SDK | https://github.com/ERDIOLMEZOGULLARI/ML-K-MEANS |

Dalam proyek ini, algoritma pengelompokan K-Means diimplementasikan di Java dari awal. Dataset: https://en.wikibooks.org/wiki/data_mining_algorithms_in_r/clustering/k-means#input_data

| Masalah | Data | Metode | Libs | Link |

|---|---|---|---|---|

Forecasting, Timeseries Analysis | Harga spot AWS EC2 | Adaboost Classifier , Decision Tree | Rapidminer | https://github.com/erdiolmezogullari/ml-forecasting-aws-spot-price |

Dalam proyek ini, kami akan menggunakan data publik, yang dikumpulkan oleh orang -orang pihak ketiga dan dirilis melalui beberapa situs web tertentu. Karena data kami terutama terkait dengan Amazon Web Services (AWS) Elastic Computing (EC2), itu akan terdiri dari beberapa bidang yang berbeda. EC2 adalah semacam mesin virtual di cloud AWS. Mesin virtual dapat dibuat tepat waktu baik di cloud pribadi atau publik di atas AWS kapan pun Anda membutuhkannya. Mesin virtual baru dapat dipilih sehubungan dengan berbagai spesifikasi dan konfigurasi dalam hal CPU, RAM, penyimpanan, dan batas pita jaringan sebelum membuatnya sekali dari awal. Mesin EC2 juga dipisahkan dan dikelola oleh AWS di berbagai wilayah geografis (US East, US West, UE, Asia Pasifik, Amerika Selatan) dan zona untuk meningkatkan ketersediaan mesin virtual di seluruh dunia. AWS memiliki segmentasi yang berbeda, yang diklasifikasikan sehubungan dengan spesifikasi sistem oleh AWS untuk berdasarkan tujuan yang berbeda (contoh makro, tujuan umum, komputasi yang dioptimalkan, penyimpanan dioptimalkan, instance GPU, memori yang dioptimalkan). Opsi pembayaran didedikasikan, instance ondemand dan spot. Karena mereka membuat biaya yang berbeda untuk operasi pelanggan, pelanggan mungkin lebih suka berbagai jenis mesin virtual sesuai dengan tujuan dan anggaran mereka. Secara umum, instance spot lebih murah daripada opsi lainnya. Namun, instance spot dapat terganggu jika harga pasar melebihi tawaran maksimal kami. Dalam penelitian kami, kami akan fokus pada pembayaran instance spot. Tujuan kami dalam proyek ini akan memilih contoh AWS yang benar dari pasar instance spot sesuai dengan persyaratan pelanggan. Kami berencana untuk melakukan pohon keputusan tentang data streaming untuk membuat keputusan dengan cepat. Ini dapat diimplementasikan sebagai versi tambahan dari pohon keputusan karena data berubah terus menerus