In diesem leidenschaftlichen Repository für selbstgeschnittene Sammlungen finden Sie viele Herausforderungen für maschinelles Lernen, Data Mining und Data Engineering, die ich bisher angegangen bin. In dieser Richtlinie gehen Sie durch die Details von Projekten und Repositorys.

Ich hoffe, dass Sie es genießen würden, während Sie die Repositorys im Zusammenhang mit ML, Data Mining und Data Engineering in der Tabelle unten überprüfen.

Sie können mich erreichen, wenn Sie weitere Informationen zu Projekten erhalten möchten.

| Problem | Methoden | Libs | Repo |

|---|---|---|---|

| Konvertierung der Zielseite | AB Testing , Z test | pandas , statsmodel | Klicken |

| Integration des Modelmodells des Modemodus -MNIST (CNN) in Tensorboard und MLFlow | CNN , Deep Learning | Keras , MLflow , Pandas , Sklearn | Klicken |

| Dockerisieren Sie eine Apache -Flink -Anwendung über Docker | Apache Flink Table & SQL | Apache Flink Table & SQL , Docker , Docker-Compose | Klicken |

| Crawler als Service | Suche ( DFS , BFS ) | GO , Neo4j , Redis , Docker , Docker-Compose | Klicken |

| Vorhersage überspringen Aktion auf dem Musikdatensatz | LightGBM , Linear Reg , Logistic Reg. | Sklearn , LightGBM , Pandas , Seaborn | Klicken |

| Frisurklassifizierung | LightGBM , TF-IDF | Sklearn , LightGBM , Pandas , Seaborn | Klicken |

| Zeitreihenanalyse durch Sarimax | ARIMA , SARIMAX | statsmodels , pandas , sklearn , seaborn | Klicken |

| Multisprachiger und Multi-Label-Klassifizierungsproblem im Modedatensatz | LightGBM , TF-IDF | Sklearn , LightGBM , Pandas , Seaborn | Klicken |

| Welches fängt es ganze* Spam -SMS auf? | Naive Bayesian , SVM , Random Forest Classifier , Deep Learning - LSTM , Word2Vec | Sklearn , Keras , Gensim , Pandas , Seaborn | Klicken |

| Zu welchem Roman gehöre ich? | Deep Learning - LSTM , Word2Vec | Sklearn , Keras , Gensim , Pandas , Seaborn | Klicken |

| Warum wählen und buchen Kunden spezifische Fahrzeuge? | Random Forest Classifier | Sklearn , Pandas , Seaborn | Klicken |

| Prognose der Auswirkungen von Promos (Promo1, Promo2) auf den Umsatz in Deutschland, Österreich und Frankreich | Random Forest Regressor , ARIMA , SARIMAX | statsmodels , pandas , sklearn , seaborn | Klicken |

| Tutorial für zufällige Waldklassifizierung in PYSPARK | Random Forest Classifier | Spark (PySpark) , Sklearn , Pandas , Seaborn | Klicken |

| Räumungsdatenanreicherung: Treten Sie zwei Geolocation -Datensätze mithilfe von Kdtree bei | Kd-tree | cKDTree | Klicken |

| Implementierung des K-Means-Algorithmus von Grund auf neu in Java | K-Means | Java SDK | Klicken |

| Vorhersage des AWS -Spotpreises durch Verwendung von Adaboosting auf RapidMiner | Adaboost Classifier , Decision Tree | Rapidminer | Klicken |

Bitte scrollen Sie nach unten, um die Details der Projekte umfassend zu sehen und ihr Repository zu besuchen.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Conversion | Einzelhandel | AB Testing , Z test | pandas , statsmodel | https://github.com/erdiolmezogullari/ml-abtesting |

In diesem Projekt wurden A/B -Tests im Kursdatensatz von Udacity durchgeführt. Es besteht aus 5 Spalten, <user_id, timestamp, group, landing_page, converted> . Bei A/B -Tests verwendeten wir 3 Spalten von ihnen, group, landing_page, and converted .

Einmal simulierten wir einige Experimente n -mal in Bezug auf die Konversionsraten ( control, treatment ), die bereits über den Datensatz erhalten wurden. Nachdem wir mit dieser Simulation die weitere Vorstellung über den Datensatz bekommen hatten, vermuteten wir eine Nullhypothese und eine alternative These. Um unsere Wahrheit der alternativen Hypothese zu beanspruchen, haben wir den kritischen Z -Score mit der Z test in Bezug auf Alpha (0,05) berechnet und dann Beta und Leistung in Bezug auf die Effektgröße des Experiments überprüft.

Bitte beachten Sie, dass Sie sich ab_test.md ansehen können, um die weiteren Informationen zu Hypothesentest und A/B -Tests mit einigen wichtigen Fotos zu erhalten.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Prediction | Mode mnist | CNN , Deep Learning | Keras , MLflow , Pandas , Sklearn | https://github.com/erdiolmezogullari/ml-fmnist-mlflow-tensorboard |

In diesem Projekt haben wir Docker -Container -Technologien verwendet, um ML -Plattform von Grund auf neu zu erstellen. Es besteht aus vier verschiedenen Docker-Containern (MLFlow, Notebook, Postgres, Tensorboard), die bereits in docker-compose.yml eingebaut sind

Die Details der Container finden sich unter ./platform -Verzeichnis. Jeder Containerdienst verfügt über eine bestimmte Dockerfile, die den Verzeichnissen (MLFlow, Notebook, Postgres, Tensorboard) im Plattformverzeichnis entspricht

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Implementation | Klicken Sie auf Stream -Datensatz | Apache Flink Table & SQL | Apache Flink Table & SQL , Docker , Docker-Compose | https://github.com/erdiolmezogullari/de-flink-sql-as-a-docker |

In diesem Projekt haben wir Docker -Container -Technologien verwendet, um Flink Cluster und Flink App separat von Grund auf neu zu starten. Flink Cluster (Plattform) besteht aus zwei verschiedenen Docker-Containern (JobManager, TaskManager), die bereits in Docker-compose.flink.yml integriert sind. Die Flink-Anwendung besteht aus einem Docker-Container, der bereits eine Dockerfile (./app-flink-base/dockerfile) und ein Shell-Skript (./app-flink-base/run.sh) verwendet, um die JAR-Datei in Docker-compose-app-flink.yml an Cluster zu senden.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Implementation | N / A | Suche ( BFS , DFS ) | GO , Neo4j , Redis , Docker , Docker-Compose | https://github.com/erdiolmezogullari/de-crawler-as-a--seriens |

In diesem Projekt wurde ein einfacher Crawler-Dienst von Grund auf neu implementiert und in Redis und Neo4j -NoSQL-Systeme unter Verwendung von Docker und Docker-compose integriert. Der Crawler -Service kriecht die erste Ziel -URL und besucht dann den Rest der URLs in den abgerufenen HTML -Dokumenten bzw. rekursiv. Während ein HTML -Dokumente, der URLs entspricht, auf 1 von 2 verschiedenen Suchalgorithmen ( BFS, DFS ) beziehen kann. Diejenigen, die nach Algorithmen suchten, wurden durch go routines in GO gesteigert, um den Krabbeln zu beschleunigen.

Während des Krabbens besteht die Möglichkeit, dass eine Reihe von GO -Routinen, die erstellt werden, gleichzeitig dieselben HTML -Dokumente holen und verarbeiten können. In diesem Fall kann der Crawler inkonsistente Daten erstellen. Daher wurde Redis -Schlüsselwert-NoSQL-System in diesem Projekt bevorzugt, um dieses Problem zu lösen und ein robustes und konsistentes System zu erstellen.

Jede URL kann sich entweder auf die andere verschiedene URL oder sich selbst in einem HTML -Dokument beziehen. Diese Beziehung zwischen zwei URLs kann als Link aufrufen. Es gibt eine einfache Möglichkeit, diese krabbenden Links und URLs durch die Verwendung einer bestimmten Datenstruktur darzustellen, nämlich Grafik. Somit wurden NoSQL von Neo4j -Graphen verwendet, um den Grafik darzustellen und visualisieren, das aus URLs und Links besteht. Während des Kriechs erstellt der Crawling -Dienst entweder einen neuen Knoten für jede URL und den neuen Link für jedes URL -Paar oder aktualisiert vorhandenen Knoten und Links auf Neo4j auch mithilfe von Cypher -Abfragen.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Prediction | Musikdatensatz | LightGBM , Linear Reg , Logistic Reg. | Sklearn , LightGBM , Pandas , Seaborn | https://github.com/erdiolmezogullari/ml-prediction-skip-action |

In diesem Projekt müssen wir die Wahrscheinlichkeit von Skip -Action von Zuhörern vorhersagen, die Musik hörten. Da wir keine Klasse haben, die bereits von jemandem gekennzeichnet ist. Unter diesen Umständen müssen wir ein Zieletikett erstellen, das das Problem lösen könnte. Daher sollte jede kontinuierliche Zielvariable als Zielfunktion ausgewählt werden. Gemäß den von uns erstellten Funktionen wird per_listen (percentage of listen) für dieses Problem besser geeignet sein, da es offensichtlich eine Vorstellung von Überspringen von Aktionen gibt. Wenn wir es als Zielfunktion auswählen, wird dieses Problem ein Bewertung/Wahrscheinlichkeitsproblem ausgewiesen, da das Verhältnis der Hörzeit zwischen 0 und 1 tendiert.

Wenn wir dieses Problem in ein Klassenproblem konvertieren möchten, können wir in der Regel ein Schrägraum für das Überspringen von Aciton ermitteln. per_listen bezeichnet, wie viel Prozentsatz des Tracks, der vom Hörer angehört wurde. Unsere Schwelle könnte also 25%, 50% sogar 51% und so weiter betragen. Bevor wir jedoch eine Entscheidung treffen, können wir die komplementäre kumulative Verteilungsfunktion (CCDF) von per_listen überprüfen. Es würde eine Vorstellung von unserer Days -Schwelle geben. Nach dem folgenden Diagramm haben wir 65% der Instanzen, deren Per_Listen -Wert größer als 0,5 ist. Daher ist 0,5 jedoch vernünftig, wenn wir darüber nachdenken, realistischer, wären weniger als 0,5 um 0,25 geeigneter eine bessere Überspringensaktion.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Classification | Frisur Datensatz | LightGBM , TF-IDF | Sklearn , LightGBM , Pandas , Seaborn | https://github.com/erdiolmezogullari/ml-hairstyle-classification |

In diesem Projekt enthält der Datensatz ein von Instagram abgebautes Beispiel 10000 -Bilder und basierend auf der Frisur, die sie präsentieren.

Der variable cluster repräsentiert den Frisur -Cluster, dem das Bild durch den visuellen Erkennungsalgorithmus zugeordnet wurde.

Jede Zeile enthält die variable url , die die Verbindung zum Bild und die Anzahl der Likes zusammen mit den comments pro Bild ist. Die user_id ist die eindeutige ID des Instagram -Kontos, aus dem der Beitrag stammt, und die variable id ist die eindeutige Kennung, die dem Beitrag selbst zugeordnet ist.

Jeder Beitrag enthält das Datum ( date_unix ) im UNIX -Format, wenn das Bild auf Instagram veröffentlicht wurde und zusätzlich das Datum in verschiedene Formate konvertiert wurde ( date_week -> Nicht -ISO -Nummer der Woche, date_month -> Der Monat, date_formated -> VOLLSTÄNDIGES DATUM DD/MM/YY) teilweise für Gebrauch für die Verwendung in Prior -Analysen. Fühlen Sie sich frei, diese Variable auf eine Weise zu konvertieren, die zu Ihrer Analyse passt.

Zusätzlich wurde jedem der Bilder mit mehr als 500 Likes ein Klassifikator influencer_flag hinzugefügt, der sie als Influencer -Posts markiert.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Time Series Analysis | Arbeitsstatistik | ARIMA , SARIMAX | statsmodels , pandas , sklearn , seaborn | https://github.com/erdiolmezogullari/ml-time-series-analysis-sarimax |

In diesem Projekt verwenden wir die Zeitreihen -Analysetechnik, um unsere Daten in 3 Komponenten wie die folgenden zu zerlegen:

1-Trend (T)

2-Seasonility (S)

3-Residual (R)

Sobald wir einen statinorischen Datensatz benötigen, bevor wir die Zeitreihenanalyse (TSA) makellos durchführen, wäre dies einfach eine Vorhersage über einen stationären Datensatz, da dies die Präopertien der Normalverteilung in Bezug auf Mittelwert und Varianz bereits grob erfüllen würde. Daher müssen wir uns mit dem Rohdatensatz befassen, indem wir einige EDA -Techniken anwenden, um wertvolle Erkenntnisse über Daten im Zusammenhang mit dem Trend und die Sängerlichkeit aufzudecken, wenn es möglich ist, in EDA zu beobachten. Nachdem wir die Datenanalyse -Phase abgeschlossen haben, müssen wir die besten verfügbaren Techniken (z. B. Arima, Sarimax) auswählen, um nach unserem Wissen, den wir in EDA erhalten würden, auf dem Datensatz durchzuführen.

In der EDA -Stufe werden wir eine Reihe von Techniken wie zeitbasierte Funktionen (Jahr, Monat, Tag, Wochentag und Quartal) anwenden, um 2 Komponenten (Trend, Sängerbarkeit) von 3 Time Series -Komponenten über bestimmte Handlungen zu finden. Diese Diagramme geben vor dem Start ein angemessenes Feedback für TSA.

In der TSA-Stufe werden wir verschiedene Modelle für nicht saisonale und saisonale Anleger erstellen, indem wir Arima und Sarimax im StatsModels-Paket verwenden.

Since the most challenging parts of TSA is finding optimum parameters (p,d,q) and (P,D,Q,S) of those techniques, we will be referring to Autocorrelation (ACF) and Partial Autocorrelation (PACF) functions to find out significant time correlations in terms of performing either Autoregression Model (AR) or Moving Average Model (MA), or Seanosal Autoregression (SAR) and Moving Average (SAM).

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Classification | Modedatensatz | LightGBM , TF-IDF | Sklearn , LightGBM , Pandas , Seaborn | https://github.com/erdiolmezogullari/multi-label-classification |

In diesem Projekt wurde Datensatz über verschiedene Mode -Websites gesammelt. Es besteht aus 7 Feldern wie unten.

id : Eine eindeutige Produktkennungname : Der Titel des Produkts, wie auf unserer Website angezeigtdescription : Die Beschreibung des Produktsprice : Der Preis des Produktsshop : Der Laden, aus dem Sie dieses Produkt kaufen könnenbrand : Die Produktmarkelabels : Die Kategoriebezeichnungen, die für dieses Produkt geltenDie Textmerkmale (Name, Beschreibung) befinden sich in verschiedenen Sprachen wie Englisch, Deutsch und Russisch. Das Format der Zielfunktion besteht aus Multilabeln (60 Kategorien), die entsprechend der Kategorie der Mode -Websites unterschiedlich markiert wurden.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

NLP | Text | Naive Bayesian , SVM , Random Forest Classifier , Deep Learning - LSTM , Word2Vec | Sklearn , Keras , Gensim , Pandas , Seaborn | https://github.com/erdiolmezogullari/ml-spam-sms-classification |

In diesem Projekt haben wir überwachte Lernalgorithmen und Deep Learning (LSTM) angewendet.

Wir haben einen öffentlichen SMS -Spam -Datensatz verwendet, der nicht rein sauber ist. Die Daten bestehen aus zwei verschiedenen Spalten (Merkmalen) wie Kontext und Klasse. Der Spaltenkontext bezieht sich auf SMS. Die Spaltenklasse kann einen Wert annehmen, der entweder spam oder ham entspricht, der dem verwandten SMS -Kontext entspricht.

Bevor wir beaufsichtigte Lernmethoden angewendet haben, haben wir eine Reihe von Datenreinigungsvorgängen angewendet, um chaotische und schmutzige Daten loszuwerden, da sie einen kaputten und unordentlichen Kontext haben.

Nachdem wir einen gereinigten Datensatz erhalten hatten, erstellten wir mit Spaces Tapes und Lemmas von SMS Corpus separat und generierten dann eine Sack-of-Word- und TF-IDF von SMS Corpus. Zusätzlich zu diesen Datentransformationen haben wir auch SVD, SVC und PCA durchgeführt, um die Dimension des Datensatzes zu verringern.

Um die Datenumwandlung in der Trainings- und Testphase effektiv zu verwalten und Datenlecks zu vermeiden, haben wir die Pipeline -Klasse von Sklearn verwendet. Daher haben wir jeden Datentransformationsschritt (z bag-of-word , TF-IDF , SVC ) und Klassifizierer (z. B. Naive Bayesian , SVM , Random Forest Classifier ) in eine Instanz der Pipeline hinzugefügt.

Nachdem wir diese überwachten Lernmethoden angewendet hatten, haben wir auch tiefes Lernen durchlaufen. Unsere von uns verwendete tiefgreifende Architektur basiert auf LSTM. Um LSTM in Keras (Tensorflow) durchzuführen, mussten wir eine Einbettungsmatrix unseres Korpus erstellen. Wir haben also Gensims Word2VEC-Ansatz verwendet, um die Einbettungsmatrix und nicht an TF-IDF zu erhalten.

Am Ende jeder Verarbeitung durch einen unterschiedlichen Klassifikator haben wir die Verwirrungsmatrix aufgetragen, um welches der beste Klassifikator für die Filtern von Spam -SMS zu vergleichen.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

NLP | Text | Deep Learning - LSTM , Word2Vec | Sklearn , Keras , Gensim , Pandas , Seaborn | https://github.com/erdiolmezogullari/ml-leep-learning-keras-novel |

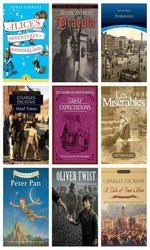

Dieses Projekt bezieht sich auf das Problem der Textklassifizierung, das wir mit Deeplearing (LSTM) -Modell (LSTM) angepasst haben, das angegebene willkürliche Absätze, die über 12 verschiedene Romane gesammelt wurden, nach dem Zufallsprinzip klassifiziert: oben: oben:

1. alice_in_wonderland

2. dracula

3. dubliners

4. great_expectations

5. hard_times

6. huckleberry_finn

7. les_miserable

8. moby_dick

9. oliver_twist

10. peter_pan

11. talw_of_two_cities

12. tom_sawyer

Mit anderen Worten, Sie können über diese Romane nachdenken, die unsere Zielklassen unseres Datensatzes sind. Um die tatsächliche Klasse des Absatzes zu unterscheiden, würde der semantische Latent unter den Absätzen eine wichtige Rolle spielen. Daher verwendeten wir Deeplearing (LSTM) über Keras (Tensorflow) nachdem wir eine Einbettungsmatrix von Gensim's word2vec erstellt haben.

Wenn in den entsprechenden Absätzen semantische Latente zwischen den Sätzen vorhanden sind, denken wir über ähnliche Absätze, die höchstwahrscheinlich aus denselben Ressourcen (Romanen) gesammelt wurden.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Imbalanced Data | Autobuchung | Random Forest Classifier | Sklearn , Pandas , Seaborn | https://github.com/erdiolmezogullari/ml-imbalanced-car-booking-data |

In diesem Projekt haben wir ein maschinelles Lernmodell erstellt, das die Frage beantwortet, was die Kundenpräferenz für Autobuchdatensatz ist.

Wir haben den Datensatz unter Verwendung von Seaborn untersucht und neue Funktionen verwendet.

Darüber hinaus ist die Form des Datensatzes imbalanced . Dies bedeutet, dass die Verteilung der Zielvariablen verzerrt ist. Um diese Herausforderung zu überwinden, gibt es bereits einige verschiedene Techniken ( over/under re-sampling techniques . Wir versuchen auch, dieses Problem mithilfe von Resampling -Techniken zu lösen.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Forecasting - Timeseries | Verkäufe | Random Forest Regressor | statsmodels , pandas , sklearn , seaborn | https://github.com/erdiolmezogullari/ml-time-series-analysis-on-sales-data |

In diesem Projekt müssen wir Zeitreihenanalysen durchführen, um neue Einblicke in Promos zu erhalten. Es gibt Geschäfte, in denen zwei Arten von Promos wie Radio, Fernsehen, die Promo1 und Promo2 entsprechen, damit sie ihren Umsatz in Deutschland, Österreich und Frankreich steigern möchten. Sie haben jedoch keine Vorstellung davon, welche Promo dafür ausreicht. Die Auswirkungen von Promos auf ihren Umsatz sind also eine wichtige Rolle bei ihrer Präferenz.

Um eine genau definierte Promo-Strategie zu definieren, müssen wir einmal Daten in Bezug auf die Auswirkungen von Promos analysieren. In diesem Fall, da Daten auf der Zeitreihe basieren, haben wir einmal time series decomposition verwendet. Nachdem wir observed Daten in trend , seasonal und residual zerlegt hatten, haben wir die Auswirkungen von Promos eindeutig auf die Entscheidung enthüllt, die Promo in jedem Land besser ist.

Darüber hinaus haben wir in diesem Prognoseproblem Random Forest Regression verwendet, um unsere Entscheidung zu steigern.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

ML Service | Zufällig generiert | Random Forest Classifier | Flask , Docker , Redis , Sklearn | https://github.com/erdiolmezogullari/ml-dockerized-microservice |

REST diesem Projekt wurde nach Random Forest Erstellen Docker maschinellen ML based micro-service

Wir haben docker-compose verwendet, um die Micro Services unten zu starten.

1.Jupyter Notebook,

2.Restful Comm. (Flask),

3.Redis

Nachdem wir drei verschiedene Container erstellt haben, wäre unser Mlass bereit.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

PySpark | Zufällig generiert | Random Forest Classifier | Spark (PySpark) , Sklearn , Pandas , Seaborn | https://github.com/erdiolmezogullari/ml-random-forest-pysspark |

In diesem Projekt finden Sie eine Reihe von Beispielcode, die sich darauf beziehen, wie Sie PYSPARK Sparks MLLIB (Random Forest Classifrivierer) und Pipeline über PYSPARK verwenden können.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Data Enrichment | Räumlich | Kd-tree | cKDTree | https://github.com/erdiolmezogullari/ml-join-spatial-data |

In diesem Projekt erstellen Sie ein effizientes Skript, das den nächsten Flughafen für einen bestimmten Benutzer basierend auf der Geolokalisierung und der Geolokalisierung des Flughafens findet.

Um diese Datenanreicherung vorzunehmen, haben wir Kd-tree -Algorithmus verwendet.

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Implementation | Statistik der Länder | K-Means | Java SDK | https://github.com/erdiolmezogullari/ml-k-means |

In diesem Projekt wurden K-Means-Clustering-Algorithmus in Java von Grund auf neu implementiert. Datensatz: https://en.wikibooks.org/wiki/data_mining_algorithms_in_r/clustering/k-means#input_data

| Problem | Daten | Methoden | Libs | Link |

|---|---|---|---|---|

Forecasting, Timeseries Analysis | AWS EC2 Spot -Preis | Adaboost Classifier , Decision Tree | Rapidminer | https://github.com/erdiolmezogullari/ml-forecasting-aws-spot-price |

In diesem Projekt werden wir öffentliche Daten verwenden, die von Mitarbeitern Dritter gesammelt und über bestimmte Websites veröffentlicht wurden. Da unsere Daten hauptsächlich mit Amazon Web Services (AWS) Elastic Computing (EC2) zusammenhängen, besteht es aus verschiedenen Feldern. EC2 ist eine Art virtuelle Maschine in der AWS -Cloud. Eine virtuelle Maschine kann gerade rechtzeitig auf privater oder öffentlicher Cloud über AWS erstellt werden, wann immer Sie sie benötigen. Eine neue virtuelle Maschine kann in Bezug auf verschiedene Spezifikationen und Konfigurationen in Bezug auf CPU-, RAM-, Speicher- und Netzwerk -Band -Limit ausgewählt werden, bevor sie von Grund auf neu erstellt werden. EC2 -Maschinen werden auch von AWS in verschiedenen geografischen Regionen (US East, US West, EU, Asien -Pazifik, Südamerika) getrennt und verwaltet, um die Verfügbarkeit virtueller Maschinen weltweit zu erhöhen. AWS hat unterschiedliche Segmentierungen, die in Bezug auf Systemspezifikationen nach AWS für unterschiedliche Ziele klassifiziert wurden (Makroinstanz, allgemeiner Zweck, optimiertes Rechen, Speicheroptimierter, GPU -Instanz, Speicheroptimierter). Die Zahlungsoptionen sind dediziert, ONDEMAND- und SPOT -Instanz. Da sie den Betrieb des Kunden unterschiedlich kosten, bevorzugen Kunden möglicherweise verschiedene Arten von virtuellen Maschinen entsprechend ihren Zielen und Budgets. Im Allgemeinen ist die Spot -Instanz billiger als der Rest der Optionen. Die Spot -Instanz kann jedoch unterbrochen werden, wenn der Marktpreis unser maximales Angebot übersteigt. In unserer Forschung konzentrieren wir uns auf die Spot -Instanzzahlung. Unser Ziel in diesem Projekt ist es, die korrekte AWS -Instanz vom Spot Instance -Markt gemäß den Anforderungen des Kunden auszuwählen. Wir planen, Entscheidungsbaum für Streaming -Daten auszuführen, um eine Entscheidung im laufenden Fliegen zu treffen. Es kann als inkrementelle Version des Entscheidungsbaums implementiert werden, da sich die Daten kontinuierlich ändern