في هذا مستودع التجميع العاطفي الذي يسير بخطى ذاتي ، ستجد العديد من التحديات التي تواجهها في مجال التعلم الآلي ، والتعدين للبيانات وهندسة البيانات التي كنت أتعامل معها ، حتى الآن. خلال هذا المبدأ التوجيهي ، سوف تسير على تفاصيل المشاريع والمستودعات.

آمل أن تستمتع أثناء مراجعة تلك المستودعات المتعلقة بـ ML ، واستخراج البيانات وهندسة البيانات على الطاولة أدناه.

قد تصل إلي كلما أردت الحصول على مزيد من المعلومات حول المشاريع.

| مشكلة | طُرق | libs | ريبو |

|---|---|---|---|

| تحويل الصفحة المقصودة | AB Testing ، Z test | pandas ، statsmodel | انقر |

| تكامل نموذج الموضة Mnist (CNN) في Tensorboard و Mlflow | CNN ، Deep Learning | Keras ، MLflow ، Pandas ، Sklearn | انقر |

| مرسومة تطبيق Apache Flink من خلال Docker | Apache Flink Table & SQL | Apache Flink Table & SQL ، Docker ، Docker-Compose | انقر |

| الزاحف كخدمة | البحث ( DFS ، BFS ) | GO ، Neo4j ، Redis ، Docker ، Docker-Compose | انقر |

| التنبؤ تخطي إجراء على مجموعة بيانات الموسيقى | LightGBM ، Linear Reg ، Logistic Reg. | Sklearn ، LightGBM ، Pandas ، Seaborn | انقر |

| تصفيف تصفيفة الشعر | LightGBM ، TF-IDF | Sklearn ، LightGBM ، Pandas ، Seaborn | انقر |

| تحليل السلاسل الزمنية من قبل ساريماكس | ARIMA ، SARIMAX | statsmodels ، pandas ، sklearn ، seaborn | انقر |

| مشكلة تصنيف متعددة اللغات ومتعددة العلامات على مجموعة بيانات الموضة | LightGBM ، TF-IDF | Sklearn ، LightGBM ، Pandas ، Seaborn | انقر |

| أي واحد يصطاد بالكامل* الرسائل القصيرة الرسائل غير المرغوب فيها؟ | Naive Bayesian ، SVM ، Random Forest Classifier ، Deep Learning - LSTM ، Word2Vec | Sklearn ، Keras ، Gensim ، Pandas ، Seaborn | انقر |

| ما هي الرواية التي أنتمي إليها؟ | Deep Learning - LSTM ، Word2Vec | Sklearn ، Keras ، Gensim ، Pandas ، Seaborn | انقر |

| لماذا يختار العملاء وحجز مركبات محددة؟ | Random Forest Classifier | Sklearn ، Pandas ، Seaborn | انقر |

| تأثير التنبؤ بالبروتولوس (PROMO1 ، PROMO2) على المبيعات في ألمانيا والنمسا وفرنسا | Random Forest Regressor ، ARIMA ، SARIMAX | statsmodels ، pandas ، sklearn ، seaborn | انقر |

| برنامج تعليمي عشوائي لتصنيف الغابات في Pyspark | Random Forest Classifier | Spark (PySpark) ، Sklearn ، Pandas ، Seaborn | انقر |

| إثراء البيانات المكانية: انضم إلى مجموعتي بيانات تحديد الموقع الجغرافي باستخدام KDTREE | Kd-tree | cKDTree | انقر |

| تنفيذ خوارزمية K-Means من الصفر في Java | K-Means | Java SDK | انقر |

| التنبؤ بسعر SPOT AWS باستخدام Adaboosting على Rapidminer | Adaboost Classifier ، Decision Tree | Rapidminer | انقر |

من فضلك ، قم بالتمرير لأسفل لمعرفة تفاصيل المشاريع بشكل شامل وزيارة مستودعها.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Conversion | بيع بالتجزئة | AB Testing ، Z test | pandas ، statsmodel | https://github.com/erdiolmezogullari/ML-AB-Testing |

في هذا المشروع ، تم إجراء اختبار A/B على مجموعة بيانات دورة Udacity. وهو يتألف من 5 أعمدة ، <user_id, timestamp, group, landing_page, converted> . في اختبار A/B ، استخدمنا 3 أعمدة منها ، group, landing_page, and converted .

قمنا بمحاكاة بعض التجارب ذات مرة فيما يتعلق بمعدلات التحويل ( control, treatment ) التي تم الحصول عليها بالفعل عبر مجموعة البيانات. بعد الحصول على فكرة أخرى حول مجموعة البيانات مع هذه المحاكاة ، افترضنا فرضية فارغة وأطروحة بديلة. للمطالبة بدقة الفرضية البديلة ، قمنا بحساب درجة Z الحرجة باستخدام طريقة Z test فيما يتعلق بـ alpha (0.05) ، ثم قمنا بفحص بيتا ، والطاقة فيما يتعلق بحجم تأثير التجربة.

من فضلك ، لاحظ أنه يمكنك التحقق من ab_test.md للحصول على مزيد من المعلومات حول اختبار الفرضية واختبار A/B مع بعض الصور المهمة.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Prediction | الموضة mnist | CNN ، Deep Learning | Keras ، MLflow ، Pandas ، Sklearn | https://github.com/erdiolmezogullari/ml-fmnist-mlflow-tensorboard |

في هذا المشروع ، استخدمنا تقنيات حاوية Docker لإنشاء منصة ML من نقطة الصفر. وهو يتألف من أربع حاويات Docker مختلفة (MLFlow ، دفتر الملاحظات ، postgres ، Tensorboard) التي تم تضمينها بالفعل في docker-compose.yml

يمكن العثور على تفاصيل الحاويات تحت ./platform platform دليل. تحتوي كل خدمة حاوية على dockerfile محددة تقابل الدلائل (MLFLOW ، دفتر الملاحظات ، postgres ، Tensorboard) ضمن دليل النظام الأساسي

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Implementation | انقر فوق دفق مجموعة البيانات | Apache Flink Table & SQL | Apache Flink Table & SQL ، Docker ، Docker-Compose | https://github.com/erdiolmezogullari/DE-FLINK-SQL-AS-A-DOCKER |

في هذا المشروع ، استخدمنا تقنيات حاوية Docker لإطلاق Flink Cluster و Flink بشكل منفصل عن نقطة الصفر. يتكون Flink Cluster (منصة) من حاوين Docker مختلفة (Jobmanager ، TaskManager) والتي تم تصميمها بالفعل في docker-corm.flink.yml. يتكون تطبيق Flink من حاوية Docker التي تستخدم بالفعل dockerfile (./app-flink-base/dockerfile) ونصي shell (./app-flink-base/run.sh) لإرسال ملف JAR إلى cluster في docker-corm-app-flink.yml.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Implementation | ن/أ | البحث ( BFS ، DFS ) | GO ، Neo4j ، Redis ، Docker ، Docker-Compose | https://github.com/erdiolmezogullari/de-crawler-as-a-service |

في هذا المشروع ، تم تنفيذ خدمة زاحف بسيطة من نقطة الصفر ، وتم دمجها في أنظمة Redis و Neo4j NoSQL باستخدام Docker و Docker-compose . تقوم خدمة الزاحف بالزحف على عنوان URL المستهدف الأول ، وبعد ذلك ، يزور بقية عناوين URL في مستندات HTML التي تم جلبها ، على التوالي ومتكرر. أثناء زحف مستندات HTML المقابلة لعناوين URL ، يمكن أن يشير إلى 1 من 2 من خوارزميات البحث المختلفة ( BFS, DFS ). تم تعزيز خوارزميات البحث عن go routines في GO من أجل تسريع خدمة الزحف.

أثناء الزحف ، هناك احتمال أن تجلب مجموعة من إجراءات GO التي سيتم إنشاؤها ومعالجة مستندات HTML نفسها في نفس الوقت. في هذه الحالة ، يجوز للزاحف إنشاء بيانات غير متسقة. وبالتالي ، تم تفضيل نظام Redis -value-value noSQL باستخدامه في هذا المشروع لحل هذه المشكلة وبناء نظام قوي ومتسق.

قد يشير كل عنوان URL إلى عنوان URL الآخر الآخر أو نفسه في مستند HTML. يمكن أن تسمي هذه العلاقة بين اثنين عناوين URL رابطًا. هناك طريقة سهلة بسيطة لتمثيل تلك الروابط المزروعة وعنوان URL باستخدام بنية بيانات معينة ، وهو رسم بياني. وبالتالي ، تم استخدام Neo4j Graph NOSQL لتمثيل الرسم البياني وتصوره الذي يتكون من عناوين URL والروابط. أثناء الزحف ، تقوم خدمة الزحف إما بإنشاء عقدة جديدة لكل عنوان URL ورابط جديد لكل زوج عناوين URL ، أو تحديث العقد والروابط الموجودة على Neo4j باستخدام Cypher Query أيضًا.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Prediction | مجموعة بيانات الموسيقى | LightGBM ، Linear Reg ، Logistic Reg. | Sklearn ، LightGBM ، Pandas ، Seaborn | https://github.com/erdiolmezogullari/ml-prediction-skip-action |

في هذا المشروع ، نحتاج إلى التنبؤ باحتمال تخطي العمل الذي قام به المستمعون ، الذين يستمعون إلى الموسيقى. نظرًا لأننا ليس لدينا أي فصل يحمله أي شخص بالفعل. في هذه الظروف ، نحتاج إلى إنشاء ملصق مستهدف يمكن أن يحل المشكلة. لذلك ، يجب اختيار أي متغير مستهدف مستمر كميزة هدف. وفقًا للميزات التي أنشأتها ، ستكون per_listen (percentage of listen) أكثر ملاءمة لهذه المشكلة لأنها تعطي فكرة عن تخطي العمل. إذا اخترناها كميزة مستهدفة ، فإن هذه المشكلة ستتحول إلى مشكلة في التسجيل/الاحتمال بسبب وجود نسبة من وقت الاستماع ، والتي تميل بين 0 إلى 1.

إذا كنا نريد تحويل هذه المشكلة إلى مشكلة في التصنيف ، فيمكننا تحديد شريعة لتخطي Aciton كقاعدة من القاعدة. تشير per_listen إلى مقدار النسبة المئوية للمسار الذي استمع إليه المستمع. لذلك ، يمكن أن تكون عتبةنا 25 ٪ و 50 ٪ حتى 51 ٪ وما إلى ذلك. ومع ذلك ، قبل اتخاذ قرار ، يمكننا الاطلاع على وظيفة التوزيع التراكمي التكميلي (CCDF) من per_listen . سيكون إعطاء فكرة عن عتبة Quentanle. وفقًا للمؤامرة التالية ، لدينا 65 ٪ من الحالات ، التي تكون قيمة Per_listen أكبر من 0.5. لذلك ، 0.5 معقول ، عندما نفكر في الأمر أكثر واقعية ، فإن أقل من 0.5 حوالي 0.25 سيكون أكثر ملاءمة تحديد أي إجراء تخطي.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Classification | مجموعة بيانات تصفيفة الشعر | LightGBM ، TF-IDF | Sklearn ، LightGBM ، Pandas ، Seaborn | https://github.com/erdiolmezogullari/Ml-Hairstyle-Lassification |

في هذا المشروع ، تحتوي مجموعة البيانات على عينة 10000 صورة تم استخراجها من Instagram وتم تجميعها بناءً على تصفيفة الشعر التي تعرضها.

تمثل cluster المتغيرة مجموعة تصفيفة الشعر التي تم تعيين الصورة بواسطة خوارزمية التعرف المرئي.

يحتوي كل صف على url المتغير وهو الرابط للصورة وعدد الإعجابات مع comments لكل صورة. user_id هو المعرف الفريد لحساب Instagram الذي يأتي منه المنشور id المتغير هو المعرف الفريد المرتبط بالنشر نفسه.

يحتوي كل منشور على التاريخ ( date_unix ) بتنسيق UNIX عندما تم نشر الصورة على Instagram ، بالإضافة إلى تحويل التاريخ إلى تنسيقات مختلفة ( date_week -> رقم غير ISO من الأسبوع ، date_month -> الشهر ، date_formated -> التاريخ الكامل DD/MM/YY) جزئيًا للاستخدام في التحليلات السابقة. لا تتردد في تحويل هذا المتغير بطريقة تناسب تحليلك.

بالإضافة إلى ذلك ، تمت إضافة influencer_flag مصنف إلى كل من الصور التي تحتوي على أكثر من 500 إعجاب ، مما يعلق عليها على أنها منشورات مؤثرة.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Time Series Analysis | إحصائيات العمل | ARIMA ، SARIMAX | statsmodels ، pandas ، sklearn ، seaborn | https://github.com/erdiolmezogullari/ML- |

في هذا المشروع ، نستخدم تقنية تحليل السلاسل الزمنية لتحليل بياناتنا إلى 3 مكونات مثل أدناه:

1-Trend (T)

2-Seasonility (S)

3-Residual (R)

بمجرد أن نحتاج إلى الحصول على مجموعة بيانات حليقة قبل إجراء تحليل السلاسل الزمنية (TSA) لا تشوبه شائبة ، سيكون من السهل إجراء التنبؤ على مجموعة بيانات ثابتة لأنه من شأنه أن يفي بالفعل بسباق التوزيع الطبيعي من حيث الوسط والتباين ، تقريبًا. لذلك ، نحتاج إلى الخوض في مجموعة البيانات الخام من خلال تطبيق بعض تقنيات EDA لفضح رؤية قيمة للبيانات المتعلقة بالاتجاه ، والموسم إذا كان من الممكن مراقبة في EDA. بعد إكمال مرحلة تحليل البيانات ، نحتاج إلى اختيار أفضل التقنيات المتاحة (على سبيل المثال ARIMA ، Sarimax) لأداء على مجموعة البيانات وفقًا لمعرفتنا ، سنحصل على EDA.

في مرحلة EDA ، سنقوم بتطبيق مجموعة من التقنيات مثل ، وربط الحشائش ، و statictics المتداول (Mean ، STD) حسب الميزات المستندة إلى الوقت (السنة ، والشهر ، واليوم ، والربع) لمعرفة مكونين (الاتجاه ، والموسم) من بين 3 مكونات من السلاسل الزمنية على قطع محددة ، Rougly. ستوفر هذه المؤامرات تعليقات معقولة لـ TSA قبل البدء بها.

في TSA Stage ، سنبني نماذج مختلفة للتراجع غير الموسمية والموسمية باستخدام ARIMA و Sarimax في حزمة STATSMODELS ، على التوالي.

نظرًا لأن الأجزاء الأكثر تحديا من TSA هي إيجاد المعلمات المثلى (P ، D ، Q) و (P ، D ، Q ، S) لتلك التقنيات ، سنشير إلى الارتباط التلقائي (ACF) ووظائف الارتباط التلقائي الجزئي (MA) (SAN) (SAN) (SAN) (SAR) (SAR) (SAR) (SAR).

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Classification | مجموعة بيانات الموضة | LightGBM ، TF-IDF | Sklearn ، LightGBM ، Pandas ، Seaborn | https://github.com/erdiolmezogullari/Multi-Label-Lassification |

في هذا المشروع ، تم جمع مجموعة البيانات على مواقع ويب أزياء مختلفة. يتكون من 7 حقول مثل أدناه.

id : معرف منتج فريدname : عنوان المنتج ، كما هو معروض على موقعنا على الويبdescription : وصف المنتجprice : سعر المنتجshop : المتجر الذي يمكنك شراء هذا المنتج منهbrand : العلامة التجارية للمنتجlabels : تسميات الفئة التي تنطبق على هذا المنتجميزات النص (الاسم ، الوصف) بلغات مختلفة ، مثل اللغة الإنجليزية والألمانية والروسية. إن تنسيق ميزة الهدف هو MultiLabels (60 فئة) تم وضع علامة عليها وفقًا للفئة المقابلة للفئة في مواقع الموضة بشكل مختلف.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

NLP | نص | Naive Bayesian ، SVM ، Random Forest Classifier ، Deep Learning - LSTM ، Word2Vec | Sklearn ، Keras ، Gensim ، Pandas ، Seaborn | https://github.com/erdiolmezogullari/ML-Spam-SMS- |

في هذا المشروع ، طبقنا خوارزميات التعلم الخاضعة للإشراف (التصنيف) والتعلم العميق (LSTM).

استخدمنا مجموعة بيانات البريد العشوائي SMS العامة ، والتي ليست مجموعة بيانات نظيفة بحتة. تتكون البيانات من عمودين مختلفين (ميزات) ، مثل السياق ، والفئة. يشير سياق العمود إلى الرسائل القصيرة. قد تأخذ فئة العمود قيمة يمكن أن تكون spam أو ham المقابل لسياق الرسائل القصيرة ذات الصلة.

قبل تطبيق أي أساليب تعليمية خاضعة للإشراف ، طبقنا مجموعة من عمليات تطهير البيانات للتخلص من البيانات الفوضوية والقذرة نظرًا لوجود بعض السياق المكسور والفوضوي.

بعد الحصول على مجموعة البيانات التي تم تنظيفها ، أنشأنا الرموز والليماس من SMS Corpus بشكل منفصل باستخدام Spacy ، وبعد ذلك ، أنشأنا حقيبة كلمة و TF-IDF من SMS Corpus ، على التوالي. بالإضافة إلى تحويلات البيانات هذه ، أجرينا أيضًا SVD و SVC و PCA لتقليل أبعاد مجموعة البيانات.

لإدارة تحويل البيانات في مرحلة التدريب والاختبار بفعالية وتجنب تسرب البيانات ، استخدمنا فئة خط أنابيب Sklearn. لذلك ، أضفنا كل خطوة تحويل البيانات (مثل bag-of-word ، TF-IDF ، SVC ) والمصنف (مثل Naive Bayesian ، SVM ، Random Forest Classifier ) إلى مثيل Pipeline الفصل.

بعد تطبيق أساليب التعلم الخاضعة للإشراف ، قمنا أيضًا بتجميع التعلم العميق. تعتمد بنية التعلم العميق التي استخدمناها على LSTM. لأداء LSTM Enperching في Keras (TensorFlow) ، كنا بحاجة إلى إنشاء مصفوفة تضمين لجسمنا. لذلك ، استخدمنا نهج Gensim's Word2Vec للحصول على مصفوفة التضمين ، بدلاً من TF-IDF.

في نهاية كل معالجة من قبل مصنف مختلف ، قمنا برسم مصفوفة الارتباك لمقارنة أي مصنف أفضل لتصفية الرسائل القصيرة للرسائل غير المرغوب فيها.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

NLP | نص | Deep Learning - LSTM ، Word2Vec | Sklearn ، Keras ، Gensim ، Pandas ، Seaborn | https://github.com/erdiolmezogullari/ML-Deep-learning-keras-novel |

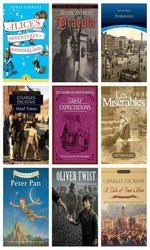

يرتبط هذا المشروع بمشكلة تصنيف النص التي تعاملنا معها مع نموذج Deeplearing (LSTM) ، والذي يصنف الفقاعات التعسفية التي تم جمعها على أكثر من 12 رواية مختلفة بشكل عشوائي ، أعلاه:

1. alice_in_wonderland

2. dracula

3. dubliners

4. great_expectations

5. hard_times

6. huckleberry_finn

7. les_miserable

8. moby_dick

9. oliver_twist

10. peter_pan

11. talw_of_two_cities

12. tom_sawyer

بمعنى آخر ، يمكنك التفكير في تلك الروايات هي فئاتنا المستهدفة من مجموعة البيانات الخاصة بنا. لتمييز الفئة الفعلية من الفقرة ، ستلعب الكامنة الدلالية بين الفقهات دورًا مهمًا. لذلك ، استخدمنا Deeplearing (LSTM) أعلى Keras (Tensorflow) بعد إنشاء مصفوفة تضمين بواسطة Gensim's word2vec .

إذا كان هناك أي كامنة دلالية بين الجمل في الفقرة المقابلة ، فإننا نفكر في فقرات مماثلة تم جمعها من نفس الموارد (الروايات) على الأرجح.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Imbalanced Data | حجز السيارات | Random Forest Classifier | Sklearn ، Pandas ، Seaborn | https://github.com/erdiolmezogullari/ML-Imbalanced-car-booking-data |

في هذا المشروع ، قمنا ببناء نموذج للتعلم الآلي الذي يجيب على السؤال ، - ما هو تفضيل العميل - على مجموعة بيانات حجز السيارات.

لقد استكشفنا مجموعة البيانات باستخدام Seaborn ، ومحولها ، الميزات الجديدة المشتقة.

بالإضافة إلى ذلك ، شكل مجموعة البيانات imbalanced . وهذا يعني أن توزيع المتغير الهدف منحرف. للتغلب على هذا التحدي ، هناك بالفعل بعض التقنيات المختلفة ( over/under re-sampling techniques ) والمناهج البديهية. نحاول حل هذه المشكلة باستخدام تقنيات إعادة أخذ العينات أيضًا.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Forecasting - Timeseries | مبيعات | Random Forest Regressor | statsmodels ، pandas ، sklearn ، seaborn | https://github.com/erdiolmezogullari/ML-time-series-analysis-on-sales-data |

في هذا المشروع ، نحتاج إلى إجراء تحليل للسلاسل الزمنية للحصول على رؤية جديدة حول العروض الترويجية. هناك متاجر تعطي نوعين من العروض الترويجية مثل الراديو والتلفزيون المقابل لـ PRAMO1 و PROMO2 بحيث يرغبون في زيادة مبيعاتها عبر ألمانيا والنمسا وفرنسا. ومع ذلك ، ليس لديهم أي فكرة عن العرض الترويجي يكفي للقيام بذلك. لذلك ، فإن تأثير العروض الترويجية على مبيعاتها هو أدوار مهمة على تفضيلها.

لتحديد إستراتيجية الترويج المحددة جيدًا ، نحتاج مرة واحدة إلى تحليل البيانات من حيث تأثيرات الترسل. في هذه الحالة ، نظرًا لأن البيانات تعتمد على السلاسل الزمنية ، فقد أشرنا مرة واحدة إلى استخدام time series decomposition . بعد أن نتحلل البيانات observed إلى مكونات trend seasonal residual ، كشفنا عن تأثير العروض الترويجية بوضوح لاتخاذ قرار يكون العرض الترويجي أفضل في كل بلد.

بالإضافة إلى ذلك ، استخدمنا Random Forest Regression في مشكلة التنبؤ هذه لتعزيز قرارنا.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

ML Service | ولدت بشكل عشوائي | Random Forest Classifier | Flask ، Docker ، Redis ، Sklearn | https://github.com/erdiolmezogullari/ml-dockerized-microservice |

في هذا المشروع ، تم تطوير ML based micro-service على قمة REST و Docker بعد بناء نموذج التعلم الآلي عن طريق أداء Random Forest

استخدمنا docker-compose لإطلاق الخدمات الصغيرة أدناه.

1.Jupyter Notebook,

2.Restful Comm. (Flask),

3.Redis

بعد أن أنشأنا ثلاث حاوية مختلفة ، سيكون MLASS جاهزًا.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

PySpark | ولدت بشكل عشوائي | Random Forest Classifier | Spark (PySpark) ، Sklearn ، Pandas ، Seaborn | https://github.com/erdiolmezogullari/ML-Random-forest-pyspark |

في هذا المشروع ، يمكنك العثور على مجموعة من رمز النماذج المتعلقة بكيفية استخدام Mllib's Pyspark Spark (مصنف الغابات العشوائي) ، وخط الأنابيب عبر Pyspark.

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Data Enrichment | مكاني | Kd-tree | cKDTree | https://github.com/erdiolmezogullari/ml- Join-Spatial-Data |

في هذا المشروع ، لإنشاء برنامج نصي فعال يجد أقرب مطار لمستخدم معين بناءً على تحديد الموقع الجغرافي والتوسيع الجغرافي للمطار.

لجعل هذا إثراء البيانات ، استخدمنا خوارزمية Kd-tree .

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Implementation | إحصائيات البلدان | K-Means | Java SDK | https://github.com/erdiolmezogullari/ML-K-Means |

في هذا المشروع ، تم تنفيذ خوارزمية التجميع K-Mean في Java من الصفر. DataSet: https://en.wikibooks.org/wiki/data_mining_algorithms_in_r/clustering/k-means#input_data

| مشكلة | بيانات | طُرق | libs | وصلة |

|---|---|---|---|---|

Forecasting, Timeseries Analysis | سعر بقعة AWS EC2 | Adaboost Classifier ، Decision Tree | Rapidminer | https://github.com/erdiolmezogullari/ML-Forecasting-Aws-Pot-Price |

في هذا المشروع ، سوف نستخدم البيانات العامة ، التي تم جمعها من قبل أشخاص طرف ثالث وإصدارها من خلال بعض مواقع الويب المحددة. نظرًا لأن بياناتنا ستكون مرتبطة بشكل أساسي بحوسبة Amazon Web Services (AWS) المرنة (EC2) ، فستكون من بعض الحقول المختلفة. EC2 هو نوع من الجهاز الظاهري في سحابة AWS. يمكن إنشاء جهاز افتراضي في الوقت المناسب إما على السحابة الخاصة أو العامة عبر AWS كلما احتجت إليها. يمكن اختيار جهاز افتراضي جديد فيما يتعلق بمواصفات وتكوينات مختلفة من حيث وحدة المعالجة المركزية ، وذاكرة الوصول العشوائي ، والتخزين ، وحد نطاق الشبكة قبل إنشائها مرة واحدة من نقطة الصفر. يتم فصل آلات EC2 أيضًا من قبل AWS في مناطق جغرافية مختلفة (الولايات المتحدة الشرقية ، الولايات المتحدة ويست ، الاتحاد الأوروبي ، آسيا والمحيط الهادئ ، أمريكا الجنوبية) ومنطقة لزيادة توافر الأجهزة الافتراضية في جميع أنحاء العالم. لدى AWS أجزاء مختلفة ، والتي تم تصنيفها فيما يتعلق بمواصفات النظام من قبل AWS على أساس أهداف مختلفة (مثيل ماكرو ، الغرض العام ، حساب الأمثل ، التخزين الأمثل ، مثيل GPU ، الذاكرة المحسنة). خيارات الدفع مخصصة ، OnDemand و SPOT مثيل. نظرًا لأنهم يقومون بتكلفة مختلفة لتشغيل العميل ، فقد يفضل العملاء أنواعًا مختلفة من الآلات الافتراضية وفقًا لأهدافهم وميزانياتهم. بشكل عام ، يكون مثيل SPOT أرخص من بقية الخيارات. ومع ذلك ، قد يتم مقاطعة مثيل SPOT إذا تجاوز سعر السوق عرض MAX لدينا. في بحثنا ، سوف نركز على دفعة مثيل موضعي. سيكون هدفنا في هذا المشروع هو اختيار مثيل AWS الصحيح من سوق مثيل SPOT وفقًا لمتطلبات العميل. نخطط لأداء شجرة القرار على دفق البيانات لاتخاذ قرار أثناء الطيران. قد يتم تنفيذه كنسخة تدريجية من شجرة القرار لأن البيانات تتغير بشكل مستمر