Cet article présente un modèle de reconstruction gaussienne 4D à grande échelle appelé L4GM, capable de générer efficacement des objets animés de haute qualité à partir de vidéos à vue unique. Il est formé sur un vaste ensemble de données contenant des vidéos multi-vues et est conçu de manière innovante pour atteindre une vitesse de traitement rapide d'une seconde seulement pour une transmission unidirectionnelle. L'avantage de L4GM est qu'il peut reconstruire des vidéos longues et des vidéos à fréquence d'images élevée, et prend en charge l'interpolation 4D pour augmenter considérablement la fréquence d'images vidéo. De plus, le modèle montre également une bonne capacité de généralisation et peut obtenir des résultats satisfaisants dans des vidéos de scènes réelles.

Récemment, l'équipe de recherche a proposé un modèle de reconstruction gaussienne 4D à grande échelle appelé L4GM, capable de générer des objets animés à partir d'entrées vidéo à vue unique et d'obtenir des résultats impressionnants.

La clé de ce modèle réside dans l'ensemble de données innovant et la conception simplifiée, qui permettent d'effectuer un transfert unidirectionnel en une seconde seulement, tout en garantissant la haute qualité des objets animés en sortie.

Vidéo vers la composition 4D

L4GM peut générer des objets 4D à partir de vidéos en quelques secondes. Dans l'exemple vidéo suivant, vous pouvez voir l'objet cible dans la vidéo originale et le modèle de reconstruction gaussienne 4D correspondant.

Reconstruisez des vidéos flexibles, longues, à FPS élevés

Et reconstruisez une vidéo de 10 secondes à 30 ips. A titre d'exemple dans la vidéo suivante,

Interpolation 4D

L’équipe a également formé un modèle d’interpolation 4D pour augmenter la fréquence d’images de 3 fois. A titre d'exemple dans la vidéo suivante,

Gauche : avant interpolation. À droite : après interpolation

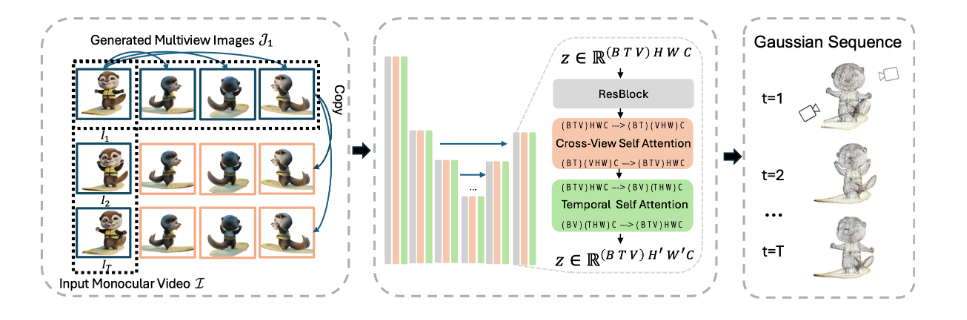

Créer un ensemble de données vidéo en perspective

L’équipe de recherche a construit un ensemble de données contenant des vidéos multi-vues contenant des objets animés soigneusement conçus et rendus à partir de l’Objaverse. Cet ensemble de données affiche 44 000 objets divers couvrant 110 000 animations depuis 48 points de vue, ce qui donne un total de 120 millions de vidéos avec un total de 300 millions d'images. Sur la base de cet ensemble de données, L4GM est directement construit sur le modèle de reconstruction 3D à grande échelle déjà pré-entraîné LGM, qui génère des ellipsoïdes gaussiens 3D à partir d'une entrée d'image multi-vues.

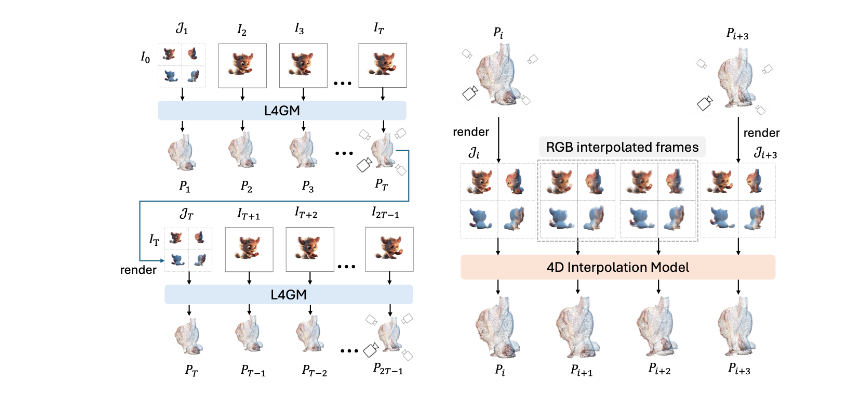

L4GM obtient une fluidité temporelle en générant une représentation splash gaussienne 3D de chaque image sur des images vidéo échantillonnées à faible ips, puis en suréchantillonnant la représentation à des ips plus élevées.

Afin d'aider le modèle à apprendre la cohérence temporelle, l'équipe de recherche a ajouté une couche d'auto-attention temporelle au LGM de base et a utilisé la perte de rendu multi-vues à chaque pas de temps pour entraîner le modèle. En entraînant un modèle d'interpolation, cette représentation est suréchantillonnée à une fréquence d'images plus élevée, ce qui donne une représentation gaussienne 3D intermédiaire.

L’équipe de recherche a démontré la bonne capacité de généralisation de L4GM sur des vidéos en milieu sauvage après une formation sur des données synthétiques, produisant des objets 3D animés de haute qualité. Le modèle accepte en entrée une vidéo à vue unique et des images multi-vues à un seul pas de temps, et génère un ensemble de distributions de probabilité gaussiennes 4D.

cadre technique

Le modèle prend en entrée une vidéo à vue unique et une image à vues multiples en un seul pas de temps, et génère un ensemble de gaussiennes 4D. Il adopte l'architecture U-Net, utilise l'auto-attention croisée pour obtenir une cohérence de vue et utilise l'auto-attention temporelle vers l'espace pour obtenir une cohérence temporelle.

L4GM permet une reconstruction autorégressive, en utilisant un rendu multi-vues de la dernière gaussienne comme entrée pour la reconstruction suivante. Il existe une image de chevauchement entre deux reconstructions consécutives. En outre, l’équipe de recherche a également formé un modèle d’interpolation 4D. Le modèle d'interpolation reçoit la vidéo multi-vue interpolée rendue à partir des résultats de reconstruction et génère la gaussienne interpolée.

Les scénarios applicables à L4GM incluent :

Génération de contenu vidéo : L4GM peut générer des modèles 4D d'objets animés à partir d'une entrée vidéo à vue unique, ce qui a de nombreuses applications dans la production d'effets spéciaux vidéo, le développement de jeux et d'autres domaines. Par exemple, il peut être utilisé pour générer des animations d’effets spéciaux, créer des scènes virtuelles, etc.

Reconstruction et réparation vidéo : L4GM peut reconstruire des vidéos à long terme à fréquence d'images élevée et peut être utilisé pour la réparation et la restauration vidéo afin d'améliorer la qualité et la clarté de la vidéo. Cela peut être utile pour la restauration de films, la compression vidéo et le traitement vidéo.

Interpolation vidéo : grâce au modèle d'interpolation 4D entraîné, L4GM peut augmenter la fréquence d'images de la vidéo et rendre la vidéo plus fluide. Cela a des applications potentielles dans le montage vidéo, la production d’effets de ralenti/accéléré, etc.

Génération d'actifs 3D : L4GM peut générer des actifs 3D animés de haute qualité, ce qui est très utile pour la génération de modèles 3D dans les applications de réalité virtuelle (VR), de réalité augmentée (AR) et le développement de jeux.

Entrée du produit : https://top.aibase.com/tool/l4gm

Dans l'ensemble, le modèle L4GM a fait des progrès significatifs dans le domaine de la reconstruction gaussienne 4D, et son rendement élevé, sa sortie de haute qualité et ses larges perspectives d'application en font un résultat de recherche d'une grande importance. L’émergence de ce modèle favorisera grandement les progrès dans des domaines tels que le traitement vidéo et la génération d’actifs 3D.