In diesem Artikel wird ein groß angelegtes 4D-Gaußsches Rekonstruktionsmodell namens L4GM vorgestellt, das in der Lage ist, aus Einzelansichtsvideos effizient hochwertige animierte Objekte zu generieren. Es basiert auf einem großen Datensatz mit Videos mit mehreren Ansichten und ist innovativ konzipiert, um eine schnelle Verarbeitungsgeschwindigkeit von nur einer Sekunde für die Übertragung in eine Richtung zu erreichen. Der Vorteil von L4GM besteht darin, dass es lange Videos und Videos mit hoher Bildrate rekonstruieren kann und 4D-Interpolation unterstützt, um die Videobildrate deutlich zu erhöhen. Darüber hinaus weist das Modell auch eine gute Generalisierungsfähigkeit auf und kann in realen Szenenvideos zufriedenstellende Ergebnisse erzielen.

Kürzlich schlug das Forschungsteam ein groß angelegtes 4D-Gaußsches Rekonstruktionsmodell namens L4GM vor, das aus Einzelansicht-Videoeingaben animierte Objekte generieren und beeindruckende Ergebnisse erzielen kann.

Der Schlüssel zu diesem Modell ist der innovative Datensatz und das vereinfachte Design, das eine einfache Übertragung in nur einer Sekunde ermöglicht und gleichzeitig die hohe Qualität der ausgegebenen animierten Objekte gewährleistet.

Vom Video zum 4D-Compositing

L4GM kann in wenigen Sekunden 4D-Objekte aus Videos generieren. Im folgenden Videobeispiel sehen Sie das Zielobjekt im Originalvideo und das entsprechende generierte 4D-Gaußsche Rekonstruktionsmodell.

Rekonstruieren Sie lange, flexible Videos mit hohen FPS

Und rekonstruieren Sie ein 10 Sekunden langes 30-fps-Video. Als Beispiel im folgenden Video:

4D-Interpolation

Das Team trainierte außerdem ein 4D-Interpolationsmodell, um die Bildrate um das Dreifache zu erhöhen. Als Beispiel im folgenden Video:

Links: vor der Interpolation. Rechts: nach der Interpolation

Erstellen Sie einen perspektivischen Videodatensatz

Das Forschungsteam erstellte einen Datensatz mit Multi-View-Videos mit sorgfältig gestalteten, gerenderten animierten Objekten aus dem Objaversum. Dieser Datensatz zeigt 44.000 verschiedene Objekte mit 110.000 Animationen aus 48 Blickwinkeln, was insgesamt 120 Millionen Videos mit insgesamt 300 Millionen Bildern ergibt. Basierend auf diesem Datensatz baut L4GM direkt auf dem bereits vorab trainierten 3D-Großrekonstruktionsmodell LGM auf, das 3D-Gaußsche Ellipsoide aus der Bildeingabe mit mehreren Ansichten ausgibt.

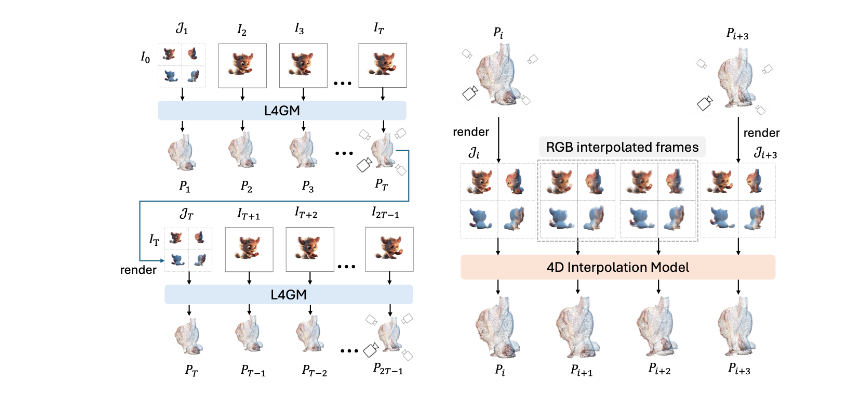

L4GM erreicht eine zeitliche Glätte, indem es für jedes Bild eine 3D-Gaußsche Splash-Darstellung auf Videobildern generiert, die mit niedrigen Bildern pro Sekunde abgetastet wurden, und die Darstellung dann auf höhere Bilder pro Sekunde hochsampelt.

Um dem Modell dabei zu helfen, zeitliche Konsistenz zu erlernen, fügte das Forschungsteam dem grundlegenden LGM eine zeitliche Selbstaufmerksamkeitsebene hinzu und nutzte bei jedem Zeitschritt den Multi-View-Rendering-Verlust, um das Modell zu trainieren. Durch das Training eines Interpolationsmodells wird diese Darstellung auf eine höhere Bildrate hochgesampelt, was zu einer mittleren 3D-Gaußschen Darstellung führt.

Das Forschungsteam demonstrierte die gute Generalisierungsfähigkeit von L4GM anhand von Videos in freier Wildbahn, nachdem es mit synthetischen Daten trainiert wurde, und erzeugte qualitativ hochwertige animierte 3D-Objekte. Das Modell akzeptiert Einzelansichtsvideos und Einzelzeitschritt-Mehrfachansichtsbilder als Eingabe und gibt einen Satz 4D-Gaußscher Wahrscheinlichkeitsverteilungen aus.

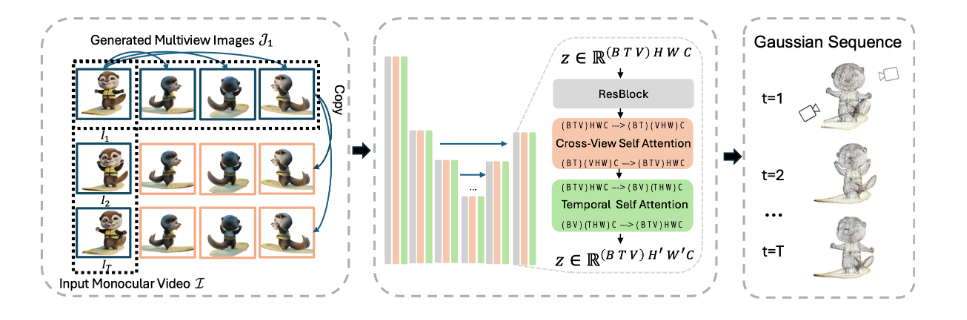

technischer Rahmen

Das Modell verwendet als Eingabe ein Einzelansichtsvideo und ein Einzelzeitschritt-Mehrfachansichtsbild und gibt einen Satz 4D-Gauß-Funktionen aus. Es übernimmt die U-Net-Architektur, verwendet ansichtsübergreifende Selbstaufmerksamkeit, um Ansichtskonsistenz zu erreichen, und nutzt zeit-räumliche Selbstaufmerksamkeit, um zeitliche Konsistenz zu erreichen.

L4GM ermöglicht eine autoregressive Rekonstruktion, wobei ein Multi-View-Rendering der letzten Gaußschen Funktion als Eingabe für die nächste Rekonstruktion verwendet wird. Zwischen zwei aufeinanderfolgenden Rekonstruktionen gibt es einen Überlappungsrahmen. Darüber hinaus trainierte das Forschungsteam auch ein 4D-Interpolationsmodell. Das Interpolationsmodell empfängt das interpolierte Multi-View-Video, das aus den Rekonstruktionsergebnissen gerendert wurde, und gibt den interpolierten Gaußschen Wert aus.

Zu den anwendbaren L4GM-Szenarien gehören:

Generierung von Videoinhalten: L4GM kann 4D-Modelle animierter Objekte aus Einzelansicht-Videoeingaben generieren, was breite Anwendungsmöglichkeiten in der Produktion von Videospezialeffekten, der Spieleentwicklung und anderen Bereichen bietet. Es kann beispielsweise zum Generieren von Spezialeffektanimationen, zum Erstellen virtueller Szenen usw. verwendet werden.

Videorekonstruktion und -reparatur: L4GM kann Langzeitvideos mit hoher Bildrate rekonstruieren und kann zur Videoreparatur und -wiederherstellung verwendet werden, um die Videoqualität und -klarheit zu verbessern. Dies kann bei der Filmwiederherstellung, Videokomprimierung und Videoverarbeitung nützlich sein.

Videointerpolation: Durch das trainierte 4D-Interpolationsmodell kann L4GM die Bildrate des Videos erhöhen und das Video flüssiger machen. Dies bietet potenzielle Anwendungen in der Videobearbeitung, der Produktion von Zeitlupen-/Zeitraffereffekten usw.

3D-Asset-Generierung: L4GM kann hochwertige animierte 3D-Assets generieren, was für die 3D-Modellgenerierung in Virtual Reality (VR), Augmented Reality (AR)-Anwendungen und Spieleentwicklung sehr nützlich ist.

Produkteingang: https://top.aibase.com/tool/l4gm

Insgesamt hat das L4GM-Modell im Bereich der 4D-Gauß-Rekonstruktion erhebliche Fortschritte gemacht und ist aufgrund seiner hohen Effizienz, der qualitativ hochwertigen Ausgabe und der breiten Anwendungsaussichten ein Forschungsergebnis von großer Bedeutung. Die Entstehung dieses Modells wird den Fortschritt in Bereichen wie der Videoverarbeitung und der 3D-Asset-Generierung erheblich vorantreiben.