? Coala: des agents de langue impressionnants

Une compilation d'agents linguistiques utilisant le cadre des architectures cognitives pour les agents linguistiques (? Coala) .

- Coala Paper (16 pages de contenu principal): https://arxiv.org/abs/2309.02427

- Coala Tweet (6 threads): https://twitter.com/shunyuyao12/status/169939683498362690

- Fichier de BoBaa Bibtex avec plus de 300 citations liées: Coala.bib

- Coala Bibtex Citation si vous trouvez notre travail / ressources utile:

@misc { sumers2023cognitive ,

title = { Cognitive Architectures for Language Agents } ,

author = { Theodore Sumers and Shunyu Yao and Karthik Narasimhan and Thomas L. Griffiths } ,

year = { 2023 } ,

eprint = { 2309.02427 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.AI }

}? Présentation du charbon

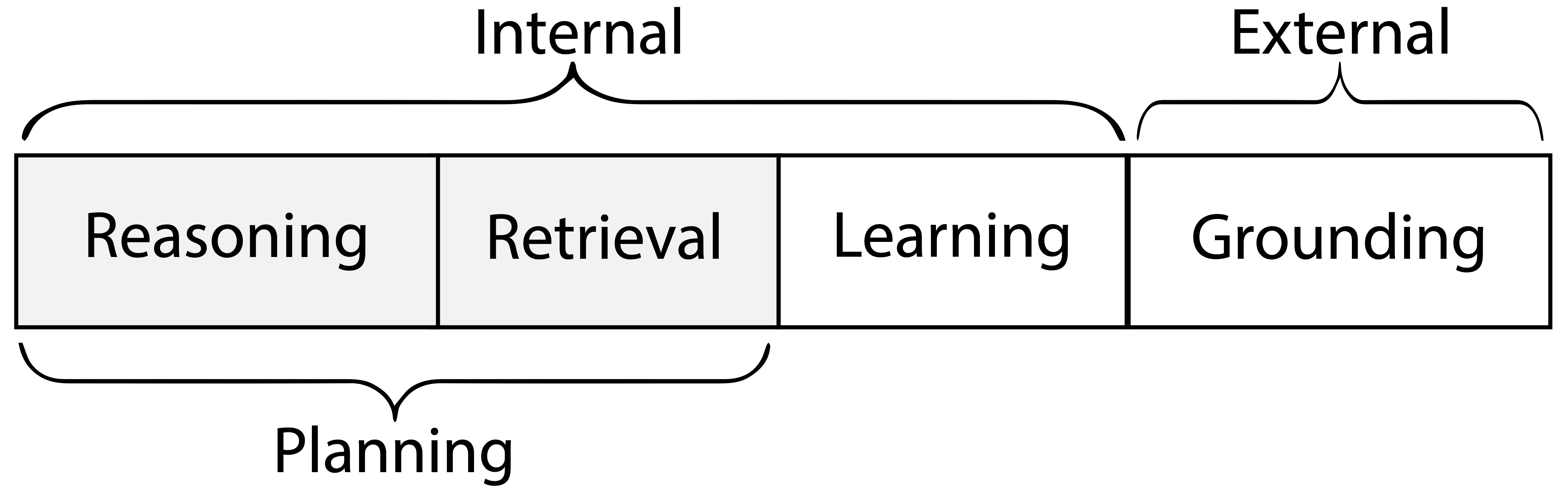

Coala spécifie parfaitement un agent linguistique commençant par son espace d'action , qui a 2 parties:

- Actions externes pour interagir avec des environnements externes ( mise à la terre )

- Actions internes pour interagir avec les souvenirs internes ( raisonnement , récupération , apprentissage )

- Un agent linguistique a une mémoire de travail à court terme et plusieurs souvenirs à long terme (facultatifs) (épisodique pour l'expérience, sémantique pour les connaissances, procédure pour le code / LLM)

- Raisonnement = mise à jour de la mémoire de travail (avec LLM)

- Retrieval = Lire la mémoire à long terme

- Apprentissage = écrire de la mémoire à long terme

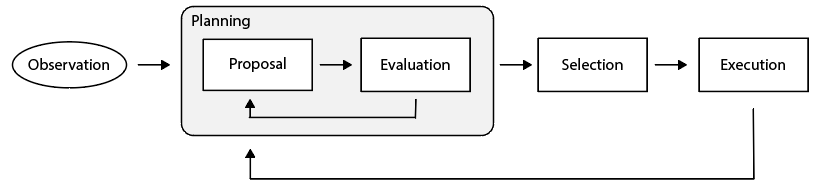

Ensuite, comment un agent linguistique choisit-il l'action à prendre? Ses actions sont structurées en cycles de prise de décision , et chaque cycle a deux étapes:

- Planification : L'agent applique des actions de raisonnement / de récupération pour proposer et évaluer (itérativement) des actions, puis sélectionner une action d'apprentissage / mise à la terre.

- Exécution : l'action d'apprentissage / mise à la terre sélectionné est exécutée pour affecter la mémoire interne ou le monde externe.

Pour en savoir plus, lisez la section 4 de notre article.

Papiers

Vous trouverez ci-dessous seulement un sous-ensemble de papiers grattés de Coala.Bib Plus des demandes tirées, avec des étiquettes d'espace d'action potentiellement incorrectes. La date est basée sur ARXIV V1. Ils ne représentent pas tous les travaux d'agent linguistique et nous prévoyons d'ajouter plus de travail bientôt (les demandes de traction sont bienvenues) et ont des étiquettes pour un travail très cité.

- (2021-10) Chaînes d'IA: interaction humaine transparente et contrôlable par le chaîne de modèles de gros langage (raisonnement)

- (2021-10) SILG: The Multi-Environment Symbolic Interactive Language Benchmark (Environment)

- (2022-01) Modèles linguistiques en tant que planificateurs de tirs zéro: extraire des connaissances exploitables pour les agents incarnés (mise à la terre)

- (2022-03) Promptchainer: le modèle de chaîne de choumail invite par la programmation visuelle (mise à la terre)

- (2022-03) SCIENCEWORLD: Votre agent est-il plus intelligent qu'un élève de 5e? (environnement)

- (2022-04) Faites ce que je peux, pas comme je le dis: la langue de mise à la terre dans les possibilités robotiques (mise à la terre)

- (2022-04) Modèles socratiques: composer un raisonnement multimodal à tirs zéro avec la langue (mise à la terre)

- (2022-07) Webshop: vers une interaction Web réelle évolutive avec des agents linguistiques ancrés (environnement)

- (2022-09) PROGPROMPT: Génération de plans de tâches de robot situés à l'aide de modèles de langue importants (mise à la terre)

- (2022-10) Invite décomposée: une approche modulaire pour résoudre des tâches complexes (raisonnement)

- (2022-10) Mind's Eye: Modèle de langage fondé Raisonnement par simulation (mise à la terre)

- (2022-10) REACT: Synergie Raisonnement et Agissant dans les modèles de langues (mise à la terre, raisonnement)

- (2022-11) Les grands modèles de langue sont des ingénieurs rapides de niveau humain (raisonnement)

- (2022-12) LLM-Planner: Planification fondée sur quelques coups pour les agents incarnés avec des modèles de grands langues (mise à la terre)

- (2022-12) Ne générez pas, discriminez: une proposition de mise à la terre des modèles de langage dans des environnements réels (mise à la terre)

- (2023-02) La chaîne du recul aligne des modèles de langue avec la rétroaction (apprentissage)

- (2023-02) Décrire, expliquer, planifier et sélectionner: la planification interactive avec de grands modèles de langue permet aux agents multi-tâches en monde ouvert (mise à la terre, raisonnement)

- (2023-02) Formateur d'outils: les modèles de langage peuvent s'apprendre à utiliser des outils (mise à la terre)

- (2023-03) Modèles de fondation pour la prise de décision: problèmes, méthodes et opportunités (enquête)

- (2023-03) Hugginggpt: Résoudre des tâches AI avec Chatgpt et ses amis dans un visage étreint (mise à la terre)

- (2023-03) PALM-E: Un modèle de langue multimodale incarné (mise à la terre)

- (2023-03) Réflexion: agents linguistiques avec apprentissage verbal du renforcement (mise à la terre, raisonnement, apprentissage)

- (2023-03) Auto-raffine: raffinement itératif avec auto-alimentation (raisonnement)

- (2023-03) Génération de code d'auto-planification avec de grands modèles de langue (raisonnement)

- (2023-04) Agents génératifs: Simulacra interactive du comportement humain (mise à la terre, raisonnement, récupération, apprentissage)

- (2023-04) Capacités de recherche scientifique autonomes émergents des modèles de gros langues (mise à la terre, raisonnement)

- (2023-04) LLM + P: Autonomiser les modèles de gros langues avec une maîtrise de la planification optimale (mise à la terre, raisonnement)

- (2023-04) REFIGER: Raisonnement des commentaires sur les représentations intermédiaires (raisonnement)

- (2023-04) Enseigner des modèles de grande langue à l'auto-plafond (raisonnement)

- (2023-04) Genegpt: Augmenter les modèles de gros langues avec des outils de domaine pour améliorer l'accès aux informations biomédicales (mise à la terre, raisonnement)

- (2023-05) Critique: Les modèles de grands langues peuvent s'auto-corriger avec une critique interactive des outils (mise à la terre, raisonnement, récupération)

- (2023-05) Augmenter les agents autotéliques avec des modèles de grandes langues (mise à la terre, raisonnement, récupération, apprentissage)

- (2023-05) CHATCOT: Raisonnement de la chaîne de réflexion à l'outil sur les modèles de grande langue basés sur le chat (mise à la terre, raisonnement)

- (2023-05) Toolkengpt: Augmenter les modèles de langage congelé avec des outils massifs via des incorporations d'outils (mise à la terre, raisonnement)

- (2023-05) La décomposition améliore le raisonnement via le décodage guidé par l'auto-évaluation (raisonnement)

- (2023-05) Encourager la pensée divergente dans les modèles de grande langue grâce à un débat multi-agents (mise à la terre, raisonnement)

- (2023-05) Amélioration de la factualité et du raisonnement dans les modèles de langues grâce à un débat multi-agents (mise à la terre, raisonnement)

- (2023-05) Adaplanner: planification adaptative à partir de commentaires avec des modèles de langue (mise à la terre, récupération, apprentissage)

- (2023-05) Plan-et-résolution Invite: Amélioration du raisonnement de la chaîne de réflexion à zéro par modèles de grande langue (raisonnement)

- (2023-05) Rewoo: Découplage du raisonnement des observations pour des modèles de langage augmentés efficaces (mise à la terre, raisonnement)

- (2023-05) Swiftsage: un agent génératif avec une réflexion rapide et lente pour les tâches interactives complexes (mise à la terre, raisonnement)

- (2023-05) Arbre de pensées: résolution de problèmes délibérée avec de grands modèles de langue (raisonnement)

- (2023-05) Voyager: un agent incarné à extrémité ouverte avec de grands modèles de langue (mise à la terre, raisonnement, récupération, apprentissage)

- (2023-06) Intercode: Standardizing et comparaison codage interactif avec rétroaction d'exécution (mise à la terre, raisonnement)

- (2023-06) ToolQA: un ensemble de données pour la question LLM répondant avec des outils externes (mise à la terre)

- (2023-06) Mind2Web: Vers un agent généraliste pour le Web (environnement)

- (2023-06) RESTGPT: Connexion de grands modèles de langue avec des API RESTfuls réels (mise à la terre, raisonnement)

- (2023-06) ToolalPACA: apprentissage d'outils généralisés pour les modèles de langue avec 3000 cas simulés (mise à la terre, raisonnement)

- (2023-07) Un webagent réel avec la planification, la compréhension du contexte long et la synthèse du programme (mise à la terre, raisonnement)

- (2023-07) RT-2: Modèles d'action visuelle-action transférer les connaissances Web vers un contrôle robotique (mise à la terre)

- (2023-07) ROCO: Collaboration dialectique multi-robot avec des modèles de grande langue (mise à la terre)

- (2023-07) Robots qui demandent de l'aide: Alignement d'incertitude pour les planificateurs de modèles à grande langue (mise à la terre)

- (2023-07) S $ ^ 3 $: Système de simulation de réseaux sociaux avec des agents de grande envergure à la langue maternelle (mise à la terre, raisonnement)

- (2023-07) TOOLLLM: faciliter les modèles de gros langues pour maîtriser plus de 16000 API du monde réel (mise à la terre, raisonnement, récupération)

- (2023-07) Comprendre les avantages et les défis de l'utilisation d'agents conversationnels basés sur un modèle de langage pour le soutien au bien-être mental (mise à la terre)

- (2023-07) Débrocheur cognitive Synergie dans les modèles de grande langue: un agent de résolution de tâches par le biais de l'auto-collaboration multi-Personnes (mise à la terre, raisonnement)

- (2023-07) Webarena: un environnement Web réaliste pour créer des agents autonomes (environnement)

- (2023-08) AgentBench: Évaluation des LLM en tant qu'agents (environnement)

- (2023-08) Agentverse: faciliter la collaboration multi-agents et explorer les comportements émergents chez les agents (environnement)

- (2023-08) Autogène: Activation des applications LLM de nouvelle génération via le cadre de conversation multi-agents (mise à la terre, raisonnement)

- (2023-08) CGMI: Cadre d'interaction multi-agents configurable (mise à la terre, raisonnement)

- (2023-08) Chateval: Vers de meilleurs évaluateurs basés sur LLM grâce à un débat multi-agents (mise à la terre, raisonnement)

- (2023-08) Raisonnement cumulatif avec de grands modèles de langue (raisonnement)

- (2023-08) Expulsion: les agents LLM sont des apprenants expérientiels (mise à la terre, raisonnement, récupération, apprentissage)

- (2023-08) GPT-in-the-boucle: prise de décision adaptative pour les systèmes multi-agents (mise à la terre, raisonnement)

- (2023-08) Gentopia: une plate-forme collaborative pour les LLM (environnement) à outils (environnement)

- (2023-08) Metagpt: Meta Programming for Multi-Agent Collaborative Framework (mise à la terre, raisonnement)

- (2023-08) ProAgent: Construire une IA coopérative proactive avec des modèles de grandes langues (mise à la terre, raisonnement)

- (2023-08) Rétro-ou: Agents rétrospectifs de grande langue avec optimisation du gradient de politique (mise à la terre, raisonnement, apprentissage)

- (2023-08) SAPIEN: Agents virtuels affectifs alimentés par de grands modèles de langue (mise à la terre, raisonnement)

- (2023-08) Intégration synergique des modèles de grands langues et des architectures cognitives pour une IA robuste: une analyse exploratoire (mise à la terre, raisonnement, récupération, apprentissage)

- (2023-09) Tora: un agent de raisonnement intégré à l'outil pour la résolution de problèmes mathématiques (mise à la terre, raisonnement, apprentissage)

- (2023-09) Identification des risques des agents LM avec un sable émulé LM (environnement)

- (2023-09) Agent de suspicion: jouer à des jeux d'information imparfaits avec la théorie de l'esprit GPT-4 (mise à la terre, raisonnement)

- (2024-01) Contrast de soi: meilleure réflexion à travers des perspectives de résolution incohérentes (raisonnement, réflexion)

- (2024-02) Agent-Pro: Apprendre à évoluer via la réflexion et l'optimisation au niveau de la politique (raisonnement, réflexion, apprentissage)

- (2024-03) LLM3: Planification de tâches et de mouvement basée sur un modèle de langage avec raisonnement de défaillance de mouvement. (planification, raisonnement)

- (2024-04) Autonomiser la découverte biomédicale avec des agents de l'IA (scientifique de l'IA, recherche biomédicale)

- (2024-05) TimeChara: Évaluation de l'hallucination ponctuelle des personnages des modèles de grande langue de jeu de rôle (raisonnement, récupération)

(Plus à ajouter bientôt. Tirez la demande de bienvenue.)

Ressources

- Agents autonomes alimentés par LLM (lil'log)

- LLM-Agents-Papers

- Llmagentpapers

- Aménagement Awesome-llm-Agent

(Plus à ajouter bientôt. Tirez la demande de bienvenue.)