Atomgrad est un simple moteur Autograd qui vise à être entre Micrograd et Tinygrad qui effectue Autodiff sur les tenseurs (atomes) à valeur vectorielle et à valeur scalaire couplés à une bibliothèque API de réseau neuronal.

sum , exp , reshape , randint , uniform , etc.).relu , sigmoid , tanh , etc.binary_cross_entropy & binary_accuracy .Vous pouvez installer Atomgrad à l'aide de PIP:

pip install atomgrad==0.3.0Voici un exemple simple d'utilisation d'atomgrad pour calculer le gradient d'une fonction:

from atomgrad . atom import Atom

from atomgrad . graph import draw_dot

# create two tensors with gradients enabled

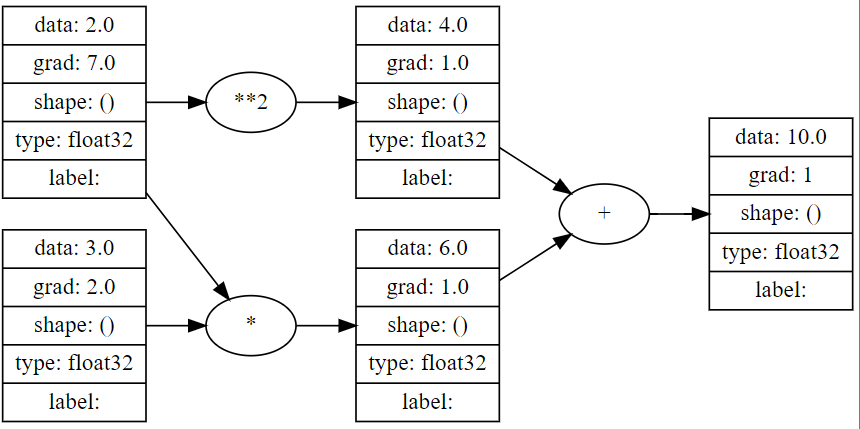

x = Atom ( 2.0 , requires_grad = True )

y = Atom ( 3.0 , requires_grad = True )

# define a function

z = x * y + x ** 2

# compute the backward pass

z . backward ()

# print the gradients

print ( x . grad ) # 7.0

print ( y . grad ) # 2.0

draw_dot ( z )

Voici un exemple simple d'utilisation d'atomgrad pour former un réseau neuronal de couche caché à 16 nœuds pour la classification binaire.

import numpy as np

from atomgrad . atom import Atom

from atomgrad . nn import AtomNet , Layer

from atomgrad . optim import SGD

from atomgrad . metrics import binary_cross_entropy , binary_accuracy

# create a model

model = AtomNet (

Layer ( 2 , 16 ),

Layer ( 16 , 16 ),

Layer ( 16 , 1 )

)

# create an optimizer

optim = SGD ( model . parameters (), lr = 0.01 )

# load some data

x = [[ 2.0 , 3.0 , - 1.0 ],

[ 3.0 , - 1.0 , 0.5 ],

[ 0.5 , 1.0 , 1.0 ],

[ 1.0 , 1.0 , - 1.0 ],

[ 0.0 , 4.0 , 0.5 ],

[ 3.0 , - 1.0 , 0.5 ]]

y = [ 1 , 1 , 0 , 1 , 0 , 1 ]

x = Atom ( x )

y = Atom ( y )

model . fit ( x , y , optim , binary_cross_entropy , binary_accuracy , epochs = 100 )

#output

'''

...

epoch: 30 | loss: 0.14601783454418182 | accuracy: 100.0%

epoch: 35 | loss: 0.11600304394960403 | accuracy: 100.0%

epoch: 40 | loss: 0.09604986757040024 | accuracy: 100.0%

epoch: 45 | loss: 0.0816292017698288 | accuracy: 100.0%

''' Un exemple d'autodiff simple et de quatre classificateurs binaires, y compris l'ensemble de données de données make_moons et les chiffres MNIST, se trouve dans le cahier examples/demos.ipynb .

Remarque: Bien atom.nn inclue l'activation softmax et cat_cross_entropy , les résultats du modèle sont assez disposés et sont probablement dus à un bug (PLZ LMK si vous le trouvez!). En conséquence, le modèle AtomNet est le mieux adapté aux tâches neurales de neural de classification binaire.