Atomgrad ist ein einfacher Autograd-Engine, der zwischen Micrograd und Tinygrad liegen soll, der Autodiff auf vektorbewertetem und skalarem Wert von Tensoren (Atomen) in Verbindung mit einer API-Bibliothek für neuronale Netzwerke ausführt.

sum , exp , reshape , randint , uniform usw.).relu , sigmoid , tanh usw.binary_cross_entropy & binary_accuracy .Sie können Atomgrad mit PIP installieren:

pip install atomgrad==0.3.0Hier ist ein einfaches Beispiel für die Verwendung von Atomgrades zur Berechnung des Gradienten einer Funktion:

from atomgrad . atom import Atom

from atomgrad . graph import draw_dot

# create two tensors with gradients enabled

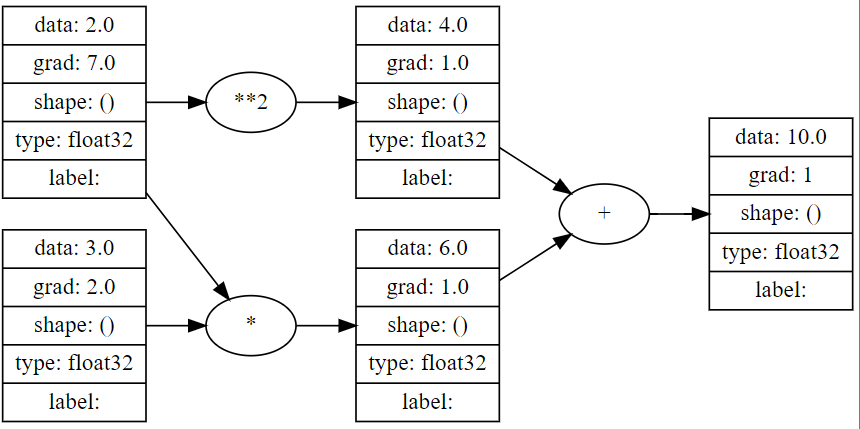

x = Atom ( 2.0 , requires_grad = True )

y = Atom ( 3.0 , requires_grad = True )

# define a function

z = x * y + x ** 2

# compute the backward pass

z . backward ()

# print the gradients

print ( x . grad ) # 7.0

print ( y . grad ) # 2.0

draw_dot ( z )

Hier finden Sie ein einfaches Beispiel für die Verwendung von Atomgrades zum Training eines einst-knüppelenden neuronalen Netzwerks für die Binärklassifizierung.

import numpy as np

from atomgrad . atom import Atom

from atomgrad . nn import AtomNet , Layer

from atomgrad . optim import SGD

from atomgrad . metrics import binary_cross_entropy , binary_accuracy

# create a model

model = AtomNet (

Layer ( 2 , 16 ),

Layer ( 16 , 16 ),

Layer ( 16 , 1 )

)

# create an optimizer

optim = SGD ( model . parameters (), lr = 0.01 )

# load some data

x = [[ 2.0 , 3.0 , - 1.0 ],

[ 3.0 , - 1.0 , 0.5 ],

[ 0.5 , 1.0 , 1.0 ],

[ 1.0 , 1.0 , - 1.0 ],

[ 0.0 , 4.0 , 0.5 ],

[ 3.0 , - 1.0 , 0.5 ]]

y = [ 1 , 1 , 0 , 1 , 0 , 1 ]

x = Atom ( x )

y = Atom ( y )

model . fit ( x , y , optim , binary_cross_entropy , binary_accuracy , epochs = 100 )

#output

'''

...

epoch: 30 | loss: 0.14601783454418182 | accuracy: 100.0%

epoch: 35 | loss: 0.11600304394960403 | accuracy: 100.0%

epoch: 40 | loss: 0.09604986757040024 | accuracy: 100.0%

epoch: 45 | loss: 0.0816292017698288 | accuracy: 100.0%

''' Ein Beispiel für einfache Autodiff und vier binäre Klassifizierer, einschließlich make_moons Dataset und MNIST Digits Dataset, befinden sich im examples/demos.ipynb .

HINWEIS: Obwohl atom.nn softmax -Aktivierung und cat_cross_entropy enthält, sind die Modellergebnisse ziemlich dissapellieren und wahrscheinlich auf einen Fehler zurückzuführen (PLZ LMK, wenn Sie es finden!). Infolgedessen eignet sich das AtomNet -Modell am besten für neuronale Nettoaufgaben der Binärklassifizierung.