Papier | Page du projet | Vidéo

Shangchen Zhou, Kelvin CK Chan, Chongyi Li, Chen Change Loy

S-Lab, Université technologique de Nanyang

Si CodeFormer est utile à vos images ou projets, veuillez aider à jouer ce dépôt. Merci! ?

dlib comme nouvelle option de détecteur de visage, il produit une identité de visage plus précise.--input_path [YOUR_VIDEO.mp4] . Essayez-le pour améliorer vos vidéos! ?

requirements.txt # git clone this repository

git clone https://github.com/sczhou/CodeFormer

cd CodeFormer

# create new anaconda env

conda create -n codeformer python=3.8 -y

conda activate codeformer

# install python dependencies

pip3 install -r requirements.txt

python basicsr/setup.py develop

conda install -c conda-forge dlib (only for face detection or cropping with dlib)

Téléchargez les modèles Facelib et Dlibs à partir de [Sortie | Google Drive | OneDrive] dans le dossier weights/facelib . Vous pouvez télécharger manuellement les modèles pré-entraînés ou télécharger en exécutant la commande suivante:

python scripts/download_pretrained_models.py facelib

python scripts/download_pretrained_models.py dlib (only for dlib face detector)

Téléchargez les modèles de CodeFormer pré-entraînés à partir de [versions | Google Drive | OneDrive] dans le dossier weights/CodeFormer . Vous pouvez télécharger manuellement les modèles pré-entraînés ou télécharger en exécutant la commande suivante:

python scripts/download_pretrained_models.py CodeFormer

Vous pouvez mettre les images de test dans le dossier inputs/TestWhole . Si vous souhaitez tester sur des visages recadrés et alignés, vous pouvez les mettre dans le dossier inputs/cropped_faces . Vous pouvez obtenir les visages recadrés et alignés en exécutant la commande suivante:

# you may need to install dlib via: conda install -c conda-forge dlib

python scripts/crop_align_face.py -i [input folder] -o [output folder]

[Remarque] Si vous souhaitez comparer CodeFormer dans votre article, veuillez exécuter la commande suivante indiquant --has_aligned (pour le visage recadré et aligné), car la commande de l'ensemble de l'image impliquera un processus de fusion de fond de face qui peut endommager la texture des cheveux à la limite, ce qui conduit à une comparaison déloyale.

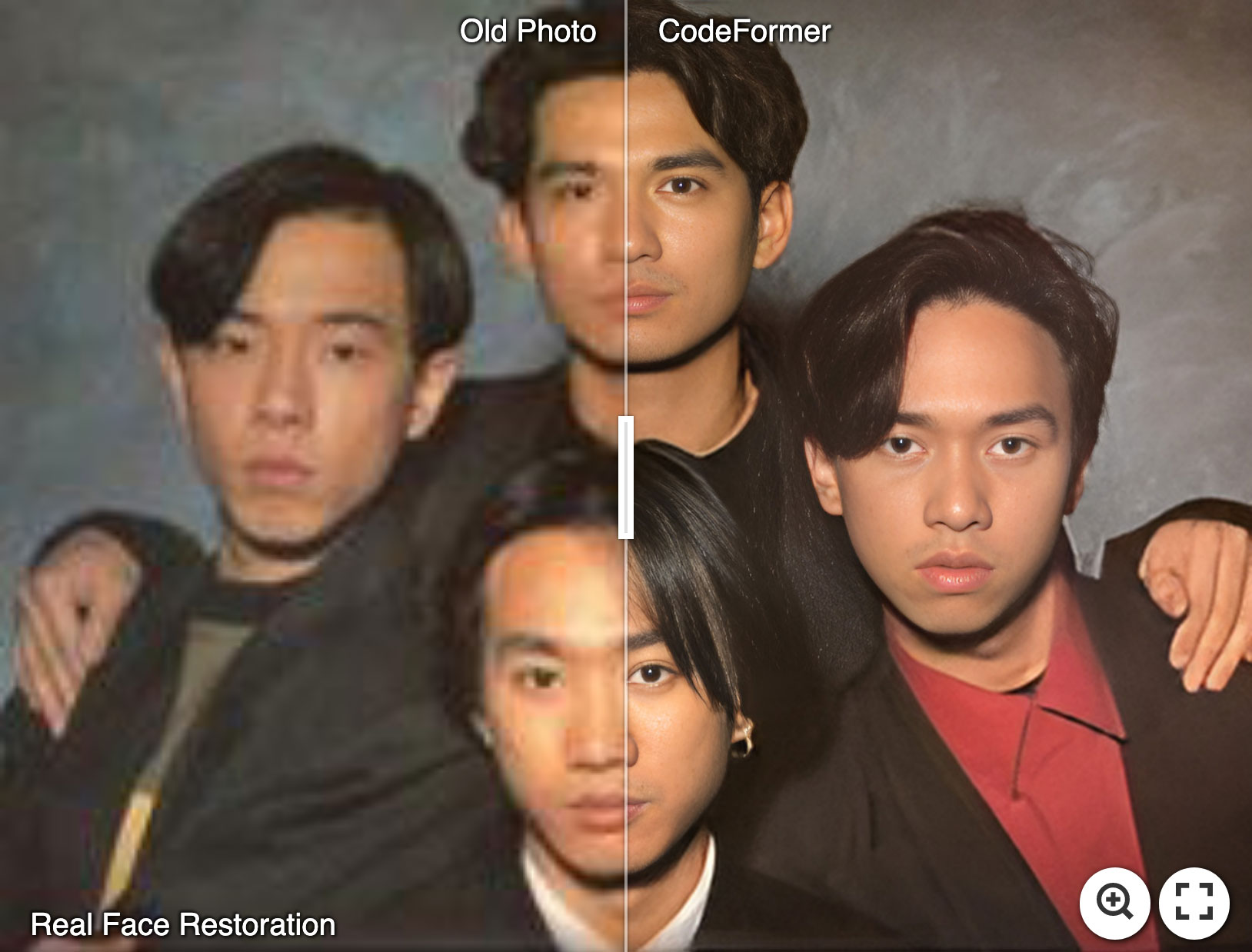

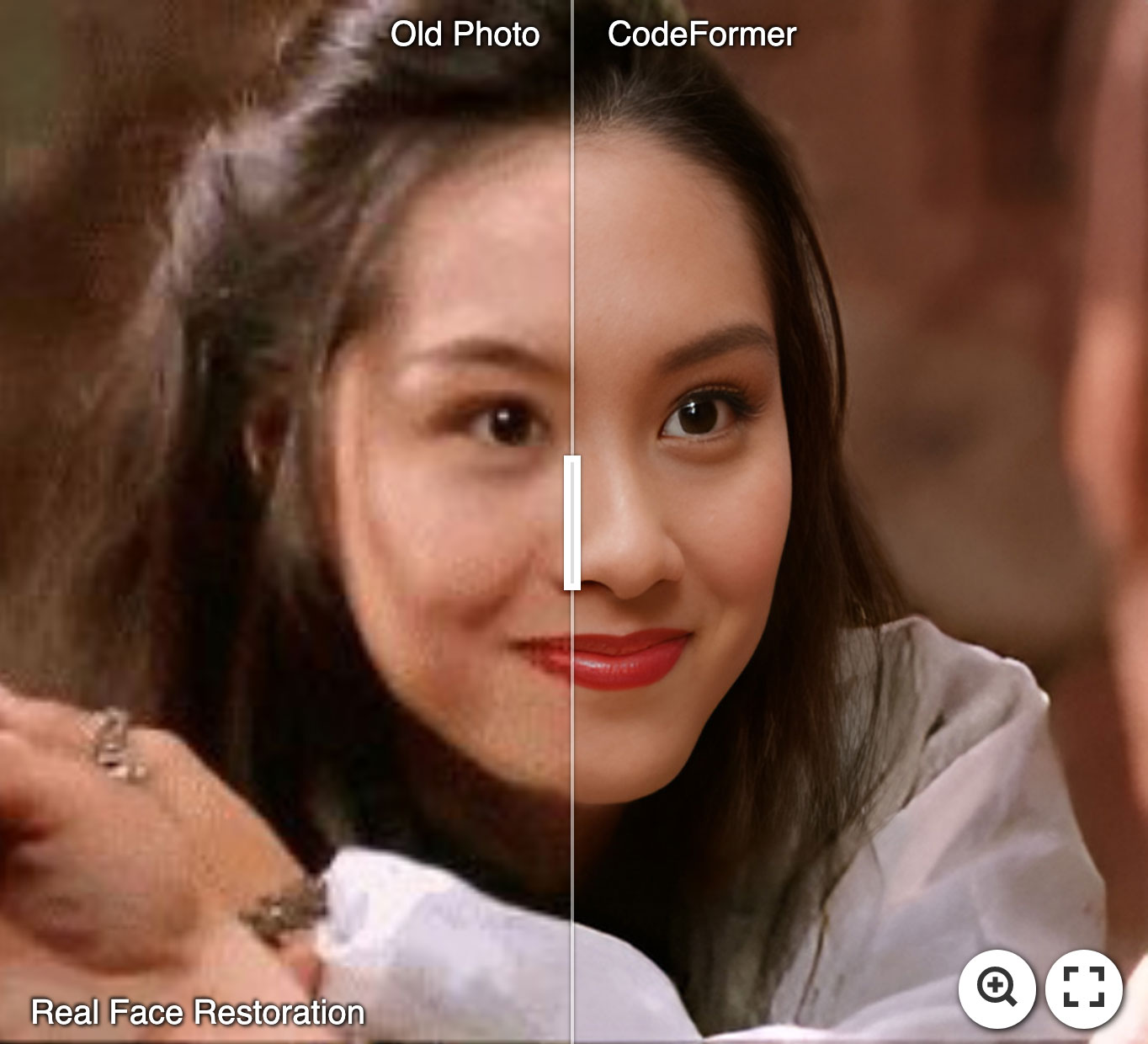

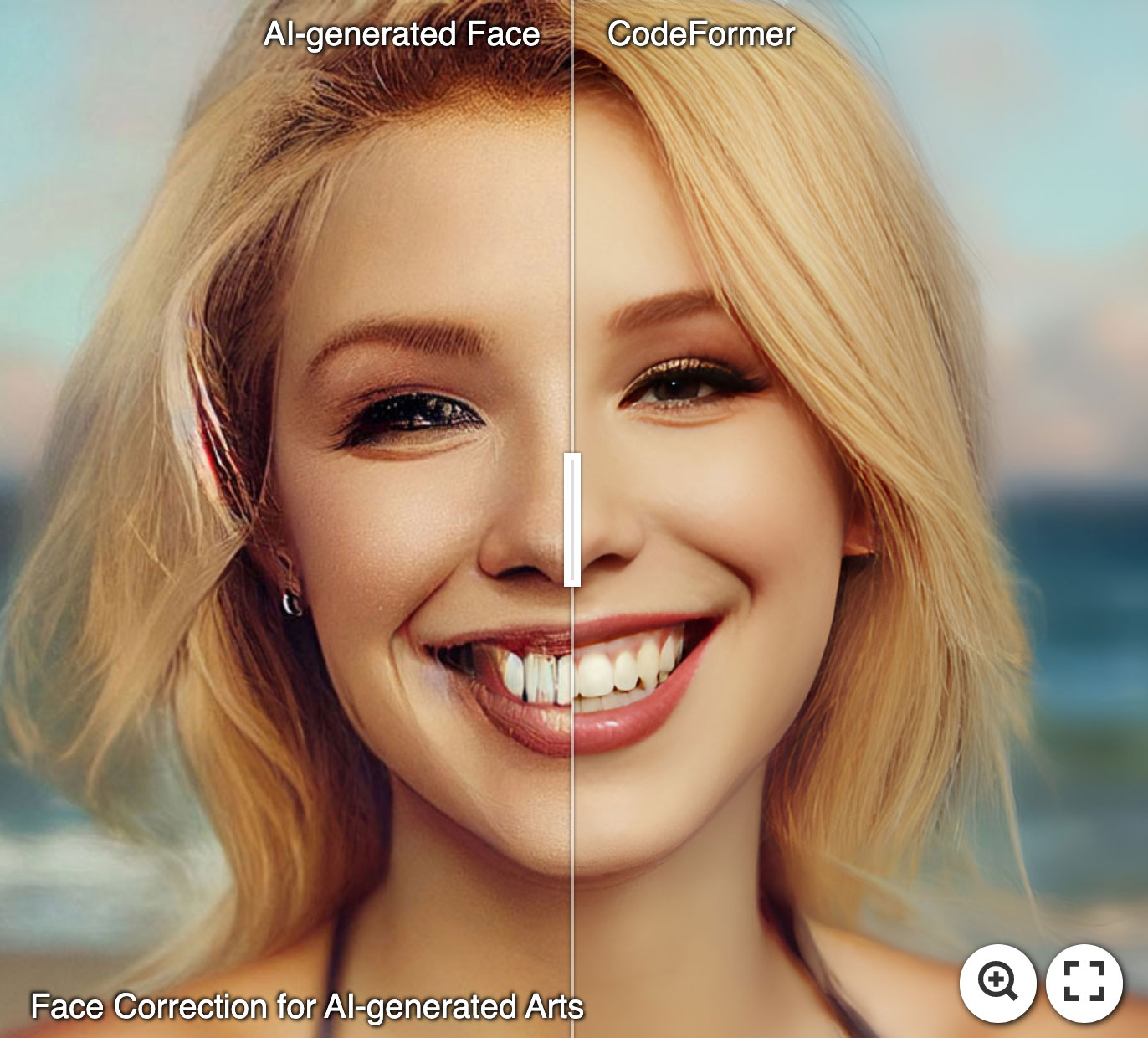

Le poids de la fidélité W pose [0, 1]. Généralement, le W plus petit a tendance à produire un résultat de meilleure qualité, tandis que le W plus important donne un résultat de fidélité plus élevée. Les résultats seront enregistrés dans le dossier results .

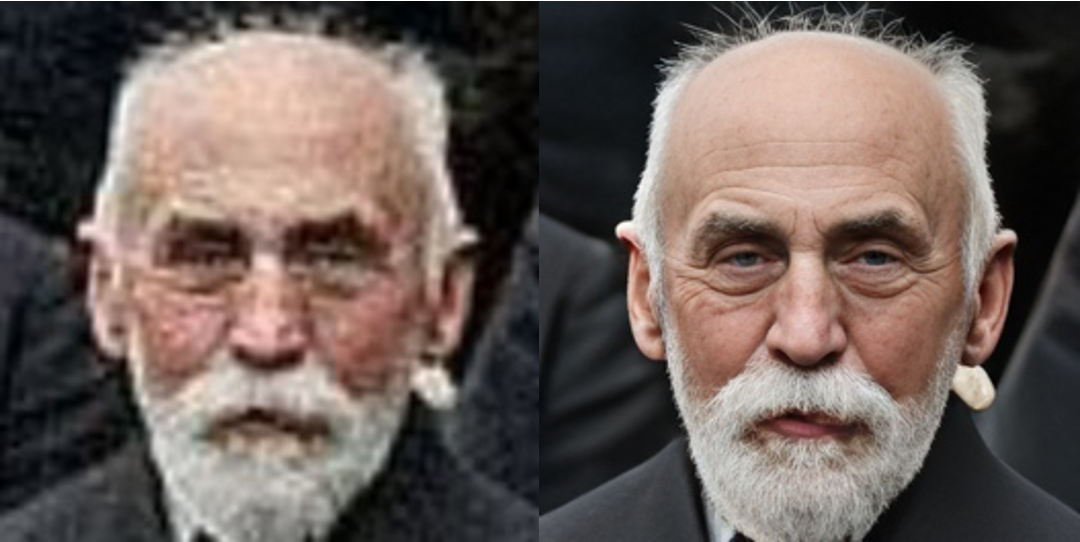

?? Restauration du visage (visage recadré et aligné)

# For cropped and aligned faces (512x512)

python inference_codeformer.py -w 0.5 --has_aligned --input_path [image folder]|[image path]

? ️ Amélioration de l'image entière

# For whole image

# Add '--bg_upsampler realesrgan' to enhance the background regions with Real-ESRGAN

# Add '--face_upsample' to further upsample restorated face with Real-ESRGAN

python inference_codeformer.py -w 0.7 --input_path [image folder]|[image path]

? Amélioration vidéo

# For Windows/Mac users, please install ffmpeg first

conda install -c conda-forge ffmpeg

# For video clips

# Video path should end with '.mp4'|'.mov'|'.avi'

python inference_codeformer.py --bg_upsampler realesrgan --face_upsample -w 1.0 --input_path [video path]

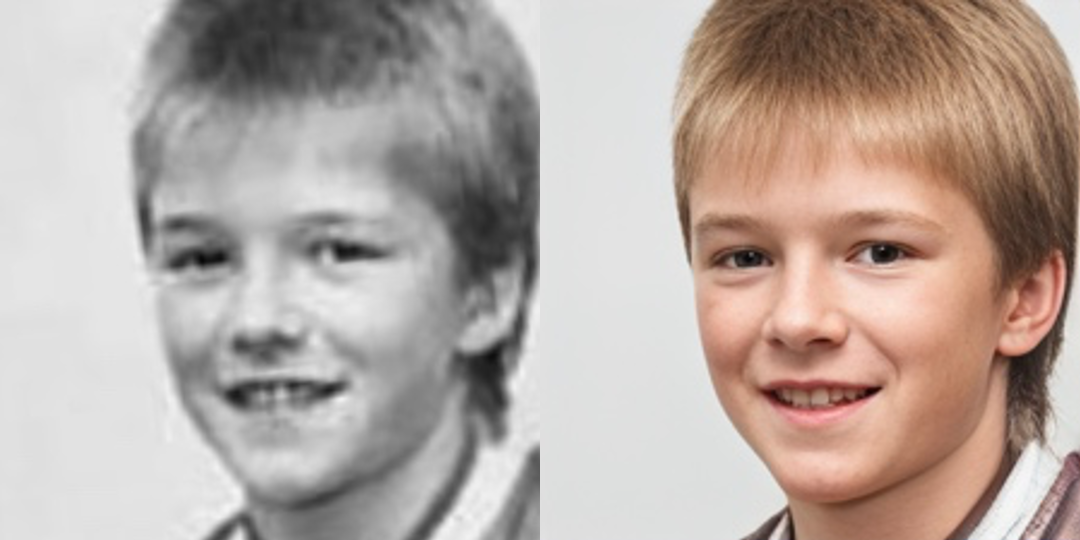

? Colorisation du visage (visage recadré et aligné)

# For cropped and aligned faces (512x512)

# Colorize black and white or faded photo

python inference_colorization.py --input_path [image folder]|[image path]

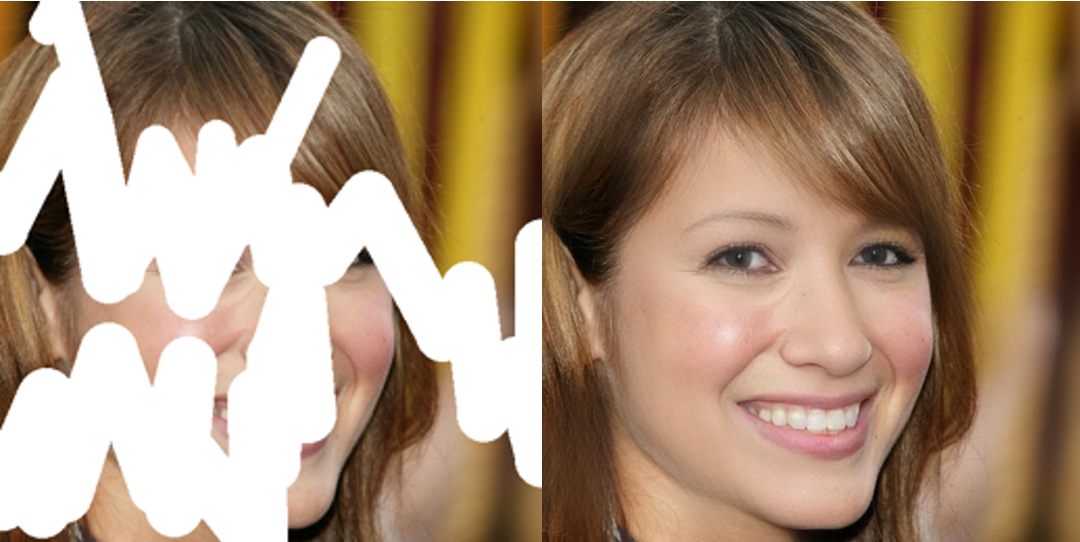

? Face à la déainure (visage recadré et aligné)

# For cropped and aligned faces (512x512)

# Inputs could be masked by white brush using an image editing app (e.g., Photoshop)

# (check out the examples in inputs/masked_faces)

python inference_inpainting.py --input_path [image folder]|[image path]

Les commandes de formation peuvent être trouvées dans les documents: anglais |简体中文.

Si notre travail est utile pour vos recherches, veuillez envisager de citer:

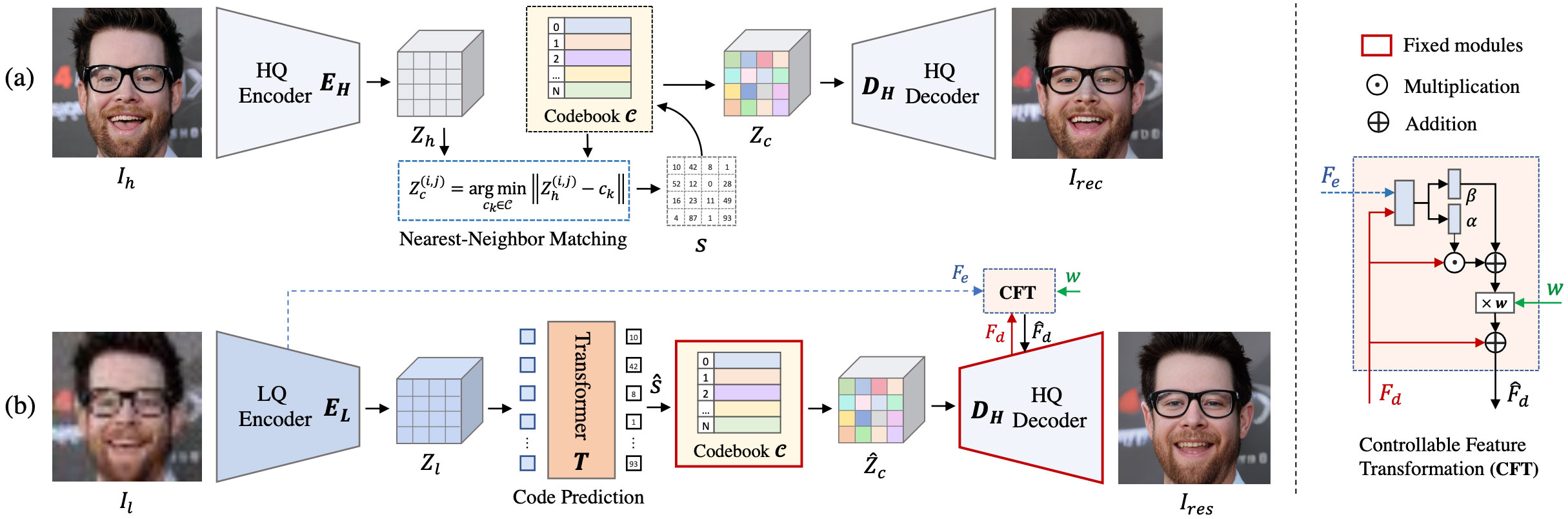

@inproceedings{zhou2022codeformer,

author = {Zhou, Shangchen and Chan, Kelvin C.K. and Li, Chongyi and Loy, Chen Change},

title = {Towards Robust Blind Face Restoration with Codebook Lookup TransFormer},

booktitle = {NeurIPS},

year = {2022}

}

Ce projet est concédé sous licence NTU S-Lab Licence 1.0. La redistribution et l'utilisation doivent suivre cette licence.

Ce projet est basé sur BasicsR. Certains codes sont apportés à des transformateurs de déchaînement, de yolov5-face et de facexlib. Nous adoptons également la réalité pour soutenir l'amélioration de l'image de fond. Merci pour leurs œuvres impressionnantes.

Si vous avez des questions, n'hésitez pas à me contacter à [email protected] .