Papier | Projektseite | Video

Shangchen Zhou, Kelvin CK Chan, Chongyi Li, Chen Change Loy

S-Lab, Nanyang Technological University

Wenn Codeformer für Ihre Bilder oder Projekte hilfreich ist, helfen Sie bitte dieses Repo. Danke! ?

dlib als neue Option für Gesichtsdetektor einbeziehen, erzeugt sie eine genauere Gesichtsidentität.--input_path [YOUR_VIDEO.mp4] . Versuchen Sie es, um Ihre Videos zu verbessern! ?

requirements.txt # git clone this repository

git clone https://github.com/sczhou/CodeFormer

cd CodeFormer

# create new anaconda env

conda create -n codeformer python=3.8 -y

conda activate codeformer

# install python dependencies

pip3 install -r requirements.txt

python basicsr/setup.py develop

conda install -c conda-forge dlib (only for face detection or cropping with dlib)

Laden Sie die vorgefertigten Modelle von Facelib und DLIB aus [Releases | Google Drive | OneDrive] in den Ordner weights/facelib . Sie können die vorgezogenen Modelle manuell herunterladen oder den folgenden Befehl herunterladen:

python scripts/download_pretrained_models.py facelib

python scripts/download_pretrained_models.py dlib (only for dlib face detector)

Laden Sie die CODEFORMER -Modelle von [Releases | herunter Google Drive | OneDrive] zum Ordner weights/CodeFormer . Sie können die vorgezogenen Modelle manuell herunterladen oder den folgenden Befehl herunterladen:

python scripts/download_pretrained_models.py CodeFormer

Sie können die Testbilder in den Ordner inputs/TestWhole einfügen. Wenn Sie auf beschnittenen und ausgerichteten Gesichtern testen möchten, können Sie sie in den Ordner inputs/cropped_faces einfügen. Sie können die beschnittenen und ausgerichteten Gesichter erhalten, indem Sie den folgenden Befehl ausführen:

# you may need to install dlib via: conda install -c conda-forge dlib

python scripts/crop_align_face.py -i [input folder] -o [output folder]

[Anmerkung] Wenn Sie den Codeformer in Ihrem Papier vergleichen möchten, führen Sie den folgenden Befehl an, der angegeben ist --has_aligned (für beschnittene und ausgerichtete Gesicht), da der Befehl für das gesamte Bild einen Prozess der Fusion mit der Face-Background-Fusion beinhaltet, die die Haarstruktur an der Grenze schädigen kann, was zu unlauter Vergleich führt.

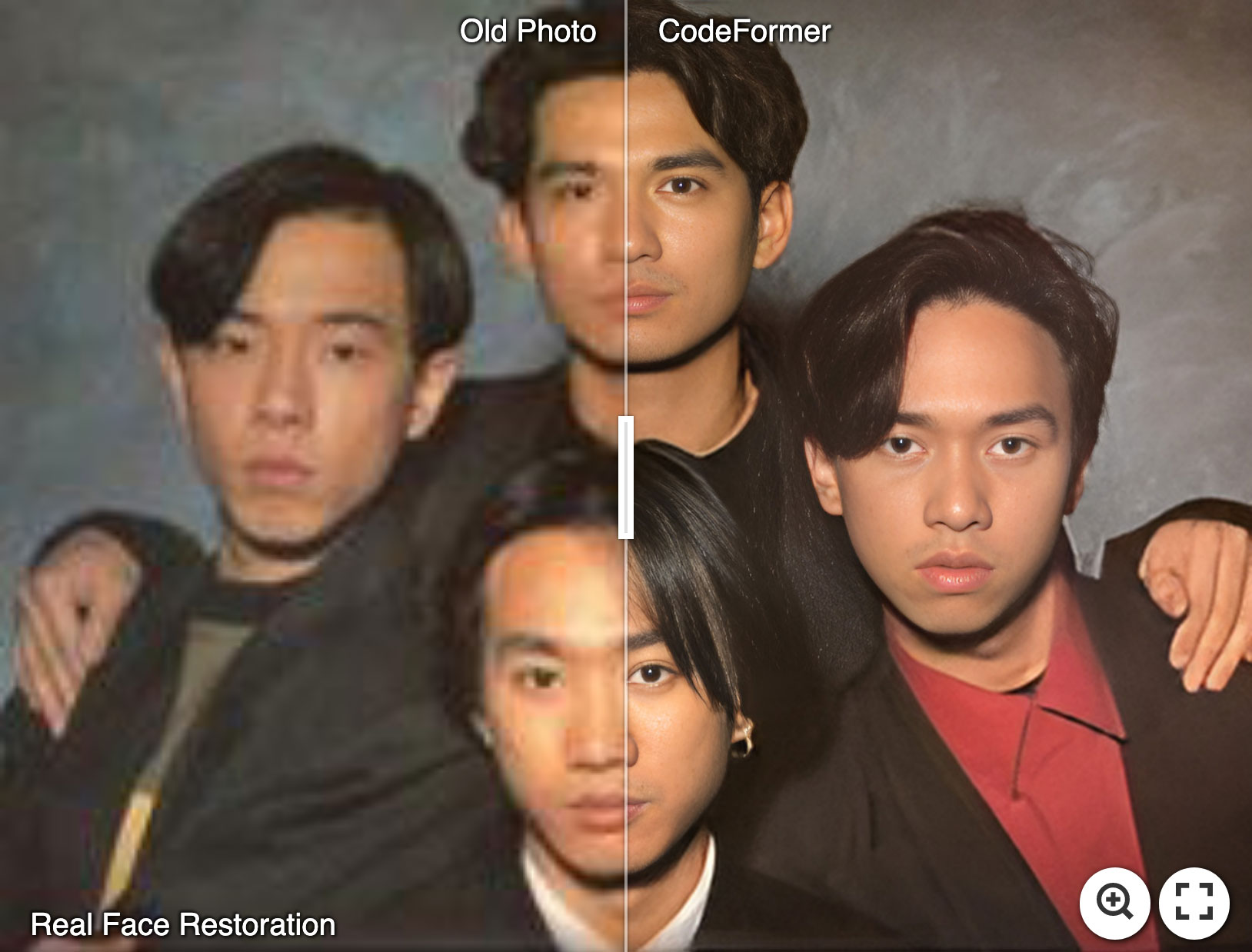

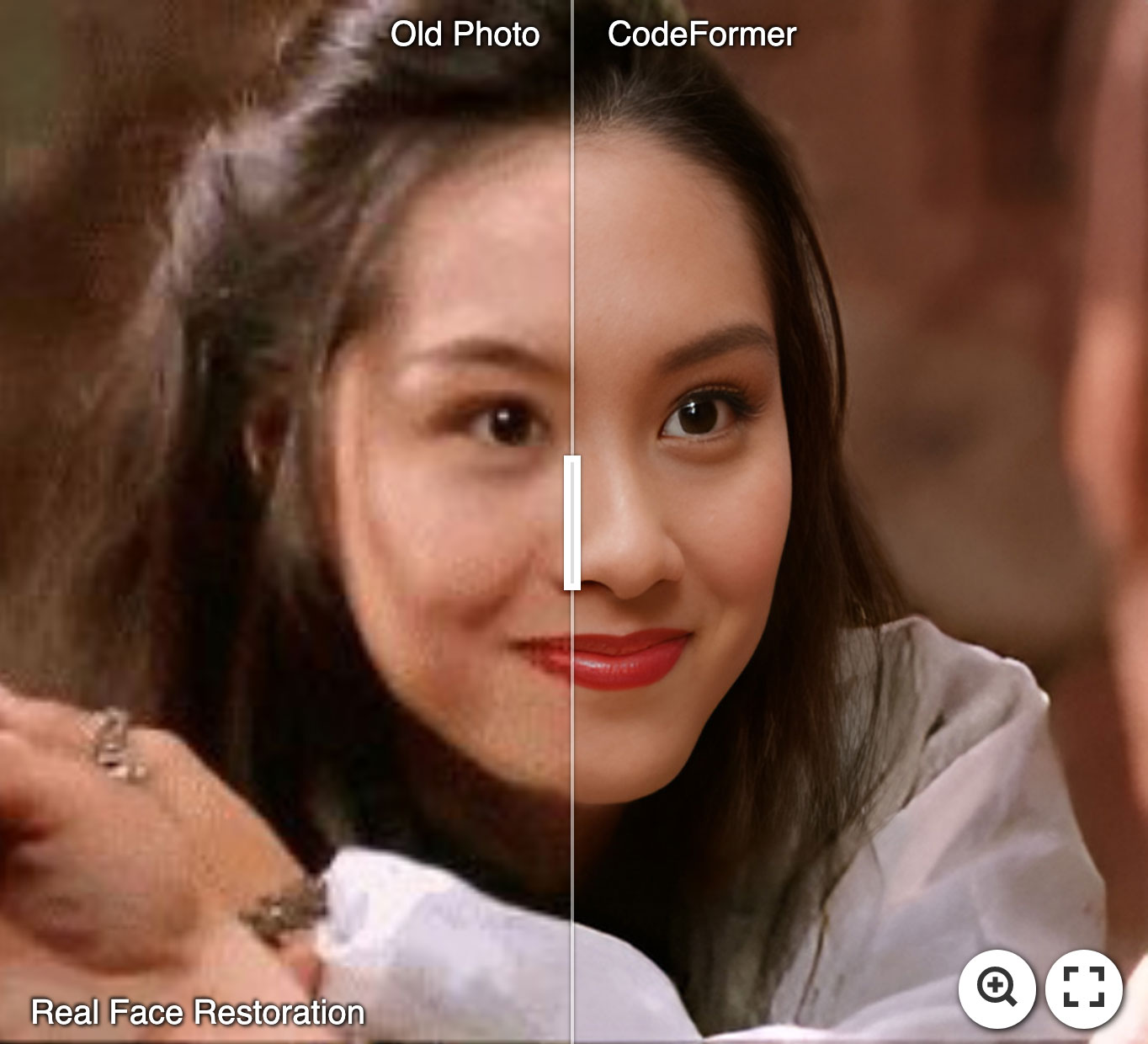

Treuegewicht w liegt in [0, 1]. Im Allgemeinen neigt kleineres W tendenziell ein Ergebnis mit höherer Qualität, während größere W ein höheres Ergebnis erzielt. Die Ergebnisse werden im Ergebnisordner des results gespeichert.

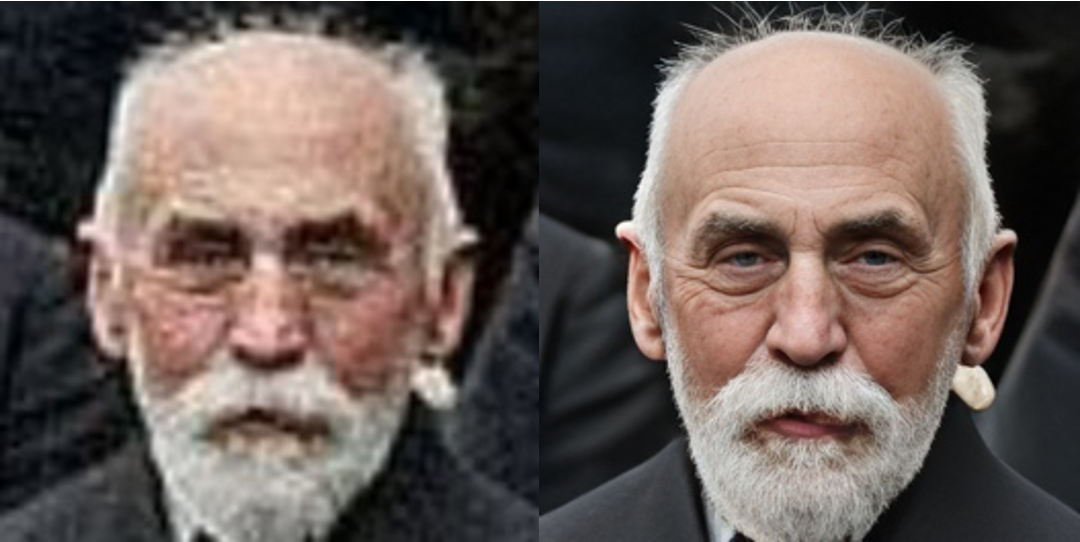

? Gesichtsrestauration (beschnittenes und ausgerichtetes Gesicht)

# For cropped and aligned faces (512x512)

python inference_codeformer.py -w 0.5 --has_aligned --input_path [image folder]|[image path]

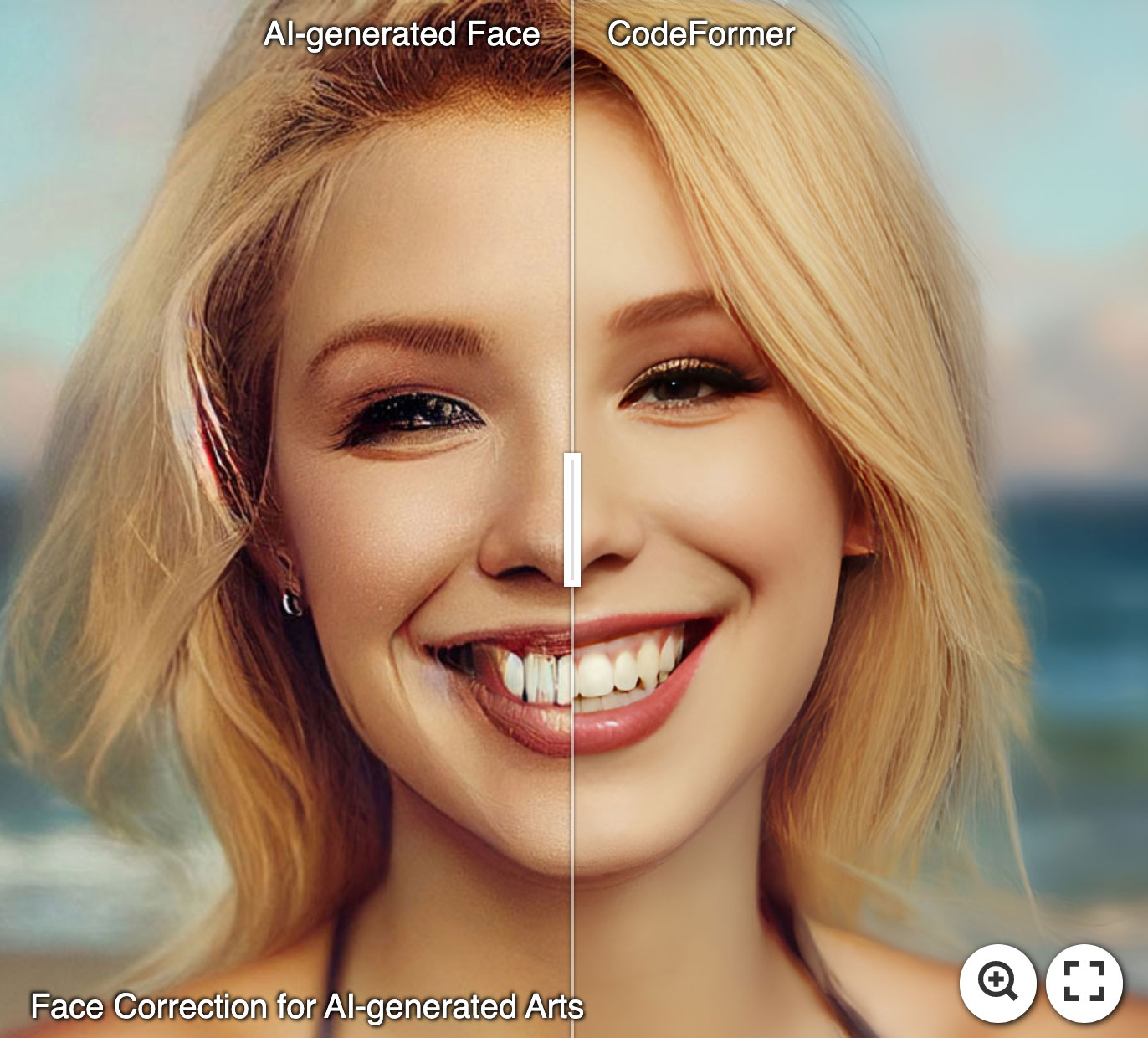

? ️ Ganze Bildverbesserung

# For whole image

# Add '--bg_upsampler realesrgan' to enhance the background regions with Real-ESRGAN

# Add '--face_upsample' to further upsample restorated face with Real-ESRGAN

python inference_codeformer.py -w 0.7 --input_path [image folder]|[image path]

? Videoverbesserung

# For Windows/Mac users, please install ffmpeg first

conda install -c conda-forge ffmpeg

# For video clips

# Video path should end with '.mp4'|'.mov'|'.avi'

python inference_codeformer.py --bg_upsampler realesrgan --face_upsample -w 1.0 --input_path [video path]

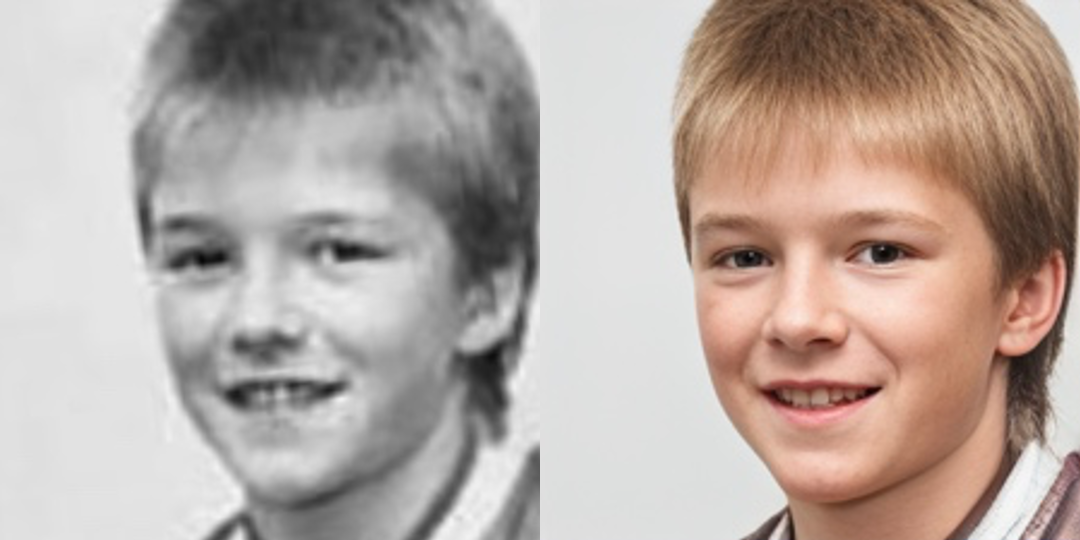

? Gesichtsfarbe (beschnittenes und ausgerichtetes Gesicht)

# For cropped and aligned faces (512x512)

# Colorize black and white or faded photo

python inference_colorization.py --input_path [image folder]|[image path]

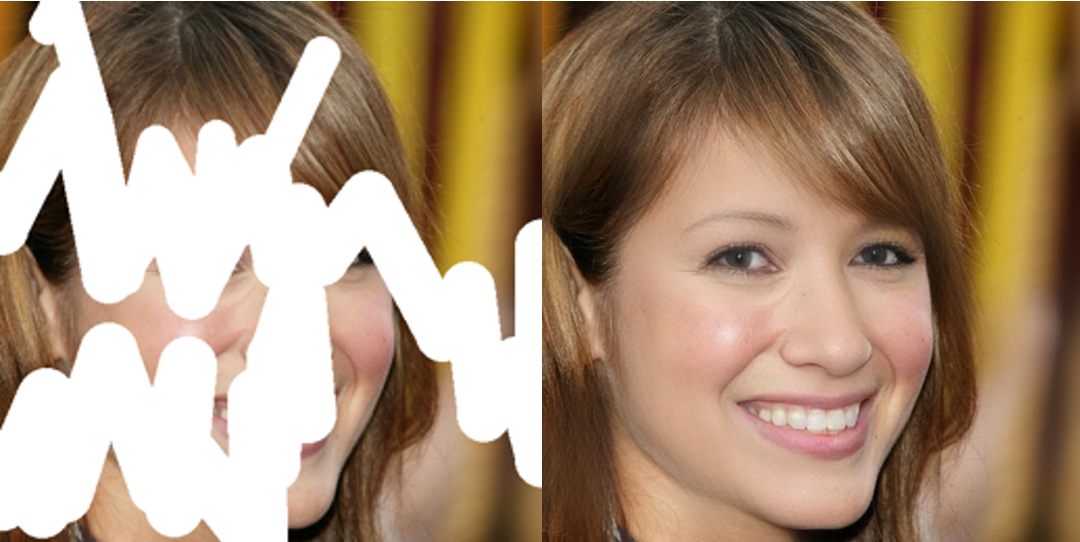

? Gesicht inpackend (beschnittenes und ausgerichtetes Gesicht)

# For cropped and aligned faces (512x512)

# Inputs could be masked by white brush using an image editing app (e.g., Photoshop)

# (check out the examples in inputs/masked_faces)

python inference_inpainting.py --input_path [image folder]|[image path]

Die Trainingsbefehle finden Sie in den Dokumenten: Englisch |简体中文.

Wenn unsere Arbeit für Ihre Forschung nützlich ist, sollten Sie sich bitte angeben:

@inproceedings{zhou2022codeformer,

author = {Zhou, Shangchen and Chan, Kelvin C.K. and Li, Chongyi and Loy, Chen Change},

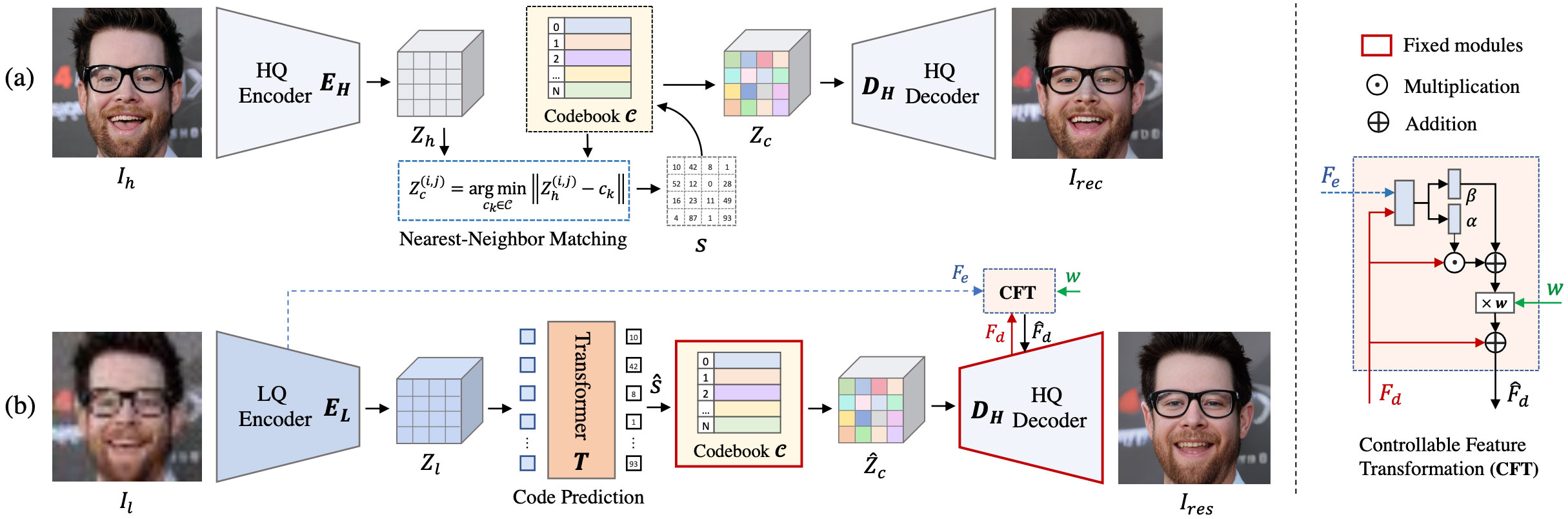

title = {Towards Robust Blind Face Restoration with Codebook Lookup TransFormer},

booktitle = {NeurIPS},

year = {2022}

}

Dieses Projekt ist unter der NTU S-LAB-Lizenz 1.0 lizenziert. Umverteilung und Verwendung sollten dieser Lizenz folgen.

Dieses Projekt basiert auf Grundlagen. Einige Codes werden aus der Entfesselung von Translasting-Translastrilen, Yolov5-Face und Facxlib gebracht. Wir übernehmen auch Real-ESRgan, um die Verbesserung des Hintergrundbildes zu unterstützen. Danke für ihre großartigen Werke.

Wenn Sie Fragen haben, können Sie mich bitte unter [email protected] erreichen.