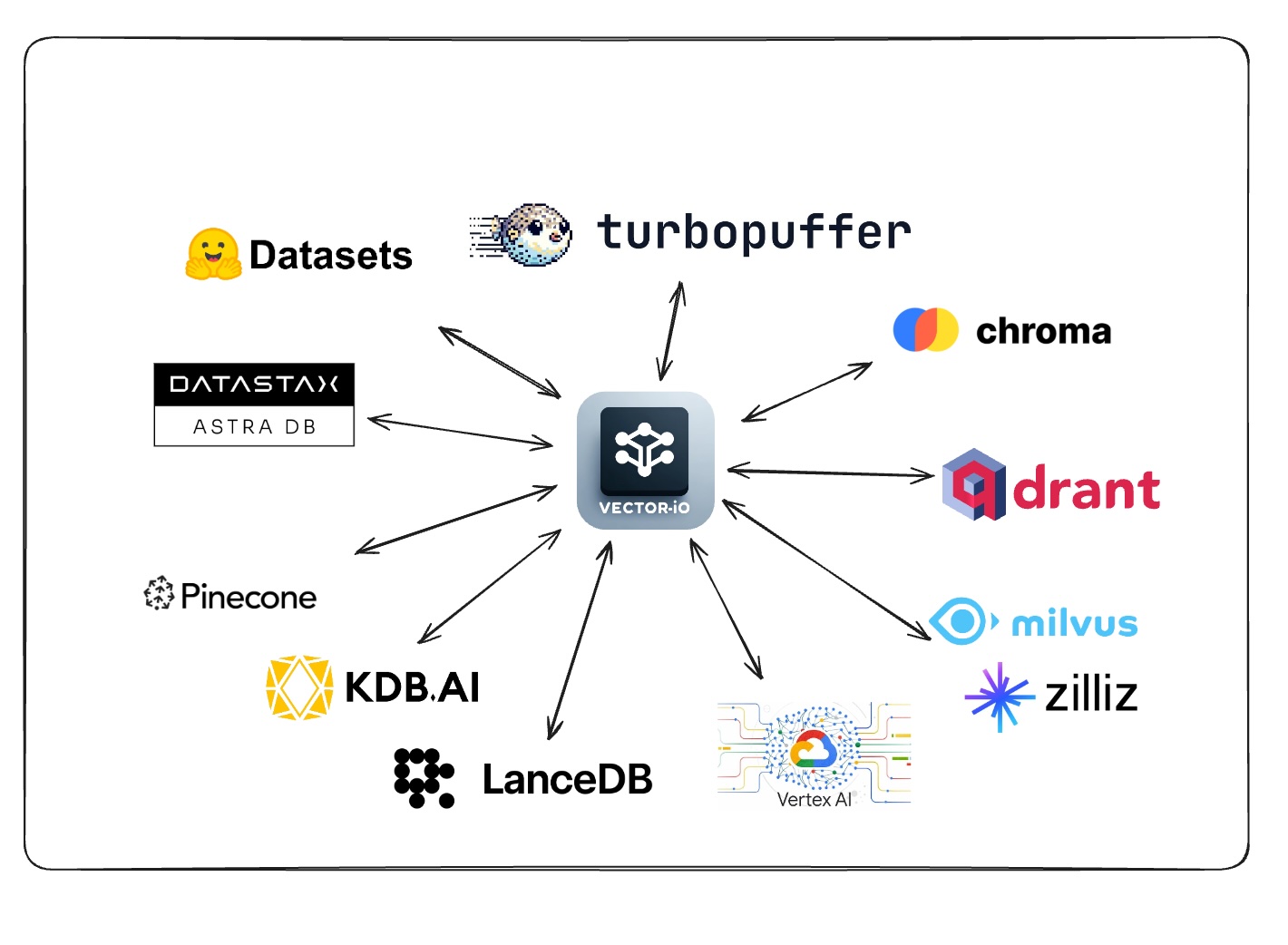

Cette bibliothèque utilise un format universel pour les ensembles de données vectoriels pour exporter et importer facilement les données de toutes les bases de données vectorielles.

Demandez le support pour un vectordb en votant / commentant ce sondage

Voir la section contributive pour ajouter la prise en charge de votre base de données vectorielle préférée.

| Base de données vectorielle | Importer | Exporter |

|---|---|---|

| Pignon | ✅ | ✅ |

| Qdrant | ✅ | ✅ |

| Milvus | ✅ | ✅ |

| Recherche de vecteur GCP Vertex AI | ✅ | ✅ |

| Kdb.ai | ✅ | ✅ |

| LancedB | ✅ | ✅ |

| DataSax Astra DB | ✅ | ✅ |

| Chrome | ✅ | ✅ |

| Turbopuffer | ✅ | ✅ |

| Base de données vectorielle | Importer | Exporter |

|---|

| Base de données vectorielle | Importer | Exporter |

|---|---|---|

| Recherche Azure AI | ||

| Tisser | ||

| MongoDB Atlas | ||

| Opeensearch | ||

| Apache Cassandra | ||

| txtai | ||

| pgvecteur | ||

| Sqlite-vss |

| Base de données vectorielle | Importer | Exporter |

|---|---|---|

| Vespa | ||

| Marqo | ||

| Elasticsearch | ||

| Recherche Redis | ||

| Maison de clic | ||

| Usearch | ||

| Rocaille | ||

| Epsilla | ||

| ActiveLoop Deep Lake | ||

| Ouverturedb | ||

| Ciel | ||

| Meilisearch | ||

| Myscale | ||

| Néo4j | ||

| Nuclia DB | ||

| OramaSearch | ||

| Coqueluche | ||

| Anari ai | ||

| Vallon | ||

| Apache Solr |

pip install vdf-iogit clone https://github.com/AI-Northstar-Tech/vector-io.git

cd vector-io

pip install -r requirements.txt class NamespaceMeta ( BaseModel ):

namespace : str

index_name : str

total_vector_count : int

exported_vector_count : int

dimensions : int

model_name : str | None = None

vector_columns : List [ str ] = [ "vector" ]

data_path : str

metric : str | None = None

index_config : Optional [ Dict [ Any , Any ]] = None

schema_dict : Optional [ Dict [ str , Any ]] = None

class VDFMeta ( BaseModel ):

version : str

file_structure : List [ str ]

author : str

exported_from : str

indexes : Dict [ str , List [ NamespaceMeta ]]

exported_at : str

id_column : Optional [ str ] = Noneexport_vdf --help

usage: export_vdf [-h] [-m MODEL_NAME]

[--max_file_size MAX_FILE_SIZE]

[--push_to_hub | --no-push_to_hub]

[--public | --no-public]

{pinecone,qdrant,kdbai,milvus,vertexai_vectorsearch}

...

Export data from various vector databases to the VDF format for vector datasets

options:

-h, --help show this help message and exit

-m MODEL_NAME, --model_name MODEL_NAME

Name of model used

--max_file_size MAX_FILE_SIZE

Maximum file size in MB (default:

1024)

--push_to_hub, --no-push_to_hub

Push to hub

--public, --no-public

Make dataset public (default:

False)

Vector Databases:

Choose the vectors database to export data from

{pinecone,qdrant,kdbai,milvus,vertexai_vectorsearch}

pinecone Export data from Pinecone

qdrant Export data from Qdrant

kdbai Export data from KDB.AI

milvus Export data from Milvus

vertexai_vectorsearch

Export data from Vertex AI Vector

Searchimport_vdf --help

usage: import_vdf [-h] [-d DIR] [-s | --subset | --no-subset]

[--create_new | --no-create_new]

{milvus,pinecone,qdrant,vertexai_vectorsearch,kdbai}

...

Import data from VDF to a vector database

options:

-h, --help show this help message and exit

-d DIR, --dir DIR Directory to import

-s, --subset, --no-subset

Import a subset of data (default: False)

--create_new, --no-create_new

Create a new index (default: False)

Vector Databases:

Choose the vectors database to export data from

{milvus,pinecone,qdrant,vertexai_vectorsearch,kdbai}

milvus Import data to Milvus

pinecone Import data to Pinecone

qdrant Import data to Qdrant

vertexai_vectorsearch

Import data to Vertex AI Vector Search

kdbai Import data to KDB.AICe script Python est utilisé pour réintégrer un ensemble de données vectoriel. Il prend un répertoire de l'ensemble de données vectoriel au format VDF et le réemboute à l'aide d'un nouveau modèle. Le script vous permet également de spécifier le nom de la colonne contenant du texte à intégrer.

reembed_vdf --help

usage: reembed_vdf [-h] -d DIR [-m NEW_MODEL_NAME]

[-t TEXT_COLUMN]

Reembed a vector dataset

options:

-h, --help show this help message and exit

-d DIR, --dir DIR Directory of vector dataset in

the VDF format

-m NEW_MODEL_NAME, --new_model_name NEW_MODEL_NAME

Name of new model to be used

-t TEXT_COLUMN, --text_column TEXT_COLUMN

Name of the column containing

text to be embeddedexport_vdf -m hkunlp/instructor-xl --push_to_hub pinecone --environment gcp-starter

import_vdf -d /path/to/vdf/dataset milvus

reembed_vdf -d /path/to/vdf/dataset -m sentence-transformers/all-MiniLM-L6-v2 -t titleSuivez l'invite pour sélectionner la plage d'index et d'ID à exporter.

Si vous souhaitez ajouter une implémentation d'importation / exportation pour une nouvelle base de données vectorielle, vous devez également implémenter l'autre côté de l'importation / exportation pour la même base de données. Veuillez débarquer le dépôt et envoyer un PR pour les scripts d'importation et d'exportation.

Étapes pour ajouter une nouvelle base de données vectorielle (ABC):

src/vdf_io/export_vdf/export_abc.py et src/vdf_io/import_vdf/import_abc.py pour la nouvelle db.Exporter :

Importer :

Si vous souhaitez modifier la spécification VDF, veuillez ouvrir un problème pour discuter de la modification avant d'envoyer un PR.

Si vous souhaitez améliorer l'efficacité des scripts d'importation / exportation, veuillez débarquer le dépôt et envoyer un RP.

L'exécution des scripts dans le dépôt enverra des données d'utilisation anonymes à AI Northstar Tech pour aider à améliorer la bibliothèque.

Vous pouvez le désactiver en définissant la variable d'environnement DISABLE_TELEMETRY_VECTORIO sur 1 .

Si vous avez des questions, veuillez ouvrir un problème sur le dépôt ou le message Dhruv Anand sur LinkedIn

Dhruv Anand ? | Jayesh Rathi | Jordan Totten |