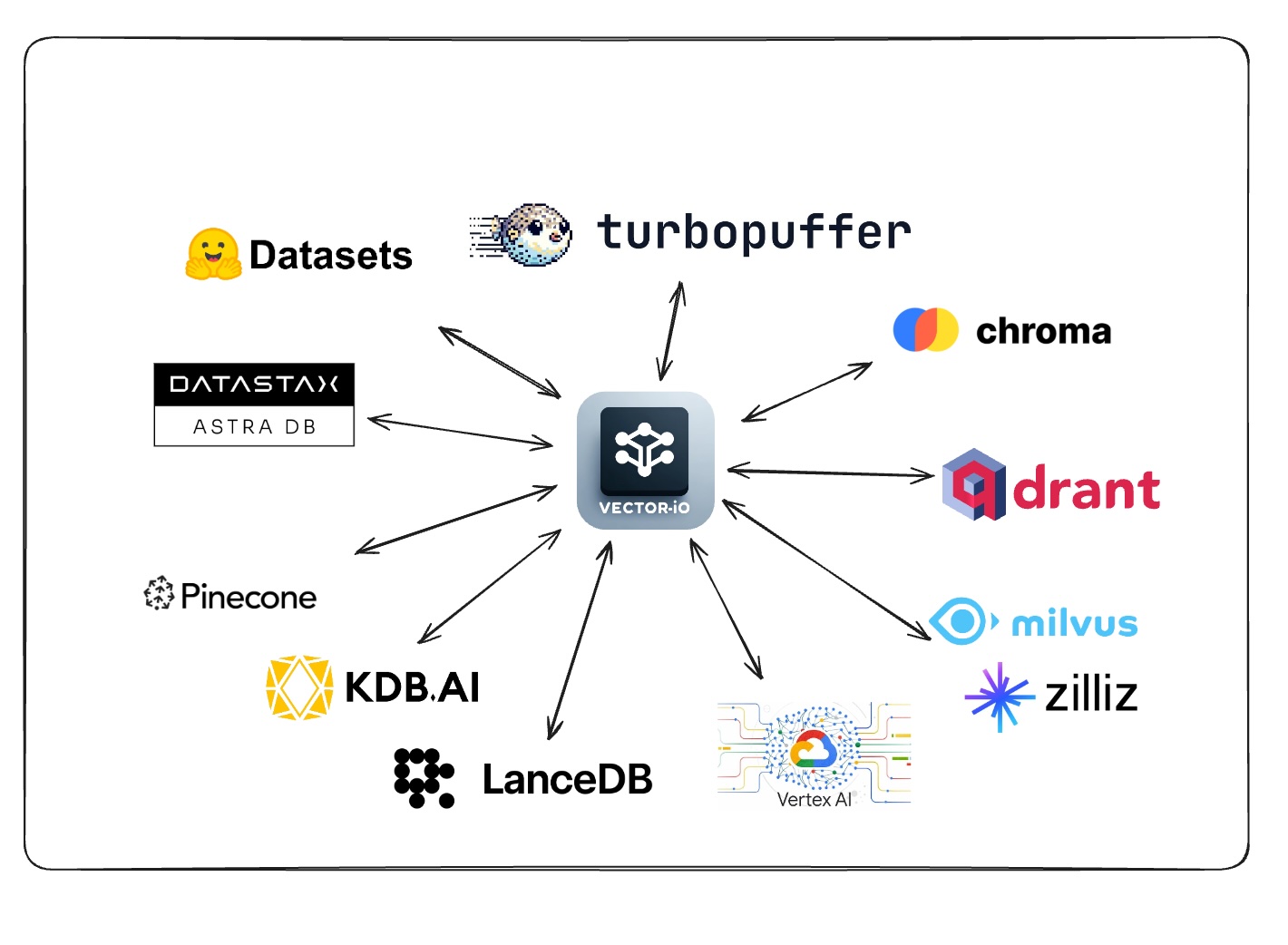

Esta biblioteca utiliza un formato universal para conjuntos de datos vectoriales para exportar e importar datos fácilmente de todas las bases de datos vectoriales.

Solicitar apoyo para un vectordb votando/comentando esta encuesta

Consulte la sección contribuyente para agregar soporte para su base de datos vectorial favorita.

| Base de datos vectorial | Importar | Exportar |

|---|---|---|

| Piña | ✅ | ✅ |

| Qdrant | ✅ | ✅ |

| Milvus | ✅ | ✅ |

| GCP Vertex AI Vector Búsqueda | ✅ | ✅ |

| KDB.AI | ✅ | ✅ |

| LancedB | ✅ | ✅ |

| Datatax Astra DB | ✅ | ✅ |

| Croma | ✅ | ✅ |

| Turboquista | ✅ | ✅ |

| Base de datos vectorial | Importar | Exportar |

|---|

| Base de datos vectorial | Importar | Exportar |

|---|---|---|

| Azure AI Search | ||

| Tejido | ||

| MongoDB Atlas | ||

| OpenSearch | ||

| Apache Cassandra | ||

| Txtai | ||

| pgvector | ||

| Sqlite-vss |

| Base de datos vectorial | Importar | Exportar |

|---|---|---|

| Vespa | ||

| Marqo | ||

| Elasticsearch | ||

| Redis Search | ||

| Clickhouse | ||

| USARECHE | ||

| Juego de rocas | ||

| Epsilla | ||

| Activeloop Deep Lake | ||

| Aperturedb | ||

| Cacatado | ||

| Meilisearch | ||

| MyScale | ||

| Neo4J | ||

| Nuclia DB | ||

| Oramasearch | ||

| Tipos | ||

| Anari ai | ||

| Vierdir | ||

| Apache solr |

pip install vdf-iogit clone https://github.com/AI-Northstar-Tech/vector-io.git

cd vector-io

pip install -r requirements.txt class NamespaceMeta ( BaseModel ):

namespace : str

index_name : str

total_vector_count : int

exported_vector_count : int

dimensions : int

model_name : str | None = None

vector_columns : List [ str ] = [ "vector" ]

data_path : str

metric : str | None = None

index_config : Optional [ Dict [ Any , Any ]] = None

schema_dict : Optional [ Dict [ str , Any ]] = None

class VDFMeta ( BaseModel ):

version : str

file_structure : List [ str ]

author : str

exported_from : str

indexes : Dict [ str , List [ NamespaceMeta ]]

exported_at : str

id_column : Optional [ str ] = Noneexport_vdf --help

usage: export_vdf [-h] [-m MODEL_NAME]

[--max_file_size MAX_FILE_SIZE]

[--push_to_hub | --no-push_to_hub]

[--public | --no-public]

{pinecone,qdrant,kdbai,milvus,vertexai_vectorsearch}

...

Export data from various vector databases to the VDF format for vector datasets

options:

-h, --help show this help message and exit

-m MODEL_NAME, --model_name MODEL_NAME

Name of model used

--max_file_size MAX_FILE_SIZE

Maximum file size in MB (default:

1024)

--push_to_hub, --no-push_to_hub

Push to hub

--public, --no-public

Make dataset public (default:

False)

Vector Databases:

Choose the vectors database to export data from

{pinecone,qdrant,kdbai,milvus,vertexai_vectorsearch}

pinecone Export data from Pinecone

qdrant Export data from Qdrant

kdbai Export data from KDB.AI

milvus Export data from Milvus

vertexai_vectorsearch

Export data from Vertex AI Vector

Searchimport_vdf --help

usage: import_vdf [-h] [-d DIR] [-s | --subset | --no-subset]

[--create_new | --no-create_new]

{milvus,pinecone,qdrant,vertexai_vectorsearch,kdbai}

...

Import data from VDF to a vector database

options:

-h, --help show this help message and exit

-d DIR, --dir DIR Directory to import

-s, --subset, --no-subset

Import a subset of data (default: False)

--create_new, --no-create_new

Create a new index (default: False)

Vector Databases:

Choose the vectors database to export data from

{milvus,pinecone,qdrant,vertexai_vectorsearch,kdbai}

milvus Import data to Milvus

pinecone Import data to Pinecone

qdrant Import data to Qdrant

vertexai_vectorsearch

Import data to Vertex AI Vector Search

kdbai Import data to KDB.AIEste script de Python se usa para volver a arrebrar un conjunto de datos vectorial. Se necesita un directorio del conjunto de datos de vectores en el formato VDF y lo reembolsa utilizando un nuevo modelo. El script también le permite especificar el nombre de la columna que contiene texto a incrustarse.

reembed_vdf --help

usage: reembed_vdf [-h] -d DIR [-m NEW_MODEL_NAME]

[-t TEXT_COLUMN]

Reembed a vector dataset

options:

-h, --help show this help message and exit

-d DIR, --dir DIR Directory of vector dataset in

the VDF format

-m NEW_MODEL_NAME, --new_model_name NEW_MODEL_NAME

Name of new model to be used

-t TEXT_COLUMN, --text_column TEXT_COLUMN

Name of the column containing

text to be embeddedexport_vdf -m hkunlp/instructor-xl --push_to_hub pinecone --environment gcp-starter

import_vdf -d /path/to/vdf/dataset milvus

reembed_vdf -d /path/to/vdf/dataset -m sentence-transformers/all-MiniLM-L6-v2 -t titleSiga el indicador para seleccionar el índice y el rango de identificación para exportar.

Si desea agregar una implementación de importación/exportación para una nueva base de datos Vector, también debe implementar el otro lado de la importación/exportación para la misma base de datos. Bifurca el repositorio y envíe un PR para los scripts de importación y exportación.

Pasos para agregar una nueva base de datos Vector (ABC):

src/vdf_io/export_vdf/export_abc.py y src/vdf_io/import_vdf/import_abc.py para el nuevo DB.Exportar :

Importar :

Si desea cambiar la especificación VDF, abra un problema para discutir el cambio antes de enviar un PR.

Si desea mejorar la eficiencia de los scripts de importación/exportación, bifurca el repositorio y envía un PR.

Ejecutar los scripts en el repositorio enviará datos de uso anónimo a AI Northstar Tech para ayudar a mejorar la biblioteca.

Puede optar por salir estableciendo la variable de entorno DISABLE_TELEMETRY_VECTORIO a 1 .

Si tiene alguna pregunta, abra un problema en el repositorio o el mensaje dhruv anand en LinkedIn

Dhruv anand ? | Jayesh Rathi | Jordan Totten |