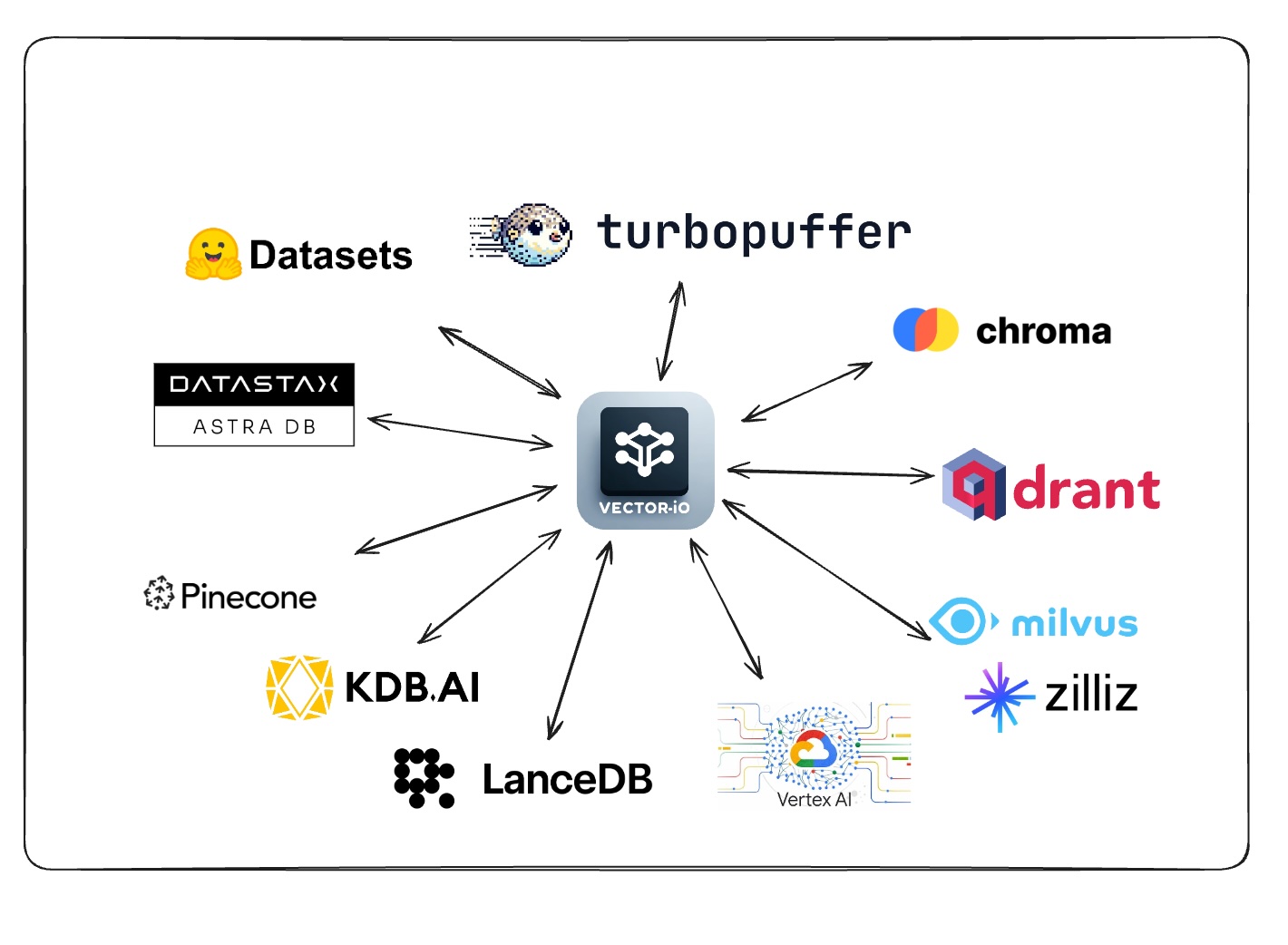

Diese Bibliothek verwendet ein universelles Format für Vektor -Datensätze, um Daten einfach aus allen Vektor -Datenbanken zu exportieren und zu importieren.

Fordern Sie Unterstützung für ein VectordB an, indem Sie diese Umfrage stimmen/kommentieren

Sehen Sie sich den Abschnitt an, um Ihre bevorzugte Vektordatenbank zu unterstützen.

| Vektordatenbank | Import | Export |

|---|---|---|

| Tannenzapfen | ✅ | ✅ |

| Qdrant | ✅ | ✅ |

| Milvus | ✅ | ✅ |

| GCP -Vertex -AI -Vektor -Suche | ✅ | ✅ |

| Kdb.ai | ✅ | ✅ |

| Lanciert | ✅ | ✅ |

| DataStax Astra db | ✅ | ✅ |

| Chroma | ✅ | ✅ |

| Turbopuffer | ✅ | ✅ |

| Vektordatenbank | Import | Export |

|---|

| Vektordatenbank | Import | Export |

|---|---|---|

| Azure AI -Suche | ||

| Waviate | ||

| MongoDb Atlas | ||

| OpenSearch | ||

| Apache Cassandra | ||

| txtai | ||

| pgVector | ||

| SQLite-VSS |

| Vektordatenbank | Import | Export |

|---|---|---|

| Vespa | ||

| Marqo | ||

| Elasticsarch | ||

| Redis -Suche | ||

| Klicken Sie auf | ||

| Usearch | ||

| Rockset | ||

| Epsilla | ||

| Activeloop Deep Lake | ||

| Apertiert | ||

| KREATTB | ||

| Meilisearch | ||

| Myscale | ||

| Neo4j | ||

| Nuclia DB | ||

| Oramasearch | ||

| Artensex | ||

| Anari ai | ||

| Vend | ||

| Apache Solr |

pip install vdf-iogit clone https://github.com/AI-Northstar-Tech/vector-io.git

cd vector-io

pip install -r requirements.txt class NamespaceMeta ( BaseModel ):

namespace : str

index_name : str

total_vector_count : int

exported_vector_count : int

dimensions : int

model_name : str | None = None

vector_columns : List [ str ] = [ "vector" ]

data_path : str

metric : str | None = None

index_config : Optional [ Dict [ Any , Any ]] = None

schema_dict : Optional [ Dict [ str , Any ]] = None

class VDFMeta ( BaseModel ):

version : str

file_structure : List [ str ]

author : str

exported_from : str

indexes : Dict [ str , List [ NamespaceMeta ]]

exported_at : str

id_column : Optional [ str ] = Noneexport_vdf --help

usage: export_vdf [-h] [-m MODEL_NAME]

[--max_file_size MAX_FILE_SIZE]

[--push_to_hub | --no-push_to_hub]

[--public | --no-public]

{pinecone,qdrant,kdbai,milvus,vertexai_vectorsearch}

...

Export data from various vector databases to the VDF format for vector datasets

options:

-h, --help show this help message and exit

-m MODEL_NAME, --model_name MODEL_NAME

Name of model used

--max_file_size MAX_FILE_SIZE

Maximum file size in MB (default:

1024)

--push_to_hub, --no-push_to_hub

Push to hub

--public, --no-public

Make dataset public (default:

False)

Vector Databases:

Choose the vectors database to export data from

{pinecone,qdrant,kdbai,milvus,vertexai_vectorsearch}

pinecone Export data from Pinecone

qdrant Export data from Qdrant

kdbai Export data from KDB.AI

milvus Export data from Milvus

vertexai_vectorsearch

Export data from Vertex AI Vector

Searchimport_vdf --help

usage: import_vdf [-h] [-d DIR] [-s | --subset | --no-subset]

[--create_new | --no-create_new]

{milvus,pinecone,qdrant,vertexai_vectorsearch,kdbai}

...

Import data from VDF to a vector database

options:

-h, --help show this help message and exit

-d DIR, --dir DIR Directory to import

-s, --subset, --no-subset

Import a subset of data (default: False)

--create_new, --no-create_new

Create a new index (default: False)

Vector Databases:

Choose the vectors database to export data from

{milvus,pinecone,qdrant,vertexai_vectorsearch,kdbai}

milvus Import data to Milvus

pinecone Import data to Pinecone

qdrant Import data to Qdrant

vertexai_vectorsearch

Import data to Vertex AI Vector Search

kdbai Import data to KDB.AIDieses Python-Skript wird verwendet, um einen Vektor-Datensatz wieder aufzunehmen. Es wird im VDF-Format ein Verzeichnis des Vektor-Datensatzes verwendet und es mit einem neuen Modell wieder aufgenommen. Mit dem Skript können Sie außerdem den Namen der Spalte angeben, die einen eingebetteten Text enthält.

reembed_vdf --help

usage: reembed_vdf [-h] -d DIR [-m NEW_MODEL_NAME]

[-t TEXT_COLUMN]

Reembed a vector dataset

options:

-h, --help show this help message and exit

-d DIR, --dir DIR Directory of vector dataset in

the VDF format

-m NEW_MODEL_NAME, --new_model_name NEW_MODEL_NAME

Name of new model to be used

-t TEXT_COLUMN, --text_column TEXT_COLUMN

Name of the column containing

text to be embeddedexport_vdf -m hkunlp/instructor-xl --push_to_hub pinecone --environment gcp-starter

import_vdf -d /path/to/vdf/dataset milvus

reembed_vdf -d /path/to/vdf/dataset -m sentence-transformers/all-MiniLM-L6-v2 -t titleBefolgen Sie die Eingabeaufforderung, um den Index- und ID -Bereich auszuwählen, um den Exportieren zu erhalten.

Wenn Sie eine Import-/Exportimplementierung für eine neue Vektor -Datenbank hinzufügen möchten, müssen Sie auch die andere Seite des Imports/Exports für dieselbe Datenbank implementieren. Bitte geben Sie das Repo auf und senden Sie eine PR sowohl für die Import- als auch für die Exportskripte.

Schritte zum Hinzufügen einer neuen Vektordatenbank (ABC):

src/vdf_io/export_vdf/export_abc.py und src/vdf_io/import_vdf/import_abc.py für die neue dB.Export :

Import :

Wenn Sie die VDF -Spezifikation ändern möchten, öffnen Sie bitte ein Problem, um die Änderung zu besprechen, bevor Sie eine PR senden.

Wenn Sie die Effizienz der Import-/Exportskripte verbessern möchten, geben Sie bitte das Repo und senden Sie eine PR.

Durch das Ausführen der Skripte im Repo wird anonyme Nutzungsdaten an AI Northstar Tech gesendet, um die Bibliothek zu verbessern.

Sie können dies abmelden, indem Sie die Umgebungsvariable DISABLE_TELEMETRY_VECTORIO auf 1 festlegen.

Wenn Sie Fragen haben, öffnen Sie bitte ein Problem auf dem Repo oder der Nachricht Dhruv Anand unter LinkedIn

Dhruv Anand ? | Jayesh Rathi | Jordan Totten |