Une application mobile pour traduire les hiéroglyphes (2018)

?? Une application mobile qui détecte, classe et translitente les hiéroglyphes.

Une grande partie du mode de vie des anciens Égyptiens avait été perdu car personne n'a pu déchiffrer le sens de la plupart de leurs symboles, Sir Alan Gardiner a classé chaque hiéroglyphe avec un code qui peut ensuite être utilisé pour le rechercher pour en savoir plus sur sa signification. Ce dictionnaire hiéroglyphique a fini par être des milliers de pages et de regarder quoi que ce soit est devenu une tâche fastidieuse. Même avec l'émergence d'Internet, il restait toujours le problème de ne pas connaître le code Gardiner d'un hiéroglyphe pour le rechercher.

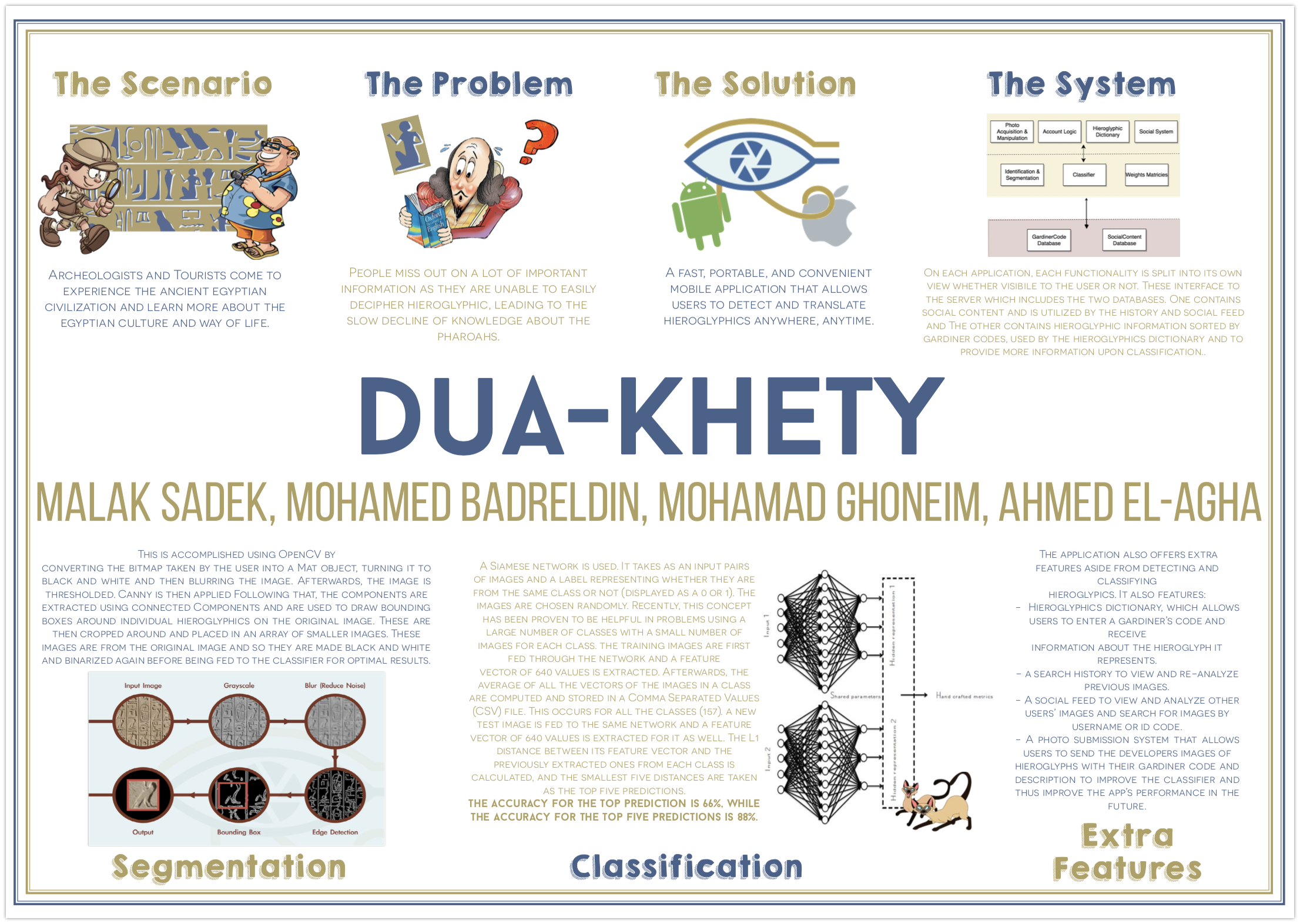

Pour aider à résoudre ce problème, Dua-Khety a été créé en tant qu'application mobile, disponible sur les appareils Android (implémentés en Java ) et iOS (implémenté dans Swift & Objective C ), dans le but de détecter et de classer les hiéroglyphes à partir d'une image prise et de fournir à l'utilisateur leurs codes Gardiner ainsi que des informations sur leur transmission et leur signification. L'ensemble du processus se déroule hors ligne, ce qui signifie que le service est pratique, rapide, facile à utiliser et est accessible n'importe où à tout moment.

Il existe de nombreuses fonctionnalités à l'application en plus de la détection et de la classification, il comprend également un dictionnaire hiéroglyphique, qui permet aux utilisateurs de saisir un code de Gardener et de recevoir des informations sur le hiéroglyphe qu'il représente, un historique de recherche pour afficher et réanalyser les images précédentes, un flux social pour afficher et analyser les autres utilisateurs et la recherche d'images de noms de nom de Hierogyphy et description pour améliorer le classificateur et ainsi améliorer les performances de l'application à l'avenir. Ces fonctionnalités reposent sur MySQL databases stockées sur un serveur distant et manipliées à Google's Firebase aide de Scripts PHP.

Chaque fonctionnalité est implémentée dans une vue distincte et des processus invisibles pour l'utilisateur tels que la classification, chacun a également son propre point de vue. L'application mobile peut communiquer avec deux bases de données sur un serveur distant. L'un détient le contenu social utilisé par les caractéristiques de l'histoire et des aliments sociaux et l'autre contient des informations sur les hiéroglyphes triés par les codes Gardiner, utilisés par le dictionnaire des hiéroglyphes et pour fournir plus d'informations sur la classification.

Pour la segmentation, cela est accompli en utilisant OpenCV en convertissant le bitmap pris par l'utilisateur dans un objet MAT, en le transformant en noir et blanc puis en brouillant l'image avec un rayon de 3. La moyenne est ensuite calculée. Ensuite, l'image est seuillée avec une valeur min de la moyenne calculée et un maxval de 255. Candue est ensuite appliquée avec des seuils de la moyenne * 0,66 et la moyenne * 1,33 et une taille d'ouverture de 3 qui s'est avérée optimale. Ensuite, les composants sont extraits et sont utilisés pour dessiner des boîtes de délimitation autour des hiéroglyphes individuels sur l'image d'origine. Ceux-ci sont ensuite recadrés et placés dans un tableau d'images plus petites. Les images recadrées (de l'image d'origine) sont ensuite transformées en noir et blanc et sont maintenues de la même manière avant d'être alimentées au classificateur pour maximiser les précisions.

Le classificateur utilise le concept de réseaux siamois . Un tel réseau diffère de ceux normaux en prenant comme paires d'entrée d'images et une étiquette représentant s'ils sont de la même classe ou non (affichés comme 0 ou 1). En d'autres termes, la moitié de ce qui est introduit dans le réseau sont des paires d'images des mêmes classes avec leur étiquette que 1 et l'autre moitié, deux images différentes de deux classes différentes, avec leur étiquette comme 0. Les images sont choisies au hasard. Récemment, ce concept s'est avéré utile dans les problèmes en utilisant un grand nombre de classes avec un petit nombre d'images pour chaque classe, car pour classer l'image de test réelle, les images d'entraînement sont alimentées par le réseau et un vecteur de fonctionnalité de 640 valeurs est extrait. Ensuite, la moyenne de tous les vecteurs des images dans une classe, est calculée et stockée dans un fichier de valeurs séparées par des virgules (CSV). Il en va de même pour toutes les classes (157). En ce qui concerne la prévision du numéro de classe pour une nouvelle image de test, il est intégré au même réseau et un vecteur de fonctionnalité de 640 valeurs est également extrait. Suite à cela, la distance L1 entre son vecteur de caractéristique et celles extraites de chaque classe est comparée et les cinq plus petites distances sont prises comme les cinq principales prédictions. L'application iOS utilise OpenML tandis que l'application Android utilise Tensorflow .

La précision de la prédiction supérieure est de 66%, tandis que la précision des cinq principales prédictions est de 88%.

Des captures d'écran et des vidéos peuvent être trouvées ici: https://malaksadek.wordpress.com/2019/10/15/teet-the-egyptian-microbus-experence/

L'application est disponible sur: