Regardez la démo: https://www.youtube.com/watch?v=UGQMN2XDU54

Ce référentiel est basé sur le code du carnet d'analyste de données sur les applications Azure Container de Langchain (https://github.com/langchain-ai/langchain/blob/master/cookbook/azure_conainer_apps_dynamic_sessions_data_analyst.ipynb) il dans un fichier CSV, et exécute du code basé sur le fichier CSV, tel que le traçage d'un graphique.

La principale fonctionnalité du code était qu'il exécutait le code dans un conteneur à l'aide des séances dynamiques des applications de conteneur Azure.

Ce projet remplace les séances dynamiques des applications de conteneur Azure par Docker. Ainsi, lorsque l'agent exécute le code, il créera un conteneur Docker, exécutera le code, puis supprimera le conteneur. Cela garantit que la machine hôte est à l'abri du code arbitraire de l'agent.

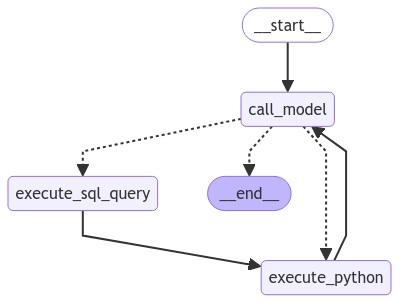

L'architecture de l'agent est la suivante:

Une fois le nœud EXECUTE_SQL_Query exécuté, les données sont enregistrées sous forme de CSV sur la machine hôte. Le conteneur Docker a ensuite l'autorisation en lecture seule pour accéder à ce CSV. S'il trace quelque chose, l'image est remise à la machine hôte via une chaîne Base64.

git clone https : // github . com / paulomuraroferreira / LLM - agents - with - docker . git

cd LLM - agents - with - docker$ pip install - e .Assurez-vous également que Docker soit installé et en cours d'exécution.

Créez un fichier .env et remplissez les variables d'environnement suivantes:

OPENAI_API_KEY = your_openai_api_key

DATABASE_URL = your_postgres_url

LLM_MODEL = i am using 'gpt-4o'Exécutez le script principal pour initialiser le flux de travail et gérer les requêtes utilisateur:

python main . py