En el campo de la inteligencia artificial multimodal, el Instituto de Investigación de Zhiyuan ha cooperado con muchas universidades para lanzar el nuevo modelo de vector multimodal BGE-VL. Esta innovación marca un gran avance en la tecnología de recuperación multimodal. Desde su lanzamiento, los modelos de la serie BGE han sido ampliamente elogiados por su excelente desempeño, y el lanzamiento de BGE-VL ha enriquecido aún más este ecosistema. Este modelo funcionó particularmente bien en muchas tareas clave, como la recuperación gráfica y de texto y la recuperación de imágenes combinadas, lo que demuestra su posición de liderazgo en el campo de la recuperación multimodal.

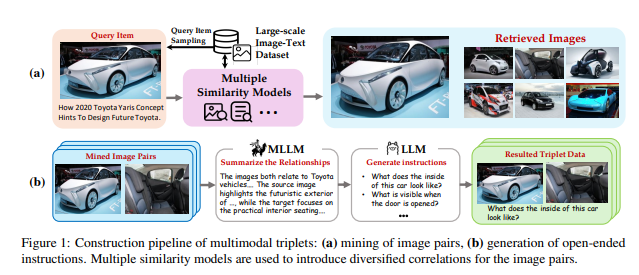

El éxito de BGE-VL es inseparable de la tecnología de síntesis de datos de Megapairs detrás de ella. Este método innovador mejora significativamente la escalabilidad y la calidad de los datos al extraer datos gráficos y de texto a gran escala existentes. Megapairs puede generar diversos conjuntos de datos a un costo extremadamente bajo, y su contenido de más de 26 millones de muestras proporciona una base sólida para capacitar a los modelos de recuperación multimodal. Esta tecnología ha permitido a BGE-VL lograr los resultados principales en múltiples puntos de referencia de búsqueda multimodales principales, consolidando aún más su posición en la industria.

Con el creciente desarrollo de la tecnología de recuperación multimodal, las necesidades de los usuarios para la adquisición de información se están volviendo cada vez más diversas. Los modelos de recuperación anteriores se basan principalmente en un solo par gráfico para el entrenamiento, y no pueden tratar de manera efectiva las entradas combinadas complejas. BGE-VL supera con éxito esta limitación al introducir los datos de Megapairs, lo que permite que el modelo comprenda y procese de manera más integral consultas multimodales, proporcionando así a los usuarios servicios de recuperación más precisos.

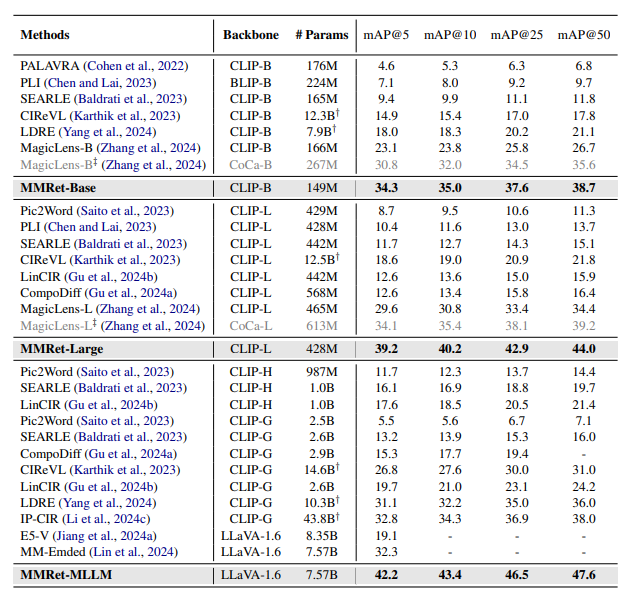

En la evaluación del rendimiento de múltiples tareas, el equipo de Zhiyuan descubrió que el modelo BGE-VL funcionó particularmente bien en el punto de referencia de incrustación multimodal masivo (MMEB). Aunque Megapairs no cubre la mayoría de las tareas en MMEB, sus capacidades de generalización de tareas siguen siendo emocionantes. Además, en la evaluación de la recuperación de imágenes combinadas, BGE-VL también se realizó de manera sobresaliente, superando significativamente muchos modelos bien conocidos, como MagicLens de Google y MM-Embed de NVIDIA, lo que demuestra aún más su posición principal en el campo de la recuperación multimodal.

Mirando hacia el futuro, el Instituto de Investigación de Zhiyuan planea continuar profundizando la tecnología de Megapairs, combinarse con escenarios de búsqueda multimodales más ricos y esforzarse por crear un buscador multimodal más completo y eficiente para proporcionar a los usuarios servicios de información más precisos. Con el desarrollo continuo de la tecnología multimodal, el lanzamiento de BGE-VL sin duda promoverá una mayor exploración e innovación en campos relacionados e inyectará un nuevo impulso al progreso de la tecnología de inteligencia artificial.

Dirección en papel: https://arxiv.org/abs/2412.14475

Página de inicio del proyecto: https://github.com/vectorspacelab/megapairs

Dirección del modelo: https://huggingface.co/baai/bge-vl-mllm-s1