Auf dem Gebiet der multimodalen künstlichen Intelligenz hat das Zhiyuan Research Institute mit vielen Universitäten zusammengearbeitet, um das neue multimodale Vektormodell BGE-VL auf den Markt zu bringen. Diese Innovation ist ein großer Durchbruch bei der multimodalen Abruftechnologie. Seit seiner Start wurden die Modelle der BGE-Serie für ihre herausragende Leistung weit verbreitet, und der Start von BGE-VL hat dieses Ökosystem weiter angereichert. Dieses Modell war besonders gut in vielen wichtigen Aufgaben wie Grafik- und Text -Abruf und kombiniertem Bildabruf ab, was seine führende Position im Bereich des multimodalen Abrufs demonstriert hat.

Der Erfolg von BGE-VL ist untrennbar mit der Megapairs Data Synthesis-Technologie dahinter verbunden. Diese innovative Methode verbessert die Skalierbarkeit und Qualität der Daten erheblich, indem vorhandene groß angelegte Grafik- und Textdaten abgebaut werden. Megapairs ist in der Lage, verschiedene Datensätze zu extrem niedrigen Kosten zu generieren, und es enthält mehr als 26 Millionen Proben, bietet eine solide Grundlage für die Schulung multimodaler Abrufmodelle. Diese Technologie hat es BGE-VL ermöglicht, führende Ergebnisse bei mehreren multimodalen Mainstream-Suchbenchmarks zu erzielen, die seine Position in der Branche weiter konsolidieren.

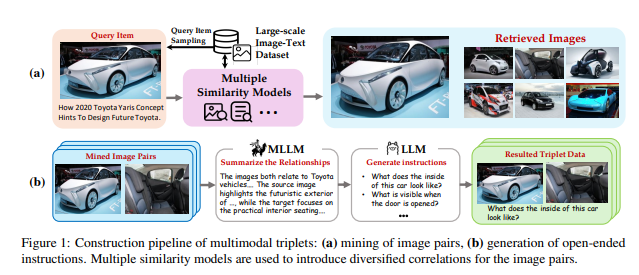

Mit der zunehmenden Entwicklung der multimodalen Abruftechnologie werden die Bedürfnisse der Benutzer nach Informationsakquisition immer vielfältiger. Frühere Abrufmodelle stützen sich hauptsächlich auf ein einzelnes Grafikpaar für das Training und können nicht effektiv mit komplexen kombinierten Eingaben umgehen. BGE-VL überwindet diese Einschränkung erfolgreich durch Einführung von Megapairs-Daten, sodass das Modell multimodale Abfragen umfassender versteht und verarbeitet und damit Benutzern genauere Abrufdienste bietet.

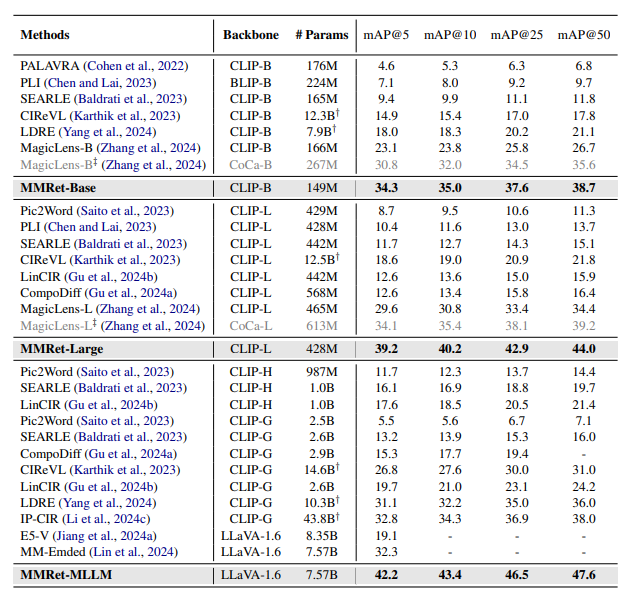

Bei der Leistungsbewertung mehrerer Aufgaben stellte das Zhiyuan-Team fest, dass das BGE-VL-Modell auf dem massiven multimodalen Einbettungs-Benchmark (MMEB) besonders gut abschneidet. Obwohl Megapairs die meisten Aufgaben in MMEB nicht abdeckt, sind seine Aufgabenverallgemeinerungsfunktionen immer noch aufregend. Darüber hinaus führte BGE-VL bei der Bewertung des kombinierten Bildabrufs außerordentlich auch von vielen bekannten Modellen, wie die Magiclens und die MM-EMBE von Google und die MM-EMBE von Google, erheblich durch, was die führende Position im Bereich multimodaler Abruf weiter beweist.

Mit Blick auf die Zukunft plant das Zhiyuan Research Institute, die Megapair -Technologie weiter zu vertiefen, sich mit reicheren multimodalen Suchszenarien zu verbinden und einen umfassenderen und effizienteren multimodalen Sucher zu erstellen, um den Benutzern genauere Informationsdienste zu bieten. Mit der kontinuierlichen Entwicklung multimodaler Technologie wird der Start von BGE-VL zweifellos weitere Erkundungen und Innovationen in verwandten Bereichen fördern und den Fortschritt der Technologie für künstliche Intelligenz neue Impulse einteilen.

Papieradresse: https://arxiv.org/abs/2412.14475

Projekt Homepage: https://github.com/vectorspacelab/megapairs

Modelladresse: https://huggingface.co/baai/bge-vl-mllm-s1