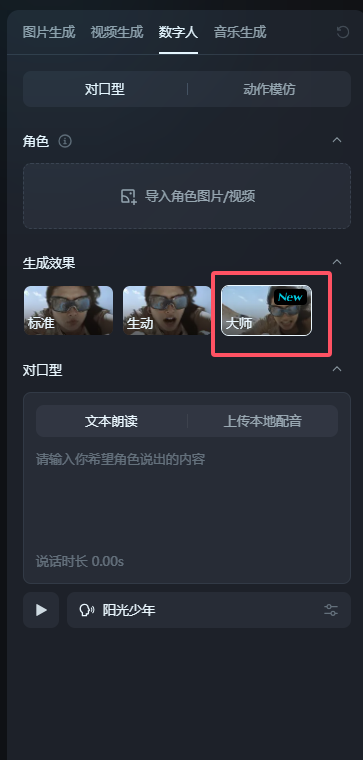

La función Omnihuman-1 de Bytedance ahora se ha abierto oficialmente para su uso en la plataforma Imeng. Recientemente, Jimeng Ai anunció el lanzamiento completo del modo digital humano-maestro. Esta función innovadora permite a los usuarios generar automáticamente humanos digitales avanzados con movimientos naturales y expresiones realistas simplemente cargando una foto y un audio. A diferencia del modelo tradicional, el modelo maestro no requiere ingresar palabras rápidas complejas, lo que reduce en gran medida el umbral para la creación humana digital y permite que más usuarios comiencen fácilmente.

El lanzamiento de esta función no solo reduce en gran medida la dificultad de la creación de las personas digitales, sino que también mejora significativamente la libertad de creación. El rendimiento de la animación de la nueva generación de personas digitales es particularmente sorprendente, deshaciéndose por completo del problema de los modelos rígidos en el pasado y brindando a los usuarios una experiencia visual más suave y natural. Ya sea que se trate de expresiones faciales o movimientos corporales, han alcanzado un nivel de realidad sin precedentes.

Lo más destacado del modo maestro es que rompe la limitación de que las personas digitales tradicionales solo pueden impulsar los movimientos de la cabeza, y se da cuenta de la generación natural de movimientos de todo el cuerpo. Esto significa que las personas digitales creadas por los usuarios ya no son una sola "muñeca de cabeza grande", sino que tienen un lenguaje corporal completo. A juzgar por los comentarios de los usuarios actuales de la comunidad, esta función funciona particularmente bien en escenas complejas como el habla, el canto y el baile, mostrando un fuerte potencial de aplicación.

Para probar esta función, el editor subió una foto de Nezha y agregó un audio. Los efectos generados son sorprendentes, con movimientos suaves y naturales y expresiones vívidas, que son ideales para crear animaciones de sincronización de labios o profesores digitales. Actualmente, el modo maestro admite cargar audio hasta 15 segundos, lo cual es suficiente para satisfacer las necesidades de la mayoría de las creaciones de video cortas.

Esta característica es, sin duda, una gran bendición para creadores de video cortos, anclajes virtuales y fabricantes de publicidad. No solo reduce en gran medida los costos de producción, sino que también ayuda a los usuarios a producir contenido más expresivo y atractivo. Ya sea que esté produciendo contenido en vivo para anclajes virtuales o agregando roles humanos digitales vívidos a los anuncios, el modelo maestro puede mejorar significativamente la eficiencia y la calidad.

Además, el potencial del modo maestro va mucho más allá de eso. Con el avance continuo de la tecnología, es probable que se convierta en un motor poderoso para la tecnología humana digital de IA para ingresar a campos más amplios como cine y televisión, juegos, etc. En el futuro, podemos ver películas protagonizadas por el hombre digital de IA o jugar un mundo inmersivo dominado por los NPC de hombre digital. Todo esto hace que las personas lo esperen, y el futuro de la tecnología humana digital sin duda será aún más emocionante.