Recientemente, el equipo de Vita-MLLM lanzó su último resultado de la investigación Vita-1.5. Vita-1.5 no solo admite dos idiomas: inglés y chino, sino que también logra un salto cualitativo en múltiples indicadores de rendimiento, lo que brinda a los usuarios una experiencia interactiva más suave y eficiente.

Vita-1.5 ha hecho un gran avance en el retraso de la interacción, acortando en gran medida el retraso original de 4 segundos a solo 1.5 segundos. Esta mejora no permite a los usuarios casi ningún retraso durante la interacción de voz, mejorando enormemente la experiencia del usuario. Además, Vita-1.5 también ha mejorado significativamente en el rendimiento multimodal.

En términos de procesamiento de voz, Vita-1.5 también ha sido profundamente optimizado. La tasa de error de su sistema de reconocimiento de voz automático (ASR) ha caído de 18.4 a 7.5, mejorando significativamente la precisión de la comprensión y la respuesta de los comandos de voz. Al mismo tiempo, Vita-1.5 presenta un nuevo módulo de texto a voz de extremo a voz (TTS), que puede recibir directamente incrustaciones de modelos de lenguaje grande (LLMS) como entrada, mejorando en gran medida la naturalidad y la coherencia de la síntesis del habla .

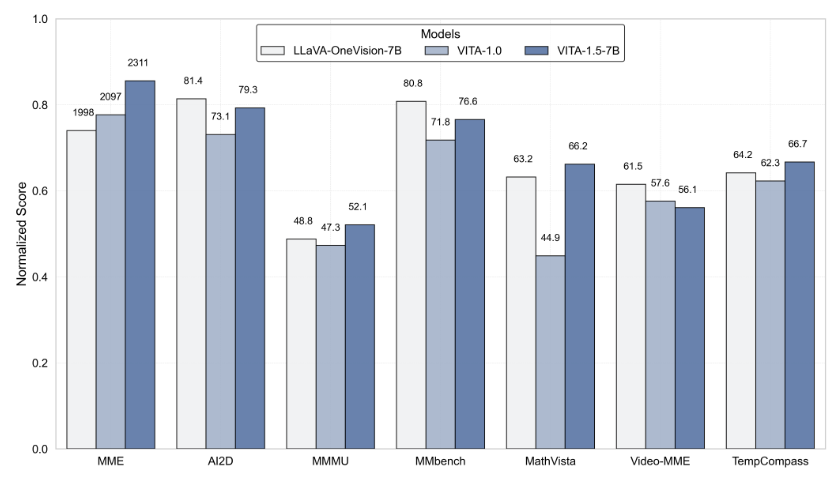

Para garantizar el equilibrio de las capacidades multimodales, Vita-1.5 adopta una estrategia de entrenamiento progresiva, que minimiza el impacto del módulo de procesamiento del habla recientemente agregado en el rendimiento del idioma visual, y el rendimiento de la comprensión de la imagen solo disminuyó ligeramente de 71.3 a 70.8. A través de estas innovaciones tecnológicas, Vita-1.5 promueve aún más los límites entre las interacciones visuales y de voz en tiempo real, estableciendo una base sólida para futuras aplicaciones de interacción inteligente.

Para los desarrolladores, Vita-1.5 es muy conveniente de usar. Los desarrolladores pueden comenzar rápidamente con operaciones simples de línea de comandos, y el equipo también proporciona demostraciones interactivas básicas y en tiempo real para ayudar a los usuarios a comprender y usar mejor el sistema. Para mejorar aún más la experiencia interactiva en tiempo real, los usuarios deben preparar algunos módulos necesarios, como el módulo de detección de actividad de voz (VAD). Además, el código de Vita-1.5 será de código abierto, permitirá a los desarrolladores participar y contribuir, y promover conjuntamente el avance de esta tecnología.

El lanzamiento de Vita-1.5 marca otro hito importante en el campo del modelo de lenguaje grande multimodal interactivo, lo que demuestra la búsqueda incesante del equipo VITA-MLLM en innovación tecnológica y experiencia del usuario. El lanzamiento de esta versión no solo trae a los usuarios una experiencia interactiva más inteligente, sino que también señala la dirección para el desarrollo futuro de la tecnología multimodal.

Entrada del proyecto: https://github.com/vita-mllm/vita?tab=readme-ov-file

Puntos clave:

Vita-1.5 reduce significativamente la latencia de interacción, acortando de 4 segundos a 1.5 segundos, mejorando significativamente la experiencia del usuario.

El rendimiento multimodal ha mejorado, con el rendimiento promedio de múltiples puntos de referencia aumentados de 59.8 a 70.8.

Se mejora la capacidad de procesamiento de voz, la tasa de error ASR ha disminuido de 18.4 a 7.5, y el reconocimiento de voz es más preciso.