Kürzlich hat das Vita-Mllm-Team sein neuestes Forschungsergebnis Vita-1.5 veröffentlicht. Vita-1.5 unterstützt nicht nur zwei Sprachen: Englisch und Chinesisch, sondern erzielt auch einen qualitativen Sprung in mehreren Leistungsindikatoren, was den Benutzern ein glatteres und effizientere interaktivere Erlebnis bietet.

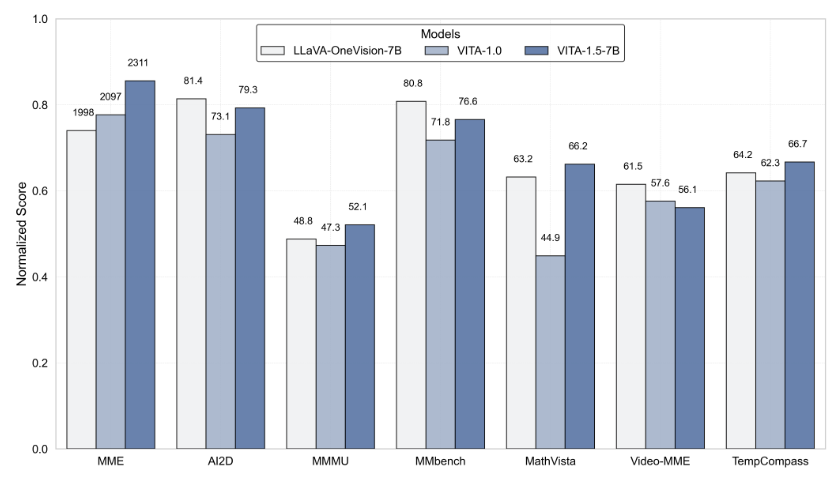

Vita-1.5 hat einen großen Durchbruch bei der Interaktionsverzögerung erzielt und die ursprüngliche 4-Sekunden-Verzögerung auf nur 1,5 Sekunden stark verkürzt. Diese Verbesserung ermöglicht es den Benutzern, während der Sprachinteraktion fast keine Verzögerung zu verzögern, was die Benutzererfahrung erheblich verbessert. Darüber hinaus hat Vita-1.5 die multimodale Leistung nach mehreren Benchmark-Tests wie MME, MMBench und Mathvista erheblich verbessert.

In Bezug auf die Sprachverarbeitung wurde auch Vita-1.5 zutiefst optimiert. Die Fehlerrate seines automatischen Spracherkennungssystems (ASR) ist von 18,4 auf 7,5 gesunken und die Verständnis und die Reaktionsgenauigkeit von Sprachbefehlen erheblich verbessert. Gleichzeitig führt Vita-1.5 ein neues End-to-End-Text-to-Speech-Modul (TTS) ein, das die Einbettung von Großsprachmodellen (LLMs) als Input direkt empfangen kann, wodurch die Natürlichkeit und Kohärenz der Sprachsynthese erheblich verbessert wird .

Um das Gleichgewicht der multimodalen Fähigkeiten zu gewährleisten, nimmt Vita-1.5 eine progressive Trainingsstrategie an, die die Auswirkungen des neu hinzugefügten Sprachverarbeitungsmoduls auf die visuelle Sprache minimiert, und die Leistung des Bildverständnisses nahm von 71.3 auf 70,8 nur geringfügig ab. Durch diese technologischen Innovationen fördert Vita-1.5 die Grenzen zwischen visuellen Echtzeit- und Sprachinteraktionen weiter und legt eine solide Grundlage für zukünftige intelligente Interaktionsanwendungen.

Für Entwickler ist Vita-1.5 sehr bequem zu bedienen. Entwickler können schnell mit einfachen Befehlszeilenvorgängen beginnen, und das Team bietet auch interaktive Basis- und Echtzeit-Demonstrationen, um den Benutzern das System besser zu verstehen und zu nutzen. Um das interaktive Echtzeit-Erlebnis weiter zu verbessern, müssen Benutzer einige erforderliche Module vorbereiten, z. B. das VAD-Modul (Voice Activity Detection). Darüber hinaus wird der Code von Vita-1.5 vollständig Open Source sein, sodass Entwickler teilnehmen und beitragen und gemeinsam die Weiterentwicklung dieser Technologie fördern können.

Der Start von Vita-1.5 markiert einen weiteren wichtigen Meilenstein im Bereich des interaktiven multimodalen Großsprachenmodells und demonstriert das unablässige Streben nach Vita-MLLM-Team in technologischer Innovation und Benutzererfahrung. Die Veröffentlichung dieser Version bringt Benutzern nicht nur ein intelligentes interaktiveres Erlebnis, sondern zeigt auch die Richtung für die zukünftige Entwicklung multimodaler Technologie.

Projekteingang: https://github.com/vita-mllm/vita?tab=readme-ov-file

Schlüsselpunkte:

Vita-1.5 reduziert die Interaktionslatenz signifikant und verkürzt sich von 4 Sekunden auf 1,5 Sekunden und verbessert die Benutzererfahrung erheblich.

Die multimodale Leistung hat sich verbessert, wobei die durchschnittliche Leistung mehrerer Benchmarks von 59,8 auf 70,8 gestiegen ist.

Die Sprachverarbeitungsfähigkeit wird verbessert, die ASR -Fehlerrate ist von 18,4 auf 7,5 gesunken und die Spracherkennung ist genauer.