ByteDance lanzó recientemente una nueva generación de modelo de profundidad, Depth Anything V2, que ha logrado un avance significativo en el campo de la estimación de profundidad monocular. En comparación con la generación anterior, la versión V2 ha mejorado enormemente en términos de precisión de detalle, robustez y eficiencia, y su velocidad es más de diez veces más rápida que el modelo basado en Difusión Estable. El avance de esta tecnología no sólo se refleja en la optimización del propio modelo, sino también en sus innovadores métodos de entrenamiento, que aportan nuevas posibilidades al campo de la visión por ordenador. El artículo detalla las características clave, los métodos de capacitación y la amplia gama de escenarios de aplicación de Depth Anything V2, lo que nos permite obtener una comprensión profunda del avance de esta tecnología.

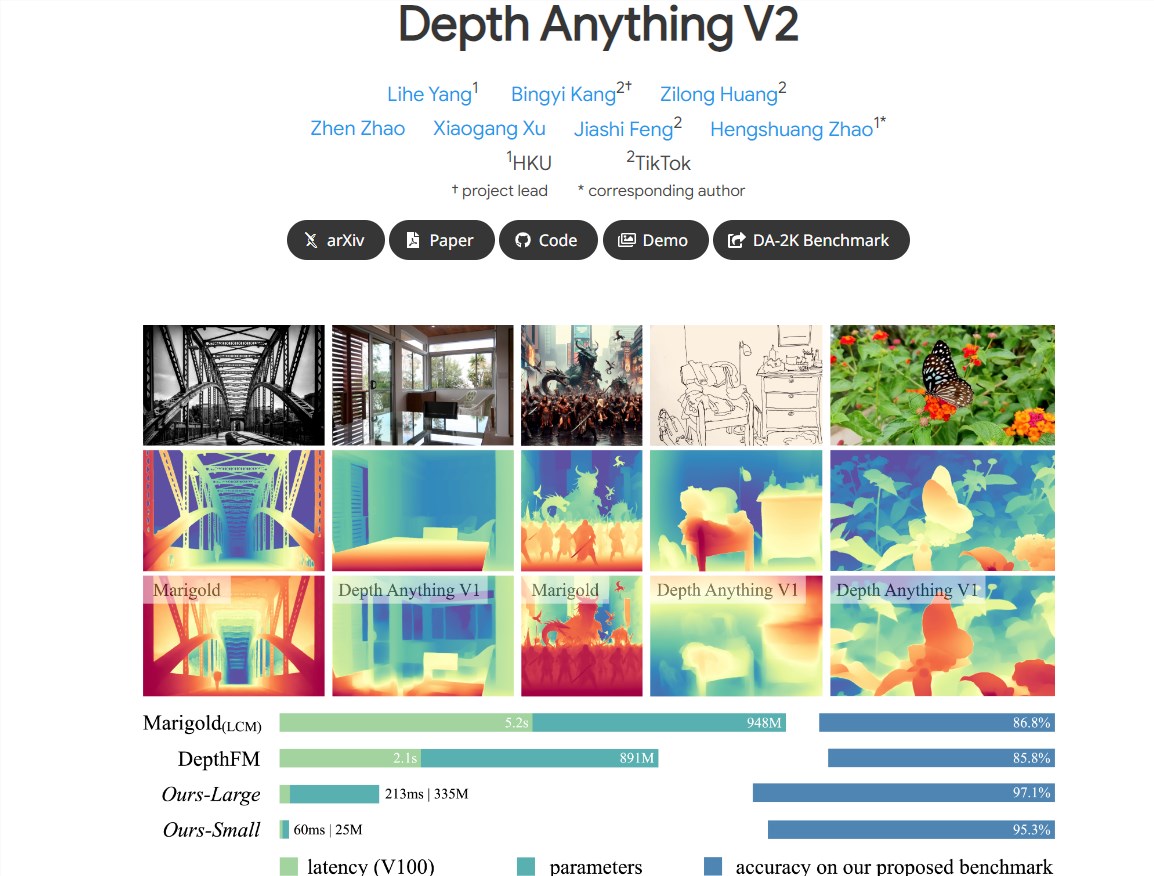

Noticias de ChinaZ.com el 14 de junio: ByteDance ha lanzado una nueva generación del modelo de profundidad Depth Anything V2, que ha logrado importantes mejoras de rendimiento en el campo de la estimación de profundidad monocular. En comparación con la generación anterior Depth Anything V1, la versión V2 tiene detalles más finos y una mayor robustez, al tiempo que mejora significativamente la eficiencia, más de 10 veces más rápido que el modelo basado en Stable Diffusion.

Características clave:

Detalles más finos: el modelo V2 está optimizado en detalle, proporcionando predicciones de profundidad más precisas.

Alta eficiencia y precisión: en comparación con los modelos construidos basados en SD, V2 ha mejorado significativamente la eficiencia y precisión.

Compatibilidad con modelos de múltiples escalas: proporciona modelos de diferentes escalas con parámetros que van desde 25 M hasta 1,3 B para adaptarse a diferentes escenarios de aplicación.

Prácticas clave: rendimiento mejorado del modelo al reemplazar imágenes reales con imágenes sintéticas, ampliar la capacidad del modelo docente y utilizar imágenes pseudoanotadas a gran escala para enseñar modelos a los estudiantes.

Tres prácticas clave para mejorar el rendimiento del modelo:

Uso de imágenes sintéticas: todas las imágenes reales anotadas se reemplazan por imágenes sintéticas, lo que mejora la eficiencia del entrenamiento del modelo.

Capacidad ampliada del modelo docente: al ampliar la capacidad del modelo docente, se mejora la capacidad de generalización del modelo.

Aplicación de imágenes pseudoanotadas: utilice imágenes reales pseudoanotadas a gran escala como puente para enseñar modelos a los estudiantes y mejorar la solidez del modelo.

Soporte para una amplia gama de escenarios de aplicaciones:

Para satisfacer las necesidades de una amplia gama de aplicaciones, los investigadores proporcionan modelos a diferentes escalas y aprovechan sus capacidades de generalización para realizar ajustes mediante etiquetas de profundidad métricas.

Se construye un punto de referencia de evaluación diverso que contiene escasas anotaciones profundas para facilitar investigaciones futuras.

Métodos de entrenamiento basados en imágenes sintéticas y reales:

Los investigadores primero entrenaron el modelo de maestro más grande con imágenes sintéticas, luego generaron pseudoetiquetas de alta calidad para imágenes reales sin etiquetar a gran escala y entrenaron modelos de estudiantes con estas imágenes reales pseudoetiquetadas.

El proceso de formación utiliza 595.000 imágenes sintéticas y más de 62 millones de imágenes pseudoetiquetadas reales.

El lanzamiento del modelo Depth Anything V2 demuestra las capacidades innovadoras de ByteDance en el campo de la tecnología de aprendizaje profundo. Sus características de rendimiento eficientes y precisas indican que el modelo tiene un amplio potencial de aplicación en el campo de la visión por computadora.

Dirección del proyecto: https://profundidad-anything-v2.github.io/

Con todo, la aparición del modelo Depth Anything V2 marca un importante avance en la tecnología de estimación de profundidad monocular. Su alta eficiencia, precisión y amplias perspectivas de aplicación le otorgan un enorme potencial de desarrollo en el campo de la visión por computadora en el futuro, y vale la pena esperar su implementación en más escenarios de aplicación.