Emu3, el último modelo de IA multimodal desarrollado por el equipo de Meta AI, está causando sensación en el campo de la inteligencia artificial con su arquitectura simple y eficiente y sus potentes funciones. A diferencia de los complejos modelos multimodales anteriores, Emu3 logra un procesamiento unificado de texto, imágenes y videos al convertir varios contenidos en símbolos discretos y usar un único modelo Transformer para predecir el siguiente símbolo. El editor de Downcodes le brindará una comprensión profunda de las innovaciones de Emu3 y cómo cambia nuestra comprensión de la IA.

En el vasto océano de la inteligencia artificial, un barco innovador llamado Emu3 rompe las olas, mostrándonos las infinitas posibilidades de la IA multimodal. Este modelo revolucionario desarrollado por el equipo de investigación de Meta AI logra el procesamiento unificado de texto, imágenes y videos a través de un mecanismo de predicción del siguiente paso simple e inteligente.

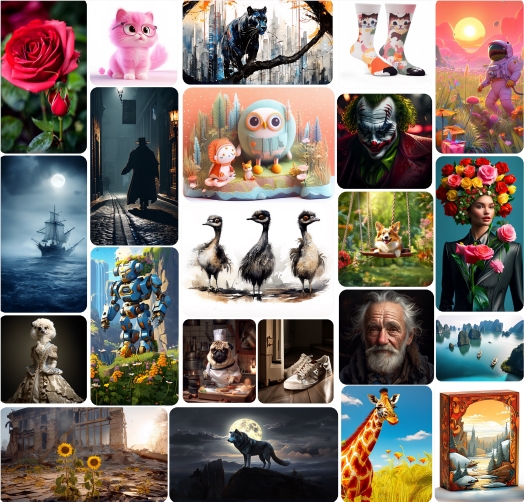

La idea central de Emu3 es convertir varios contenidos en símbolos discretos y luego usar un único modelo Transformer para predecir el siguiente símbolo. Este enfoque no solo simplifica la arquitectura del modelo, sino que también permite a Emu3 demostrar capacidades asombrosas en múltiples campos. Desde la generación de imágenes de alta calidad hasta la comprensión precisa de imágenes y textos, desde respuestas de diálogo coherentes hasta la creación de videos fluida, Emu3 puede manejarlo con facilidad.

En términos de generación de imágenes, Emu3 solo necesita una descripción de texto para crear imágenes de alta calidad que cumplan con los requisitos. Incluso supera al modelo especializado de generación de imágenes SDXL. Lo que es aún más sorprendente es que Emu3 no es inferior en capacidades de comprensión de imágenes y lenguaje, y puede describir con precisión escenas del mundo real y dar respuestas de texto apropiadas, todo sin depender de CLIP o modelos de lenguaje previamente entrenados.

Emu3 también funciona bien en el campo de la generación de vídeo. Es capaz de crear vídeos prediciendo el siguiente símbolo en una secuencia de vídeo, en lugar de depender de técnicas complejas de difusión de vídeo como otros modelos. Además, Emu3 también tiene la capacidad de continuar con el contenido de vídeo existente y ampliar naturalmente las escenas de vídeo como si pudiera prever el futuro.

El equipo de Meta AI planea abrir los pesos del modelo, el código de inferencia y el código de evaluación de Emu3 en un futuro próximo, para que más investigadores y desarrolladores puedan experimentar el encanto de este poderoso modelo. Para aquellos interesados en probar Emu3, el proceso es bastante sencillo. Simplemente clone el código base e instale los paquetes necesarios, y podrá ejecutar fácilmente Emu3-Gen para generar imágenes a través de la biblioteca Transformers, o usar Emu3-Chat para interacción gráfica y de texto.

Emu3 no es sólo un avance tecnológico, sino que representa una innovación importante en el campo de la IA. Mediante el procesamiento unificado de información de diferentes modalidades, Emu3 señala el camino para futuros sistemas inteligentes. Muestra cómo lograr una mayor funcionalidad de una manera más sencilla, revolucionando potencialmente la forma en que diseñamos y utilizamos los sistemas de IA.

Dirección del proyecto: https://github.com/baaivision/Emu3

La aparición de Emu3 presagia un nuevo capítulo en el desarrollo de la IA multimodal. Su concepto de diseño simple y eficiente y sus poderosas funciones brindan nuevas direcciones y posibilidades para el desarrollo de la futura tecnología de IA. El editor de Downcodes espera que Emu3 pueda mostrar su gran potencial en más campos y brindarnos una experiencia de vida más inteligente y conveniente.