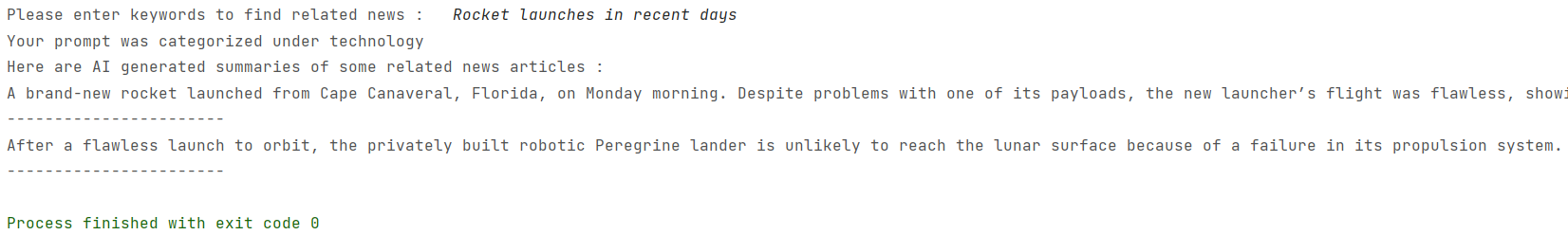

Un software de código abierto completamente basado en RAG (generación aumentada de recuperación) que proporciona resúmenes de artículos de noticias relacionados construidos utilizando la base de datos de vectores de ChromAdB, mixtral-8x7b-instructo-v0.1 LLM (a través de la IA replicada), el modelo de replicidad de la regla de los Times, el modelo de la transmisión de la transmisión de la transmisión de la oración y la transmisión de la oración y la transmisión de la transmisión de la oración de la oración de la oración de Times/BART-BASE-BASE-BASE-BASE-BASE. Incrustos de Huggingface.

Un software de código abierto completamente basado en RAG (generación aumentada de recuperación) que proporciona resúmenes de artículos de noticias relacionados construidos utilizando la base de datos de vectores de ChromAdB, mixtral-8x7b-instructo-v0.1 LLM (a través de la IA replicada), el modelo de replicidad de la regla de los Times, el modelo de la transmisión de la transmisión de la transmisión de la oración y la transmisión de la oración y la transmisión de la transmisión de la oración de la oración de la oración de Times/BART-BASE-BASE-BASE-BASE-BASE. Incrustos de Huggingface.

Los datos para diferentes categorías de artículos de noticias se obtuvieron de los siguientes archivos RSS conformados: Tecnología: https://rss.nytimes.com/services/xml/rss/nyt/technology.xml deportes: https://rss.nytimes.com/services/xml/rss/nyt/sports.xml science:: la ciencia::: la ciencia::: la ciencia::: la ciencia:: la ciencia::: https://rss.nytimes.com/services/xml/rss/nyt/science.xml Health: https://rss.nytimes.com/services/xml/rss/nyt/science.xml

Los titulares, las descripciones y los dominios para cada artículo de noticias se vectorizan utilizando las incrustaciones de base de oración-T5 y se almacenan en un cliente de ChromAdB persistente. Los enlaces a los respectivos artículos de noticias también se almacenan en los metadatos. Además, las noticias de cada dominio se almacenan en una instancia de colección ChromAdB diferente para una recuperación eficiente.

El raspado web se ha realizado utilizando el raspador proporcionado por la API de NY Times, que solo da ~ 40-60 palabras de las noticias. La pared se puede pasar fácilmente incluso con BeautifulSoup4, pero no está muy seguro de su legalidad.

Para la categorización rápida, hemos utilizado el modelo MixTral-8x7B-Instruct-V0.1 debido a sus capacidades excepcionales, la ejecución basada en la nube en la IA replicada y la prevención sin esfuerzo de la alucinación. Para el texto-sumarización, utilizamos una versión ajustada del modelo Bart-Large de Huggingface originalmente propuesto por Facebook. El modelo ha sido capacitado en el conjunto de datos CNN_DAILYMAIL y aún más ajustado en el conjunto de datos Samsum, logrando una mejora del 103% en Rouge2 Benchmark. Es un modelo bastante liviano con un tamaño de ~ 1.6 GB. Enlaces: https://huggingface.co/dhivyeshrk/bart-large-cnn-samsum https://replicate.com/mistalai/mixtral-8x7b-instruct-v0.1

Use sus claves API de la API de New York Times y replique la AI AI y reemplácelas en web_scrape_nyt.py y categorize_promppt.py respectivamente. Luego ejecuta main.py