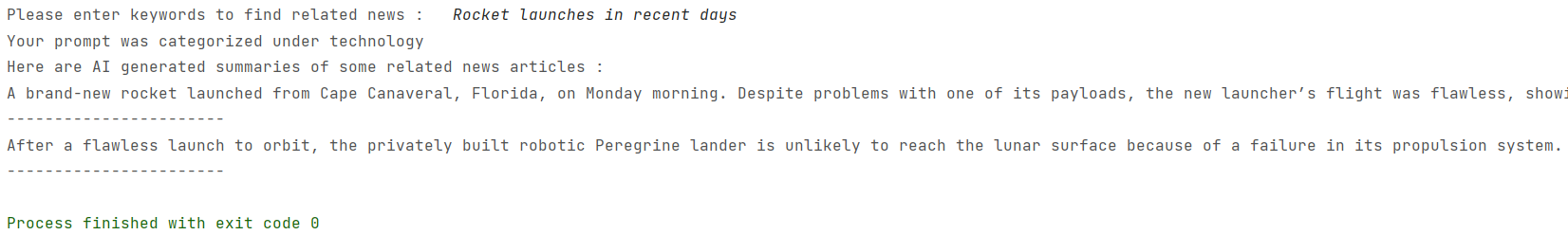

برنامج RAG (الجيل المعزز مع المعزز Retrival) يعتمد على المصادر بالكامل والذي يوفر ملخصات للمقالات الإخبارية ذات الصلة المصممة باستخدام قاعدة بيانات ناقلات ChromadB ، MIXTRAL-8X7B-INSTRUCT-V0.1 LLM (من خلال النسخ المتماثل من AI) ، STRING-BASE-TUND-BASE-TRANSTING-TRANSTANC التضمين من Huggingface.

برنامج RAG (الجيل المعزز مع المعزز Retrival) يعتمد على المصادر بالكامل والذي يوفر ملخصات للمقالات الإخبارية ذات الصلة المصممة باستخدام قاعدة بيانات ناقلات ChromadB ، MIXTRAL-8X7B-INSTRUCT-V0.1 LLM (من خلال النسخ المتماثل من AI) ، STRING-BASE-TUND-BASE-TRANSTING-TRANSTANC التضمين من Huggingface.

تم الحصول على بيانات عن فئات مختلفة من المقالات الإخبارية من الملفات التالية rss-formatted: التكنولوجيا: https://rss.nytimes.com/services/xml/rss/nyt/technology.xml Sports: https://rss.nytimes.com/services/xml/rss/nyt/sports.xml https://rss.nytimes.com/services/xml/rss/nyt/science.xml الصحة: https://rss.nytimes.com/services/xml/rss/nyt/science.xml

تتم عناوين العناوين والأوصاف والمجالات لكل مقالة إخبارية باستخدام تضمينات الجملة-T5 وتخزينها في عميل chromadb المستمر. يتم أيضًا تخزين الروابط إلى المقالات الإخبارية المعنية في البيانات الوصفية. بالإضافة إلى ذلك ، يتم تخزين الأخبار من كل مجال في مثيل مجموعة مختلفة من Chromadb لاسترجاع فعال.

تم إجراء تجريف الويب باستخدام مكشطة توفرها NY Times API ، والتي تعطي فقط 40-60 كلمة من الأخبار. يمكن تجاوز الجدار بسهولة حتى مع BeautifulSoup4 ولكن ليس متأكدًا تمامًا من شرعيةه.

بالنسبة للتصنيف السريع ، استخدمنا نموذج Mixtral-8x7B-instruct-V0.1 بسبب قدراته الاستثنائية ، والتنفيذ المستند إلى مجموعة النظراء على التكرار الذكاء الاصطناعي والوقاية من الهلوسة. لتكوين النصوص ، نستخدم إصدارًا دقيقًا من طراز Bart-Large من Huggingface الذي اقترحه Facebook أصلاً. تم تدريب النموذج على مجموعة بيانات CNN_DailyMail وتم ضبطه بشكل أكبر على مجموعة بيانات Samsum ، مما يحقق 103 ٪ من التحسين في ROUGE2. إنه نموذج خفيف الوزن إلى حد ما بحجم 1.6 جيجابايت. الروابط: https://huggingface.co/dhivyeshrk/bart-large-cnn-samsum https://replicate.com/mistralai/mixtral-8x7b-instruct-v0.1

استخدم مفاتيح API الخاصة بك من API New York Times وقم بتكرار AI API واستبدلها في Web_Scrape_nyt.py و Consigorize_prompt.py على التوالي. ثم تشغيل main.py