Transformator Labor

Herunterladen, interagieren und finetune Modelle lokal.

Erforschen Sie die Dokumente »

Demo anzeigen · Meldefehler · Features vorschlagen · Diskordien beischließen · Folgen Sie auf Twitter

Hinweis: Transformator Lab wird aktiv bearbeitet. Bitte schließen Sie sich unserer Zwietracht bei oder folgen Sie uns auf Twitter, um Updates zu erhalten. Fragen, Feedback und Beiträge sind hoch geschätzt!

Jetzt herunterladen

Über das Projekt

Transformator Lab ist eine App, mit der jeder mit großen Sprachmodellen experimentieren kann.

Unterstützt von Mozilla

Transformator Lab ist stolz darauf, von Mozilla durch das Mozilla Builders -Programm unterstützt zu werden

Merkmale

Transformator Lab ermöglicht es Ihnen:

- ? One-Click-Download Hunderte beliebter Modelle :

- LLAMA3, PHI3, Mistral, Mixtral, Gemma, Command-R und Dutzende mehr

- ⬇ Laden Sie LLM von Suggingface herunter

- ? Finetune / Zug über verschiedene Hardware

- Finetune mit MLX auf Apple Silicon

- Finetune mit Suggingface an der GPU

- ⚖️ RLHF und Präferenzoptimierung

- DPO

- Orpo

- Simpo

- Belohnungsmodellierung

- Arbeiten Sie mit LLMs über Betriebssysteme hinweg :

- Windows App

- MacOS App

- Linux

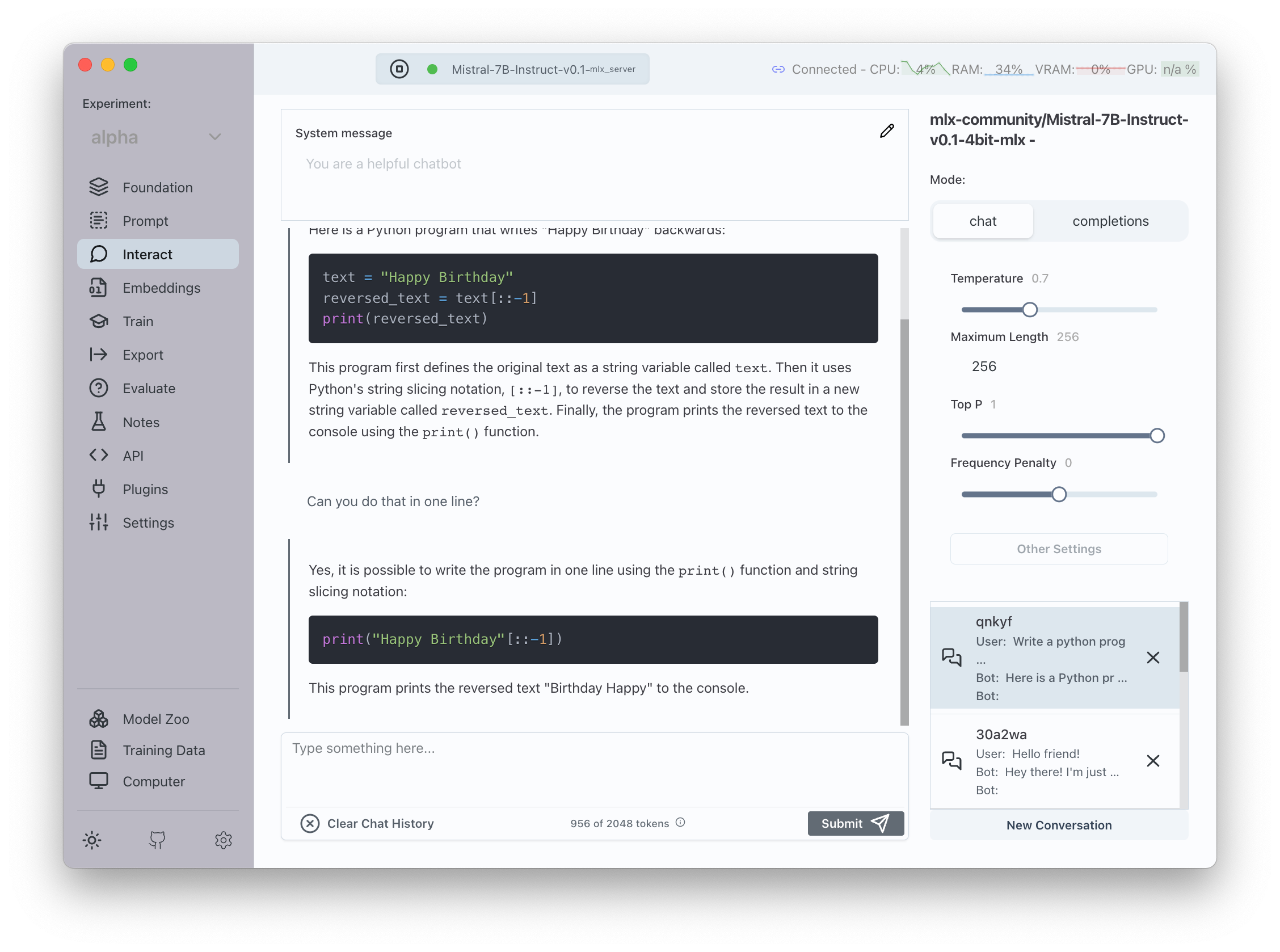

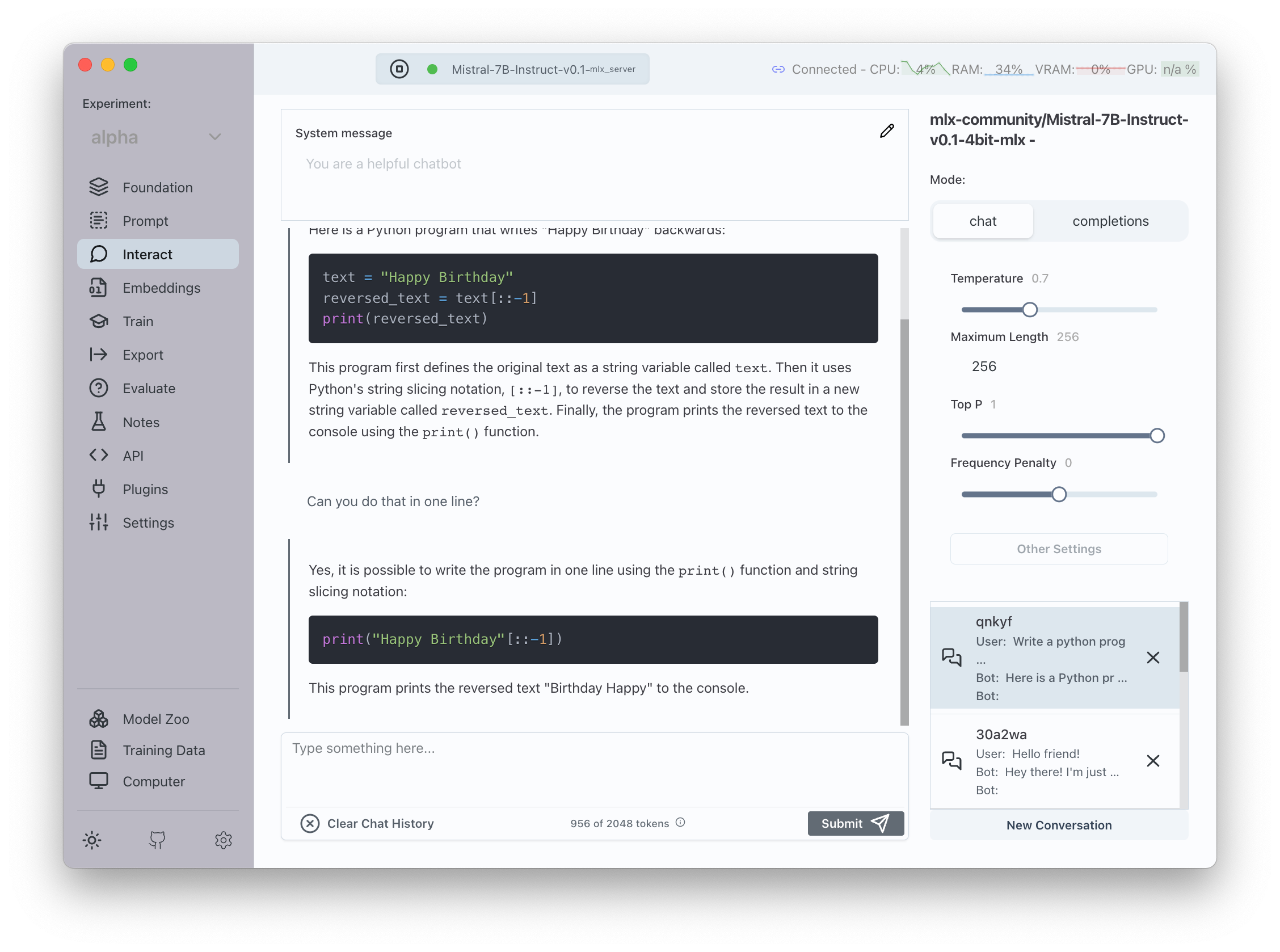

- Chatten Sie mit Modellen

- Chat

- Fertigstellungen

- Voreinstellungen (Vorlagen) Eingabeaufforderungen

- Chat -Geschichte

- Optimierungsparameter der Generierung

- Angegriffene Schlussfolgerung

- Tool verwenden / Funktionsaufruf (in Alpha)

- ? Verwenden Sie verschiedene Inferenzmotoren

- MLX auf Apple Silicon

- Umarmungsface -Transformatoren

- vllm

- Lama CPP

- ? ? Modelle bewerten

- RAG (Retreival Augmented Generation)

- Drag & Drop -Datei UI

- Arbeitet Apple MLX, Transformers und andere Motoren

- ? Erstellen Sie Datensätze für das Training

- Ziehen Sie Hunderte von gängigen Datensätzen,

- Geben Sie Ihren eigenen Datensatz mit Drag & Drop an

- ? Berechnen Sie Einbettungen

- ? Vollreste API

- ? In der Wolke laufen

- Sie können die Benutzeroberfläche auf Ihrem Desktop/Laptop ausführen, während die Engine auf einem Remote- oder Cloud -Computer ausgeführt wird

- Oder Sie können alles lokal auf einer einzigen Maschine ausführen

- ? Umwandeln Modelle über Plattformen hinweg

- Konvertieren von/nach Umarmung, MLX, GGUF

- ? Plugin -Unterstützung

- Ziehen Sie einfach aus einer Bibliothek vorhandener Plugins

- Schreiben Sie Ihre eigenen Plugins, um die Funktionalität zu erweitern

- ? Eingebetteter Monaco -Code -Editor

- Bearbeiten von Plugins und sehen Sie, was hinter den Kulissen passiert

- Sofortige Bearbeitung

- Bearbeiten von Systemmeldungen oder Eingabeaufforderung Vorlagen einfach zu bearbeiten

- Inferenzprotokolle

- Sehen Sie sich bei Inferenz oder Lappen ein Protokoll der rohen Anfragen an, die an die LLM gesendet wurden

Und Sie können das oben über eine einfache plattformübergreifende GUI durchführen.

Erste Schritte

Klicken Sie hier, um Transformator Lab herunterzuladen.

Lesen Sie diese Seite, um zu erfahren, wie Sie installieren und verwenden.

Gebaut mit

Entwickler

Gebäude von Grund auf neu

Um die App selbst zu erstellen, ziehen Sie dieses Repo und befolgen Sie die folgenden Schritte:

Verpackung für die Produktion

Um Apps für die lokale Plattform zu verpacken:

Lizenz

Unter der AGPL V3 -Lizenz verteilt. Weitere Informationen finden Sie LICENSE.txt .

Referenz

Wenn Sie Transformator Lab in Ihren Forschungen oder Anwendungen nützlich fanden, zitieren Sie bitte mit den folgenden Bibtex:

@software{transformerlab,

author = {Asaria, Ali},

title = {Transformer Lab: Experiment with Large Language Models},

month = December,

year = 2023,

url = {https://github.com/transformerlab/transformerlab-app}

}

Kontakt

- @aliasaria - Ali Asasria

- @dadmobile - Tony Salomone