Deep Learning hatte einen bemerkenswerten Erfolg in der Roboterwahrnehmung, aber seine datenzentrierte Natur leidet bei der Verallgemeinerung von sich ständig verändernden Umgebungen. Im Gegensatz dazu verallgemeinert die physikbasierte Optimierung besser, funktioniert jedoch nicht so gut in komplizierten Aufgaben aufgrund des Mangels an semantischen Informationen auf hoher Ebene und der Abhängigkeit von der manuellen parametrischen Abstimmung. Um diese beiden komplementären Welten zu nutzen, präsentieren wir PYPOSE: eine robotikorientierte , pytorchbasierte Bibliothek, die tiefgreifende Wahrnehmungsmodelle mit physikalischen Optimierungstechniken kombiniert. Unser Designziel für Pypose ist es, mit einer ordentlichen und gut organisierten Architektur benutzerfreundlich , effizient und interpretierbar zu sein. Mit einer imperativen Stiloberfläche kann sie leicht in reale Roboteranwendungen integriert werden.

SO3 , SE3 , Sim3 , RxSO3so3 , se3 , sim3 , rxso3 LTI , LTV , NLSEKF , UKF , PFEPnPLQRIMUPreintegratorGaussNewtonLevenbergMarquardtWillst du mehr Funktionen? Erstellen Sie hier ein Problem, um neue Funktionen anzufordern.

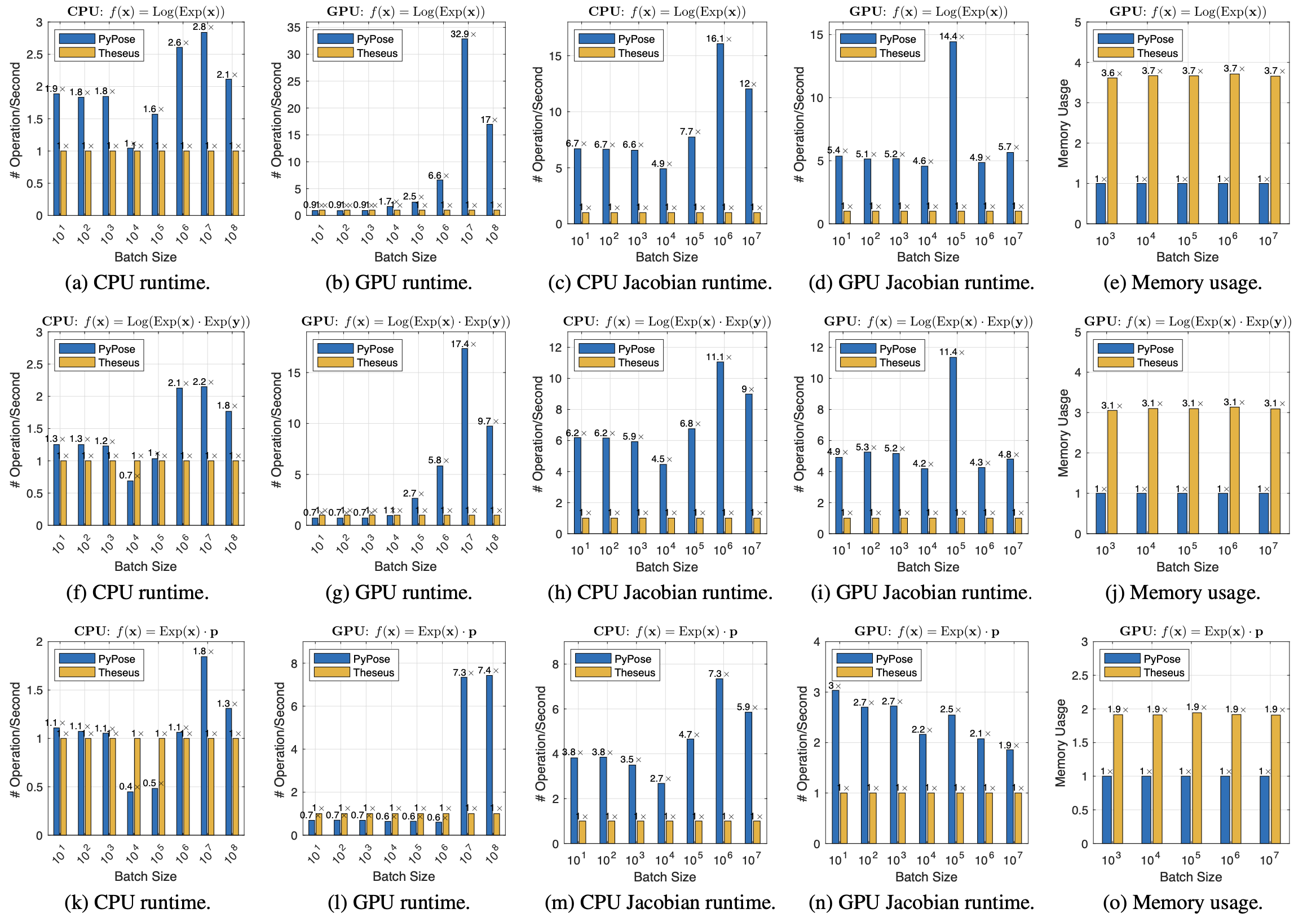

Effizienz und Gedächtnisvergleich von batchierten Lügengruppenoperationen (wir nehmen Theseus -Leistung als 1 ×).

Weitere Informationen zum Effizienzvergleich gehen für Pypose in unser Papier.

pip install pyposeInstallieren Sie bei Ubuntu, MacOS oder Windows Pytorch und fahren Sie dann aus:

pip install -r requirements/runtime.txtgit clone https://github.com/pypose/pypose.git

cd pypose && python setup.py developpytestStellen Sie sicher, dass die obige Installation korrekt ist.

Gehen Sie zu Beitrag.md

> >> import torch , pypose as pp

> >> # A random so(3) LieTensor

>> > r = pp . randn_so3 ( 2 , requires_grad = True )

so3Type LieTensor :

tensor ([[ 0.1606 , 0.0232 , - 1.5516 ],

[ - 0.0807 , - 0.7184 , - 0.1102 ]], requires_grad = True )

> >> R = r . Exp () # Equivalent to: R = pp.Exp(r)

SO3Type LieTensor :

tensor ([[ 0.0724 , 0.0104 , - 0.6995 , 0.7109 ],

[ - 0.0395 , - 0.3513 , - 0.0539 , 0.9339 ]], grad_fn = < AliasBackward0 > )

>> > p = R @ torch . randn ( 3 ) # Rotate random point

tensor ([[ 0.8045 , - 0.8555 , 0.5260 ],

[ 0.3502 , 0.8337 , 0.9154 ]], grad_fn = < ViewBackward0 > )

>> > p . sum (). backward () # Compute gradient

>> > r . grad # Print gradient

tensor ([[ - 0.7920 , - 0.9510 , 1.7110 ],

[ - 0.2659 , 0.5709 , - 0.3855 ]])scheduler bereitgestellt, von denen jede unabhängig funktionieren kann. > >> from torch import nn

> >> import torch , pypose as pp

> >> from pypose . optim import LM

> >> from pypose . optim . strategy import Constant

> >> from pypose . optim . scheduler import StopOnPlateau

> >> class InvNet ( nn . Module ):

def __init__ ( self , * dim ):

super (). __init__ ()

init = pp . randn_SE3 ( * dim )

self . pose = pp . Parameter ( init )

def forward ( self , input ):

error = ( self . pose @ input ). Log ()

return error . tensor ()

> >> device = torch . device ( "cuda" )

> >> input = pp . randn_SE3 ( 2 , 2 , device = device )

> >> invnet = InvNet ( 2 , 2 ). to ( device )

> >> strategy = Constant ( damping = 1e-4 )

> >> optimizer = LM ( invnet , strategy = strategy )

> >> scheduler = StopOnPlateau ( optimizer , steps = 10 , patience = 3 , decreasing = 1e-3 , verbose = True )

> >> # 1st option, full optimization

>> > scheduler . optimize ( input = input )

> >> # 2nd option, step optimization

>> > while scheduler . continual ():

loss = optimizer . step ( input )

scheduler . step ( loss )

> >> # Note: remove one of the above options for usage!Weitere Verwendung finden Sie unter Dokumentation. Weitere Anwendungen finden Sie unter Beispiele.

Wenn Sie PYPOSE verwenden, zitieren Sie bitte das Papier unten. Sie können es auch hier herunterladen.

@inproceedings { wang2023pypose ,

title = { {PyPose}: A Library for Robot Learning with Physics-based Optimization } ,

author = { Wang, Chen and Gao, Dasong and Xu, Kuan and Geng, Junyi and Hu, Yaoyu and Qiu, Yuheng and Li, Bowen and Yang, Fan and Moon, Brady and Pandey, Abhinav and Aryan and Xu, Jiahe and Wu, Tianhao and He, Haonan and Huang, Daning and Ren, Zhongqiang and Zhao, Shibo and Fu, Taimeng and Reddy, Pranay and Lin, Xiao and Wang, Wenshan and Shi, Jingnan and Talak, Rajat and Cao, Kun and Du, Yi and Wang, Han and Yu, Huai and Wang, Shanzhao and Chen, Siyu and Kashyap, Ananth and Bandaru, Rohan and Dantu, Karthik and Wu, Jiajun and Xie, Lihua and Carlone, Luca and Hutter, Marco and Scherer, Sebastian } ,

booktitle = { IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

year = { 2023 }

}Weitere Papiere, die Pypose beschreiben:

@inproceedings { zhan2023pypose ,

title = { {PyPose} v0.6: The Imperative Programming Interface for Robotics } ,

author = { Zitong Zhan and Xiangfu Li and Qihang Li and Haonan He and Abhinav Pandey and Haitao Xiao and Yangmengfei Xu and Xiangyu Chen and Kuan Xu and Kun Cao and Zhipeng Zhao and Zihan Wang and Huan Xu and Zihang Fang and Yutian Chen and Wentao Wang and Xu Fang and Yi Du and Tianhao Wu and Xiao Lin and Yuheng Qiu and Fan Yang and Jingnan Shi and Shaoshu Su and Yiren Lu and Taimeng Fu and Karthik Dantu and Jiajun Wu and Lihua Xie and Marco Hutter and Luca Carlone and Sebastian Scherer and Daning Huang and Yaoyu Hu and Junyi Geng and Chen Wang } ,

year = { 2023 } ,

booktitle = { IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS) Workshop } ,

}