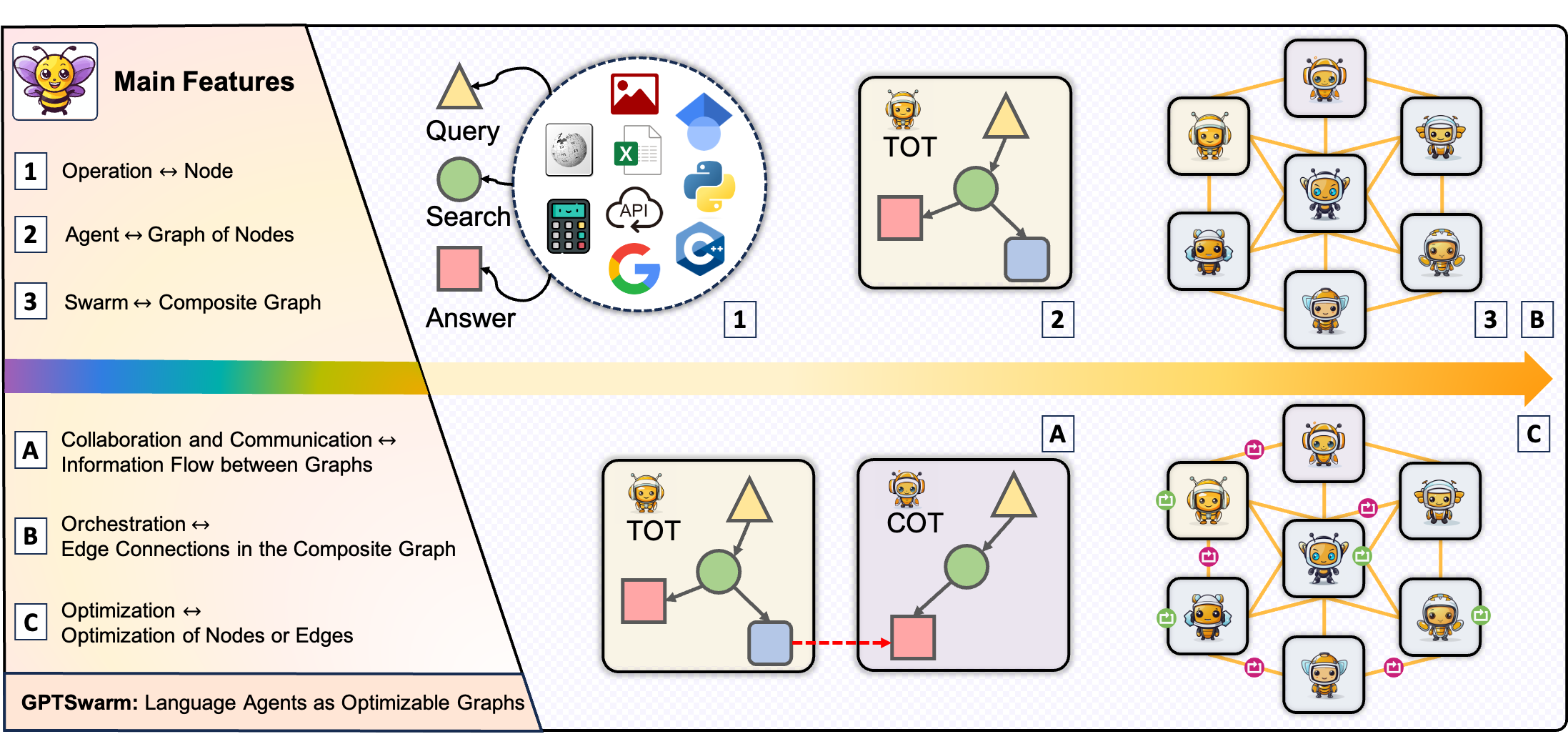

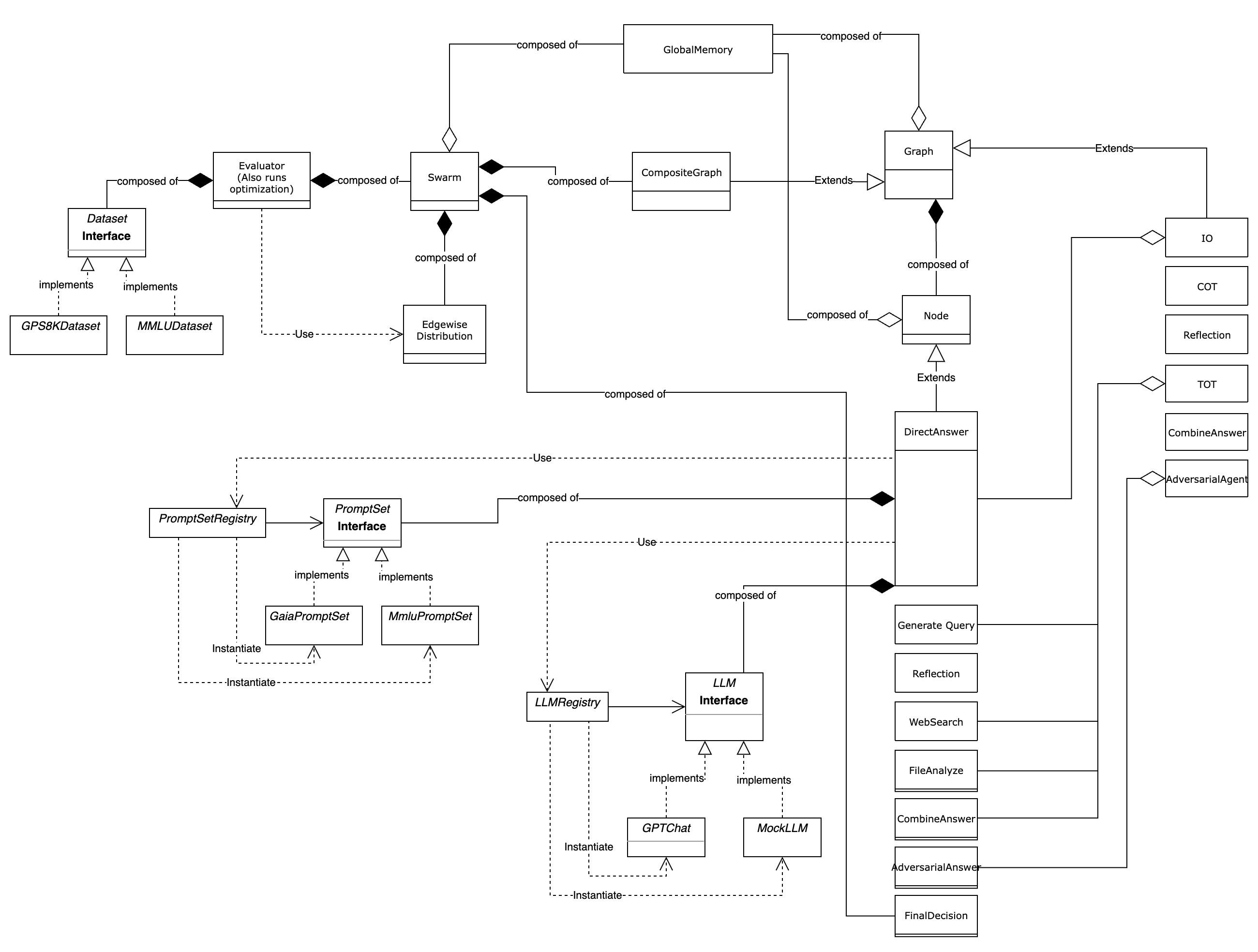

? GPTSWARM ist ein grafisches Framework für LLM-basierte Agenten, das zwei hochrangige Funktionen bietet:

Auf einer granularen Ebene ist GPTSWARM eine Bibliothek mit den folgenden Komponenten:

| Modul | Beschreibung |

|---|---|

| Schwarm. Umwelt | Domänenspezifische Operationen, Agenten, Werkzeuge und Aufgaben |

| Swarm.Graph | Graph-bezogene Funktionen zum Erstellen und Ausführen von Agentendiagramme und Swarm Composite-Diagramme |

| Swarm.llm | Schnittstelle zur Auswahl der LLM -Backends und zur Berechnung ihrer Betriebskosten |

| Swarm.Memory | Indexbasiertes Speicher |

| Swarm.Optimizer | Optimierungsalgorithmen zur Verbesserung der Agentenleistung und der Gesamtschwarm -Effizienz |

? [10/12] Respekt? Openais Schwarm, aber? GPTSWARM ist die bessere Option, wenn Sie die berücksichtigen? Swarm Intelligence ?.

[08/07] Mingchen besuchte ein eingeladenes Seminar mit Shanghai AI Lab.

[07/25] Louis und Francesco hielten die mündliche Präsentation in ICML 2024.

[07/17] Mingchen führte GPTSWARM in Meta ein.

[07/05] Mingchen hielt ein eingeladenes Gespräch mit Waic.

[06/21] Mingchen hielt ein eingeladenes Gespräch mit IA-Cas.

[06/20] Dmitrii hielt ein eingeladenes Gespräch mit Sberbank.

Sdaia lud das GPTSWARM -Team (Wenyi, Francesco, Dmitrii) für ein 5 -stündiges Seminar ein.

[06/02] GPTSWARM wurde von ICML2024 als orale Präsentation (Top 1,5%, 144 in 9.473) ausgewählt! Herzlichen Glückwunsch!

[05/01] GPTSWARM wurde von ICML2024 akzeptiert.

[04/18] Mingchen hielt das eingeladene Gespräch mit Bytedance.

[03/20] Mingchen hielt das eingeladene Gespräch mit Huawei.

[03/13] Mittr China Exklusives Interview mit Mingchen.

[03/01] GPTSWARM kann jetzt über PIP installiert werden: pip install gptswarm

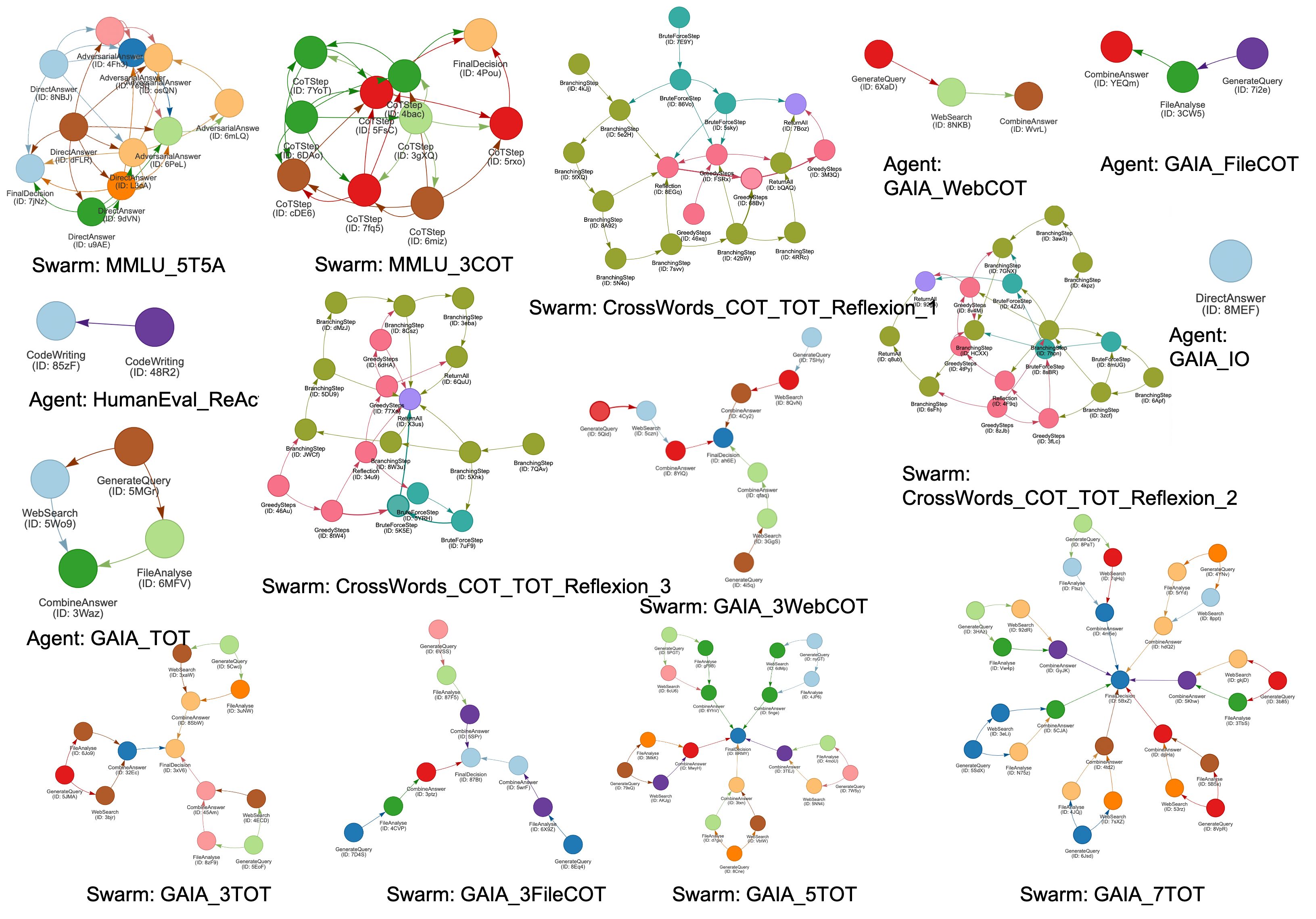

Unser akademisches Papier: Sprachagenten als optimierbare Grafiken werden veröffentlicht.

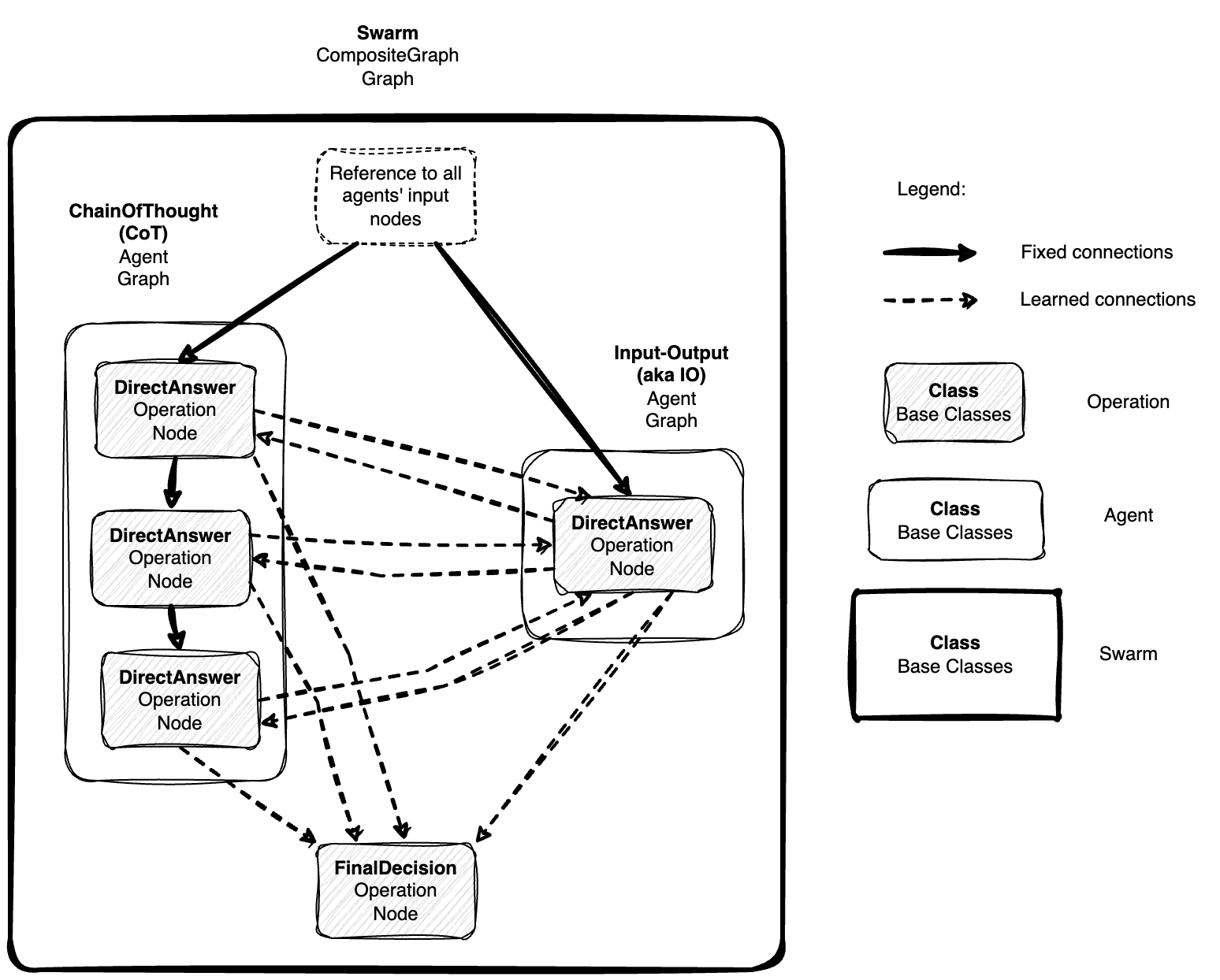

Hier ist der Edge -Optimierungsprozess, der die Kantenwahrscheinlichkeiten zur Verbesserung des Benchmark -Scores aktualisiert. Beachten Sie, dass innerhalb eines Agenten die Kanten festgelegt sind, während die Inter-Agent-Verbindungen entweder zum Randbeschnitten (Wert 0, blau) oder zur Erstellung (Wert 1, rot) optimiert werden.

Klonen Sie das Repo

git clone https://github.com/metauto-ai/GPTSwarm.git

cd GPTSwarm/Pakete installieren

conda create -n swarm python=3.10

conda activate swarm

pip install poetry

poetry install

Sie sollten API -Schlüssel in .env.template hinzufügen und seinen Namen in .env ändern

OPENAI_API_KEY = "" # for OpenAI LLM backend

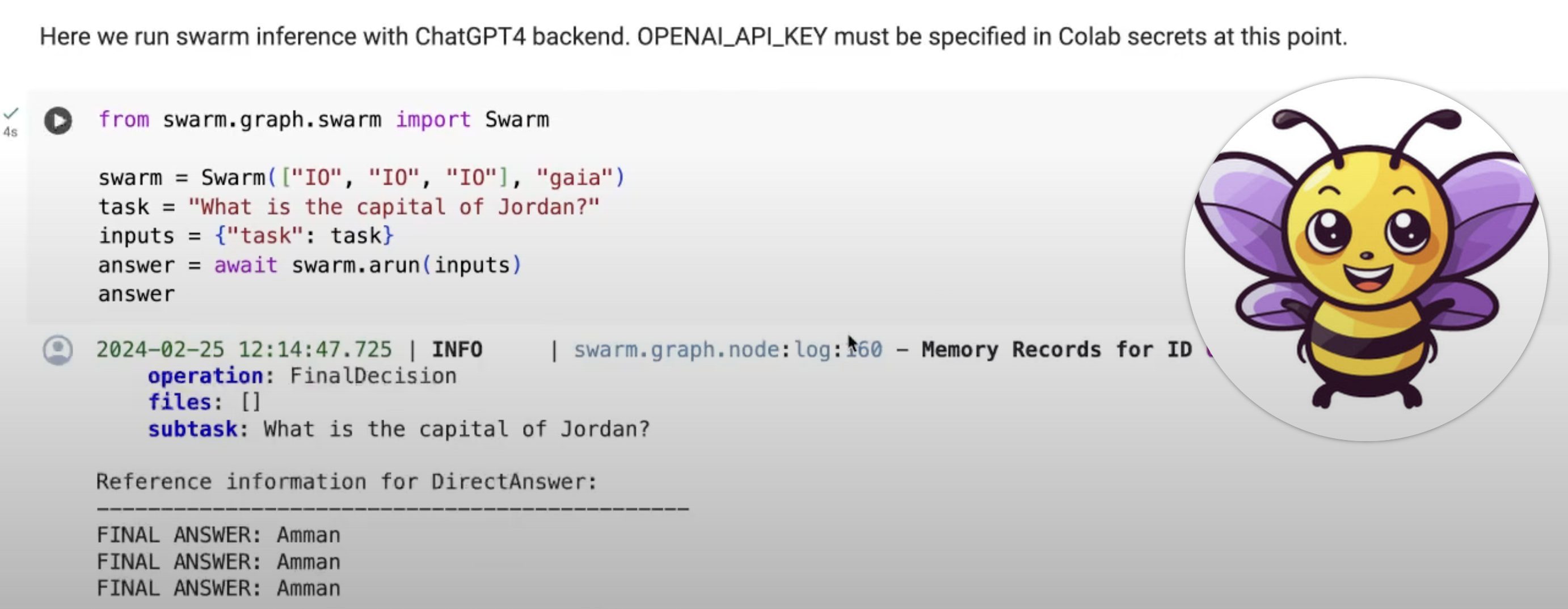

SEARCHAPI_API_KEY = "" # for Web SearchDer Einstieg mit GPTSWARM ist einfach. Führen Sie schnell einen vordefinierten Schwarm aus

from swarm . graph . swarm import Swarm

swarm = Swarm ([ "IO" , "IO" , "IO" ], "gaia" )

task = "What is the capital of Jordan?"

inputs = { "task" : task }

answer = await swarm . arun ( inputs )oder nutzen Sie Tools wie den Dateianalysator

from swarm . graph . swarm import Swarm

swarm = Swarm ([ "IO" , "TOT" ], "gaia" )

task = "Tell me more about this image and summarize it in 3 sentences."

files = [ "./datasets/demos/js.png" ]

inputs = { "task" : task , "files" : files }

danswer = swarm . run ( inputs )Schauen Sie sich hier das Beispiel für minimale Schwarm in Colab an :.

Sehen Sie, wie Sie einen benutzerdefinierten Agenten erstellen und hier einen Schwarm ausführen :.

Hier ist ein YouTube -Video zum Ausführen der Demo -Notizbücher:

In unseren Experimenten finden Sie einen weiteren Gebrauch unseres Frameworks.

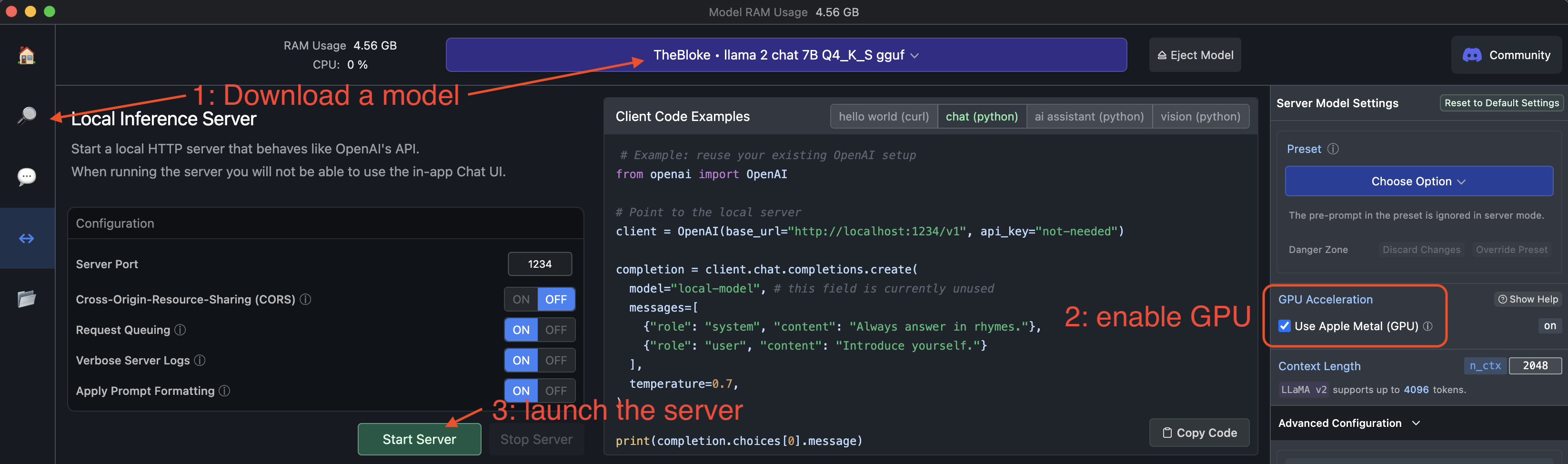

Wir unterstützen die lokale LM -Inferenz über LM Studio. Laden Sie ihre Desktop -App für Mac oder Windows herunter, wählen Sie ein Modell aus dem HuggingFace -Repository und starten Sie den Server. Verwenden Sie model_name='lmstudio' im GPTSWARM -Code, um mit dem lokalen LLM auszuführen.

Bitte lesen Sie unser Entwicklerdokument, wenn Sie an einem Beitrag interessiert sind.

Bitte zitieren Sie unser Papier, wenn Sie die Bibliothek nützlich oder interessant finden.

@inproceedings{zhugegptswarm,

title={GPTSwarm: Language Agents as Optimizable Graphs},

author={Zhuge, Mingchen and Wang, Wenyi and Kirsch, Louis and Faccio, Francesco and Khizbullin, Dmitrii and Schmidhuber, J{"u}rgen},

booktitle={Forty-first International Conference on Machine Learning}

}