近日,小米大模型團隊在音頻推理領域的研究中取得了突破性進展,成功應用強化學習算法於多模態音頻理解任務,準確率達到了64.5%,這一成就使其在國際權威的MMAU 音頻理解評測中奪得了第一名。這一成果的背後,離不開團隊對DeepSeek-R1的啟發。

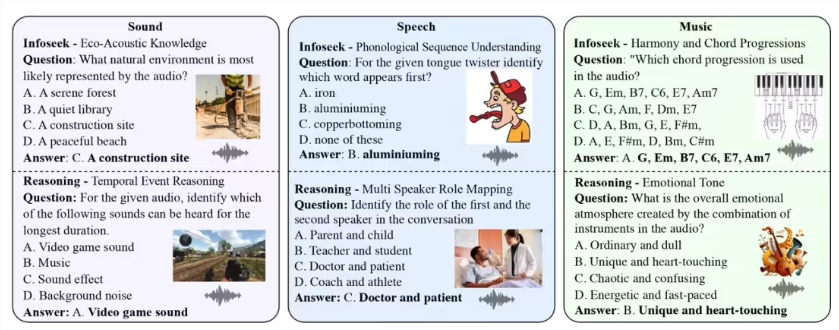

MMAU(Massive Multi-Task Audio Understanding and Reasoning)評測集是衡量音頻推理能力的重要標準,通過對包含語音、環境聲和音樂的多種音頻樣本進行分析,測試模型在復雜推理任務中的表現。人類專家的準確率為82.23%,而當前榜單上表現最好的模型是OpenAI 的GPT-4o,準確率為57.3%。在這樣的背景下,小米糰隊的成績尤為引人注目。

在團隊的實驗中,他們採用了DeepSeek-R1的Group Relative Policy Optimization(GRPO)方法,該方法通過“試錯- 獎勵” 的機制,使得模型能自主演化,展現出類似於人類的反思和推理能力。值得注意的是,在強化學習的支持下,即便只使用了3.8萬條訓練樣本,小米糰隊的模型仍然能夠在MMAU 評測集上取得64.5% 的準確率,比當前的第一名高出近10個百分點。

此外,實驗還發現,傳統的顯式思維鏈輸出方式反而會導致模型準確率下降,顯示出隱式推理在訓練中的優勢。儘管取得了顯著的成績,但小米糰隊仍然意識到,距離人類專家的水平還有一段距離。團隊表示將繼續優化強化學習策略,以期實現更好的推理能力。

這項研究的成功,不僅展示了強化學習在音頻理解領域的潛力,也為未來的智能聽覺時代鋪平了道路。隨著機器不僅能“聽見” 聲音,還能“聽懂” 其背後的因果邏輯,智能音頻技術將迎來新的發展機遇。小米糰隊還將開源訓練代碼和模型參數,以便於學術界和產業界的進一步研究與交流。

訓練代碼:https://github.com/xiaomi-research/r1-aqa

模型參數:https://huggingface.co/mispeech/r1-aqa

技術報告:https://arxiv.org/abs/2503.11197

交互Demo:https://120.48.108.147:7860/