上海人工智慧實驗室近期進行了一場別開生面的“高考”,7個AI模型,包括GPT-4o在內,接受了語文、數學和英語的全面測試,使用了全國新課標I捲和人工閱卷的方式,力求確保測試的公平公正。此測驗旨在評估AI模型在處理高考題型上的能力,並為未來AI技術發展提供參考資料。參與測試的模型涵蓋了國內外多個知名機構,展現了當前AI技術發展的不同方向和層次。

在人工智慧的世界裡,高考不再只是人類的舞台。最近,上海人工智慧實驗室用一場別開生面的“高考”,讓我們見證了AI的學術實力。他們採用了OpenCompass評測體系,讓包括GPT-4o在內的7個AI模型,接受了語文、數學和英文的全面能力測驗。

這場測驗採用的是全國新課標I卷,確保了所有參與的開源模型都是在高考前就已經開源,保證了測試的公正性。而且,這些AI的「答案」是由有高考評卷經驗的教師人工評判的,力求接近真實的閱卷標準。

參與評測的模型來自不同的背景,有法國AI新創公司Mistral開源的Mixtral8x22B對話模型,零一萬物公司的Yi-1.5-34B,智譜AI的GLM-4-9B,上海人工智慧實驗室的InternLM2 -20B-WQX,以及阿里巴巴的Qwen2系列。 GPT-4o作為閉源模型參與評測,僅作為參考。

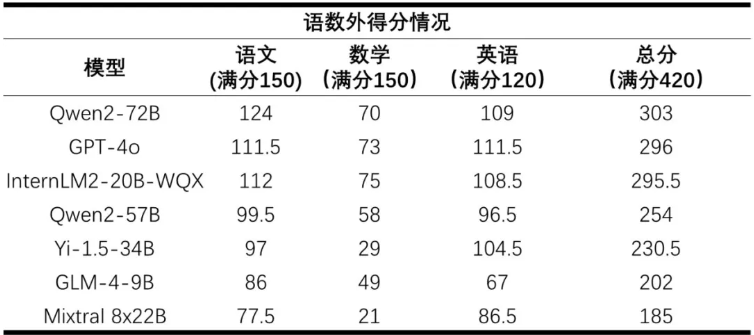

成績揭曉,Qwen2-72B以303分的總分位列第一,GPT-4o以296分緊隨其後,InternLM2-20B-WQX則以295.5分位列第三。這些模型在語文和英語科目上表現不俗,語文平均得分率達了67%,英語更是高達81%。然而,在數學科目上,所有模型的平均得分率僅為36%,顯示出AI在數學推理方面還有很大的提升空間。

閱卷教師對AI模型的答案卷進行了全面分析。在語文科目中,模型們普遍閱讀理解現代文較為得心應手,但在文言文和作文上則稍顯不足。數學方面,模型們的公式記憶能力雖強,但在解題過程中的靈活運用上仍有不足。英語科目整體表現良好,但在某些題型上,部分模型的得分率較低。

這次「大模型高考」不僅讓我們看到了AI在學術領域的潛力,也揭示了它們在理解和應用知識上的限制。隨著科技的不斷進步,我們有理由相信,未來的AI將變得更加聰明,更好地服務人類社會。

透過這次AI“高考”,我們可以清楚地看到AI技術的進步和不足,這為未來的AI發展提供了寶貴的經驗,也為我們對人工智慧的理解提供了新的視角。相信在不久的將來,AI將在更多領域展現出更強大的能力。