Das Shanghai Artificial Intelligence Laboratory führte kürzlich eine einzigartige „College Entrance Examination“ durch. Sieben KI-Modelle, darunter GPT-4o, wurden umfassenden Tests in Chinesisch, Mathematik und Englisch unterzogen, wobei der nationale neue Lehrplanstandard I und die manuelle Bewertung zum Einsatz kamen Fairness und Unparteilichkeit des Tests. Ziel dieses Tests ist es, die Fähigkeit des KI-Modells zu bewerten, Fragen zu Hochschulaufnahmeprüfungen zu bearbeiten und Referenzdaten für die zukünftige Entwicklung der KI-Technologie bereitzustellen. Die am Test teilnehmenden Modelle decken viele namhafte Institutionen im In- und Ausland ab und zeigen die unterschiedlichen Richtungen und Ebenen der aktuellen Entwicklung der KI-Technologie.

In der Welt der künstlichen Intelligenz ist die Hochschulaufnahmeprüfung nicht mehr nur eine Bühne für Menschen. Kürzlich nutzte das Shanghai Artificial Intelligence Laboratory eine einzigartige „Hochschulaufnahmeprüfung“, um uns die akademische Stärke der KI zu zeigen. Sie übernahmen das Bewertungssystem OpenCompass und unterzogen sieben KI-Modelle, darunter GPT-4o, umfassenden Eignungstests in Chinesisch, Mathematik und Englisch.

Bei diesem Test wurde Papier I des neuen nationalen Lehrplanstandards verwendet, der sicherstellte, dass alle teilnehmenden Open-Source-Modelle vor der Aufnahmeprüfung für das College Open Source waren und so die Fairness des Tests gewährleistete. Darüber hinaus werden diese KI-„Antwortbögen“ manuell von Lehrern mit Erfahrung in der Bewertung von Aufnahmeprüfungen für Hochschulen beurteilt, wobei sie bestrebt sind, den tatsächlichen Bewertungsstandards nahe zu kommen.

Die an der Evaluierung teilnehmenden Modelle haben unterschiedliche Hintergründe, darunter das Open-Source-Dialogmodell Mixtral8x22B des französischen KI-Startups Mistral, Yi-1.5-34B von Zero One Thousand Things Company, GLM-4-9B von Zhipu AI und InternLM2 von das Shanghai Artificial Intelligence Laboratory. -20B-WQX und die Qwen2-Serie von Alibaba. GPT-4o nimmt als Closed-Source-Modell an der Evaluierung teil und dient nur als Referenz.

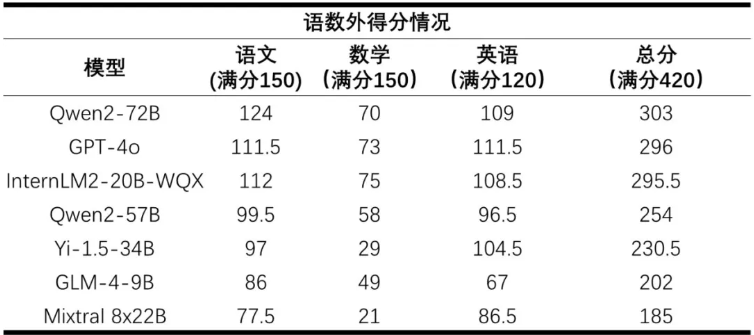

Die Ergebnisse wurden bekannt gegeben. Qwen2-72B belegte mit einer Gesamtpunktzahl von 303 Punkten den ersten Platz, gefolgt von GPT-4o mit 296 Punkten und InternLM2-20B-WQX mit 295,5 Punkten auf dem dritten Platz. Diese Modelle schnitten in den Fächern Chinesisch und Englisch gut ab, mit einer durchschnittlichen Punktzahl von 67 % in Chinesisch und 81 % in Englisch. Im Mathematikfach liegt die durchschnittliche Punktzahl aller Modelle jedoch nur bei 36 %, was zeigt, dass die KI im mathematischen Denken noch viel Raum für Verbesserungen hat.

Der Bewertungslehrer führte eine umfassende Analyse des Antwortbogens des KI-Modells durch. In den Fächern Chinesisch sind die Modelle im Allgemeinen gut darin, moderne Texte zu lesen und zu verstehen, im klassischen Chinesisch und in der Komposition weisen sie jedoch leichte Defizite auf. In Bezug auf die Mathematik verfügen die Modelle zwar über ein starkes Formelgedächtnis, es mangelt ihnen jedoch immer noch an einer flexiblen Anwendung im Problemlösungsprozess. Die Gesamtleistung im Englischfach ist gut, bei bestimmten Fragetypen weisen einige Modelle jedoch niedrigere Bewertungsquoten auf.

Diese „große Muster-Hochschulaufnahmeprüfung“ ermöglicht es uns nicht nur, das Potenzial von KI im akademischen Bereich zu erkennen, sondern zeigt auch ihre Grenzen beim Verständnis und der Anwendung von Wissen auf. Da die Technologie immer weiter voranschreitet, haben wir Grund zu der Annahme, dass KI in Zukunft intelligenter werden und der menschlichen Gesellschaft besser dienen wird.

Durch diese KI-„Hochschulaufnahmeprüfung“ können wir die Fortschritte und Mängel der KI-Technologie deutlich erkennen, was wertvolle Erfahrungen für die zukünftige KI-Entwicklung und eine neue Perspektive für unser Verständnis der künstlichen Intelligenz liefert. Man geht davon aus, dass KI in naher Zukunft in mehr Bereichen leistungsfähigere Fähigkeiten zeigen wird.