*****新:Stargan V2可在https://github.com/clovaai/stargan-v2 *****上找到

該存儲庫提供了以下論文的官方Pytorch實施:

Stargan:用於多域圖像到圖像翻譯的統一生成對抗網絡

Yunjey Choi 1,2 ,Minje Choi 1,2 ,Munyoung Kim 2,3 ,Jung-Woo HA 2 ,Sung Kim 2,4 ,Jaegul Choo 1,2

1韓國大學,Naver Corp. 2 Clova AI研究。

3新澤西學院,香港科學技術大學4

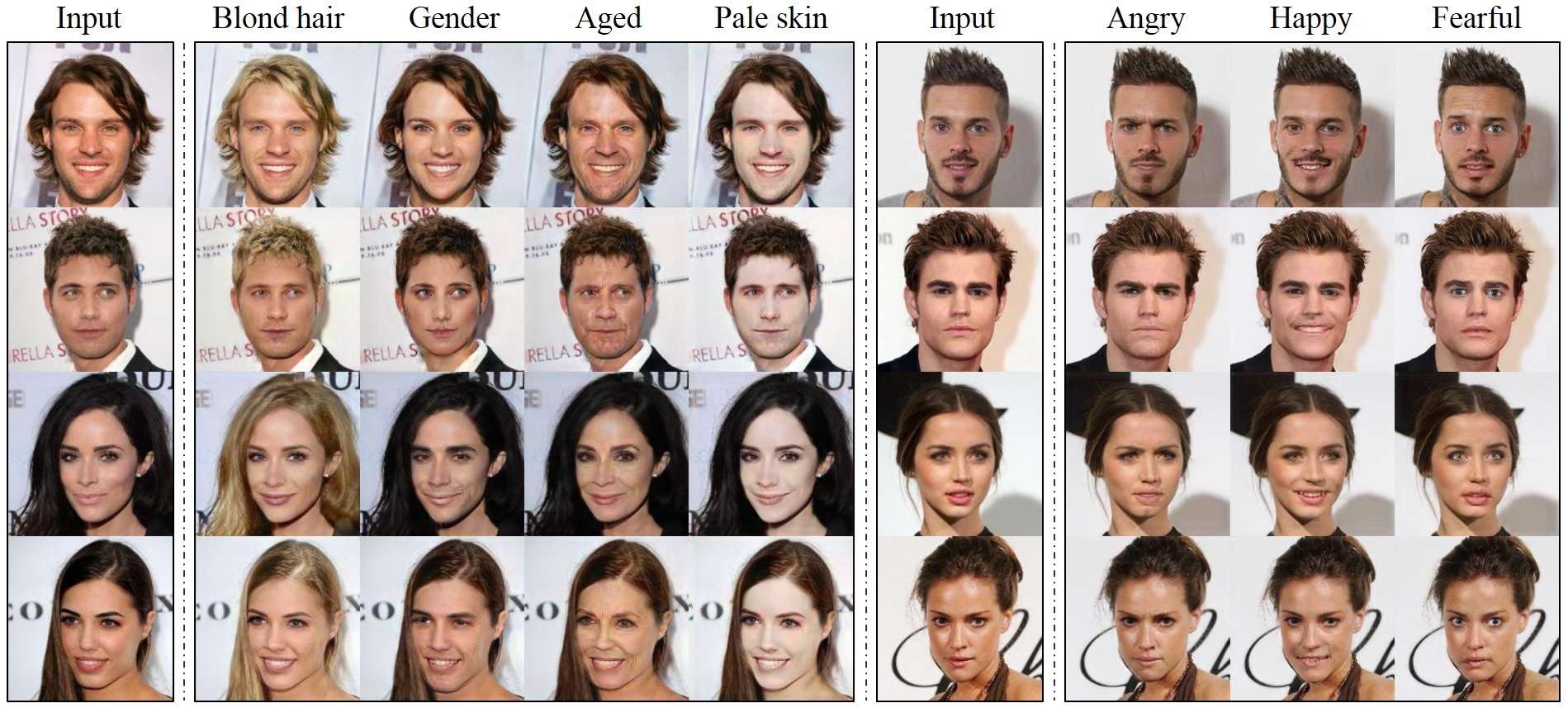

https://arxiv.org/abs/1711.09020摘要:最近的研究表明,在兩個領域的圖像到圖像翻譯方面取得了顯著成功。但是,現有方法在處理兩個以上的域時具有有限的可擴展性和魯棒性,因為應針對每對圖像域獨立構建不同的模型。為了解決此限制,我們提出了Stargan,這是一種新穎且可擴展的方法,可以僅使用單個模型對多個域進行圖像到圖像翻譯。這樣的統一模型體系結構允許同時培訓單個網絡中具有不同域的多個數據集。與現有模型相比,這導致了Stargan翻譯圖像的卓越質量,以及將輸入圖像靈活地轉換為任何所需目標域的新型能力。我們從經驗上證明了方法對面部屬性轉移和麵部表達綜合任務的有效性。

要下載Celeba數據集:

git clone https://github.com/yunjey/StarGAN.git

cd StarGAN/

bash download.sh celeba要下載RAFD數據集,您必須從Radboud Faces數據庫網站請求訪問數據集。然後,您需要如下所述創建一個文件夾結構。

要在Celeba上訓練Stargan,請在下面運行培訓腳本。請參閱此處,以獲取Celeba數據集中的可選屬性列表。如果更改selected_attrs參數,則還應相應地更改c_dim參數。

# Train StarGAN using the CelebA dataset

python main.py --mode train --dataset CelebA --image_size 128 --c_dim 5

--sample_dir stargan_celeba/samples --log_dir stargan_celeba/logs

--model_save_dir stargan_celeba/models --result_dir stargan_celeba/results

--selected_attrs Black_Hair Blond_Hair Brown_Hair Male Young

# Test StarGAN using the CelebA dataset

python main.py --mode test --dataset CelebA --image_size 128 --c_dim 5

--sample_dir stargan_celeba/samples --log_dir stargan_celeba/logs

--model_save_dir stargan_celeba/models --result_dir stargan_celeba/results

--selected_attrs Black_Hair Blond_Hair Brown_Hair Male Young在Rafd上訓練Stargan:

# Train StarGAN using the RaFD dataset

python main.py --mode train --dataset RaFD --image_size 128

--c_dim 8 --rafd_image_dir data/RaFD/train

--sample_dir stargan_rafd/samples --log_dir stargan_rafd/logs

--model_save_dir stargan_rafd/models --result_dir stargan_rafd/results

# Test StarGAN using the RaFD dataset

python main.py --mode test --dataset RaFD --image_size 128

--c_dim 8 --rafd_image_dir data/RaFD/test

--sample_dir stargan_rafd/samples --log_dir stargan_rafd/logs

--model_save_dir stargan_rafd/models --result_dir stargan_rafd/results在Celeba和Rafd上訓練Stargan:

# Train StarGAN using both CelebA and RaFD datasets

python main.py --mode=train --dataset Both --image_size 256 --c_dim 5 --c2_dim 8

--sample_dir stargan_both/samples --log_dir stargan_both/logs

--model_save_dir stargan_both/models --result_dir stargan_both/results

# Test StarGAN using both CelebA and RaFD datasets

python main.py --mode test --dataset Both --image_size 256 --c_dim 5 --c2_dim 8

--sample_dir stargan_both/samples --log_dir stargan_both/logs

--model_save_dir stargan_both/models --result_dir stargan_both/results要在您自己的數據集上訓練Stargan,請以與RAFD相同的格式創建一個文件夾結構,然後運行命令:

# Train StarGAN on custom datasets

python main.py --mode train --dataset RaFD --rafd_crop_size CROP_SIZE --image_size IMG_SIZE

--c_dim LABEL_DIM --rafd_image_dir TRAIN_IMG_DIR

--sample_dir stargan_custom/samples --log_dir stargan_custom/logs

--model_save_dir stargan_custom/models --result_dir stargan_custom/results

# Test StarGAN on custom datasets

python main.py --mode test --dataset RaFD --rafd_crop_size CROP_SIZE --image_size IMG_SIZE

--c_dim LABEL_DIM --rafd_image_dir TEST_IMG_DIR

--sample_dir stargan_custom/samples --log_dir stargan_custom/logs

--model_save_dir stargan_custom/models --result_dir stargan_custom/results要下載預訓練的模型檢查點,請在下面運行腳本。預先訓練的模型檢查點將下載並保存到./stargan_celeba_128/models目錄中。

$ bash download.sh pretrained-celeba-128x128要使用預訓練模型翻譯圖像,請在下面運行評估腳本。翻譯的圖像將保存到./stargan_celeba_128/results目錄中。

$ python main.py --mode test --dataset CelebA --image_size 128 --c_dim 5

--selected_attrs Black_Hair Blond_Hair Brown_Hair Male Young

--model_save_dir= ' stargan_celeba_128/models '

--result_dir= ' stargan_celeba_128/results ' 如果您發現這項工作對您的研究有用,請引用我們的論文:

@inproceedings{choi2018stargan,

author={Yunjey Choi and Minje Choi and Munyoung Kim and Jung-Woo Ha and Sunghun Kim and Jaegul Choo},

title={StarGAN: Unified Generative Adversarial Networks for Multi-Domain Image-to-Image Translation},

booktitle={Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition},

year={2018}

}

這項工作主要是在第一作者在Naver的Clova AI Research進行研究實習時完成的。我們感謝Naver的所有研究人員,尤其是Donghyun Kwak的所有研究人員,都進行了深刻的討論。