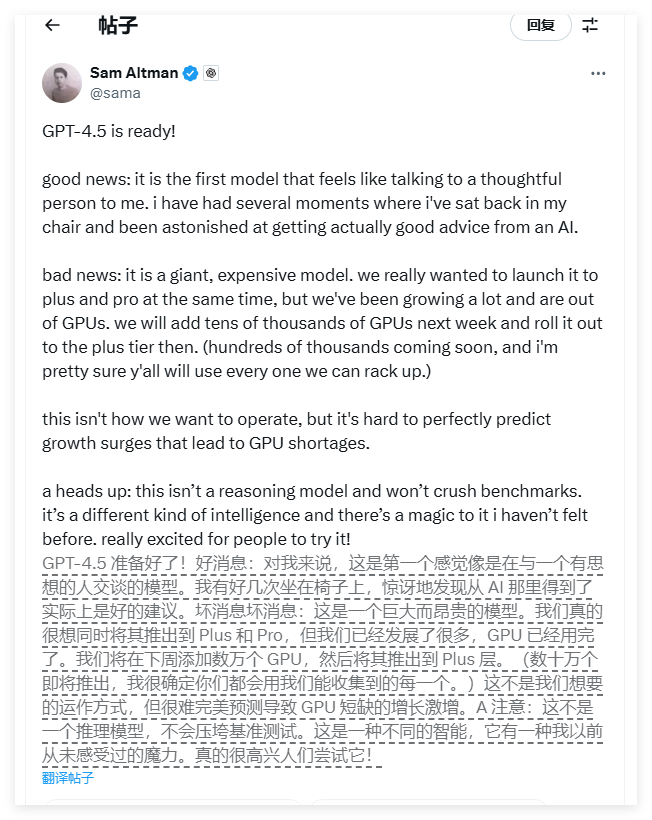

近日,OpenAI 的首席执行官山姆・阿尔特曼(Sam Altman)在社交平台 X 上发布了一条重要声明,宣布由于公司 GPU 资源耗尽,最新的人工智能模型 GPT-4.5 将不得不采取分阶段发布的方式。阿尔特曼解释说,GPT-4.5 的规模庞大且成本极高,需要“成千上万”的 GPU 才能支持更多用户接入该模型。这一消息引发了广泛关注,尤其是对人工智能领域感兴趣的用户和开发者。

根据阿尔特曼的声明,GPT-4.5 将首先向 ChatGPT Pro 的订阅用户开放,预计于本周四正式启动。随后,ChatGPT Plus 用户将在下周获得访问权限。这种分阶段的发布策略旨在缓解当前 GPU 资源紧张的问题,确保用户能够逐步体验到这一先进的人工智能模型。OpenAI 希望通过这种方式,既能满足用户需求,又能有效管理资源。

阿尔特曼还透露,GPT-4.5 的使用成本相当高昂。OpenAI 将对输入的每百万个 token(约 750,000 个单词)收取 75 美元,对输出的每百万个 token 收取 150 美元。这一收费标准分别是 OpenAI 之前主力产品 GPT-4o 的输入成本的 30 倍和输出成本的 15 倍。这一价格政策引发了用户的广泛讨论,许多人认为其费用水平过高,可能会限制普通用户的使用。

在声明中,阿尔特曼进一步解释道:“我们的发展速度非常快,目前已经耗尽了 GPU 资源。我们计划在下周增加成千上万的 GPU,并随后将其推广到 Plus 层用户。这并不是我们想要的运营模式,但很难准确预测导致 GPU 短缺的增长潮。”他还提到,OpenAI 一直面临计算能力不足的问题,未来计划通过研发自有的 AI 芯片及建立大型数据中心来应对这一挑战。

总的来说,OpenAI 的 GPT-4.5 发布计划反映了人工智能领域在资源管理和技术发展方面的复杂性。尽管面临 GPU 资源短缺和高昂成本的挑战,OpenAI 仍然致力于为用户提供最先进的人工智能体验。未来,随着自有 AI 芯片的研发和数据中心的建设,OpenAI 有望进一步解决计算能力不足的问题,推动人工智能技术的持续发展。