香港中文大学(深圳)与深圳大数据研究院的研究团队近日推出了一款名为HuatuoGPT-o1的医疗大型语言模型(LLM),这一创新成果标志着医疗AI领域在复杂推理方面迈出了重要一步。该模型专为医疗领域的复杂推理而设计,旨在提升医疗诊断和决策的准确性和可靠性。与以往侧重于数学推理的LLM不同,HuatuoGPT-o1专注于医疗这一特殊领域,通过模拟医生在实际工作中的严谨思考过程,为医疗AI的发展开辟了新的道路。

研究团队在开发过程中面临的主要挑战是医疗领域的推理过程往往缺乏明确的步骤,难以验证。为了解决这一难题,他们从医疗考试题库中精选出4万道具有唯一、客观正确答案的难题,并将其转化为开放式问题,构建了一个可验证的医疗问题集。这些问题不仅需要模型进行深入的推理,还能通过答案的对错来验证推理过程的正确性,从而为模型的训练提供了可靠的数据支持。

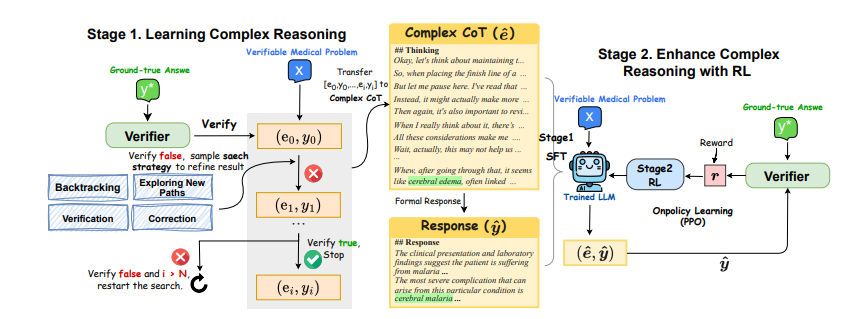

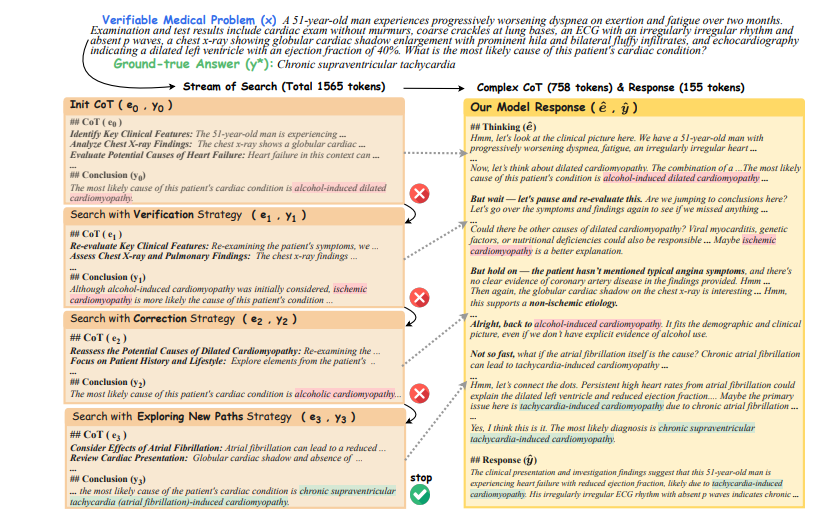

为了提升模型的推理能力,研究团队采用了一种两阶段训练方法。在第一阶段,他们利用验证器的反馈(正确或错误)来引导模型进行基于策略的搜索,生成复杂的推理轨迹。模型首先初始化一个思维链(CoT),如果验证器认为当前的CoT不正确,模型会尝试回溯、探索新路径、验证或纠正等策略,直到找到正确的答案。这些成功的推理轨迹随后被用来微调LLM,使其具备迭代反思的复杂推理能力。在第二阶段,研究团队利用验证器提供的稀疏奖励,通过强化学习(RL)算法进一步提升模型的复杂推理能力。

实验结果表明,这种两阶段训练方法取得了显著的效果。仅使用4万个可验证的问题,一个80亿参数的模型在医疗基准测试中取得了8.5分的提升。而一个700亿参数的模型在多个医疗基准测试中,也超越了其他开源的通用和医疗专用LLM。这些结果不仅证实了复杂推理对解决医疗问题的有效性,也展示了强化学习在提升模型性能方面的显著作用。

HuatuoGPT-o1的创新之处在于它首次使用可验证的医疗问题和医疗验证器来提升LLM的医疗复杂推理能力。通过这种方法,模型能够像医生一样进行深入思考,并在给出答案前进行自我检查和修正。这不仅提高了模型在医疗领域的应用潜力,也为其他专业领域的推理能力提升提供了借鉴。

为了进一步验证模型的可靠性,研究人员使用GPT-4o作为验证器,结果显示其在第一阶段的准确率达到96.5%,在第二阶段的准确率达到94.5%。同时,他们也证实了基于LLM的验证器比传统的精确匹配方法更可靠。此外,研究人员还将该方法应用到中文医疗领域,同样取得了显著的成果,证明了该方法在不同领域和语言环境下的适应性。

总体而言,HuatuoGPT-o1的出现标志着医疗AI在复杂推理方面取得了重大进展。它不仅为医疗诊断和决策提供了更可靠的工具,也为未来AI在其他专业领域的应用提供了新的思路。尽管该模型目前仍处于研究阶段,不能直接应用于临床,但其巨大的潜力已引起了广泛关注,未来有望在医疗领域发挥更大的作用。

论文地址:https://arxiv.org/pdf/2412.18925