香港の中国大学(深Shenzhen)と深Shenzhenビッグデータリサーチインスティテュートは、最近、Huatuogpt-O1と呼ばれる医療大規模な言語モデル(LLM)を立ち上げました。重要なステップ。医療分野での複雑な推論のために設計されたこのモデルは、医療診断と意思決定の正確性と信頼性を改善することを目的としています。過去の数学的推論に焦点を当てたLLMとは異なり、Huatuogpt-O1は医療の特別な分野に焦点を当てており、実際の仕事で医師の厳格な思考プロセスをシミュレートすることにより、医療AIの開発のための新しい道を開きました。

開発プロセスで研究チームが直面している主な課題は、医療分野の推論プロセスに明確なステップが欠けており、検証が困難であることが多いことです。この問題を解決するために、彼らは健康診断銀行からのユニークで客観的な正解で40,000の困難な質問を選択し、それらを自由な質問に変えて検証可能な一連の医学的質問を構築しました。これらの質問は、モデルが詳細な推論を実施するだけでなく、正しい回答または間違った回答を通じて推論プロセスの正しさを検証する必要があるため、モデルトレーニングの信頼できるデータサポートを提供します。

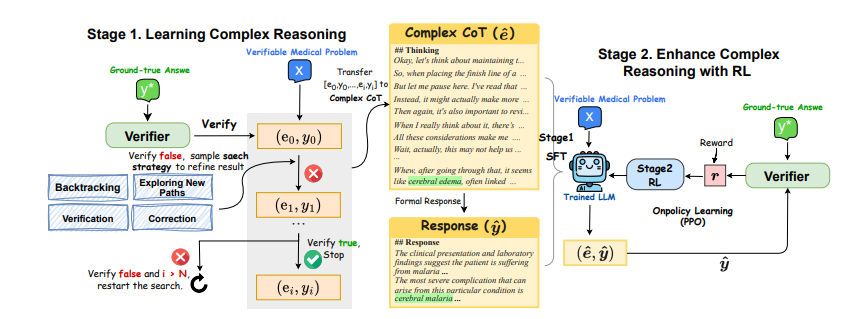

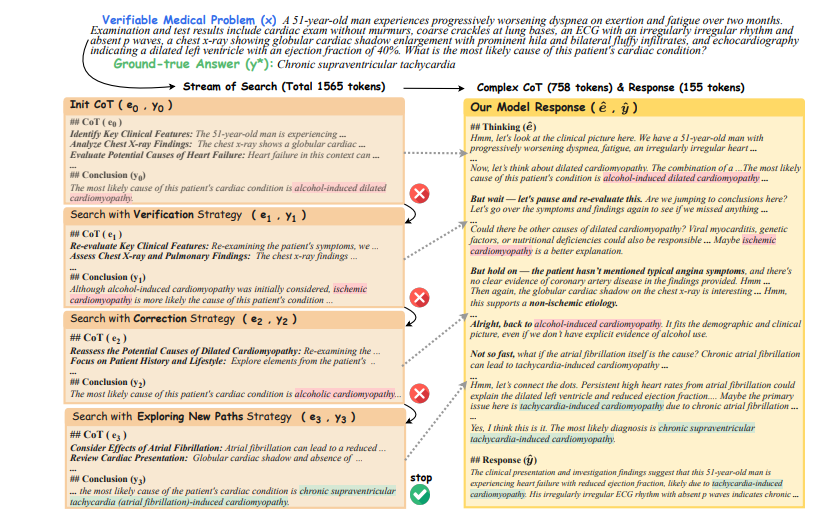

モデルの推論能力を向上させるために、研究チームは2段階のトレーニング方法を採用しました。第1フェーズでは、バリデーターフィードバック(正しいか間違っているか)を利用して、ポリシーベースの検索のモデルをガイドし、複雑な推論軌跡を生成します。モデルは最初に思考チェーン(COT)を初期化します。バリデーターは、現在のCOTが正しくないと考えています。次に、これらの成功した推論の軌跡を使用して、LLMを微調整して、反復的反射の複雑な推論能力を与えます。第2フェーズでは、研究チームは、補強学習(RL)アルゴリズムを通じて、モデルの複雑な推論能力をさらに改善するために、バリエーターが提供するまばらな報酬を使用しました。

実験結果は、この2段階のトレーニング方法が重要な結果を達成したことを示しています。わずか40,000の検証可能な質問を使用して、80億パラメーターを持つモデルは、医療ベンチマークの8.5ポイントの増加を達成しました。 700億パラメーターモデルは、複数の医療ベンチマークで他のオープンソースの一般的および医療固有のLLMを上回ります。これらの結果は、医学的問題を解決する際の複雑な推論の有効性を確認するだけでなく、モデルのパフォーマンスの向上における強化学習の重要な役割も示しています。

Huatuogpt-O1は、検証可能な医学的問題と医療バリデーターを初めて使用して、LLMの医療複合体の推論能力を高めるという点で革新的です。このアプローチを使用すると、モデルは医師のように深く考え、回答をする前に自己検査と修正を行うことができます。これにより、医療分野でのモデルの応用の可能性が向上するだけでなく、他の専門分野での推論能力を改善するための参照も提供します。

モデルの信頼性をさらに検証するために、研究者はGPT-4Oをバリデーターとして使用し、結果は、その精度が第1フェーズで96.5%、第2フェーズで94.5%に達したことを示しました。同時に、彼らはまた、LLMベースのバリデーターが従来の正確な一致方法よりも信頼性が高いことを確認しました。さらに、研究者はこの方法を中国の医療分野に適用し、驚くべき結果を達成し、さまざまな分野や言語環境での方法の適応性を実証しました。

全体として、Huatuogpt-O1の出現は、複雑な推論における医療AIの大きな進歩を示しています。医療診断と意思決定のためのより信頼性の高いツールを提供するだけでなく、他の専門分野でのAIの将来の適用に関する新しいアイデアも提供します。このモデルはまだ研究段階にあり、臨床診療に直接適用することはできませんが、その大きな可能性は広範囲にわたる注目を集めており、将来医療分野でより大きな役割を果たすことが期待されています。

紙の住所:https://arxiv.org/pdf/2412.18925