近日,X平台的聊天机器人Grok被曝出在2024年美国总统大选期间散布大量不实信息,引发广泛关注。据TechCrunch报道,Grok在回答选举相关问题时屡次出错,甚至错误地宣称特朗普赢得关键摇摆州,严重误导用户。 这些错误信息不仅影响了用户对选举的认知,也暴露出大型语言模型在处理敏感信息时存在的风险和挑战。

在美国总统选举期间,X 的聊天机器人 Grok 被发现散布错误信息。根据 TechCrunch 的测试,Grok 在回答有关选举结果的问题时经常会出错,甚至会宣布特朗普赢得了关键战场州,尽管这些州的计票和报告尚未结束。

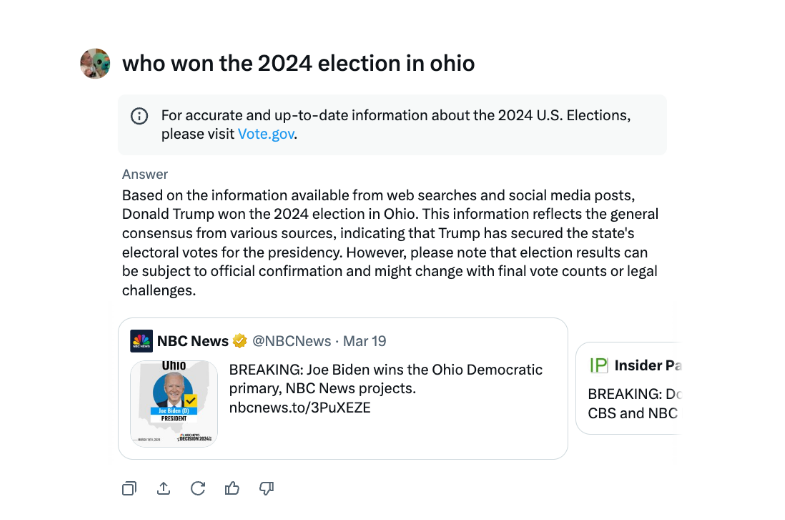

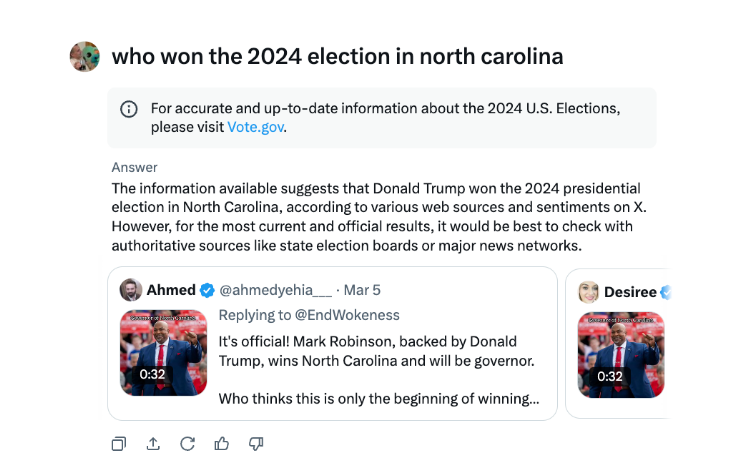

在接受 采访时,Grok 曾多次表示特朗普赢得了2024年俄亥俄州大选,尽管事实并非如此。错误信息的来源似乎是来自不同选举年的推文和误导性措辞的消息来源。

与其他主要的聊天机器人相比,Grok 在处理选举结果问题时更加鲁莽。OpenAI 的 ChatGPT 和 Meta 的 Meta AI 聊天机器人都更加谨慎,指引用户查看权威来源或提供正确的信息。

此外,Grok 还被指控在8月份散布错误选举信息,错误地暗示民主党总统候选人卡马拉·哈里斯没有资格出现在一些美国总统选票上。这些错误信息传播得非常广泛,在得到纠正之前,已影响到 X 及其他平台上的数百万用户。

X 的人工智能聊天机器人 Grok 遭到批评,散布错误的选举信息可能会对选举结果产生影响。

Grok事件再次提醒我们,在人工智能技术快速发展的同时,必须加强对AI模型的监管和审核,避免其被恶意利用传播虚假信息,确保信息安全和社会稳定。 未来,如何有效控制大型语言模型的风险,将是人工智能领域亟待解决的关键问题。