该仓库是LTSF线性的官方Pytorch实施:“变形金刚有效的时间序列预测?”。

[2024/01/28]我们的模型已包含在神经Forecast中。特别感谢撰稿人@cchallu!

[2022/11/23]接受了三个强项接受AAAI 2023!我们还发布了长期时间序列的基准预测,以进行进一步研究。

[2022/08/25]我们对论文进行了全面的分析,以了解为什么现有的LTSF-Transformers在LTSF问题上无法正常工作!

[2022/08/25]除了dlinear,我们很高兴在纸张和该仓库中添加两个线性模型。现在我们有一个LTSF线性家庭!

[2022/08/25]我们更新了LTSF-Linear的一些脚本。

除LTSF线性外,我们还提供了五个重要的预测变压器,以重新实现本文中的结果。

我们在./scripts中提供所有实验脚本文件:

| 文件 | 解释 |

|---|---|

| exp-longforecasting | 长期时间序列预测任务 |

| Exp-lookbackwindow | 研究不同的外观窗口尺寸的影响 |

| 展示 | 研究不同嵌入策略的影响 |

此代码只是基于自动配置器的代码库构建。我们非常感谢以下GitHub存储库的宝贵代码库或数据集:

AutoFormer,Informer和Transferer的实现来自https://github.com/thuml/autoformer

FedFormer的实现来自https://github.com/maziqing/fedformer

pyraformer的实现来自https://github.com/alipay/pyraformer

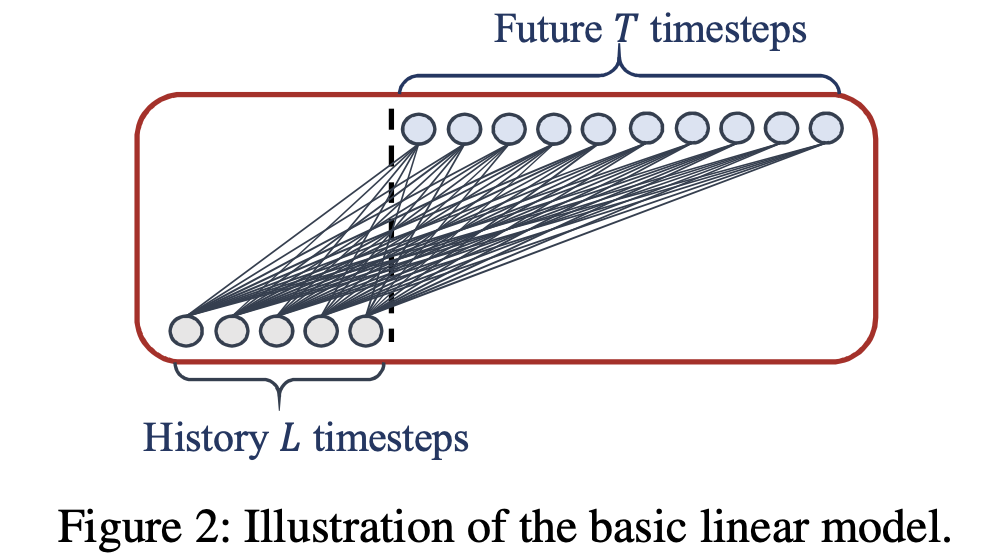

LTSF线性是一组线性模型。

LTSF线性是一组线性模型。

尽管LTSF线性很简单,但它具有一些令人信服的特征:

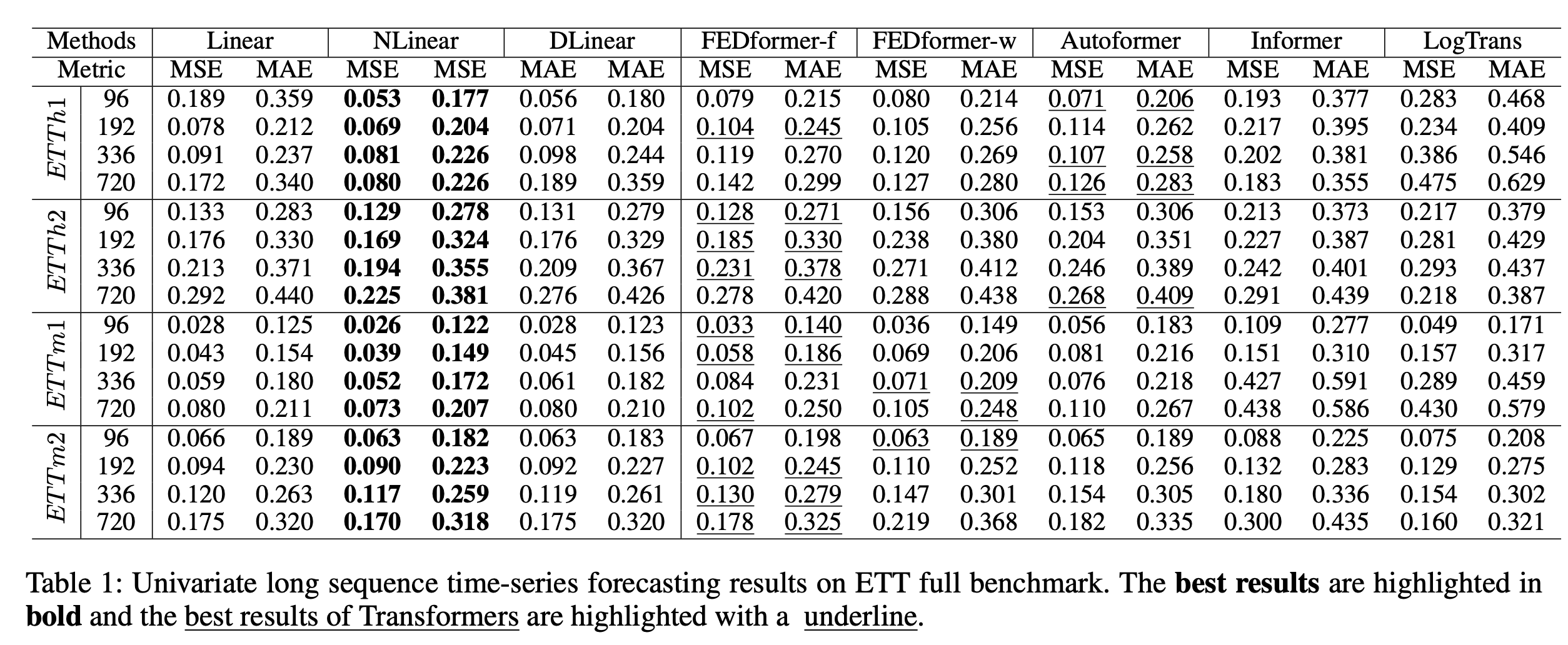

单变量预测: 多元预测:

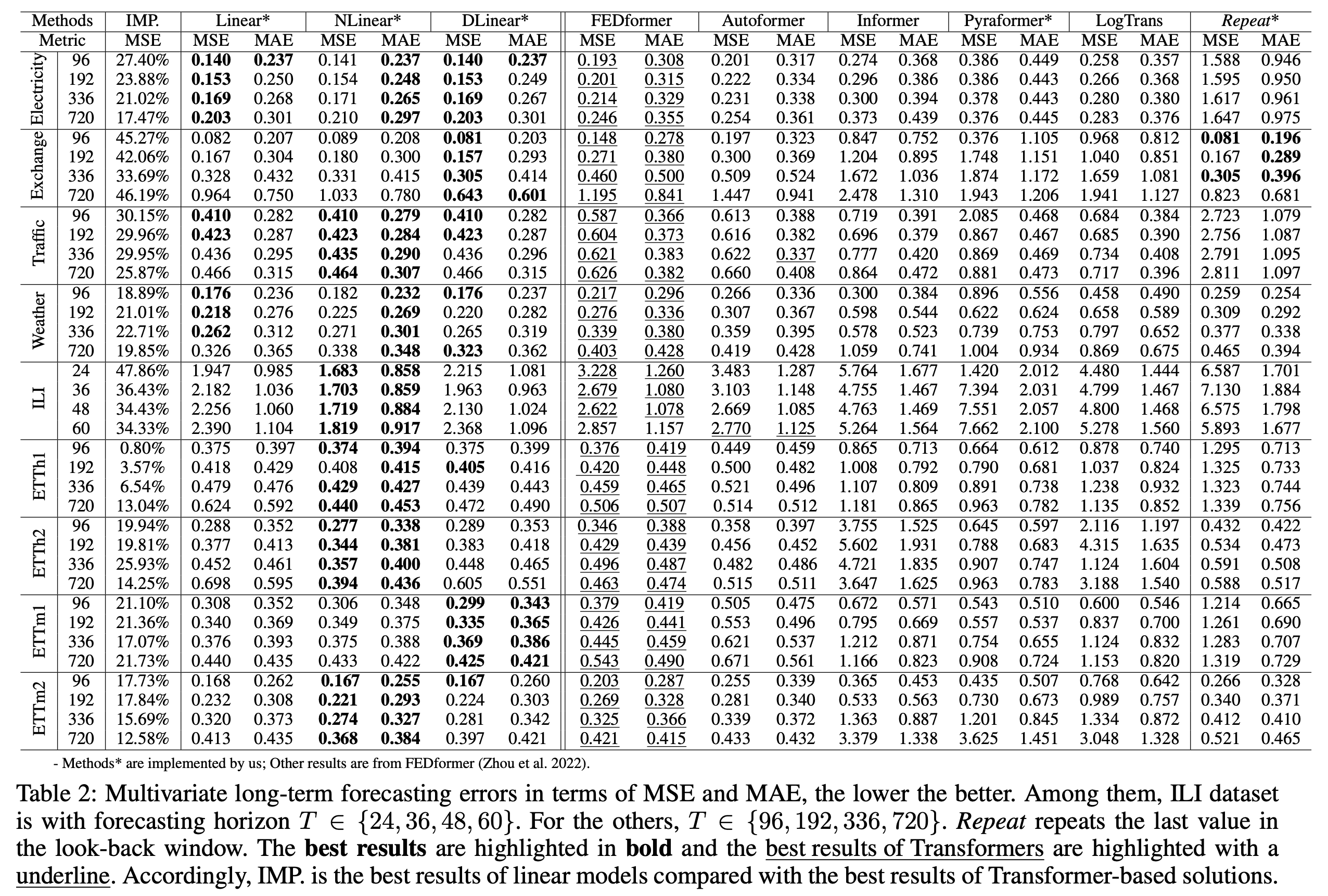

多元预测: LTSF线性的表现优于所有基于变压器的方法的大幅度。

LTSF线性的表现优于所有基于变压器的方法的大幅度。

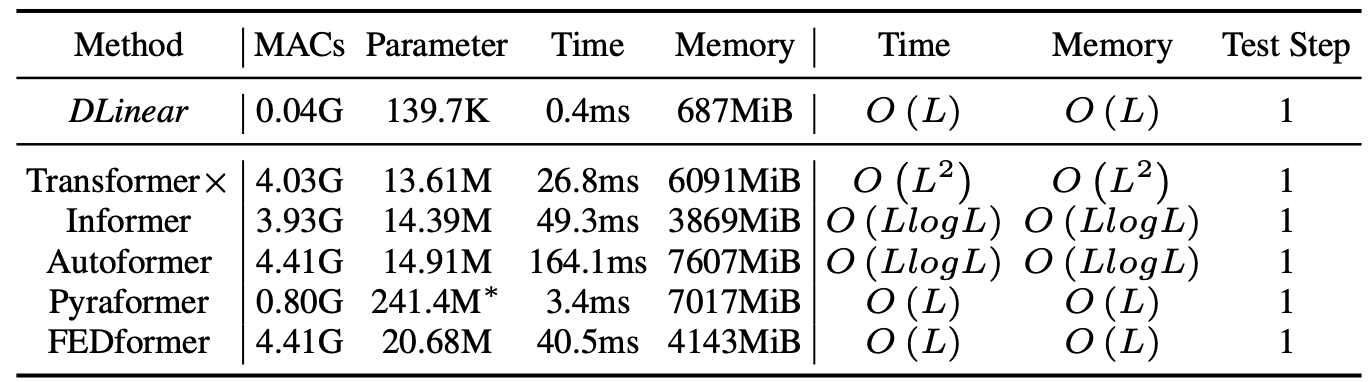

将方法效率与外观背面窗口尺寸96和预测步骤720进行比较。 MAC是多功能操作的数量。我们使用dlinear进行比较,因为它在LTSF线性中具有双重成本。推理时间平均为5。

将方法效率与外观背面窗口尺寸96和预测步骤720进行比较。 MAC是多功能操作的数量。我们使用dlinear进行比较,因为它在LTSF线性中具有双重成本。推理时间平均为5。

首先,请确保您已经安装了Conda。然后,我们的环境可以通过:

conda create -n LTSF_Linear python=3.6.9

conda activate LTSF_Linear

pip install -r requirements.txt

您可以从AutoFormer提供的Google Drive获得所有9个基准。所有数据集都是经过精心处理的,可以轻松使用。

mkdir dataset

请将它们放在./dataset目录中

scripts/中,我们提供模型实现dlinear/autoFormer/Informer/TransfererFEDformer/scripts/ ,我们提供FedFormer实施Pyraformer/scripts/ ,我们提供了pyraformer实现例如:

要在Exchange-rate数据集上训练LTSF线性,您可以使用脚本scripts/EXP-LongForecasting/Linear/exchange_rate.sh :

sh scripts/EXP-LongForecasting/Linear/exchange_rate.sh

默认情况下,它将开始训练dlinear,结果将显示在logs/LongForecasting中。您可以在脚本中指定模型的名称。 (线性,dlinear,nlinear)

所有有关在长期预测任务上使用ltsf linear的脚本都是在scripts/EXP-LongForecasting/Linear/中,您可以以类似的方式运行它们。脚本中的默认外观窗口为336,LTSF线性通常可以通过纸张中的较长的外观窗口获得更好的结果。

关于外观背回窗口大小以及对FedFormer和pyraformer的长期预测的脚本分别在FEDformer/scripts和Pyraformer/scripts中。要运行它们,您需要首先使用cd FEDformer或cd Pyraformer 。然后,您可以使用SH以类似的方式运行它们。日志将存储在logs/中。

scripts/EXP-LongForecasting/Linear/ the 5min-20min中的每个实验。对于其他变压器脚本,由于我们将所有相关实验放在一个脚本文件中,因此直接运行它们将每天需要8个小时。您可以保持您感兴趣的实验并对其他人发表评论。

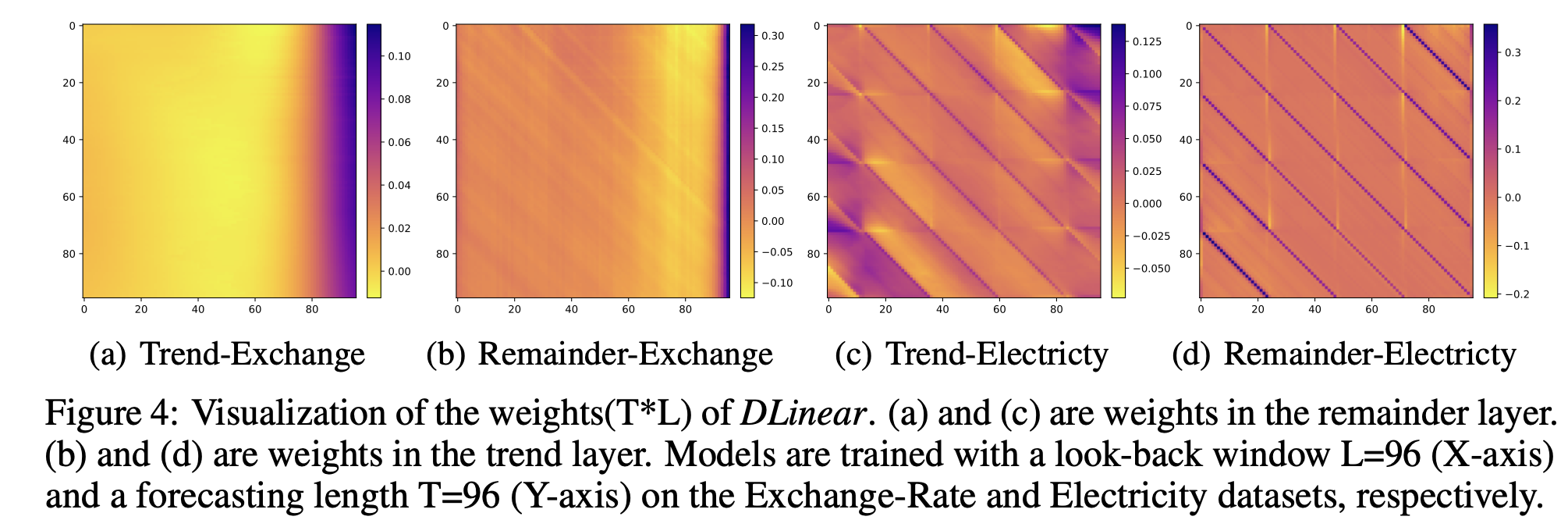

如我们的论文所示,LTSF线性的权重可以揭示数据的某些特征,即周期性。例如,我们提供了weight_plot.py中dlinear的重量可视化。要运行可视化,您需要输入dlinear的模型路径(model_name)(默认情况下为./checkpoint中的模型目录)。为了获得平滑清晰的模式,您可以使用我们在线性模型文件中提供的初始化。

如果您发现此存储库对您的工作有用,请考虑以下内容:

@inproceedings { Zeng2022AreTE ,

title = { Are Transformers Effective for Time Series Forecasting? } ,

author = { Ailing Zeng and Muxi Chen and Lei Zhang and Qiang Xu } ,

journal = { Proceedings of the AAAI Conference on Artificial Intelligence } ,

year = { 2023 }

}请记住,如果您在实验中使用了所有数据集并比较所有数据集。