ในช่วงไม่กี่ปีที่ผ่านมาด้วยการพัฒนาแบบจำลองภาษาขนาดใหญ่อย่างรวดเร็วโมเดลการเพิ่มประสิทธิภาพการอนุมานได้ก่อให้เกิดการอภิปรายอย่างกว้างขวางเกี่ยวกับอัตราการเกิดภาพหลอนของพวกเขาในขณะที่ปรับปรุงความสามารถในการประมวลผลของงานที่ซับซ้อน เมื่อเร็ว ๆ นี้ทีมงานการเรียนรู้ของเครื่อง Vectara ได้ทำการศึกษาเชิงลึกของโมเดล Deepseek Series ซึ่งเผยให้เห็นความแตกต่างอย่างมีนัยสำคัญในรูปแบบการเพิ่มการอนุมานในแง่ของอัตราการเกิดภาพหลอน

เมื่อเร็ว ๆ นี้ทีมงานการเรียนรู้ของ Vectara ได้ทำการทดสอบภาพหลอนเชิงลึกในซีรีย์ Deepseek สองรุ่น v3. สิ่งนี้ชี้ให้เห็นว่า Deepseek-R1 สร้างความไม่ถูกต้องหรือไม่สอดคล้องกับข้อมูลดั้งเดิมในระหว่างกระบวนการเพิ่มการใช้เหตุผล ผลลัพธ์นี้ทำให้เกิดการอภิปรายอย่างกว้างขวางเกี่ยวกับอัตราการเกิดภาพหลอนของแบบจำลองภาษาขนาดใหญ่ที่เพิ่มการอนุมาน (LLM)

หมายเหตุแหล่งที่มาของภาพ: ภาพถูกสร้างขึ้นโดย AI และผู้ให้บริการที่ได้รับอนุญาตภาพ Midjourney

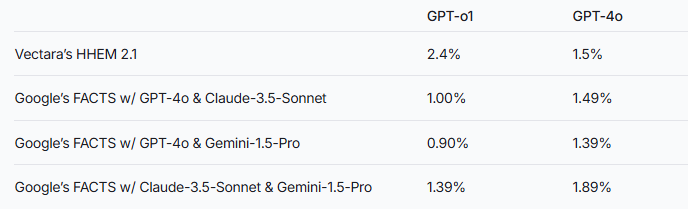

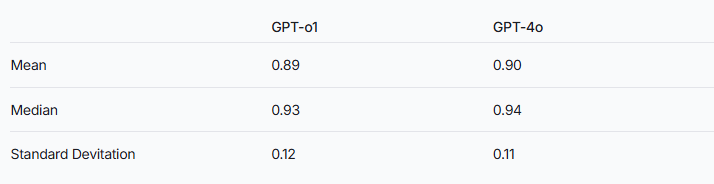

ทีมวิจัยชี้ให้เห็นว่ารูปแบบการเสริมการอนุมานอาจมีแนวโน้มที่จะเกิดภาพหลอนมากกว่าแบบจำลองภาษาขนาดใหญ่ทั่วไป ปรากฏการณ์นี้เห็นได้ชัดโดยเฉพาะอย่างยิ่งในการเปรียบเทียบซีรี่ส์ Deepseek กับแบบจำลองการปรับปรุงการอนุมานอื่น ๆ ตัวอย่าง GPT เป็นตัวอย่างความแตกต่างในอัตราการเกิดภาพหลอนระหว่าง GPT-O1 ที่เพิ่มขึ้นด้วยเหตุผลและ GPT-4O เวอร์ชันปกติยังตรวจสอบการเก็งกำไรนี้

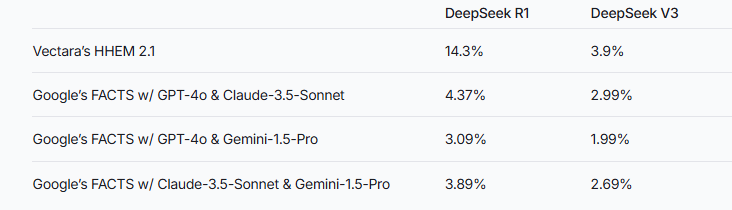

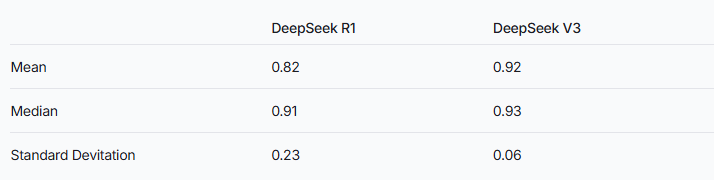

เพื่อประเมินประสิทธิภาพของทั้งสองรุ่นนี้นักวิจัยใช้รูปแบบ HHEM ของ Vectara และวิธีการข้อเท็จจริงของ Google ในการตัดสิน ในฐานะที่เป็นเครื่องมือตรวจจับภาพหลอนพิเศษ HHEM แสดงความไวสูงขึ้นเมื่อจับอัตราการเกิดภาพหลอนที่เพิ่มขึ้นของ Deepseek-R1 ในขณะที่แบบจำลองข้อเท็จจริงมีประสิทธิภาพค่อนข้างต่ำในเรื่องนี้ สิ่งนี้เตือนเราว่า HHEM อาจมีประสิทธิภาพมากกว่า LLM เป็นมาตรฐาน

เป็นที่น่าสังเกตว่า Deepseek-R1 แม้จะมีประสิทธิภาพที่ยอดเยี่ยมในการให้เหตุผล แต่ก็มาพร้อมกับอัตราการเกิดภาพหลอนที่สูงขึ้น สิ่งนี้อาจเกี่ยวข้องกับตรรกะที่ซับซ้อนที่จำเป็นในการประมวลผลแบบจำลองการปรับปรุงการอนุมาน เมื่อความซับซ้อนของการใช้เหตุผลเพิ่มขึ้นความแม่นยำของเนื้อหาที่สร้างขึ้นอาจได้รับผลกระทบแทน ทีมวิจัยยังเน้นว่าหาก Deepseek สามารถมุ่งเน้นไปที่การลดภาพหลอนในระหว่างขั้นตอนการฝึกอบรมอาจเป็นไปได้ที่จะได้รับความสมดุลที่ดีระหว่างความสามารถในการใช้เหตุผลและความแม่นยำ

ในขณะที่โมเดลที่เพิ่มการอนุมานโดยทั่วไปจะมีภาพหลอนที่สูงขึ้น แต่นี่ไม่ได้หมายความว่าพวกเขาไม่มีข้อได้เปรียบในแง่อื่น ๆ สำหรับซีรี่ส์ Deepseek ยังจำเป็นที่จะต้องแก้ภาพหลอนในการวิจัยและการเพิ่มประสิทธิภาพที่ตามมาเพื่อปรับปรุงประสิทธิภาพของโมเดลโดยรวม

การอ้างอิง: https://www.vectara.com/blog/deepseek-r1-hallucinates-more-than-deepseek-v3

ด้วยวิวัฒนาการอย่างต่อเนื่องของแบบจำลองภาษาขนาดใหญ่วิธีลดอัตราการเกิดภาพหลอนในขณะที่ปรับปรุงความสามารถในการใช้เหตุผลจะกลายเป็นทิศทางที่สำคัญสำหรับการวิจัยในอนาคต ผลการทดสอบของซีรี่ส์ Deepseek ช่วยให้เรามีการอ้างอิงที่มีค่าเพื่อส่งเสริมอุตสาหกรรมเพื่อเพิ่มประสิทธิภาพของโมเดลต่อไป