최근에는 대형 언어 모델의 빠른 개발로 추론 향상 모델도 환각율에 대한 광범위한 토론을 촉발하면서 복잡한 작업의 처리 기능을 향상 시켰습니다. Vectara의 기계 학습 팀은 최근 DeepSeek 시리즈 모델에 대한 심층적 인 연구를 수행하여 환각율 측면에서 추론 향상 모델의 상당한 차이를 보여줍니다.

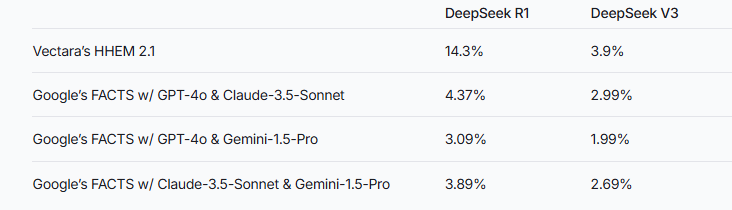

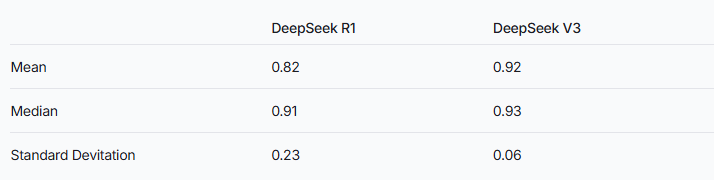

최근 Vectara의 기계 학습 팀은 Deepseek R1의 환각율이 14.3%로 상당히 높았다는 것을 보여주었습니다. v3. 이는 DeepSeek-R1이 추론을 강화하는 과정에서 원래 정보에 더 부정확하거나 일관성이 없음을 시사합니다. 이 결과는 LLM (Langed Language Model)의 환각 속도에 대한 광범위한 논의를 유발합니다.

이미지 소스 참고 : 이미지는 AI에 의해 생성되며 이미지 공인 서비스 제공 업체 Midjourney

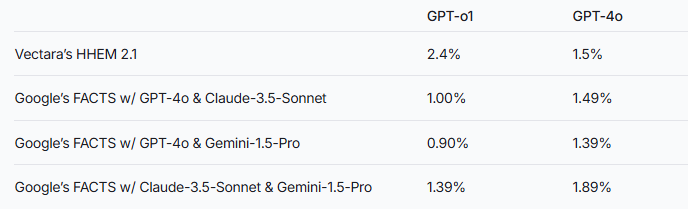

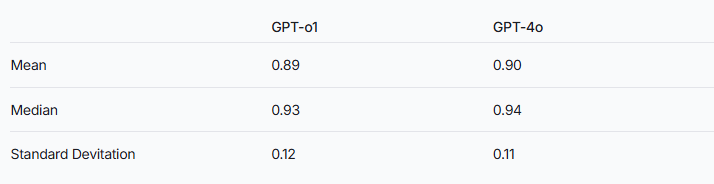

연구팀은 추론 확대 모델이 일반적인 대형 언어 모델보다 환각에 더 쉽다는 것을 지적했다. 이 현상은 특히 DeepSeek 시리즈를 다른 추론 향상 모델과 비교할 때 특히 분명합니다. GPT 시리즈를 예로 들어, 추론 강화 GPT-O1과 GPT-4O의 정상 버전 사이의 환각 속도의 차이 도이 추측을 확인합니다.

이 두 모델의 성능을 평가하기 위해 연구원들은 Vectara의 HHEM 모델과 Google의 사실 방법을 사용하여 판단을 내 렸습니다. 특수 환각 탐지 도구로서, HHEM은 DeepSeek-R1의 환각율 증가를 포착 할 때 더 높은 감도를 나타냅니다. 그리고 Facts 모델은 이와 관련하여 비교적 제대로 성능이 저하됩니다. 이것은 Hhem이 LLM보다 표준으로 더 효과적 일 수 있음을 상기시켜줍니다.

DeepSeek-R1은 추론의 우수한 성능에도 불구하고 더 높은 환각율을 동반한다는 점은 주목할 가치가 있습니다. 이는 추론 향상 모델을 처리하는 데 필요한 복잡한 논리와 관련이있을 수 있습니다. 모델 추론의 복잡성이 증가함에 따라 생성 된 컨텐츠의 정확도가 대신 영향을받을 수 있습니다. 연구팀은 또한 DeepSeek이 훈련 단계에서 환각을 줄이는 데 더 집중할 수 있다면 추론 능력과 정확성 사이의 균형을 잘 유지할 수 있다고 강조했다.

추론 강화 모델은 일반적으로 더 높은 환각을 나타내지 만, 이것이 다른 측면에서 이점이 없다는 것을 의미하지는 않습니다. DeepSeek 시리즈의 경우 전체 모델 성능을 향상시키기 위해 후속 연구 및 최적화에서 환각을 풀어야합니다.

참조 : https://www.vectara.com/blog/deepseek-r1-hallucinates-more-than-deepseek-v3

대형 언어 모델의 지속적인 진화로 환각율을 낮추는 동시에 추론 능력을 향상시키는 방법은 향후 연구에 중요한 방향이 될 것입니다. DeepSeek 시리즈의 테스트 결과는 우리에게 모델 성능을 더욱 최적화하기 위해 업계를 홍보하기위한 귀중한 참조를 제공합니다.