【 2024.06.13 】สนับสนุน MiniCPM-Llama3-V-2_5 , ปรับเปลี่ยนตัวแปรสภาพแวดล้อม MODEL_NAME=minicpm-v PROMPT_NAME=minicpm-v DTYPE=bfloat16

[2024.06.12] รองรับโมเดล GLM-4V , ปรับเปลี่ยนตัวแปรสภาพแวดล้อม MODEL_NAME=glm-4v PROMPT_NAME=glm-4v DTYPE=bfloat16 ดู glm4v สำหรับตัวอย่างการทดสอบ

【 2024.06.08 】โมเดล QWEN2 ได้รับการสนับสนุนแก้ไขตัวแปรสภาพแวดล้อม MODEL_NAME=qwen2 PROMPT_NAME=qwen2

【 2024.06.05 】รองรับรุ่น GLM4 และแก้ไขตัวแปรสภาพแวดล้อม MODEL_NAME=chatglm4 PROMPT_NAME=chatglm4

【 2024.04.18 】 Code Qwen , SQL Q&A Demo

【 2024.04.16 】สนับสนุนรูปแบบการสั่งซื้อ Rerank วิธีการใช้งาน

【 QWEN1.5 】ตัวแปรสภาพแวดล้อม MODEL_NAME=qwen2 PROMPT_NAME=qwen2

สำหรับข่าวและประวัติเพิ่มเติมโปรดไปที่นี่

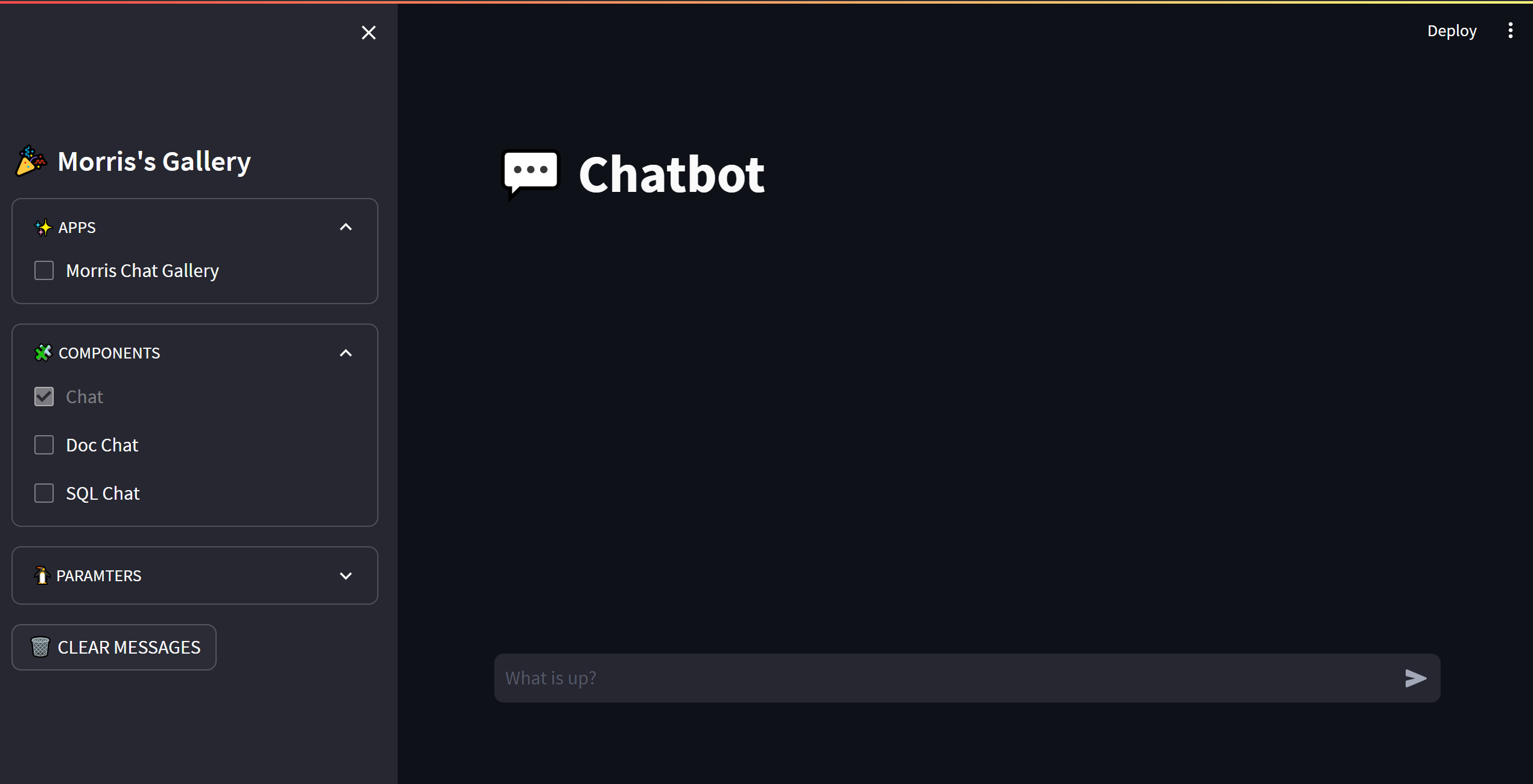

เนื้อหาหลักของโครงการนี้

โครงการนี้ใช้อินเทอร์เฟซแบ็กเอนด์แบบครบวงจรสำหรับการใช้เหตุผลของโมเดลโอเพ่นซอร์สขนาดใหญ่ซึ่งสอดคล้องกับการตอบสนองของ OpenAI และมีคุณสมบัติดังต่อไปนี้:

เรียกโมเดลโอเพนซอร์สต่างๆในรูปแบบของ OpenAI ChatGPT API

️รองรับการตอบสนองการสตรีมเพื่อให้ได้เอฟเฟกต์เครื่องพิมพ์

ใช้แบบจำลองการฝังข้อความเพื่อให้การสนับสนุนสำหรับเอกสารความรู้และคำตอบ

️สนับสนุนฟังก์ชั่นต่าง ๆ ของ langchain เครื่องมือพัฒนาแบบจำลองภาษาขนาดใหญ่

chatgpt

รองรับการโหลดรุ่น lora ที่ผ่านการฝึกอบรมด้วยตนเอง

⚡สนับสนุนการเร่งการอนุมาน VLLM และการประมวลผลคำขอพร้อมกัน

| บท | อธิบาย |

|---|---|

| ?? ♂ รุ่นโมเดล | โมเดลโอเพ่นซอร์สที่สนับสนุนโดยโครงการนี้และข้อมูลสั้น ๆ |

| ? วิธีเริ่มต้น | คำสั่งการกำหนดค่าสภาพแวดล้อมและคำสั่งเริ่มต้นสำหรับรุ่นเริ่มต้น |

| ⚡vllmวิธีการเริ่มต้น | คำสั่งการกำหนดค่าสภาพแวดล้อมและการเริ่มต้นสำหรับรุ่นเริ่มต้นโดยใช้ vLLM |

| วิธีการโทร | วิธีการโทรหลังจากเริ่มต้นโมเดล |

| ❓faq | ตอบคำถามที่พบบ่อย |

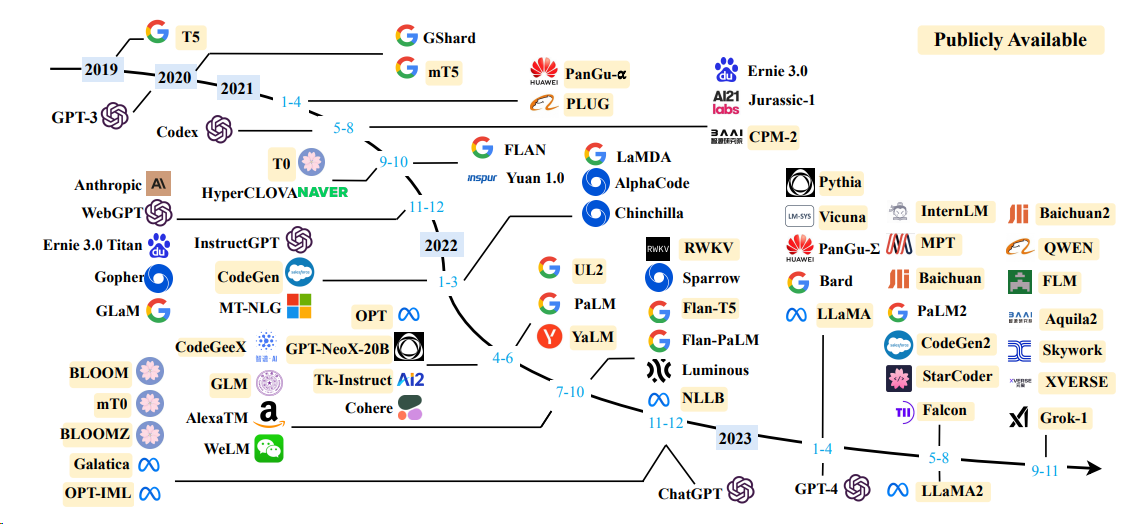

รูปแบบภาษา

| แบบอย่าง | ขนาดพารามิเตอร์รุ่น |

|---|---|

| ชาวไชน่า | 7b/13b |

| chatglm | 6B |

| ลึกล้ำ | 7b/16b/67b/236b |

| ผู้ฝึกงาน | 7b/20b |

| ลาม่า | 7b/13b/33b/65b |

| Llama-2 | 7b/13b/70b |

| Llama-3 | 8b/70b |

| Qwen | 1.8b/7b/14b/72b |

| Qwen1.5 | 0.5b/1.8b/4b/7b/14b/32b/72b/110b |

| Qwen2 | 0.5B/1.5B/7B/57B/72B |

| ยี่ (1/1.5) | 6b/9b/34b |

สำหรับรายละเอียดโปรดดูวิธีการเริ่มต้น VLLM และวิธีการเริ่มต้น Transformers

แบบจำลอง

| แบบอย่าง | มิติ | ลิงค์น้ำหนัก |

|---|---|---|

| BGE-LARGE-ZH | 1024 | BGE-LARGE-ZH |

| M3E ขนาดใหญ่ | 1024 | Moka-AI/M3E ขนาดใหญ่ |

| Text2Vec-large-chinese | 1024 | Text2Vec-large-chinese |

| BCE-embedding-base_v1 (แนะนำ) | 768 | BCE-embedding-base_v1 |

OPENAI_API_KEY : เพียงเติมสตริงที่นี่

OPENAI_API_BASE : ที่อยู่อินเตอร์เฟสของการเริ่มต้นแบ็กเอนด์เช่น: http: //192.168.0.xx: 80/v1

cd streamlit-demo

pip install -r requirements.txt

streamlit run streamlit_app.py

from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

chat_completion = client . chat . completions . create (

messages = [

{

"role" : "user" ,

"content" : "你好" ,

}

],

model = "gpt-3.5-turbo" ,

)

print ( chat_completion )

# 你好!我是人工智能助手 ChatGLM3-6B,很高兴见到你,欢迎问我任何问题。

# stream = client.chat.completions.create(

# messages=[

# {

# "role": "user",

# "content": "感冒了怎么办",

# }

# ],

# model="gpt-3.5-turbo",

# stream=True,

# )

# for part in stream:

# print(part.choices[0].delta.content or "", end="", flush=True) from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

completion = client . completions . create (

model = "gpt-3.5-turbo" ,

prompt = "你好" ,

)

print ( completion )

# 你好!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。 from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# compute the embedding of the text

embedding = client . embeddings . create (

input = "你好" ,

model = "text-embedding-ada-002"

)

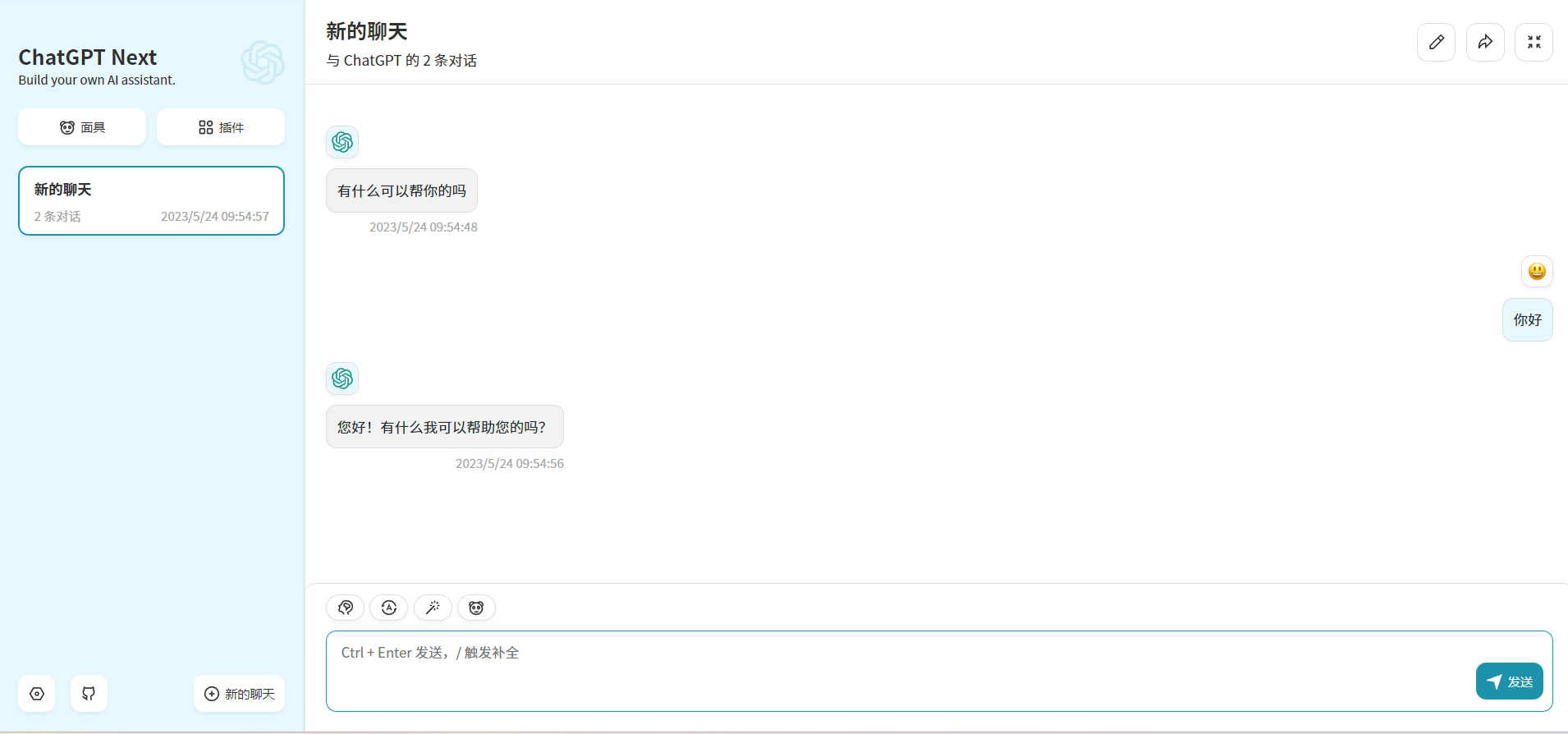

print ( embedding ) ด้วยการปรับเปลี่ยนตัวแปรสภาพแวดล้อม OPENAI_API_BASE แอปพลิเคชัน chatgpt ส่วนใหญ่และโครงการส่วนหน้าสามารถเชื่อมต่อได้อย่างราบรื่น!

docker run -d -p 3000:3000

-e OPENAI_API_KEY= " sk-xxxx "

-e BASE_URL= " http://192.168.0.xx:80 "

yidadaa/chatgpt-next-web

# 在docker-compose.yml中的api和worker服务中添加以下环境变量

OPENAI_API_BASE: http://192.168.0.xx:80/v1

DISABLE_PROVIDER_CONFIG_VALIDATION: ' true '

โครงการนี้ได้รับอนุญาตภายใต้ใบอนุญาต Apache 2.0 โปรดดูไฟล์ใบอนุญาตสำหรับข้อมูลเพิ่มเติม

chatglm: รูปแบบภาษาบทสนทนาแบบเปิดสองภาษา

Bloom: รูปแบบภาษาหลายภาษาแบบเปิดกว้าง 176b-parameter

LLAMA: แบบจำลองภาษาพื้นฐานที่เปิดกว้างและมีประสิทธิภาพ

การเข้ารหัสข้อความที่มีประสิทธิภาพและมีประสิทธิภาพสำหรับ Llama และ Alpaca จีน

ฟีนิกซ์: ประชาธิปไตย chatgpt ข้ามภาษา

มอส: โมเดลภาษาสนทนาแบบโอเพนซอร์ซ

FastChat: แพลตฟอร์มเปิดสำหรับการฝึกอบรมการให้บริการและการประเมิน chatbots แบบจำลองภาษาขนาดใหญ่

Langchain: การสร้างแอพพลิเคชั่นที่มี LLM ผ่านการรวมกัน

chuanhuchatgpt