Визуально сравните подсказки LLM заполнения, чтобы раскрыть изученные предубеждения и ассоциации!

????

Большие языковые модели (LLM), такие как BERT и GPT-3, наблюдали значительные улучшения в выполнении задач естественного языка, что позволяет им помочь людям отвечать на вопросы, генерировать эссе, суммировать длинные статьи и многое другое. Тем не менее, понимание того, чему научились эти модели и почему они работают, все еще является открытым испытанием. Для исследователей и инженеров по обработке естественного языка (NLP), которые все чаще обучают и развертывают LLM как «черные ящики» для создания текста, изучая, как изученное поведение во время обучения проявляется в задачах нижестоящих по течению, может помочь им улучшить разработку модели; Например, всплыв вредные стереотипы .

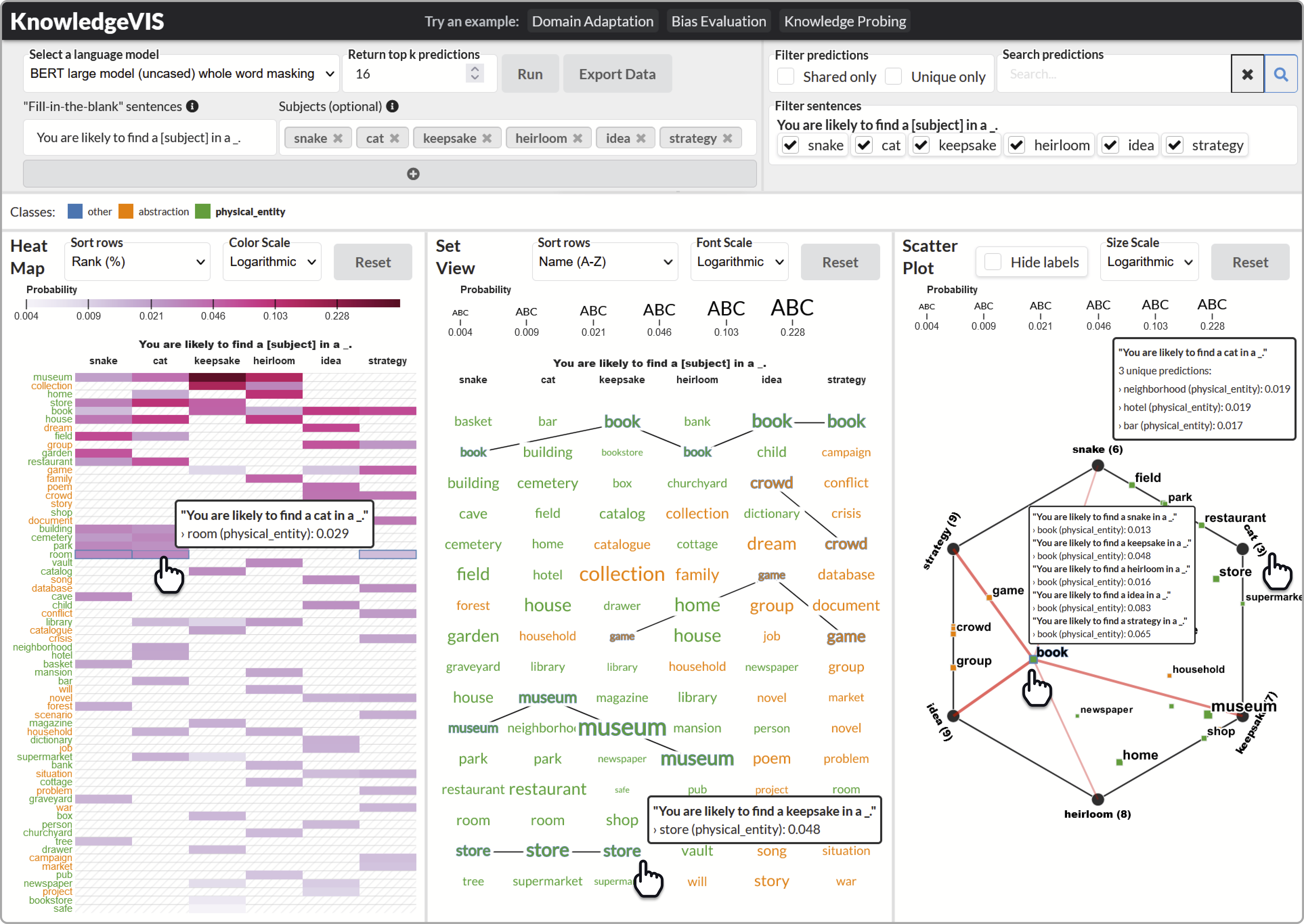

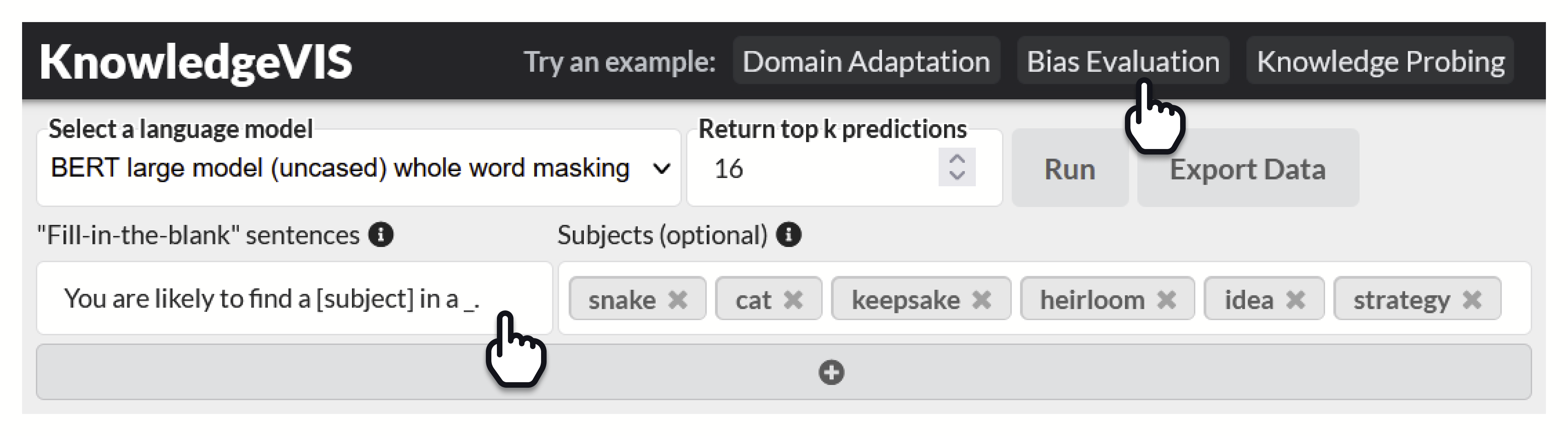

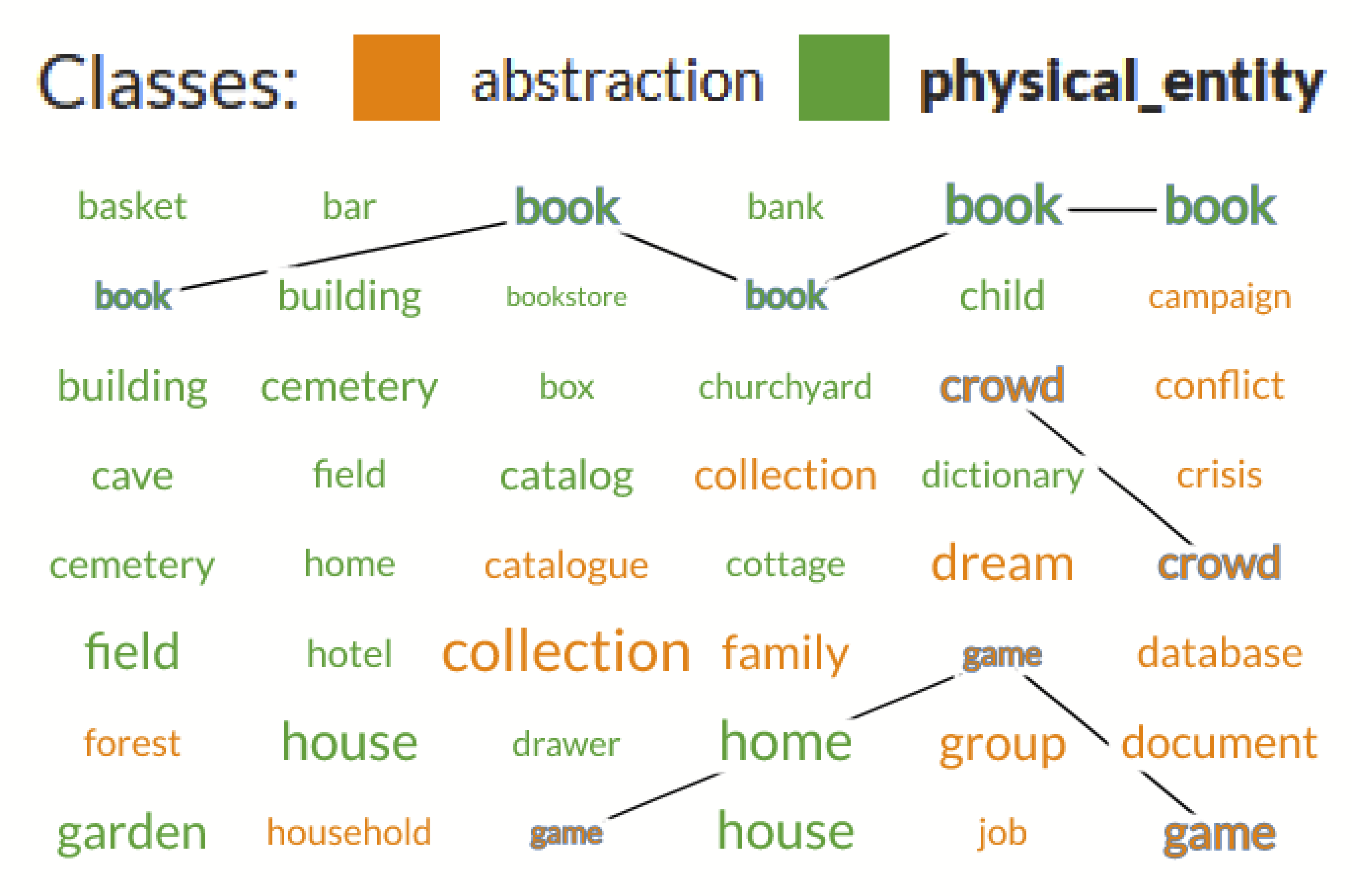

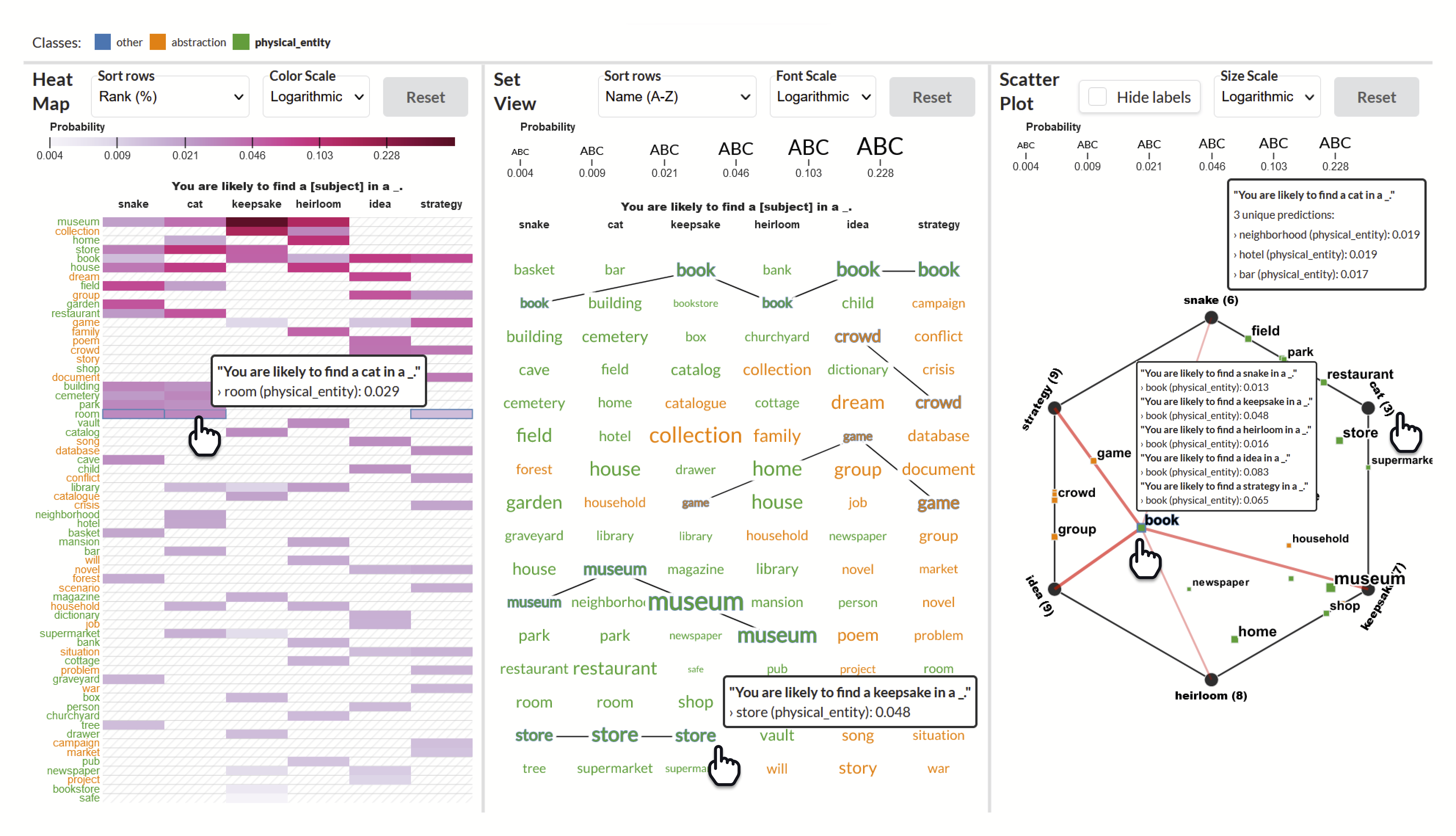

Знания VIS-это система визуальной аналитики человека в петле для сравнения подсказок заполнения , чтобы раскрыть ассоциации из изученных текстовых представлений. Знания VIS помогает разработчикам создавать эффективные наборы подсказок, исследовать множество типов отношений между словами, тестировать на различные ассоциации, которые были изучены, и находят представление о нескольких наборах прогнозов для любой языковой модели на основе BERT.

В совокупности эти визуализации помогают пользователю определить вероятность и уникальность отдельных прогнозов, сравнивать наборы прогнозов между подсказками и обобщать закономерности и взаимосвязь между прогнозами во всех подсказках.

Этот код сопровождает исследовательскую работу:

Знание VIS: интерпретация языковых моделей путем сравнения подсказок заполнения вдзлания

Адам Коссия, Алекс Эндерт

Транзакции IEEE по визуализации и компьютерной графике (TVCG), 2023 (чтобы появиться)

| Бумага |

Посмотрите демо -видео для полного учебника здесь: https://youtu.be/hbx4rsumr_i

Для живой демонстрации, посетите: https://adamcoscia.com/papers/knowledgevis/demo/

? Вы можете проверить наши визуализации на собственных LLMS всего за несколько простых шагов!

v3.9.x (последний выпуск)git clone [email protected]:AdamCoscia/KnowledgeVIS.git

# use --depth if you don't want to download the whole commit history

git clone --depth 1 [email protected]:AdamCoscia/KnowledgeVIS.gitПерейдите к папке интерфейса:

cd interfacepy -3.9 -m http.serverpython3.9 -m http.serverПерейдите в Localhost: 8000. Вы должны увидеть знания, бегущие в вашем браузере :)

Перейдите к папке сервера:

cd serverСоздайте виртуальную среду:

# Start a virtual environment

py -3.9 -m venv venv

# Activate the virtual environment

. v env S cripts a ctivate # Start a virtual environment

python3.9 -m venv venv

# Activate the virtual environment

source venv/bin/activateУстановить зависимости:

python -m pip install -r requirements.txt Установить Pytorch v2.0.x (инструкции)

Pytorch устанавливается отдельно, потому что некоторые системы могут поддерживать CUDA, который требует другого процесса установки и может значительно ускорить инструмент.

Затем запустите сервер:

python main.pyВо главе с Адамом Косцией знания, является результатом сотрудничества между экспертами по визуализации в вычислительных компьютерах и дизайне взаимодействия от Georgia Tech. Знания Viss созданы Адамом Коссии и Алексом Эндертом.

Чтобы узнать больше о знаниях, пожалуйста, прочитайте нашу исследовательскую статью (появившись в IEEE TVCG).

@article { Coscia:2023:KnowledgeVIS ,

author = { Coscia, Adam and Endert, Alex } ,

journal = { IEEE Transactions on Visualization and Computer Graphics } ,

title = { KnowledgeVIS: Interpreting Language Models by Comparing Fill-in-the-Blank Prompts } ,

year = { 2023 } ,

volume = { } ,

number = { } ,

pages = { 1-13 } ,

doi = { 10.1109/TVCG.2023.3346713 }

}Программное обеспечение доступно по лицензии MIT.

Если у вас есть какие -либо вопросы, не стесняйтесь открывать проблему или свяжитесь с Адамом Косцией.