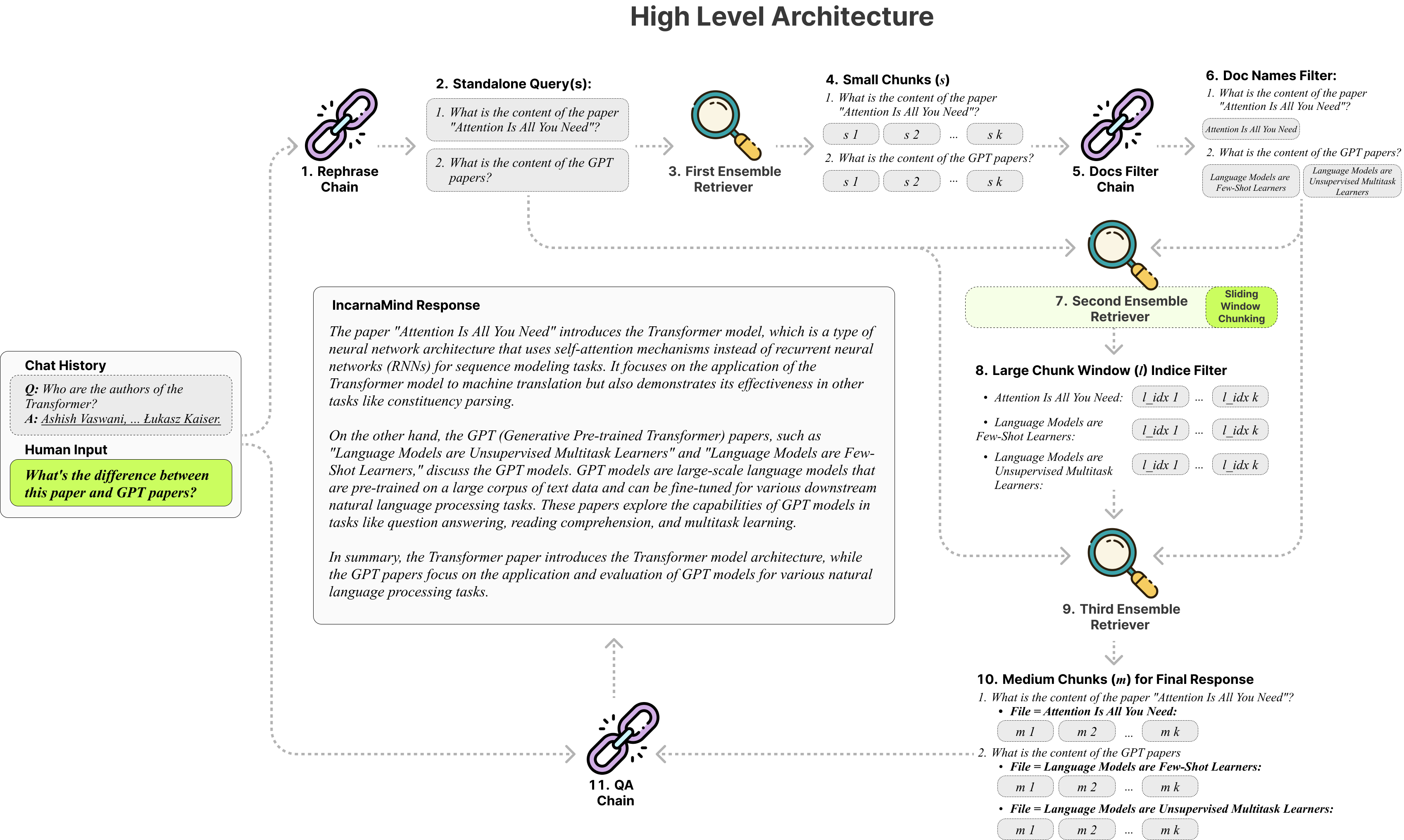

Incarnamind позволяет вам общаться с вашими личными документами? (PDF, TXT) Используя большие языковые модели (LLMS), такие как GPT (Обзор архитектуры). В то время как OpenAI недавно запустил API с тонкой настройкой для моделей GPT, он не позволяет базовым предварительному моделям изучать новые данные, а ответы могут быть подвержены фактическим галлюцинациям. Используйте наш механизм раздвижного окна, а ансамблевой ретривер позволяет эффективно запросить как мелкозернистую, так и крупную информацию в ваших наземных документах истины, чтобы увеличить LLMS.

Не стесняйтесь использовать его, и мы приветствуем какие -либо отзывы и новые предложения функций?

Вот сравнительная таблица различных моделей, которые я протестировал, только для справки:

| Метрики | GPT-4 | GPT-3.5 | Клод 2.0 | Llama2-70b | Llama2-70b-Gguf | Llama2-70B-API |

|---|---|---|---|---|---|---|

| Рассуждение | Высокий | Середина | Высокий | Середина | Середина | Середина |

| Скорость | Середина | Высокий | Середина | Очень низкий | Низкий | Середина |

| Графический баран | N/a | N/a | N/a | Очень высоко | Высокий | N/a |

| Безопасность | Низкий | Низкий | Низкий | Высокий | Высокий | Низкий |

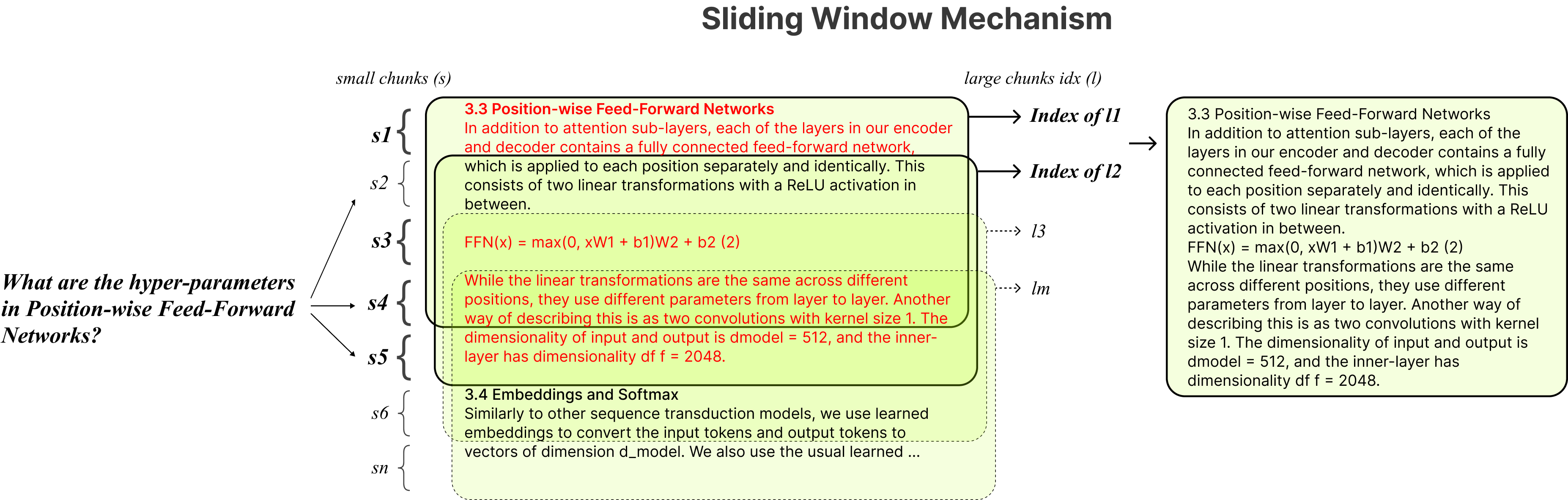

Фиксированный кункинг : традиционные тряпичные инструменты полагаются на фиксированные размеры кусок, ограничивая их адаптивность в обработке различной сложности и контекста данных.

Точность против семантики : текущие методы поиска обычно фокусируются либо на семантическом понимании, либо в точном поиске, но редко оба.

Ограничение с одним документом .

Стабильность : Iccarnamind совместим с OpenAI GPT, Anpropic Claude, Llama2 и другими LLMS с открытым исходным кодом, обеспечивая стабильный анализ.

Адаптивная подставка : наша техника раздвижного окна динамически настраивает размер и положение окна для тряпичной тряпки, балансируя мелкозернистый и крупнозернистый доступ к данным на основе сложности и контекста данных.

Многодокументированный разговорной QA : поддерживает простые и многообогативные запросы по нескольким документам одновременно, разрушая ограничение с одним годом.

Совместимость файлов : поддерживает форматы файлов PDF и TXT.

Совместимость модели LLM : поддерживает OpenAI GPT, Anpropic Claude, Llama2 и другие LLMS с открытым исходным кодом.

Установка проста, вам просто нужно запустить несколько команд.

git clone https://github.com/junruxiong/IncarnaMind

cd IncarnaMindСоздайте виртуальную среду Conda:

conda create -n IncarnaMind python=3.10Активировать:

conda activate IncarnaMindУстановите все требования:

pip install -r requirements.txtУстановите Llama-CPP отдельно, если вы хотите запустить квантованные локальные LLMS:

NVIDIA используйте cuBLAS CMAKE_ARGS= " -DLLAMA_CUBLAS=on " FORCE_CMAKE=1 pip install llama-cpp-python==0.1.83 --no-cache-dirM1/M2 ) используйте CMAKE_ARGS= " -DLLAMA_METAL=on " FORCE_CMAKE=1 pip install llama-cpp-python==0.1.83 --no-cache-dirУстановите свой/все клавиши API в файле configparser.ini :

[tokens]

OPENAI_API_KEY = (replace_me)

ANTHROPIC_API_KEY = (replace_me)

TOGETHER_API_KEY = (replace_me)

# if you use full Meta-Llama models, you may need Huggingface token to access.

HUGGINGFACE_TOKEN = (replace_me)(Необязательно) Настройка пользовательских параметров в файле configparser.ini :

[parameters]

PARAMETERS 1 = (replace_me)

PARAMETERS 2 = (replace_me)

...

PARAMETERS n = (replace_me)Поместите все свои файлы (пожалуйста, правильно назовите каждый файл, чтобы максимизировать производительность) в каталог /data , и запустите следующую команду для употребления всех данных: (вы можете удалить примеры файлов в каталоге /data , прежде чем запустить команду)

python docs2db.pyЧтобы начать разговор, запустите команду как:

python main.pyПодождите, пока сценарий требует вашего ввода, как ниже.

Human:Когда вы запустите чат, система автоматически генерирует файл incarnamind.log . Если вы хотите отредактировать журнал, пожалуйста, отредактируйте в файле configparser.ini .

[logging]

enabled = True

level = INFO

filename = IncarnaMind.log

format = %(asctime)s [%(levelname)s] %(name)s: %(message)sОсобая благодарность Langchain, Chroma DB, Localgpt, Llama-CPP за их неоценимый вклад в сообщество с открытым исходным кодом. Их работа сыграла важную роль в том, чтобы сделать проект «Играминанда» реальностью.

Если вы хотите процитировать нашу работу, используйте следующую запись Bibtex:

@misc { IncarnaMind2023 ,

author = { Junru Xiong } ,

title = { IncarnaMind } ,

year = { 2023 } ,

publisher = { GitHub } ,

journal = { GitHub Repository } ,

howpublished = { url{https://github.com/junruxiong/IncarnaMind} }

}Apache 2.0 Лицензия