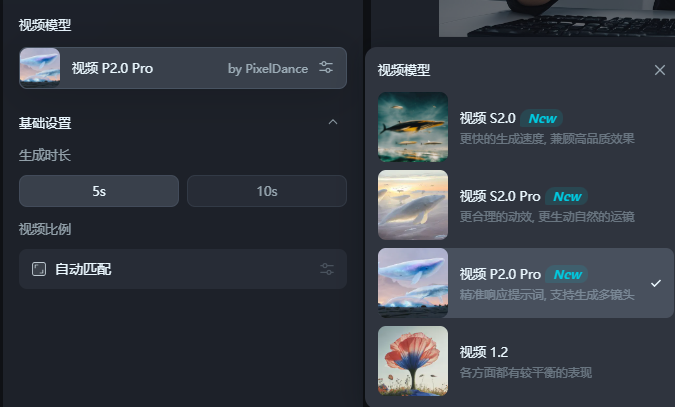

Os modelos de geração de vídeo da Bytedance, Pixeldance e Haterweed, foram totalmente lançados na plataforma Jimeng AI! Agora, os usuários podem experimentar essas duas poderosas ferramentas de geração de vídeo da AI por meio da versão da Web e do aplicativo móvel usando "Video P2.0Pro" ou "Video S2.0Pro". O P2.0Pro é adequado para cenas esportivas complexas, mas é mais sensível às palavras solicitadas; . Este artigo realizará comparação e avaliação detalhadas dos dois modelos e compartilharão a experiência de uso real para ajudá -lo a escolher o modelo mais adequado.

Finalmente, todos podem usar o modelo de geração de bytes Pixeldance! Vídeo S2.0Pro "Para experimentar o poder desses dois modelos.

Ambos os modelos precisam gerar um vídeo de 5 segundos para os dois consumirem 20 pontos, enquanto o P2.0Pro consumirá 40 pontos.

O Aibase realmente experimentou isso por um tempo. Precisa dominar.

Às vezes, o pequeno exercício usa o S2.0Pro para produzir vídeos com mais eficácia do que o P2.0Pro e é mais amigável para os novatos informações e convertem -as em animação em vídeo apropriada.

De acordo com o feedback de muitos criadores de testes internos, o P2.0Pro tem um desempenho excelentemente ao gerar vídeos de 10 segundos, especialmente quando 3-5 chutes são trocados, e podem manter a coerência da cena e bem o personagem. Ao ajustar as palavras rápidas, o modelo também pode obter efeitos especiais incríveis. Os usuários podem usar técnicas avançadas, como prontuários de tempo, palavras e fotos longas para melhorar a expressividade e a história do vídeo.

A seguir, é apresentada a experiência real de teste do AIBase:

Primeiro, jogue uma foto do gato de surf.

Efeito S2.0Pro

Efeito p2.0Pro

Como você pode ver, o S2.0Pro pode restaurar com precisão as características detalhadas do estilo, cor e outras imagens que inserimos, enquanto o P2.0Pro às vezes possui moldes de cores. Em termos de movimento, os dois modelos tiveram um desempenho muito estável, e basicamente não havia problema.

Em seguida, use Max para testar dois modelos:

Basta entrar "Musk Gets perto da câmera e entrega os polegares" para ver o efeito ~

Efeito S2.0Pro

Efeito p2.0Pro

Para este vídeo relativamente simples, as diferenças entre os dois modelos não parecem ser muito grandes, mas o P2.0Pro também adicionou expressões a Musk, o que o tornou mais vívido.

Dê a eles alguma dificuldade:

Vamos obter uma palavra rápida e complexa e complexa "A câmera avança, concentrando -se em um jovem em uma túnica branca lisa. Ele segura uma espada pitoresca na mão e parece firme. O vento sopra o cabelo e o céu escurece lentamente. Uma enorme O dragão-preto azul desceu das nuvens, com luz fria na balança. ”

Efeito S2.0Pro

Efeito p2.0Pro

Atualmente, o P2.0Pro segue as palavras imediatas e implementa estritamente a primeira metade das palavras imediatas "A lente avança, concentrando -se em um garoto em uma túnica branca simples", mas o movimento do dragão é um pouco menor. O efeito do S2.0Pro é mais aleatório, mas a faixa de movimento dos dragões é melhor que a do P2.0Pro. No uso real, você pode usar dois modelos de acordo com suas necessidades.

Vale a pena notar que o Zhimeng também possui um modelo leve de vídeo S2.0 (equivalente à versão castrada do S2.0Pro), que é mais rápido para gerar e às vezes enfraquecer o efeito, mas leva apenas 5 pontos para gerar um vídeo. Pode -se dizer que tem um desempenho de custo mais alto.

Aqui está o efeito de não inserir nenhuma palavra imediata:

Aqueles que estão interessados podem experimentá -lo sozinhos: https://top.aibase.com/tool/jimeng

Em resumo, o Pixeldance e o algas marítimos fornecem aos usuários recursos de geração de vídeo de IA. A plataforma Zhimeng AI também fornece uma versão leve do S2.0, que é mais econômica. Vá e experimente!