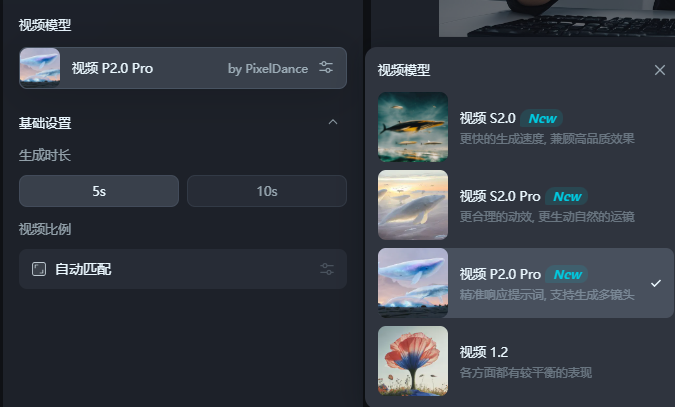

¡Los modelos de generación de videos de Bytedance Pixeldance y Seaweed se han lanzado completamente en la plataforma Jimeng AI! Los usuarios ahora pueden experimentar estas dos poderosas herramientas de generación de videos AI a través de la versión web y la aplicación móvil utilizando "Video P2.0Pro" o "Video S2.0Pro". P2.0Pro es adecuado para escenas deportivas complejas, pero es más sensible a las palabras rápidas; . Este artículo llevará a cabo una comparación y evaluación detalladas de los dos modelos y compartirá la experiencia de uso real para ayudarlo a elegir el modelo más adecuado.

Finalmente, todos pueden usar el modelo de generación de videos Byte Pixeldance ahora, los modelos de generación de videos de Bytedance se han lanzado por completo en Jimeng AI. Video S2.0Pro "para experimentar el poder de estos dos modelos.

Ambos modelos deben generar un video de 5 segundos para que ambos consuman 20 puntos, mientras que P2.0PRO consumirá 40 puntos.

AIBASE realmente lo ha experimentado por un tiempo. Necesito dominarlo.

Pequeño ejercicio a veces usa S2.0Pro para producir videos de manera más efectiva que P2.0Pro, y es más amigable para los novatos. información y convertirla en animación de video apropiada.

Según los comentarios de muchos creadores de pruebas internas, P2.0Pro se desempeña excelentemente al generar videos de 10 segundos, especialmente cuando se cambian 3-5 tomas y pueden mantener bien la coherencia de la escena y el personaje. Al ajustar finamente las palabras rápidas, el modelo también puede lograr efectos especiales sorprendentes. Los usuarios pueden usar técnicas avanzadas, como palabras de tiempo y tomas largas para mejorar la expresividad y la historia del video.

La siguiente es la experiencia de prueba real de AIBASE:

Primero, lanza una imagen del gato de surf.

Efecto s2.0pro

Efecto p2.0pro

Como puede ver, S2.0Pro puede restaurar con precisión las características detalladas del estilo, el color y otras imágenes que ingresamos, mientras que P2.0Pro a veces tiene un fundido de color. En términos de movimiento, ambos modelos tuvieron un rendimiento muy estable, y básicamente no hubo ningún problema.

A continuación, use Max para probar dos modelos:

Simplemente ingrese "El almizcle se acerca a la cámara y da un pulgar hacia arriba" para ver el efecto ~

Efecto s2.0pro

Efecto p2.0pro

Para este video relativamente simple, las diferencias entre los dos modelos no parecen ser muy grandes, pero P2.0Pro también agregó expresiones a Musk, lo que lo hizo más vívido.

Dales algunas dificultades:

Recibamos una palabra rápida más larga y compleja "La cámara avanza, enfocándose en un hombre joven con una túnica blanca simple. Sostiene una espada pintoresca en la mano y se ve firme. El viento le sopla el cabello y el cielo se oscurece lentamente. Un enorme El dragón azul-negro salió de las nubes, con luz fría en la balanza ".

Efecto s2.0pro

Efecto p2.0pro

En la actualidad, P2.0Pro sigue más las palabras rápidas e implementa estrictamente la primera mitad de las palabras rápidas "La lente avanza, centrándose en un niño con una túnica blanca simple", pero el movimiento del dragón es un poco más pequeño. El efecto de S2.0Pro es más aleatorio, pero el rango de movimiento de los dragones es mejor que el de P2.0Pro. En uso real, puede usar dos modelos de acuerdo con sus necesidades.

Vale la pena señalar que Zhimeng también tiene un modelo de video liviano S2.0 (equivalente a la versión castrada de S2.0Pro), que es más rápida de generar y, a veces, debilita el efecto, pero solo se necesitan 5 puntos para generar un video. Se puede decir que tiene un rendimiento de mayor costo.

Aquí está el efecto de no ingresar ninguna palabra rápida:

Los que están interesados pueden experimentarlo por sí mismos: https://top.aibase.com/tool/jimeng

En resumen, Pixeldance y Seaweed proporcionan a los usuarios capacidades de generación de videos de IA fuertes. La plataforma Zhimeng AI también proporciona una versión liviana de S2.0, que es más rentable. ¡Ve y experimenta!