KLLM: Modelo de linguagem no nível do kernel

Bem-vindo ao KLLM, um projeto avançado focado no desenvolvimento do núcleo da IA do kernel, integrando os modelos de idiomas no dispositivo (LMS) para obter recursos de IA eficientes e poderosos.

Visão geral

O KLLM significa Modelo de Linguagem no nível do kernel, uma estrutura de ponta projetada para injetar modelos de linguagem diretamente no nível do kernel. Este projeto tem como objetivo revolucionar a integração da IA no sistema operacional central, fornecendo desempenho contínuo e eficiente em termos de energia para aplicativos no dispositivo.

Características

Desenvolvimento do núcleo da IA do kernel

Aproveitando o poder do kernel, o KLLM garante que as funcionalidades da IA sejam profundamente integradas no sistema. Essa profunda integração permite um processamento mais rápido e eficiente das tarefas de IA, pois as funcionalidades principais são incorporadas no nível mais baixo do sistema operacional. Essa abordagem minimiza a latência, aprimora a segurança e fornece uma base estável para a execução de modelos complexos de IA. Além disso, métodos robustos de codificação são usados para manter a integridade dos dados e o acesso rápido.

LMS no dispositivo

A KLLM se concentra na execução de modelos e aplicativos de IA diretamente em dispositivos pessoais, como laptops, smartphones ou dispositivos de borda, em vez de depender de serviços baseados em nuvem. Esta integração local traz vários benefícios transformadores:

- Privacidade : garantir que dados confidenciais nunca deixem o dispositivo, protegendo a privacidade do usuário e reduzindo o risco de violações de dados. Informações pessoais e interações do usuário são processadas e armazenadas no dispositivo, eliminando a necessidade de transmitir dados para servidores externos.

- Eficiência de custos : ao eliminar a necessidade de recursos caros baseados em nuvem, a KLLM reduz os custos operacionais contínuos associados à transmissão de dados, armazenamento em nuvem e serviços computacionais. Isso torna a IA mais acessível e acessível para desenvolvedores e usuários finais.

- Relevância cultural : permite a personalização e adaptação dos modelos de idiomas para se alinhar melhor aos idiomas, dialetos e nuances culturais. Isso aprimora a experiência do usuário, fornecendo interações mais precisas e contextualmente relevantes.

- Confiabilidade do sistema : a redução da dependência da conectividade da Internet e dos serviços em nuvem melhora a confiabilidade e a disponibilidade dos aplicativos de IA. O KLLM garante que as funcionalidades da IA continuem operando perfeitamente, mesmo em ambientes offline ou de baixa conexão. O Guardrails é implementado para impedir que os modelos de IA realizem ações não intencionais, garantindo um comportamento seguro e confiável.

LMS com eficiência energética

A KLLM implementa técnicas de camadas de pseudo-nível, que fornecem uma arquitetura de kernel mais modular e flexível. Esta abordagem oferece várias vantagens:

- Modularidade : quebrar o kernel em camadas menores e gerenciáveis permite atualizações e manutenção mais fáceis. Cada camada pode ser desenvolvida, testada e atualizada de forma independente.

- Flexibilidade : o design modular facilita a integração de novos recursos e funcionalidades sem interromper todo o sistema.

- Escalabilidade : As camadas de pseudo-nível suportam a escala do kernel para acomodar diferentes tipos de dispositivos e requisitos de desempenho.

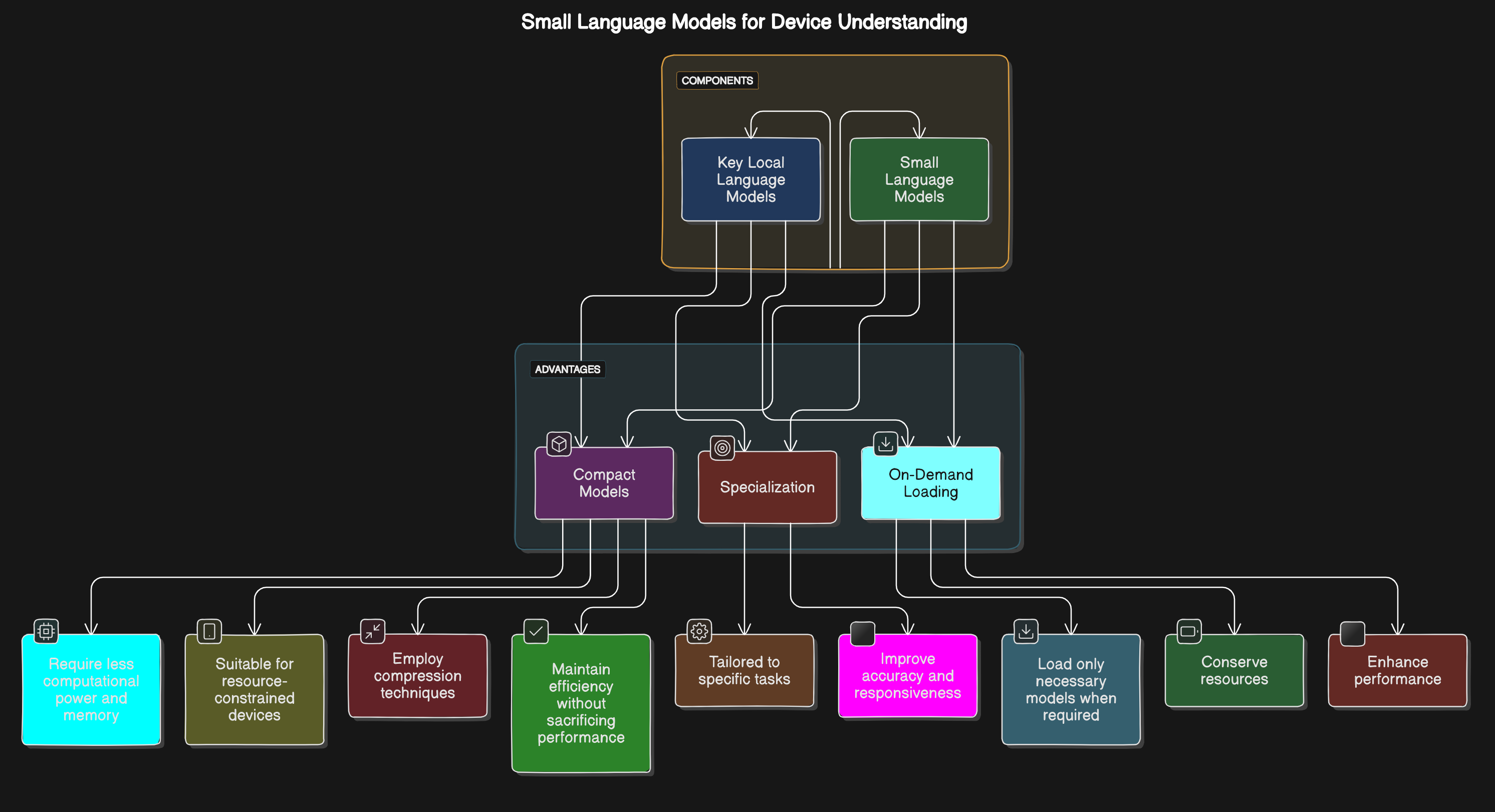

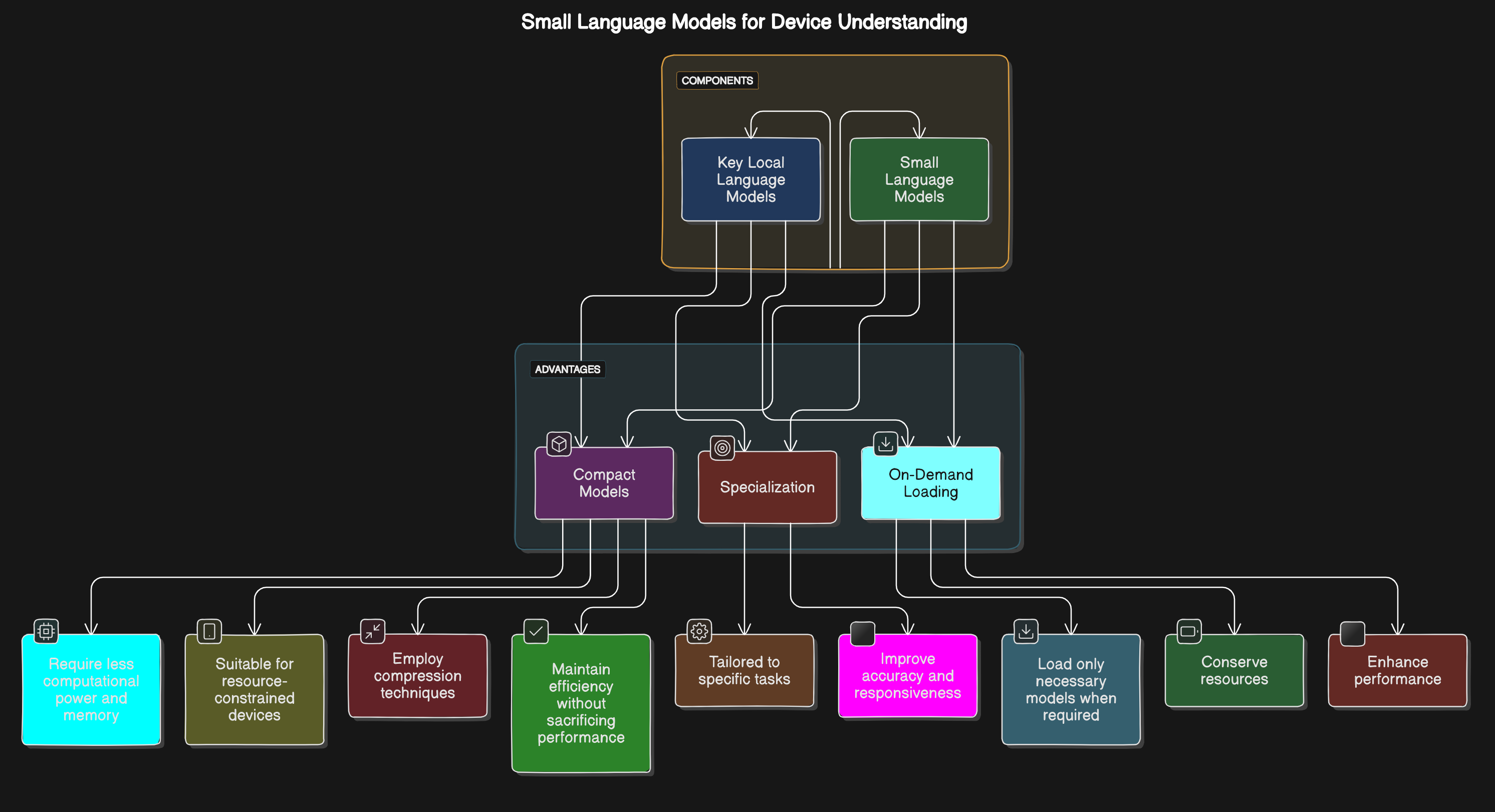

Pequenos modelos de linguagem para compreensão do dispositivo

O KLLM inclui modelos de linguagem menor e otimizado (LMS pequenos) adaptados para funcionalidades específicas do dispositivo. Esses modelos aprimoram a capacidade do dispositivo de entender e responder aos comandos do usuário com eficiência:

O KLLM inclui modelos de linguagem menor e otimizado (LMS pequenos) adaptados para funcionalidades específicas do dispositivo. Esses modelos aprimoram a capacidade do dispositivo de entender e responder aos comandos do usuário com eficiência:

- Modelos compactos : os modelos menores requerem menor poder computacional e memória, tornando-os adequados para dispositivos com restrição de recursos. As técnicas de compressão são empregadas para manter a eficiência do modelo sem sacrificar o desempenho.

- Especialização : adaptar os modelos para tarefas específicas (por exemplo, comandos de voz, previsões de texto) melhora a precisão e a capacidade de resposta.

- Carregamento sob demanda : carregando apenas os modelos necessários quando necessário conserva recursos e aprimora o desempenho.

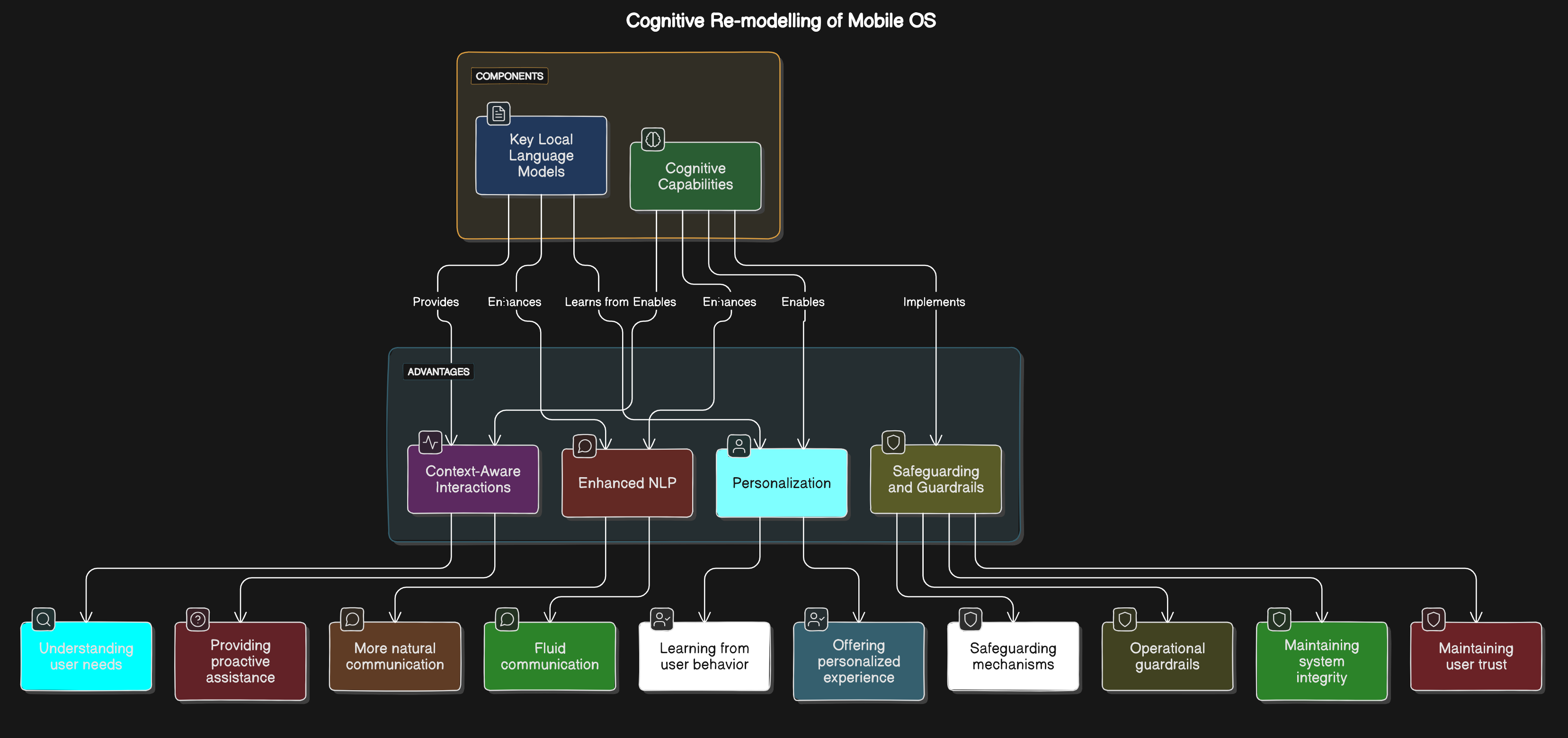

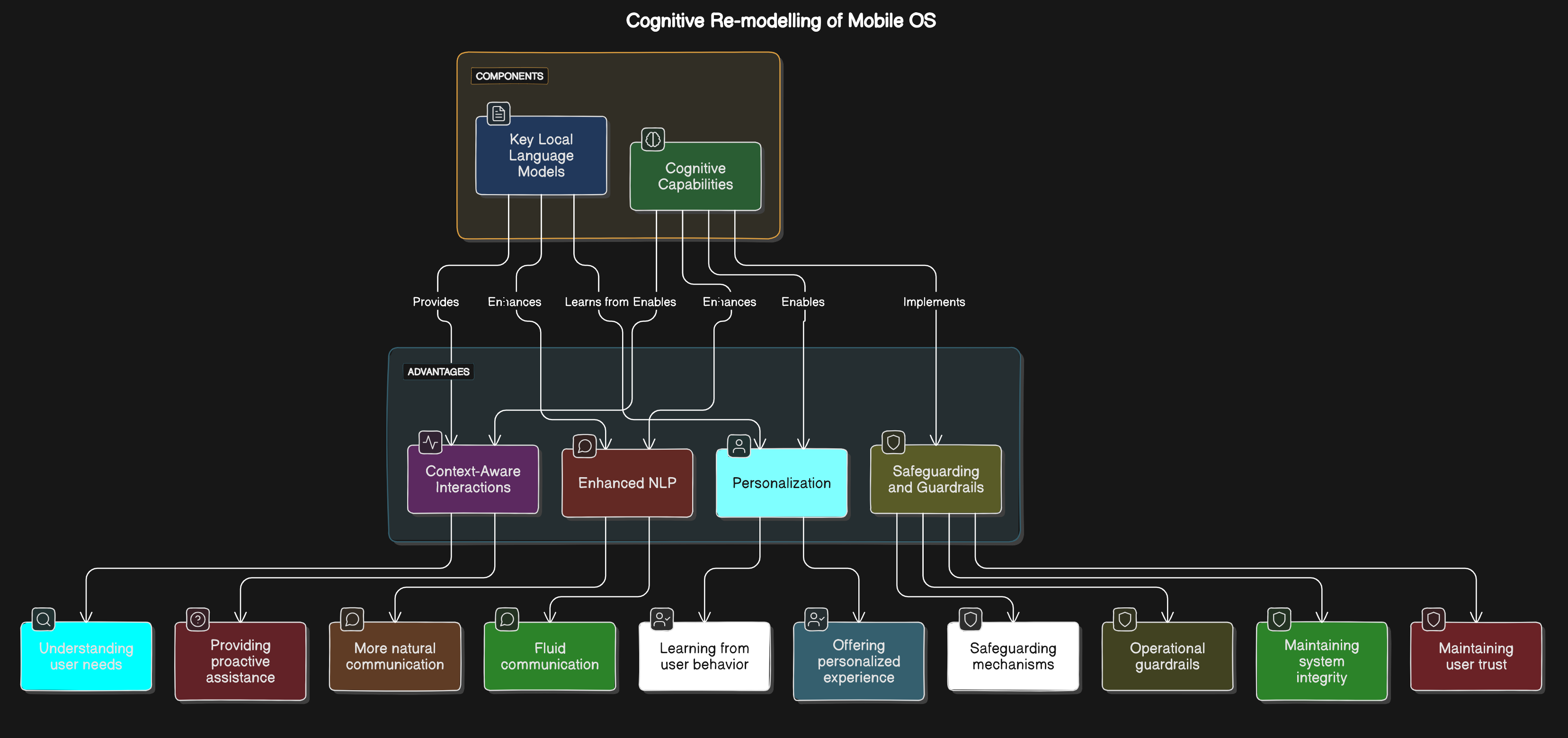

Re-modelagem cognitiva do sistema operacional móvel

Ao integrar os recursos cognitivos diretamente no sistema operacional móvel, o KLLM permite interações mais inteligentes e intuitivas entre os usuários e seus dispositivos:

Ao integrar os recursos cognitivos diretamente no sistema operacional móvel, o KLLM permite interações mais inteligentes e intuitivas entre os usuários e seus dispositivos:

- Interações com reconhecimento de contexto : o sistema operacional pode entender e antecipar as necessidades do usuário com base no contexto, fornecendo assistência proativa.

- Processamento da linguagem natural : os recursos aprimorados da PNL permitem uma comunicação mais natural e fluida com o dispositivo.

- Personalização : a re-modelagem cognitiva permite que o sistema operacional aprenda com o comportamento e as preferências do usuário, oferecendo uma experiência personalizada.

- Proteção de salvaguarda e guarda : A implementação de mecanismos de proteção e corrimão operacional garante que os componentes da IA atuem dentro de limites seguros predefinidos, mantendo a integridade do sistema e a confiança do usuário.

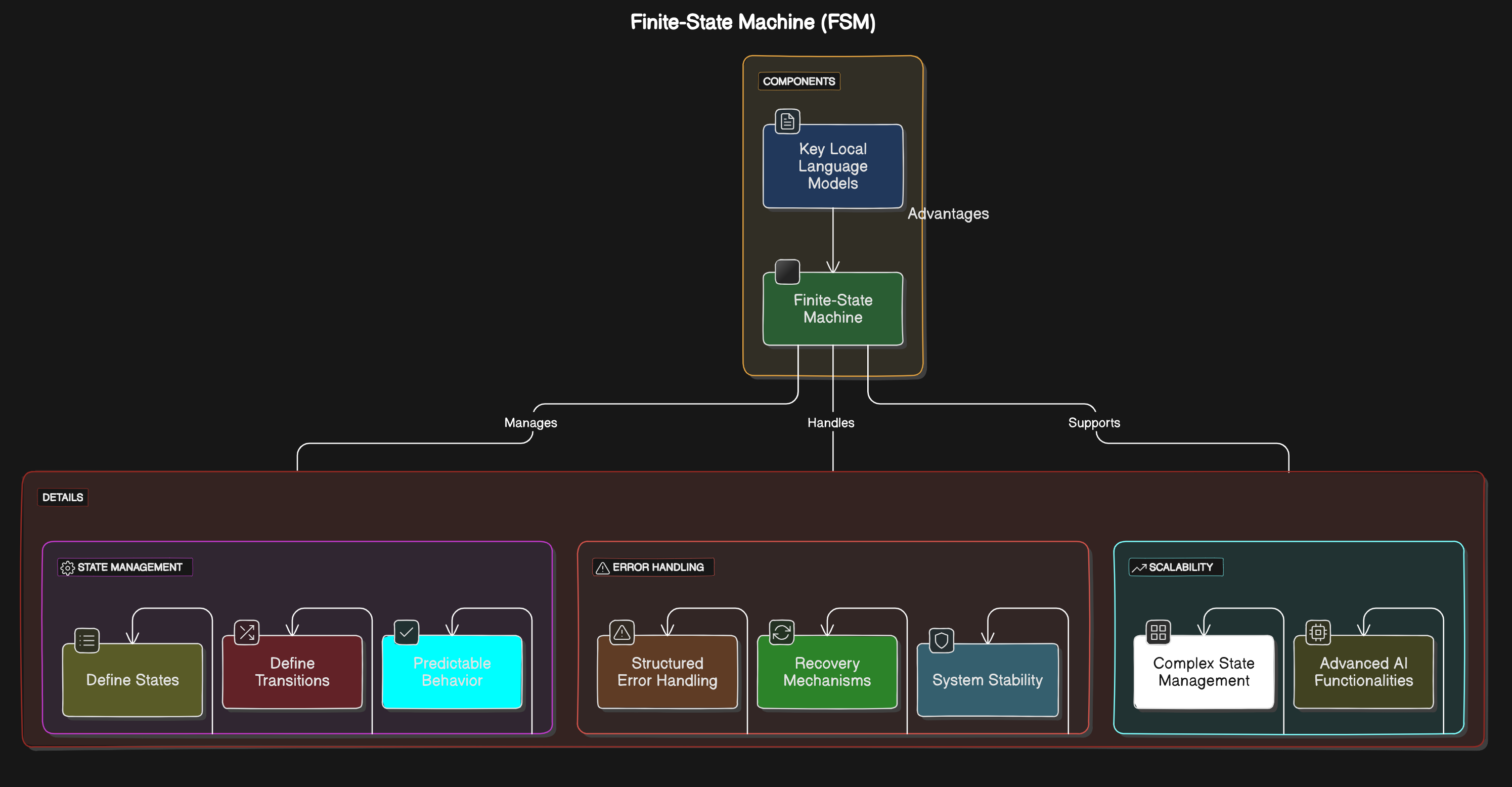

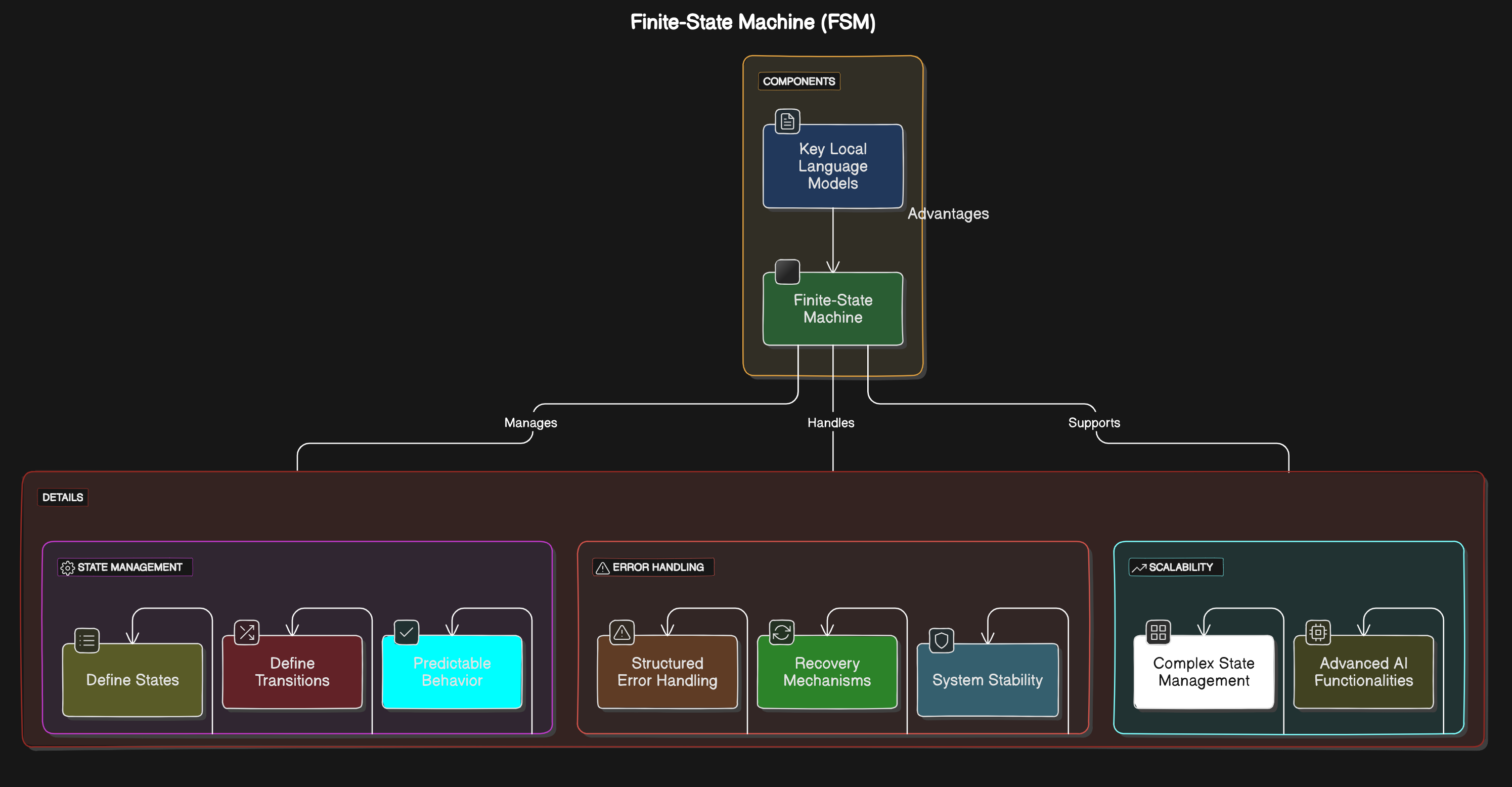

Máquina de Estado Finito (FSM)

A KLLM utiliza uma arquitetura robusta de máquinas de estado finito para gerenciar os estados e transições dentro do kernel:

A KLLM utiliza uma arquitetura robusta de máquinas de estado finito para gerenciar os estados e transições dentro do kernel:

- Gerenciamento de Estado : o FSM garante comportamento confiável e previsível dos componentes da IA, definindo claramente estados e transições.

- Manuseio de erros : o FSM fornece mecanismos estruturados de manuseio e recuperação de erros, melhorando a estabilidade do sistema.

- Escalabilidade : A arquitetura FSM suporta requisitos complexos de gerenciamento de estado, tornando -o adequado para funcionalidades avançadas de IA.

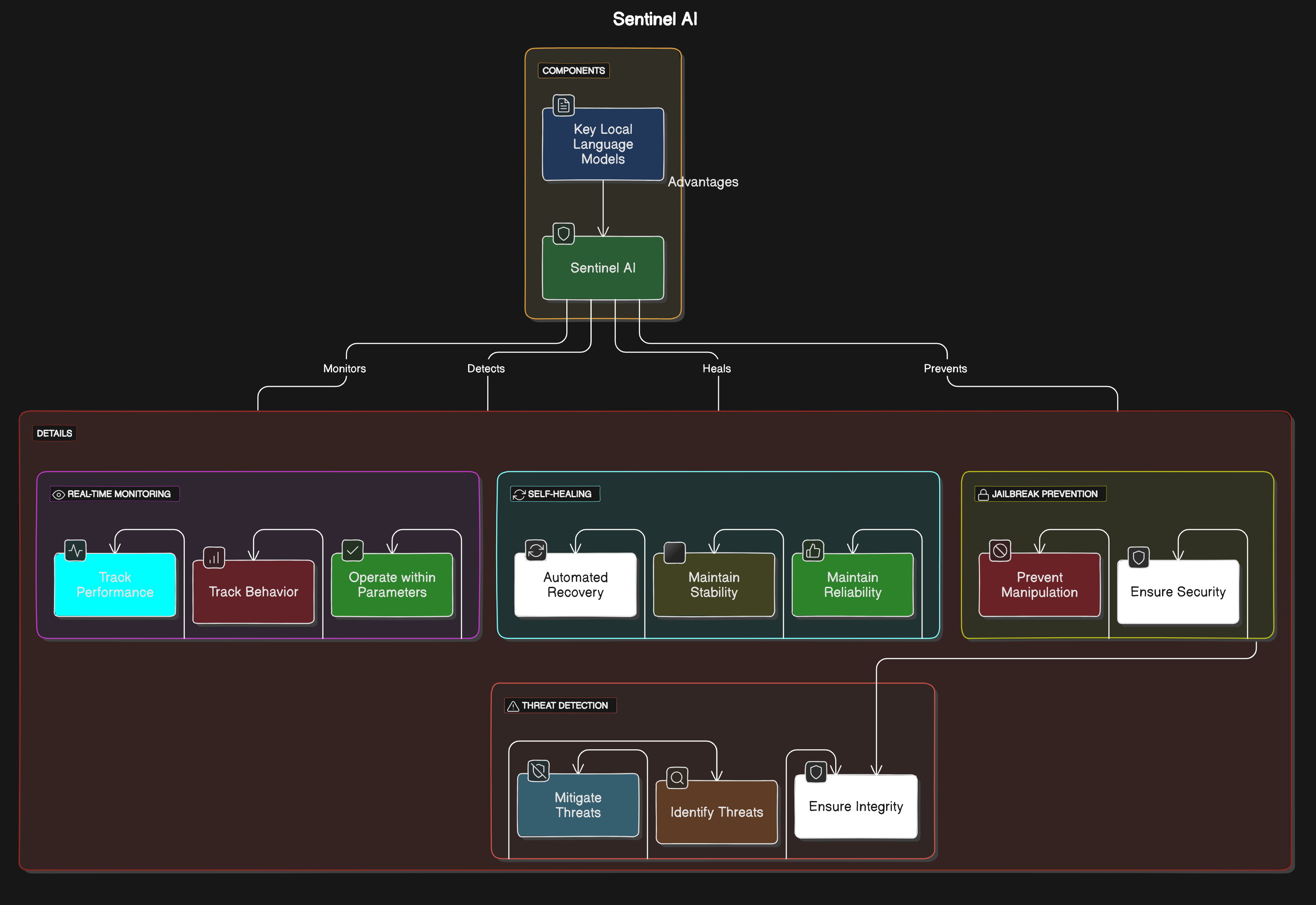

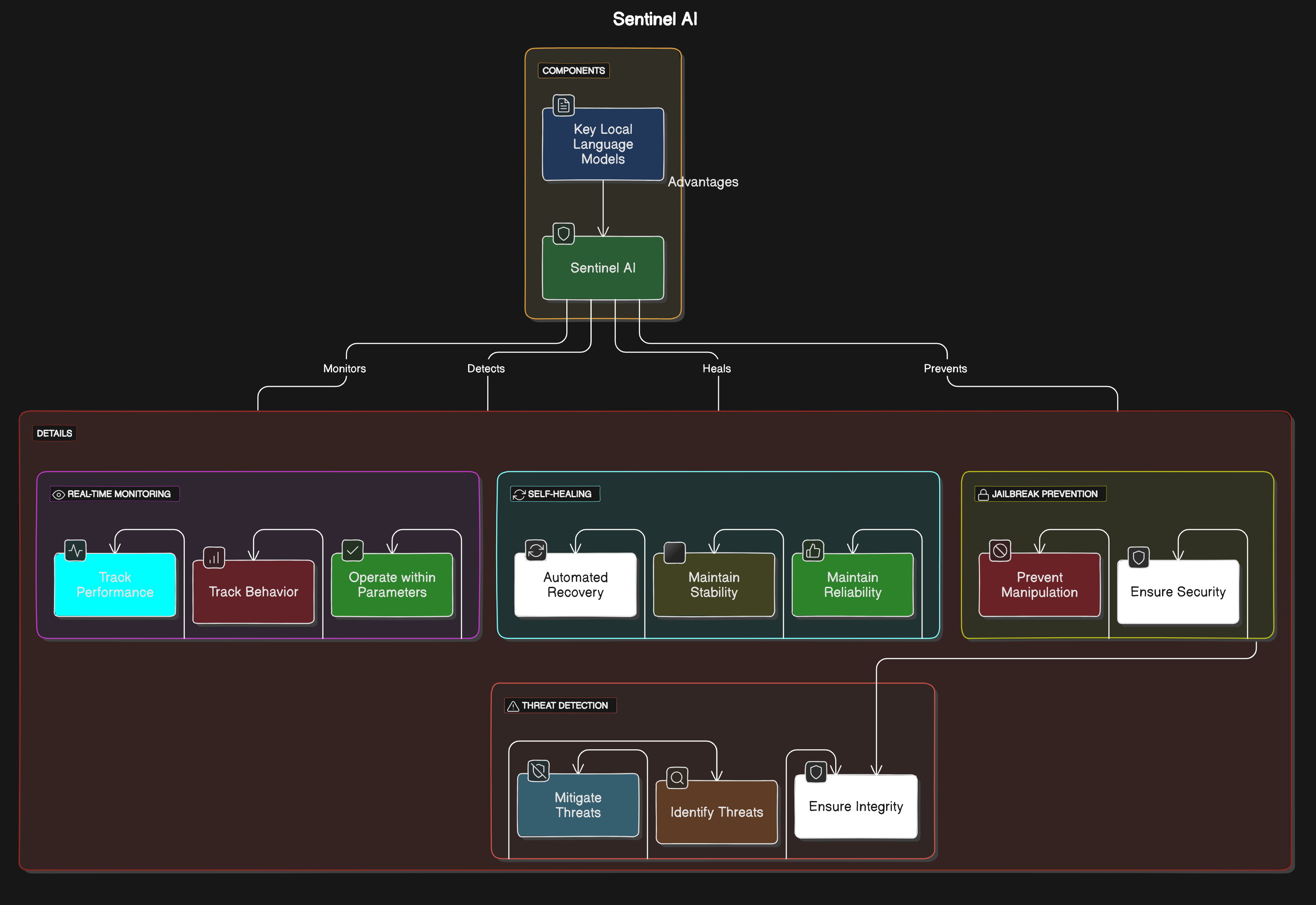

Sentinel AI

O Sentinel AI é um recurso avançado de monitoramento e segurança integrado no KLLM. Ele fornece monitoramento e proteção em tempo real para modelos e aplicativos de IA:

O Sentinel AI é um recurso avançado de monitoramento e segurança integrado no KLLM. Ele fornece monitoramento e proteção em tempo real para modelos e aplicativos de IA:

- Monitoramento em tempo real : rastreia continuamente o desempenho e o comportamento dos modelos de IA, garantindo que eles operem dentro dos parâmetros esperados.

- Detecção de ameaças : identifica e mitiga ameaças ou anomalias em potencial nas operações de IA, protegendo contra atividades maliciosas e garantindo a integridade do sistema.

- Auto-cicatrização : implementa mecanismos automatizados de recuperação para resolver problemas detectados, mantendo a estabilidade e a confiabilidade do sistema sem intervenção manual.

- Prevenção de jailbreak : As estratégias são empregadas para impedir a manipulação não autorizada dos modelos e sistemas de IA, mantendo a integridade e a segurança das funcionalidades da IA.

Tarefa, comportamento, ato

A estrutura "tarefa, comportamento, ato" é uma pedra angular da KLLM, orientando a maneira como os modelos de IA operam, aprendem e interagem dentro do sistema. Essa estrutura garante que os componentes da IA não sejam apenas funcionais, mas também adaptáveis, eficientes e fáceis de usar.

Tarefa

Definição : as tarefas são os objetivos ou funções específicos que os modelos de IA são projetados para realizar. Essas tarefas são definidas com base nas necessidades do usuário e nos requisitos do sistema.

Exemplos :

- Reconhecimento de voz : compreensão e resposta aos comandos de voz.

- Previsão de texto : previsão e sugerindo entradas de texto.

- Análise de dados : Analisando os dados do usuário para fornecer informações ou recomendações.

Implementação :

- Alocação de tarefas modulares : quebrar tarefas complexas em subtareas menores e gerenciáveis para processamento eficiente.

- Atribuição de tarefas dinâmicas : atribuindo tarefas com base no status atual do sistema e na disponibilidade de recursos.

Comportamento

Definição : Comportamentos são os métodos e padrões pelos quais os modelos de IA executam tarefas. Isso inclui como os modelos processam dados, interagem com os usuários e se adaptam às alterações.

Exemplos :

- Processamento com reconhecimento de contexto : ajustando as respostas com base em informações contextuais, como localização do usuário, hora do dia e interações anteriores.

- Aprendizagem adaptativa : aprendendo continuamente com as interações do usuário para melhorar o desempenho e a precisão.

Implementação :

- Modelos comportamentais : desenvolver modelos que encapsulam comportamentos específicos para diferentes tarefas.

- Adaptação contextual : implementando algoritmos que permitem que os modelos adaptem seu comportamento com base no contexto em tempo real.

Agir

Definição : Atos são os resultados ou ações tomadas pelos modelos de IA em resposta a tarefas e comportamentos. Esses atos são os resultados tangíveis do processamento e tomada de decisão da IA.

Exemplos :

- Comandos de execução : executando instruções do usuário, como abrir um aplicativo ou enviar uma mensagem.

- Fornecendo feedback : oferecendo sugestões ou correções com base na entrada do usuário.

- Processos de automação : executando tarefas de rotina automaticamente, como ajustar as configurações ou enviar notificações.

Implementação :

- Módulos de ação : Desenvolvimento de módulos que traduzem decisões de IA em ações executáveis.

- Loops de feedback : criando sistemas que permitem que a IA receba e processe feedback sobre suas ações para melhorar o desempenho futuro.

Memória?

Definição : a memória permite que os modelos de IA lembrem experiências e interações passadas, permitindo que eles forneçam respostas mais relevantes e contextuais ao longo do tempo.

Implementação :

- Experiência Replay : Armazenando e reproduzindo interações passadas para reforçar o aprendizado.

- Memória contextual : retendo informações específicas do contexto para personalizar as interações do usuário.

Auto-refinamento?

Definição : O auto-refinamento permite que os modelos de IA melhorem seu desempenho, abordando as críticas e aprendendo com o feedback.

Implementação :

- Análise de feedback : analisando continuamente o feedback do usuário para identificar áreas para melhorar.

- Refinamento iterativo : implementando processos iterativos para refinar as saídas do modelo com base no feedback.

Comprimir conhecimento

Definição : a compactação do conhecimento envolve destilar grandes quantidades de informações em um formato compacto e utilizável que se encaixa no contexto do modelo de IA.

Implementação :

- Abstração do conhecimento : abstrair regras e padrões de grandes conjuntos de dados.

- Resumo do conteúdo : Resumindo o conteúdo extenso para extrair informações essenciais.

Inferência

Definição : A inferência permite que os modelos de IA façam suposições educadas com base nas informações disponíveis, mesmo quando os dados são incompletos ou ambíguos.

Implementação :

- Modelagem preditiva : usando modelos estatísticos para prever resultados com base nos dados de entrada.

- Geração de hipóteses : gerando e testando hipóteses para inferir informações ausentes.

Condições de linguagem natural

Definição : As condições de linguagem natural permitem que os usuários expressem escolhas e condições em linguagem natural, tornando as interações mais intuitivas.

Implementação :

- Parsing de idiomas : implementando o processamento de linguagem natural para interpretar os comandos e condições do usuário.

- Avaliação da condição : Avaliando condições expressas na linguagem natural para orientar as ações da IA.

Dispositivos

O KLLM foi projetado para ser compatível com uma ampla gama de dispositivos, garantindo versatilidade e ampla aplicabilidade. Os dispositivos adequados incluem:

- Laptops e desktops : computadores com energia suficiente para executar modelos de IA localmente.

- Smartphones : dispositivos móveis que se beneficiam da IA no dispositivo para obter funcionalidade aprimorada e recursos offline.

- Tablets : Dispositivos portáteis Aproveitando a IA local para obter melhores interações e desempenho.

- Smartwatches : wearables usando pequenos modelos de idiomas para comandos e notificações de voz.

- Dispositivos domésticos inteligentes : dispositivos IoT, como alto -falantes inteligentes e assistentes domésticos, usando a IA para automação e controle.

- Dispositivos de borda : dispositivos de computação na borda da rede, executando modelos de IA localmente para reduzir a latência.

- Robótica e sistemas ciber-físicos : sistemas movidos a IA para navegação, assistência e detecção em veículos e drones.

- Dispositivos de saúde : dispositivos médicos e wearables usando IA para monitoramento da saúde e recomendações personalizadas.

- Equipamento industrial : máquinas usando IA para manutenção preditiva, otimização de processos e automação.

- Sistemas incorporados : dispositivos especializados com IA integrada para funções específicas, exigindo baixa potência e alta eficiência, como microcontroladores e aceleradores de hardware dedicados.

Linguagens de programação

O KLLM é desenvolvido usando uma combinação das seguintes linguagens de programação para garantir o desempenho, compatibilidade e flexibilidade ideais:

- C/C ++ : para o desenvolvimento do núcleo do núcleo e componentes críticos de desempenho.

- Java : Para criar aplicativos robustos e independentes da plataforma.

- Kotlin : Para desenvolvimento moderno, conciso e seguro do Android.

- DART : Para a construção de aplicativos móveis rápidos, nativos e de plataforma cruzada.

- RUST : Para programação no nível do sistema com segurança e simultaneidade.

- Python : Para scripts, automação e prototipagem rápida.

- JavaScript/HTML/CSS : para criar aplicativos baseados na Web com recursos de IA integrados usando WebOS.

Conformidade com dados

A KLLM está comprometida em garantir a conformidade dos dados com os padrões e regulamentos do setor para proteger os dados do usuário e manter a privacidade. As principais medidas de conformidade incluem:

- Criptografia de dados : Todos os dados transmitidos e armazenados são criptografados para proteger contra acesso não autorizado.

- Controles de acesso : Implementando controles rígidos de acesso para garantir que apenas o pessoal autorizado possa acessar dados confidenciais.

- Anonimização dos dados : os dados pessoais são anonimizados para impedir que a identificação de indivíduos dos dados.

- Conformidade regulatória : adesão aos regulamentos relevantes de proteção de dados, como GDPR, CCPA e HIPAA, garantindo que todas as práticas de manuseio de dados cumpram os requisitos legais.

Conformidade com o modelo

O KLLM garante que todos os modelos de IA cumpram as diretrizes éticas e os padrões do setor para promover a justiça, a transparência e a responsabilidade. As principais medidas de conformidade incluem:

- Mitigação de viés : Implementando técnicas para identificar e reduzir o viés nos modelos de IA para garantir resultados justos e equitativos.

- Transparência : fornecendo documentação clara sobre o desenvolvimento do modelo, dados de treinamento e processos de tomada de decisão para melhorar a transparência.

- Responsabilidade : Estabelecendo mecanismos para monitorar e auditar o desempenho do modelo de IA para garantir a responsabilidade e a melhoria contínua.

- Padrões éticos : aderir às diretrizes éticas para o desenvolvimento e implantação da IA, promovendo o uso ético e responsável das tecnologias de IA.

Licença de Foss

O KLLM é liberado sob a licença do MIT, uma licença de software livre permissiva que permite reutilização, modificação e distribuição. O texto completo da licença está disponível no arquivo LICENSE . Os principais pontos da licença do MIT incluem:

- Permissão : a permissão é concedida para usar, copiar, modificar e distribuir o software.

- Atribuição : a licença exige que o aviso original de direitos autorais e o aviso de permissão sejam incluídos em todas as cópias ou em partes substanciais do software.

- Responsabilidade : o software é fornecido "como está", sem garantia de qualquer tipo, expresso ou implícito, incluindo, entre outros, as garantias de comercialização, aptidão para uma finalidade específica e não comprometimento.

Licença

O KLLM está licenciado sob a licença do MIT. Consulte o arquivo LICENSE para obter mais detalhes.

O KLLM inclui modelos de linguagem menor e otimizado (LMS pequenos) adaptados para funcionalidades específicas do dispositivo. Esses modelos aprimoram a capacidade do dispositivo de entender e responder aos comandos do usuário com eficiência:

O KLLM inclui modelos de linguagem menor e otimizado (LMS pequenos) adaptados para funcionalidades específicas do dispositivo. Esses modelos aprimoram a capacidade do dispositivo de entender e responder aos comandos do usuário com eficiência: Ao integrar os recursos cognitivos diretamente no sistema operacional móvel, o KLLM permite interações mais inteligentes e intuitivas entre os usuários e seus dispositivos:

Ao integrar os recursos cognitivos diretamente no sistema operacional móvel, o KLLM permite interações mais inteligentes e intuitivas entre os usuários e seus dispositivos: A KLLM utiliza uma arquitetura robusta de máquinas de estado finito para gerenciar os estados e transições dentro do kernel:

A KLLM utiliza uma arquitetura robusta de máquinas de estado finito para gerenciar os estados e transições dentro do kernel: O Sentinel AI é um recurso avançado de monitoramento e segurança integrado no KLLM. Ele fornece monitoramento e proteção em tempo real para modelos e aplicativos de IA:

O Sentinel AI é um recurso avançado de monitoramento e segurança integrado no KLLM. Ele fornece monitoramento e proteção em tempo real para modelos e aplicativos de IA: