Kllm: Sprachmodell auf Kernelebene

Willkommen bei Kllm, einem fortschrittlichen Projekt, das sich auf Kernkern-KI-Entwicklung konzentriert und in der LPMS (On-Device-Sprachmodelle) für effiziente und leistungsstarke KI-Funktionen integriert wird.

Überblick

Kllm steht für das Sprachmodell auf Kernel-Ebene, ein modernes Framework, das Sprachmodelle direkt auf Kernelebene injiziert. Dieses Projekt zielt darauf ab, die Integration von KI in das Kernbetriebssystem zu revolutionieren und für die Anwendungen von On-Device-Anwendungen eine nahtlose und energieeffiziente Leistung zu erzielen.

Merkmale

Kernkern -KI -Entwicklung

Kllm nutzt die Kraft des Kernels und stellt sicher, dass die KI -Funktionen tief in das System integriert sind. Diese tiefe Integration ermöglicht eine schnellere und effizientere Verarbeitung von KI -Aufgaben, da die Kernfunktionalitäten auf der niedrigsten Ebene des Betriebssystems eingebettet sind. Dieser Ansatz minimiert die Latenz, verbessert die Sicherheit und bietet eine stabile Grundlage für das Ausführen komplexer KI -Modelle. Darüber hinaus werden robuste Codierungsmethoden verwendet, um die Datenintegrität und den schnellen Zugriff aufrechtzuerhalten.

On-Device LMS

Kllm konzentriert sich darauf, KI-Modelle und Anwendungen direkt auf persönliche Geräte wie Laptops, Smartphones oder Kantengeräte auszuführen, anstatt sich auf Cloud-basierte Dienste zu verlassen. Diese lokale Integration bringt mehrere transformative Vorteile mit sich:

- Privatsphäre : Stellen Sie sicher, dass sensible Daten das Gerät niemals verlassen, die Privatsphäre des Benutzers schützen und das Risiko von Datenverletzungen verringern. Persönliche Informationen und Benutzerinteraktionen werden im Gerät verarbeitet und gespeichert, wodurch die Übertragung von Daten auf externe Server übertragen werden muss.

- Kosteneffizienz : Durch die Beseitigung der Notwendigkeit teurer Cloud-basierter Ressourcen reduziert KlLLM die laufenden Betriebskosten, die mit Datenübertragung, Cloud-Speicher und Computerdiensten verbunden sind. Dies macht KI sowohl für Entwickler als auch für Endbenutzer zugänglicher und erschwinglicher.

- Kulturelle Relevanz : Ermöglicht die Anpassung und Anpassung von Sprachmodellen, um sich besser an den Lokalsprachen, Dialekten und kulturellen Nuancen auszurichten. Dies verbessert die Benutzererfahrung, indem genauere und kontextbezogene Interaktionen bereitgestellt werden.

- Systemzuverlässigkeit : Die Verringerung der Abhängigkeit von Internetverbindungen und Cloud -Dienste verbessert die Zuverlässigkeit und Verfügbarkeit von AI -Anwendungen. Kllm stellt sicher, dass die KI-Funktionen auch in offline- oder niedrigen Konnektivitätsumgebungen weiterhin nahtlos funktionieren. Leitplanken werden implementiert, um zu verhindern, dass KI -Modelle unbeabsichtigte Maßnahmen ausführen und ein sicheres und zuverlässiges Verhalten sicherstellen.

Energieeffizienter LMS

Kllm implementiert Pseudo-Ebene-Schichttechniken, die eine modularere und flexiblere Kernelarchitektur bieten. Dieser Ansatz bietet mehrere Vorteile:

- Modularität : Das Aufteilen des Kernels in kleinere, überschaubare Schichten ermöglicht eine einfachere Aktualisierung und Wartung. Jede Schicht kann unabhängig voneinander entwickelt, getestet und aktualisiert werden.

- Flexibilität : Das modulare Design erleichtert die Integration neuer Merkmale und Funktionen, ohne das gesamte System zu stören.

- Skalierbarkeit : Die Schicht auf Pseudoebene unterstützt die Skalierung des Kernels, um unterschiedliche Gerätetypen und Leistungsanforderungen zu erfüllen.

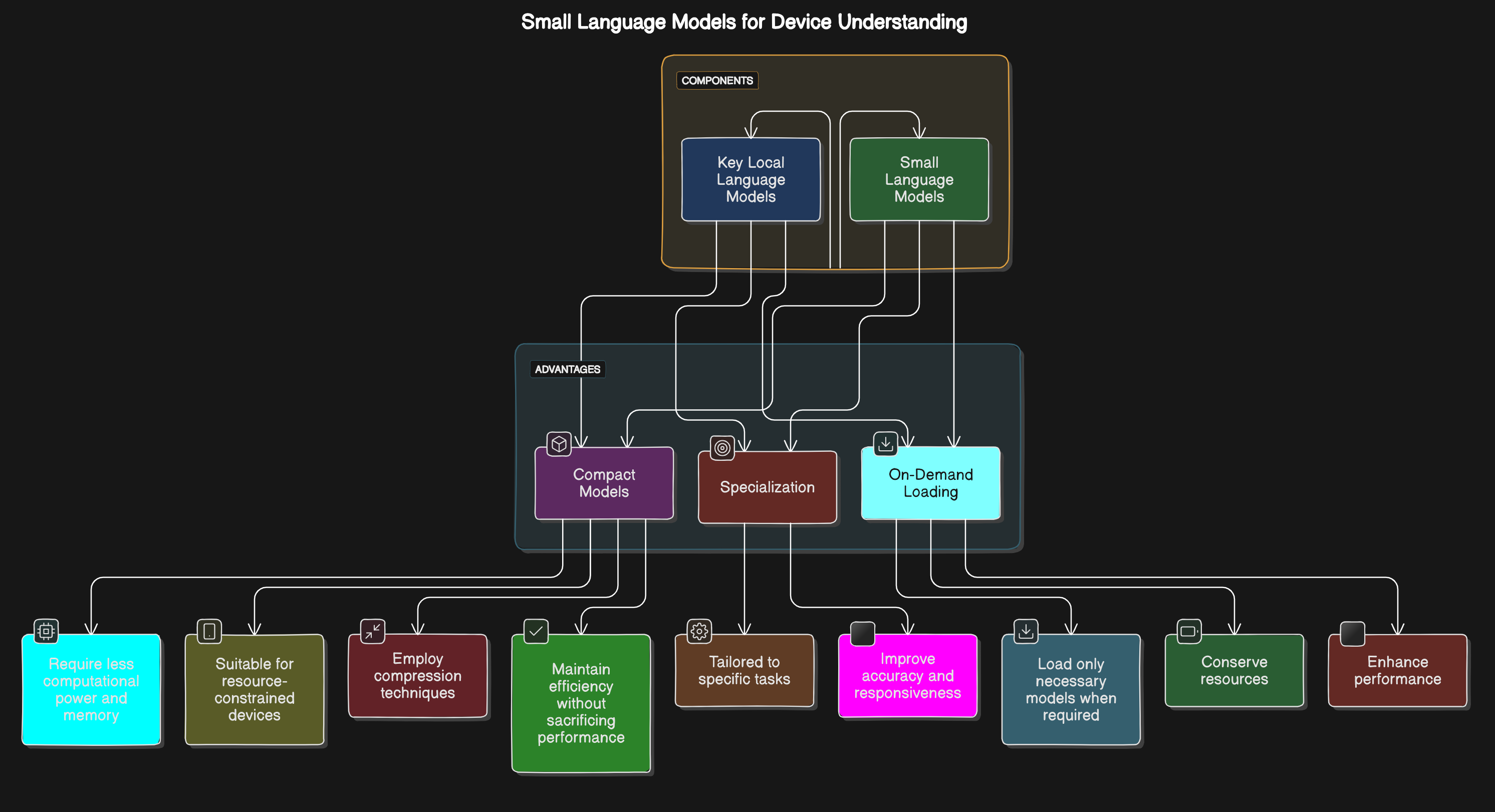

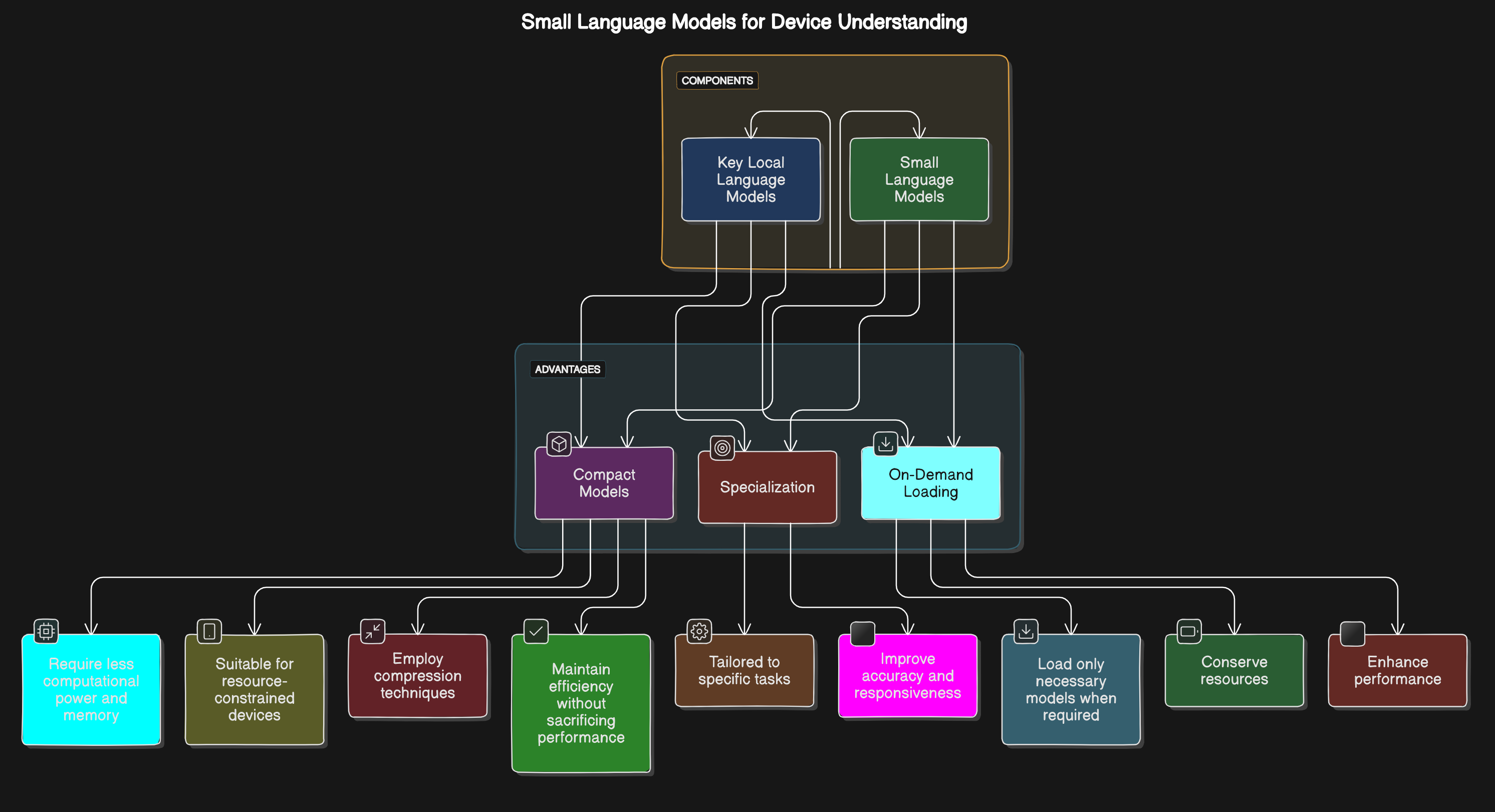

Kleine Sprachmodelle für Geräteverständnis

Kllm enthält kleinere, optimierte Sprachmodelle (kleine LMS), die auf bestimmte Gerätefunktionen zugeschnitten sind. Diese Modelle verbessern die Fähigkeit des Geräts, Benutzerbefehle effizient zu verstehen und auf Benutzerbefehle zu reagieren:

Kllm enthält kleinere, optimierte Sprachmodelle (kleine LMS), die auf bestimmte Gerätefunktionen zugeschnitten sind. Diese Modelle verbessern die Fähigkeit des Geräts, Benutzerbefehle effizient zu verstehen und auf Benutzerbefehle zu reagieren:

- Kompakte Modelle : Kleinere Modelle erfordern weniger Rechenleistung und Speicher, wodurch sie für ressourcenbezogene Geräte geeignet sind. Kompressionstechniken werden eingesetzt, um die Modelleffizienz aufrechtzuerhalten, ohne die Leistung zu beeinträchtigen.

- Spezialisierung : Anpassung von Modellen auf bestimmte Aufgaben (z. B. Sprachbefehle, Textvorhersagen) verbessert die Genauigkeit und Reaktionsfähigkeit.

- On-Demand-Beladung : Laden nur die erforderlichen Modelle, wenn die erforderlichen Bedarfsartikel erhalten und die Leistung verbessert.

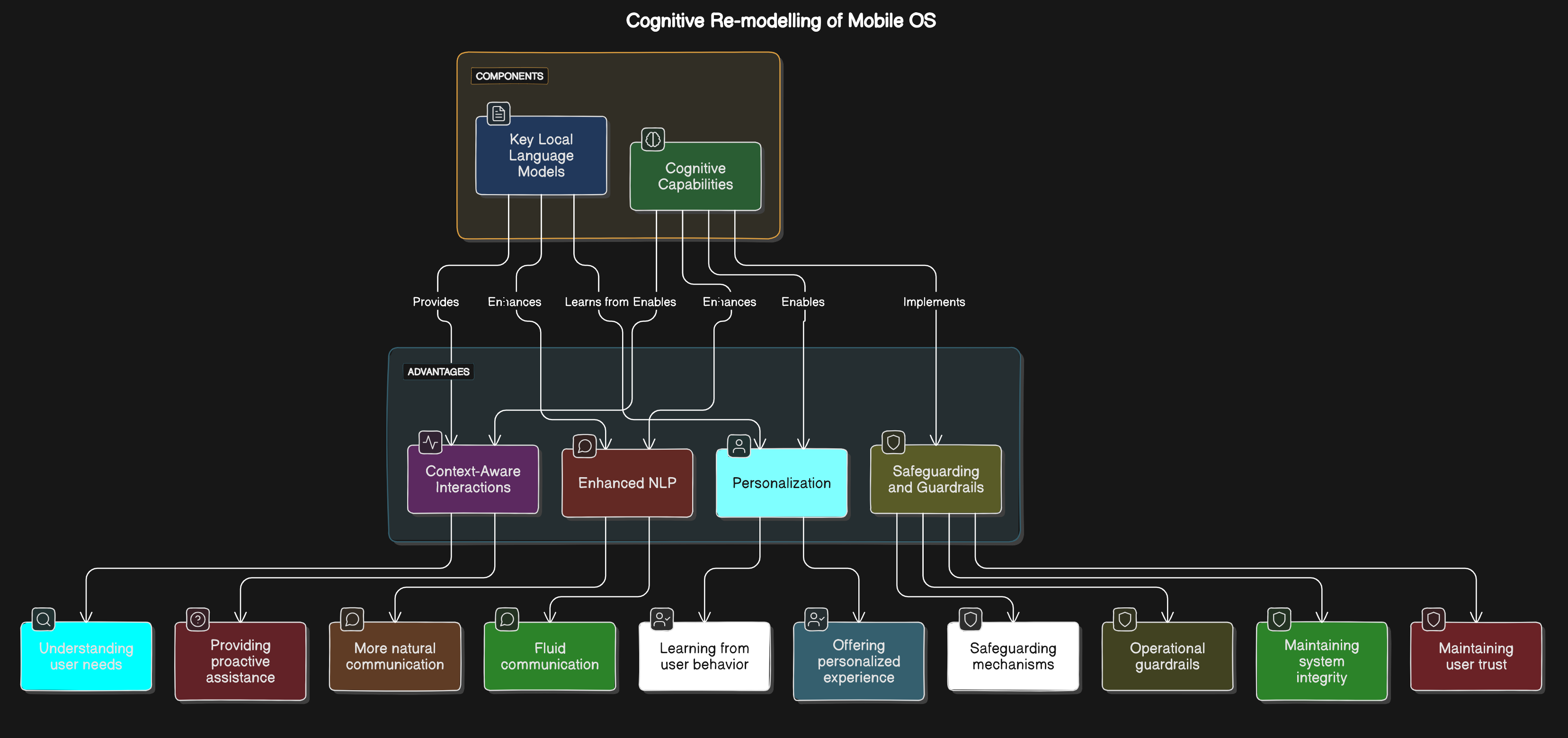

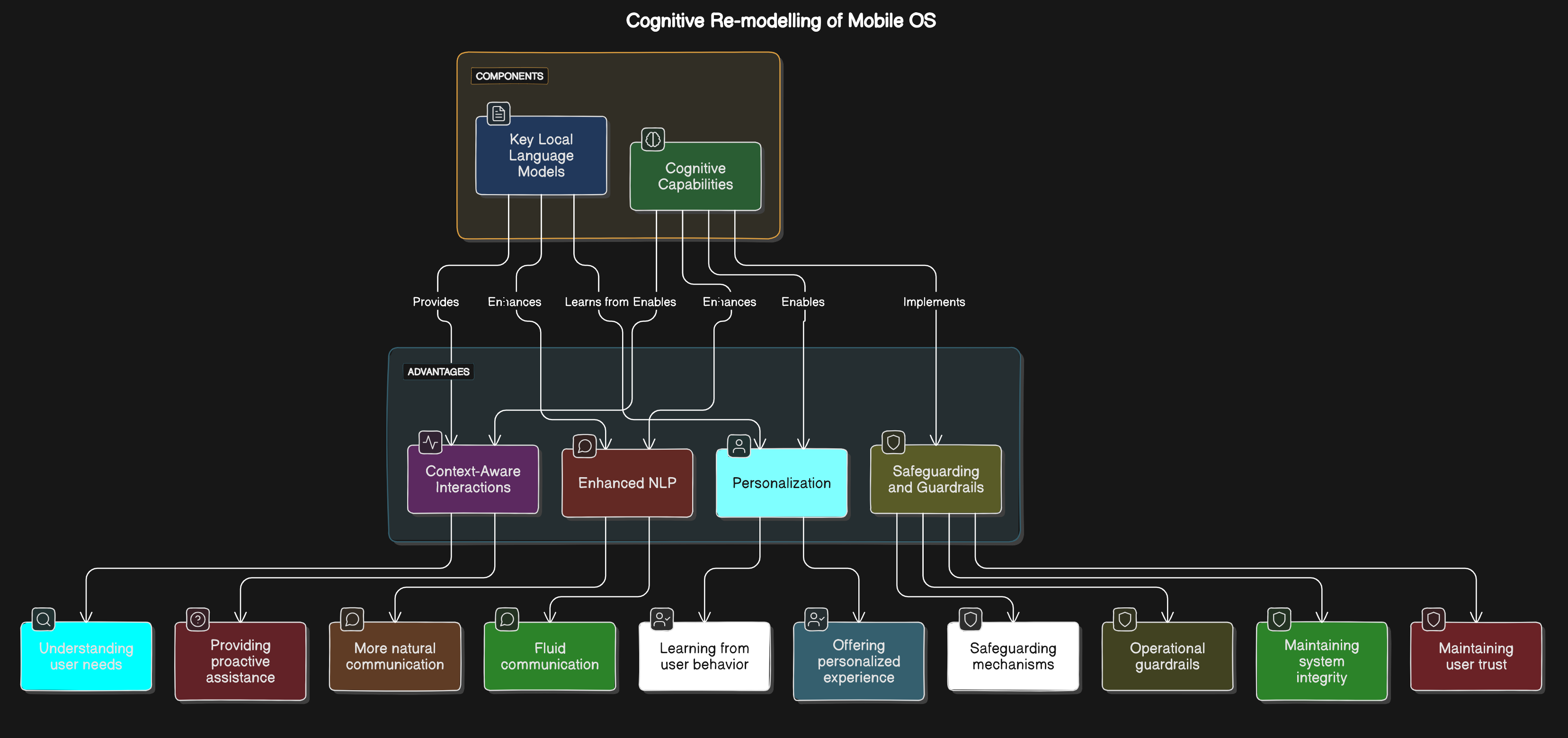

Kognitive Neumodell des mobilen Betriebssystems

Durch die Integration kognitiver Funktionen direkt in das mobile Betriebssystem ermöglicht Kllm intelligentere und intuitivere Interaktionen zwischen Benutzern und ihren Geräten:

Durch die Integration kognitiver Funktionen direkt in das mobile Betriebssystem ermöglicht Kllm intelligentere und intuitivere Interaktionen zwischen Benutzern und ihren Geräten:

- Kontextbewusste Interaktionen : Das Betriebssystem kann die Benutzerbedürfnisse auf der Grundlage des Kontextes verstehen und vorwegnehmen und proaktive Unterstützung leisten.

- Verarbeitung natürlicher Sprache : Verbesserte NLP -Funktionen ermöglichen eine natürlichere und flüssige Kommunikation mit dem Gerät.

- Personalisierung : Das kognitive Neumodell ermöglicht es dem Betriebssystem, aus dem Benutzerverhalten und den Vorlieben zu lernen und eine personalisierte Erfahrung zu bieten.

- Sicherung und Leitplanken : Implementieren von Schutzmechanismen und operativen Leitplanken stellt sicher, dass KI -Komponenten innerhalb vordefinierter sicherer Grenzen und der Aufrechterhaltung der Systemintegrität und des Benutzervertrauens aufrechterhalten werden.

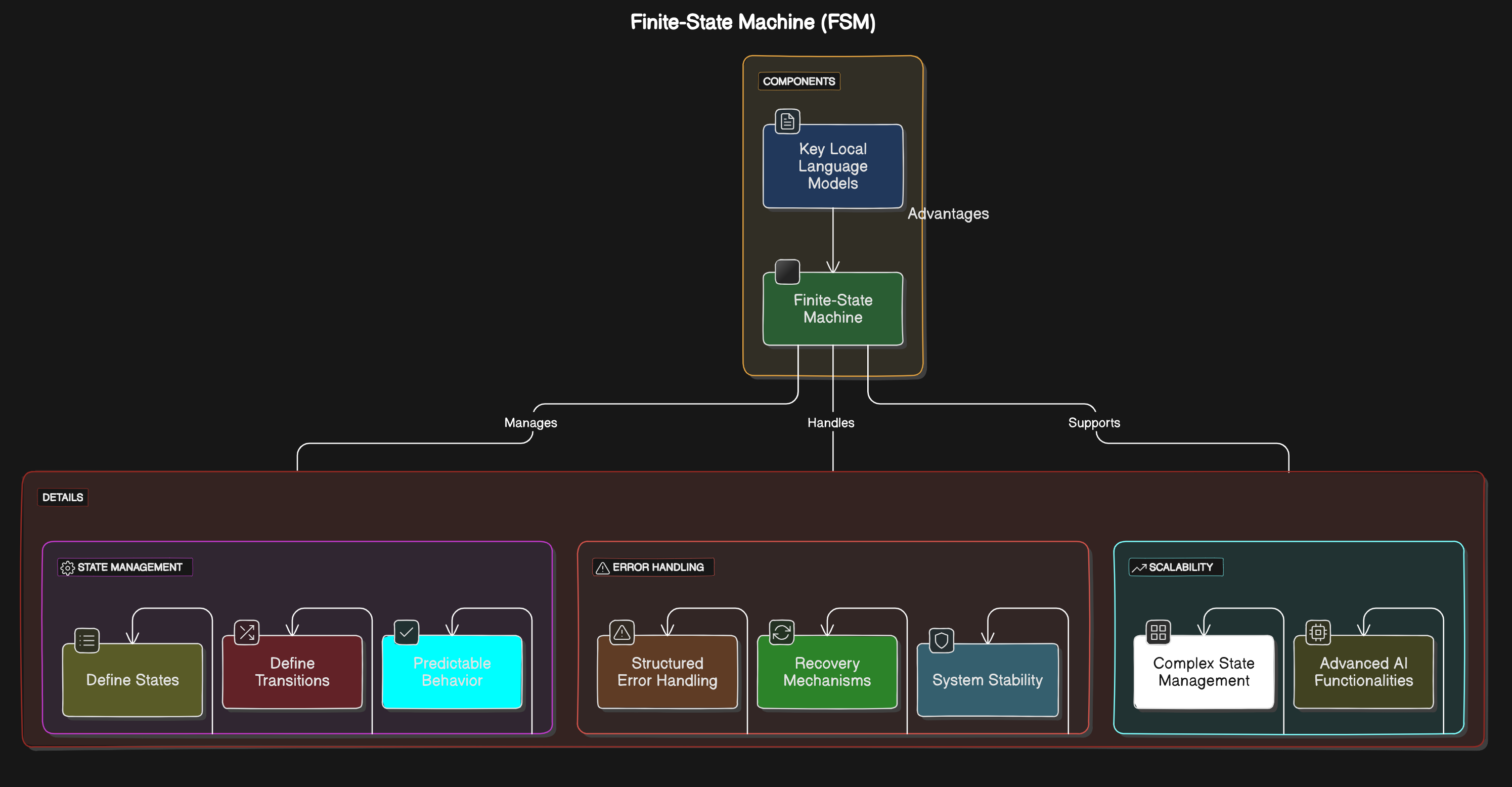

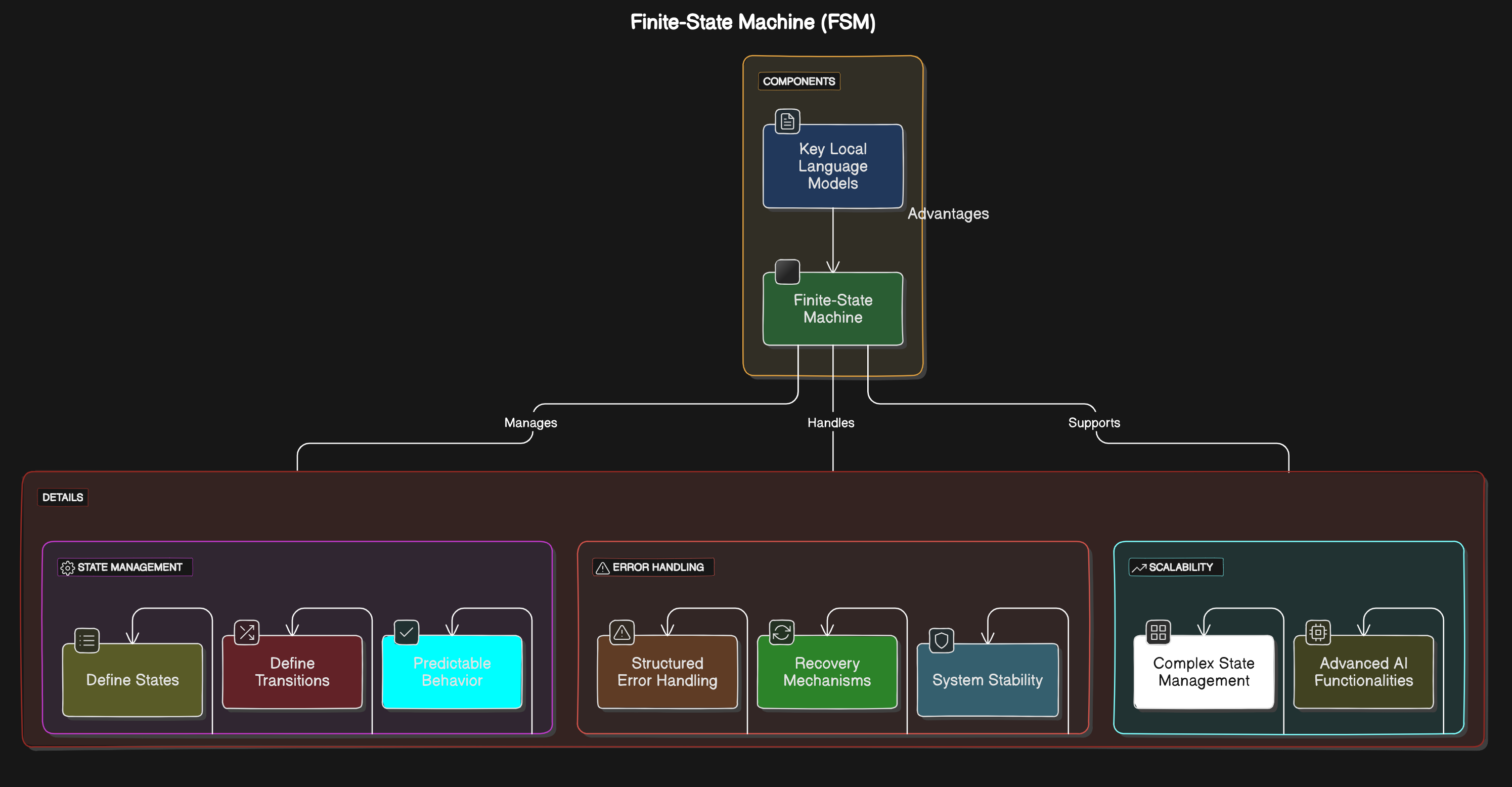

Finite-State-Maschine (FSM)

Kllm verwendet eine robuste Finite-State-Maschinenarchitektur, um die Zustände und Übergänge innerhalb des Kernels zu verwalten:

Kllm verwendet eine robuste Finite-State-Maschinenarchitektur, um die Zustände und Übergänge innerhalb des Kernels zu verwalten:

- Staatsmanagement : FSM sorgt für ein verlässliches und vorhersehbares Verhalten von AI -Komponenten, indem Staaten und Übergänge klar definiert werden.

- Fehlerbehandlung : FSM bietet strukturierte Fehler- und Wiederherstellungsmechanismen und verbesserte Systemstabilität.

- Skalierbarkeit : Die FSM -Architektur unterstützt komplexe staatliche Verwaltungsanforderungen und ist für fortschrittliche KI -Funktionen geeignet.

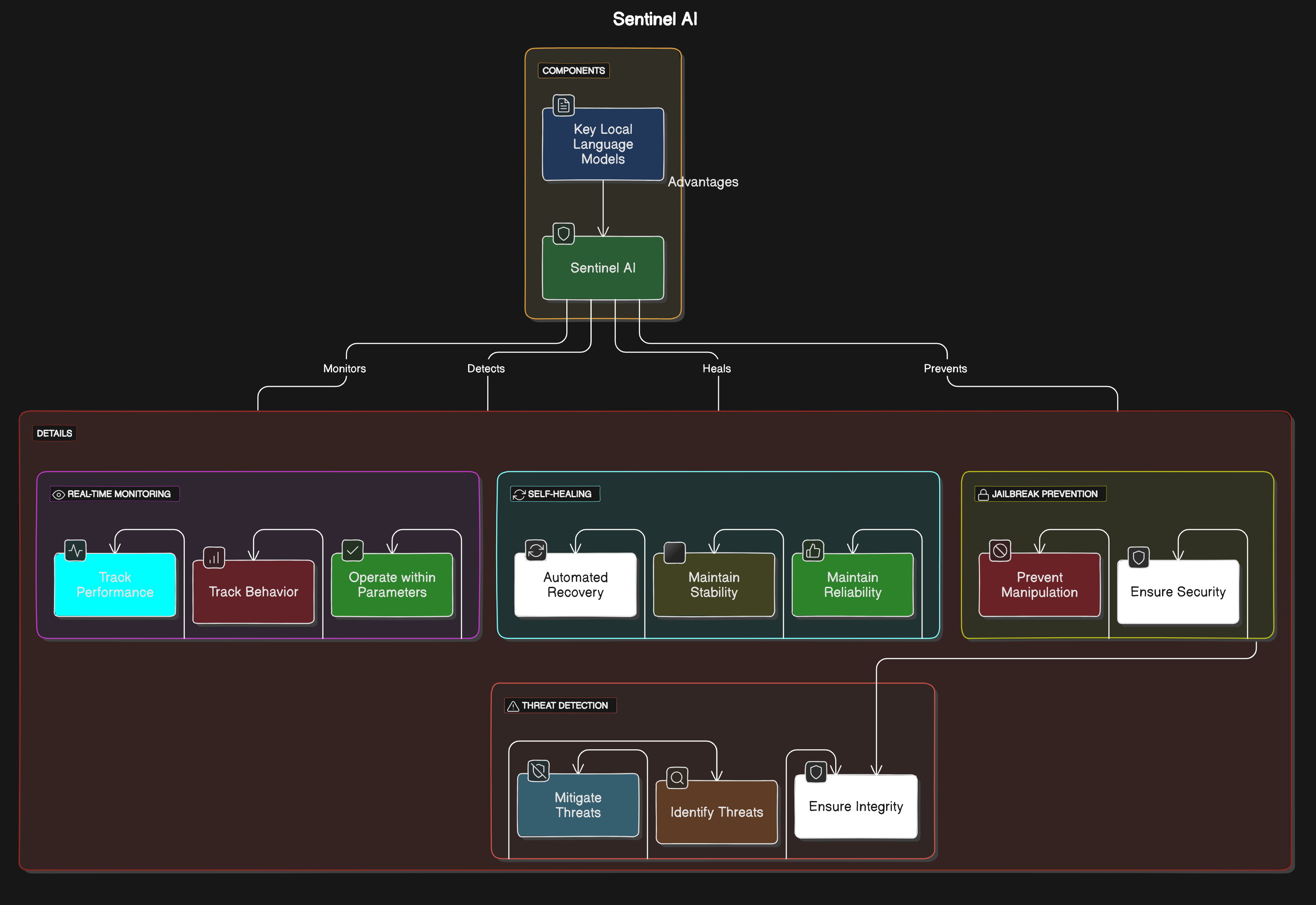

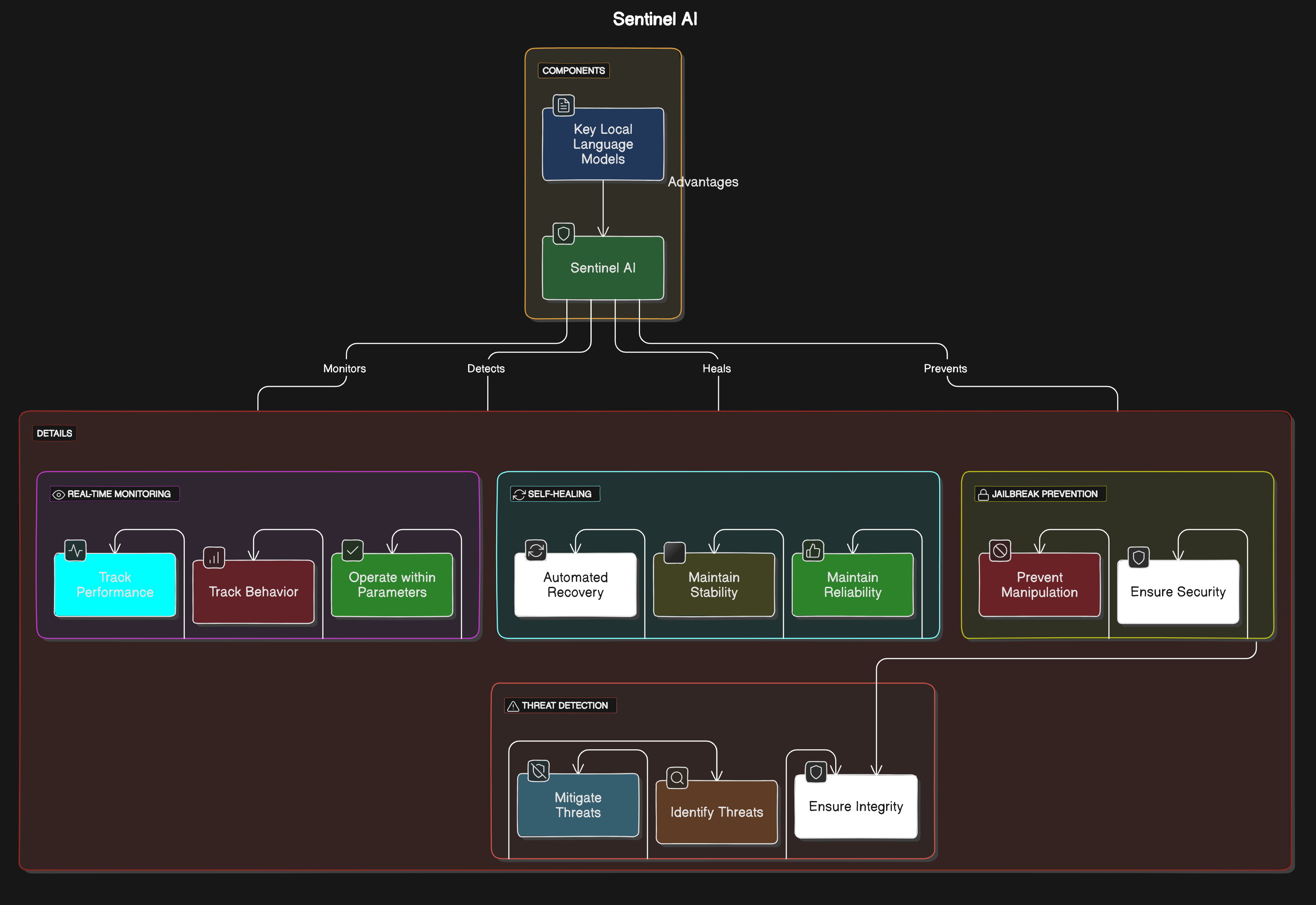

Sentinel Ai

Sentinel AI ist eine in Kllm integrierte erweiterte Überwachungs- und Sicherheitsfunktion. Es bietet Echtzeitüberwachung und Schutz für KI-Modelle und Anwendungen:

Sentinel AI ist eine in Kllm integrierte erweiterte Überwachungs- und Sicherheitsfunktion. Es bietet Echtzeitüberwachung und Schutz für KI-Modelle und Anwendungen:

- Echtzeitüberwachung : Verfolgt kontinuierlich die Leistung und das Verhalten von KI-Modellen, um sicherzustellen, dass sie innerhalb der erwarteten Parameter arbeiten.

- Bedrohungserkennung : Identifiziert und mindert potenzielle Bedrohungen oder Anomalien im KI -Betrieb, schützt vor böswilligen Aktivitäten und die Gewährleistung der Systemintegrität.

- Selbstheilung : Implementiert automatisierte Wiederherstellungsmechanismen, um erkannte Probleme anzugehen und die Systemstabilität und Zuverlässigkeit ohne manuelle Eingriff aufrechtzuerhalten.

- Jailbreak -Prävention : Es werden Strategien eingesetzt, um eine nicht autorisierte Manipulation von KI -Modellen und -systemen zu verhindern und die Integrität und Sicherheit der KI -Funktionen aufrechtzuerhalten.

Aufgabe, Verhalten, Handlung

Das Framework "Aufgabe, Verhalten, Act" ist ein Eckpfeiler von Kllm, der leitet, wie KI -Modelle im System arbeiten, lernen und interagieren. Dieses Framework stellt sicher, dass KI-Komponenten nicht nur funktional, sondern auch adaptiv, effizient und benutzerfreundlich sind.

Aufgabe

Definition : Aufgaben sind die spezifischen Ziele oder Funktionen, die die KI -Modelle erfüllen sollen. Diese Aufgaben werden basierend auf den Bedürfnissen und Systemanforderungen der Benutzer definiert.

Beispiele :

- Spracherkennung : Verständnis und Reaktion auf Sprachbefehle.

- Textvorhersage : Vorhersagen und Vorschlag von Texteingaben.

- Datenanalyse : Analyse von Benutzerdaten, um Erkenntnisse oder Empfehlungen bereitzustellen.

Implementierung :

- Modulare Aufgabenzuweisung : Komplexe Aufgaben in kleinere, überschaubare Unteraufgaben für die effiziente Verarbeitung zerlegen.

- Dynamische Aufgabenzuweisung : Zuweisen von Aufgaben basierend auf dem aktuellen Systemstatus und der Verfügbarkeit von Ressourcen.

Verhalten

Definition : Verhaltensweisen sind die Methoden und Muster, durch die die KI -Modelle Aufgaben ausführen. Dies schließt die Art und Weise ein, wie die Modelle Daten verarbeiten, mit Benutzern interagieren und sich an Änderungen anpassen.

Beispiele :

- Kontextbewusste Verarbeitung : Anpassung von Antworten basierend auf Kontextinformationen wie Benutzerstandort, Tageszeit und früheren Interaktionen.

- Adaptives Lernen : kontinuierliches Lernen aus Benutzerinteraktionen zur Verbesserung der Leistung und Genauigkeit.

Implementierung :

- Verhaltensmodelle : Entwicklung von Modellen, die spezifische Verhaltensweisen für verschiedene Aufgaben zusammenfassen.

- Kontextanpassung : Implementierung von Algorithmen, mit denen Modelle ihr Verhalten anhand von Echtzeitkontext anpassen können.

Akt

Definition : Handlungen sind die Ergebnisse oder Handlungen der KI -Modelle als Reaktion auf Aufgaben und Verhaltensweisen. Diese Handlungen sind die konkreten Ergebnisse der Verarbeitung und Entscheidungsfindung der KI.

Beispiele :

- Ausführungsbefehle : Benutzeranweisungen wie das Öffnen einer App oder das Senden einer Nachricht ausführen.

- Bereitstellung von Feedback : Vorschläge oder Korrekturen basierend auf Benutzereingaben.

- Prozesse automatisieren : automatisch Routineaufgaben ausführen, z. B. Anpassung der Einstellungen oder das Senden von Benachrichtigungen.

Implementierung :

- Aktionsmodule : Entwicklung von Modulen, die KI -Entscheidungen in ausführbare Aktionen umsetzen.

- Feedback -Schleifen : Erstellen von Systemen, mit denen die KI Feedback zu ihren Aktionen empfangen und verarbeiten kann, um die zukünftige Leistung zu verbessern.

Erinnerung ?

Definition : Gedächtnis ermöglicht KI -Modellen, sich an vergangene Erfahrungen und Interaktionen zu erinnern, sodass sie im Laufe der Zeit relevantere und kontextbezogene Antworten liefern können.

Implementierung :

- Erfahrung Wiederholung : Speichern und Wiederholung vergangener Interaktionen, um das Lernen zu verstärken.

- Kontextspeicher : Kontextspezifische Informationen zur Personalisierung der Benutzerinteraktionen beibehalten.

Selbstbekämpfung?

Definition : Selbstbekämpfung ermöglicht es KI-Modellen, ihre Leistung zu verbessern, indem Kritikpunkte und das Lernen aus dem Feedback angesprochen werden.

Implementierung :

- Feedback -Analyse : kontinuierlich analysieren Sie das Feedback der Benutzer, um Verbesserungsbereiche zu identifizieren.

- Iterative Verfeinerung : Implementierung iterativer Prozesse zur Verfeinerung von Modellausgaben basierend auf Feedback.

Komprimierungswissen

Definition : Das Komprimieren von Wissen umfasst die Distelung großer Informationsmengen in ein kompaktes, nutzbares Format, das in den Kontext des KI -Modells passt.

Implementierung :

- Wissensabstraktion : Abstrahierende Regeln und Muster aus großen Datensätzen.

- Inhaltsübersicht : Zusammenfassung umfangreicher Inhalte zum Extrahieren von wesentlichen Informationen.

Schlussfolgerung

Definition : Inferenz ermöglicht es KI -Modellen, fundierte Vermutungen auf der Grundlage der verfügbaren Informationen vorzunehmen, auch wenn Daten unvollständig oder mehrdeutig sind.

Implementierung :

- Vorhersagemodellierung : Verwenden statistischer Modelle zur Vorhersage von Ergebnissen basierend auf Eingabedaten.

- Hypothesenerzeugung : Erzeugen und Testen von Hypothesen, um fehlende Informationen zu schließen.

Natürliche Sprachbedingungen

Definition : Natürliche Sprachbedingungen ermöglichen es Benutzern, Auswahlmöglichkeiten und Bedingungen in der natürlichen Sprache auszudrücken und Interaktionen intuitiver zu machen.

Implementierung :

- Sprachanalyse : Implementierung der Verarbeitung natürlicher Sprache, um Benutzerbefehle und -bedingungen zu interpretieren.

- Bedingungsbewertung : Bewertung von Bedingungen, die in der natürlichen Sprache ausgedrückt werden, um AI -Aktionen zu leiten.

Geräte

Kllm ist so konzipiert, dass sie mit einer Vielzahl von Geräten kompatibel ist und die Vielseitigkeit und breite Anwendbarkeit gewährleistet. Zu den geeigneten Geräten gehören:

- Laptops und Desktops : Computer mit ausreichender Leistung, um KI -Modelle lokal auszuführen.

- Smartphones : Mobile Geräte profitieren von der KI der On-Device-KI für verbesserte Funktionen und Offline-Funktionen.

- Tablets : Tragbare Geräte, die die lokale KI nutzen, um bessere Interaktionen und Leistung zu erzielen.

- Smartwatches : Wearables verwenden kleine Sprachmodelle für Sprachbefehle und Benachrichtigungen.

- Smart Home -Geräte : IoT -Geräte wie Smart -Lautsprecher und Home Assistenten, die KI zur Automatisierung und Kontrolle verwenden.

- Edge -Geräte : Computergeräte am Netzwerkkanten, die KI -Modelle lokal ausführen, um die Latenz zu verringern.

- Robotik- und Cyber-Physical-Systeme : KI-betriebene Systeme zur Navigation, Unterstützung und Erfindung in Fahrzeugen und Drohnen.

- Gesundheitsvorrichtungen : Medizinprodukte und Wearables verwenden KI für Gesundheitsüberwachung und personalisierte Empfehlungen.

- Industriegeräte : Maschinen mit KI für Vorhersagewartung, Prozessoptimierung und Automatisierung.

- Eingebettete Systeme : Spezialisierte Geräte mit integrierter KI für bestimmte Funktionen, die geringe Leistung und hohe Effizienz erfordern, z. B. Mikrocontroller und dedizierte Hardwarebeschleuniger.

Programmiersprachen

Kllm wird unter Verwendung einer Kombination der folgenden Programmiersprachen entwickelt, um eine optimale Leistung, Kompatibilität und Flexibilität zu gewährleisten:

- C/C ++ : Für Kernkernentwicklung und leistungskritische Komponenten.

- Java : Zum Aufbau robuster, plattformunabhängiger Anwendungen.

- Kotlin : Für moderne, prägnante und sichere Android -Entwicklung.

- DART : Zum Aufbau von schnellen, nativen und plattformübergreifenden mobilen Anwendungen.

- Rost : Für Programme auf Systemebene mit Sicherheit und Parallelität.

- Python : Für Skript-, Automatisierungs- und schnelle Prototypen.

- JavaScript/HTML/CSS : Zum Erstellen von webbasierten Anwendungen mit integrierten KI-Funktionen mithilfe von WebOS.

Datenkonformität

Kllm setzt sich dafür ein, dass die Einhaltung von Daten und Vorschriften der Daten zur Schützung von Benutzerdaten und zur Aufrechterhaltung der Privatsphäre sichergestellt wird. Zu den wichtigsten Konformitätsmaßnahmen gehören:

- Datenverschlüsselung : Alle übertragenen und gespeicherten Daten werden verschlüsselt, um vor unbefugtem Zugriff zu schützen.

- Zugriffskontrollen : Implementieren strenger Zugriffskontrollen, um sicherzustellen, dass nur autorisierte Mitarbeiter auf sensible Daten zugreifen können.

- Datenanonymisierung : Persönliche Daten werden anonymisiert, um die Identifizierung von Personen an den Daten zu verhindern.

- Vorschriftenregulierung : Einhaltung relevanter Datenschutzbestimmungen wie DSGVO, CCPA und HIPAA, sodass sichergestellt wird, dass alle Daten zur Datenbearbeitung den gesetzlichen Anforderungen entsprechen.

Modellkonformität

Kllm stellt sicher, dass alle KI -Modelle den ethischen Richtlinien und Branchenstandards entsprechen, um Fairness, Transparenz und Rechenschaftspflicht zu fördern. Zu den wichtigsten Konformitätsmaßnahmen gehören:

- Vorspannungsminderung : Implementierung von Techniken zur Identifizierung und Reduzierung von Verzerrungen in KI -Modellen, um faire und gerechte Ergebnisse zu gewährleisten.

- Transparenz : Bereitstellung einer klaren Dokumentation zu Modellentwicklung, Schulungsdaten und Entscheidungsprozessen zur Verbesserung der Transparenz.

- Rechenschaftspflicht : Festlegen von Mechanismen zur Überwachung und Prüfung der KI -Modellleistung, um die Rechenschaftspflicht und eine kontinuierliche Verbesserung sicherzustellen.

- Ethische Standards : Einhaltung ethischer Richtlinien für die Entwicklung und Bereitstellung von KI, Förderung der verantwortungsvollen und ethischen Verwendung von AI -Technologien.

FOSS -Lizenz

Kllm wird unter der MIT -Lizenz veröffentlicht, einer freizügigen freien Softwarelizenz, die Wiederverwendung, Änderung und Verteilung ermöglicht. Der vollständige Lizenztext ist in der LICENSE verfügbar. Zu den wichtigsten Punkten der MIT -Lizenz gehören:

- Genehmigung : Die Berechtigung wird erteilt, die Software zu verwenden, zu kopieren, zu ändern und zu verteilen.

- Zuschreibung : Die Lizenz verlangt, dass die ursprüngliche Copyright -Mitteilung und die Berechtigungsbekanntmachung in alle Kopien oder wesentlichen Teile der Software enthalten sind.

- Haftung : Die Software wird "wie ist" ohne Garantie jeglicher Art, ausdrücklich oder stillschweigend bereitgestellt, einschließlich, aber nicht beschränkt auf die Gewährleistung der Marktgängigkeit, die Eignung für einen bestimmten Zweck und die Nichtverletzung.

Lizenz

Kllm ist unter der MIT -Lizenz lizenziert. Weitere Informationen finden Sie in der LICENSE .

Kllm enthält kleinere, optimierte Sprachmodelle (kleine LMS), die auf bestimmte Gerätefunktionen zugeschnitten sind. Diese Modelle verbessern die Fähigkeit des Geräts, Benutzerbefehle effizient zu verstehen und auf Benutzerbefehle zu reagieren:

Kllm enthält kleinere, optimierte Sprachmodelle (kleine LMS), die auf bestimmte Gerätefunktionen zugeschnitten sind. Diese Modelle verbessern die Fähigkeit des Geräts, Benutzerbefehle effizient zu verstehen und auf Benutzerbefehle zu reagieren: Durch die Integration kognitiver Funktionen direkt in das mobile Betriebssystem ermöglicht Kllm intelligentere und intuitivere Interaktionen zwischen Benutzern und ihren Geräten:

Durch die Integration kognitiver Funktionen direkt in das mobile Betriebssystem ermöglicht Kllm intelligentere und intuitivere Interaktionen zwischen Benutzern und ihren Geräten: Kllm verwendet eine robuste Finite-State-Maschinenarchitektur, um die Zustände und Übergänge innerhalb des Kernels zu verwalten:

Kllm verwendet eine robuste Finite-State-Maschinenarchitektur, um die Zustände und Übergänge innerhalb des Kernels zu verwalten: Sentinel AI ist eine in Kllm integrierte erweiterte Überwachungs- und Sicherheitsfunktion. Es bietet Echtzeitüberwachung und Schutz für KI-Modelle und Anwendungen:

Sentinel AI ist eine in Kllm integrierte erweiterte Überwachungs- und Sicherheitsfunktion. Es bietet Echtzeitüberwachung und Schutz für KI-Modelle und Anwendungen: