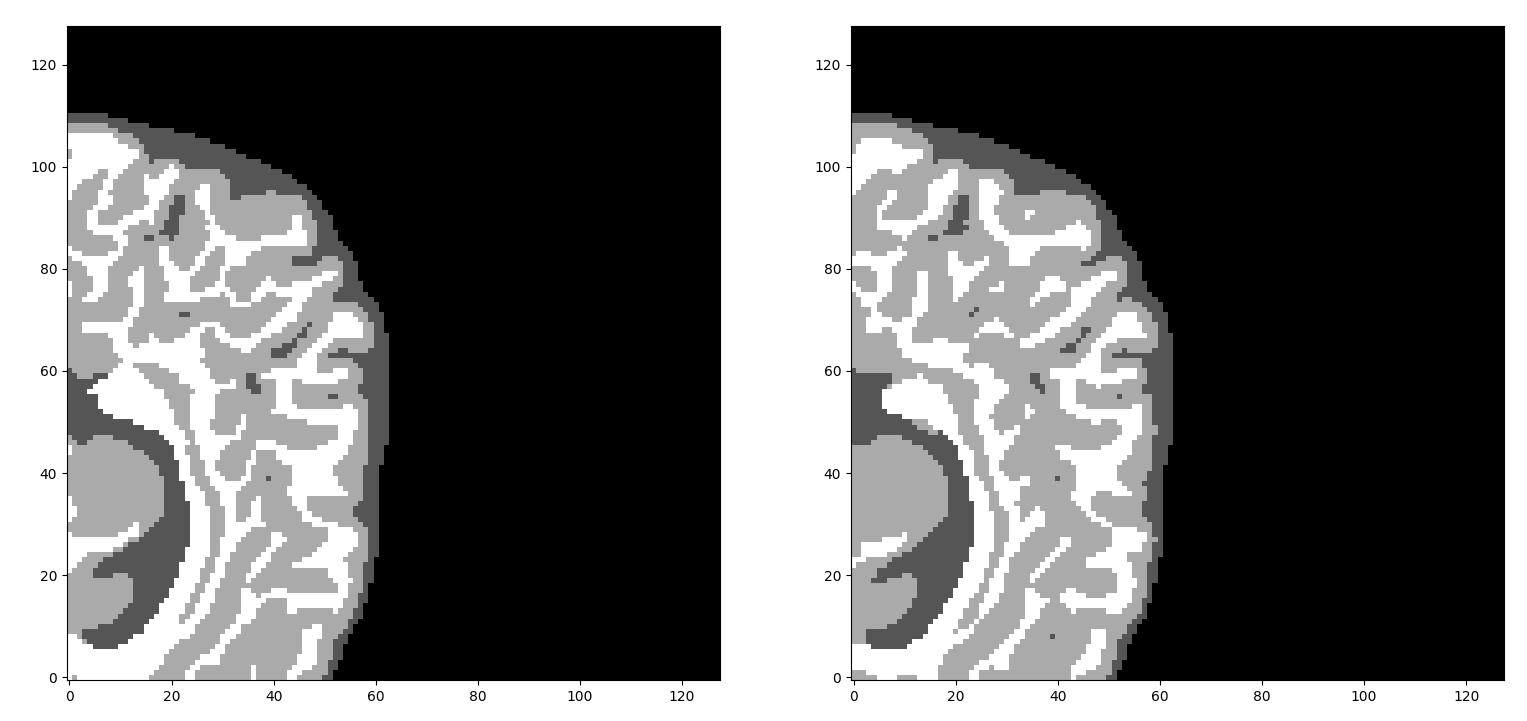

Acreditamos fortemente em pesquisas de aprendizado profundo aberto e reproduzível . Nosso objetivo é implementar uma biblioteca de segmentação de imagens médicas de código aberto das redes neurais profundas em Pytorch . Também implementamos vários carregadores de dados dos conjuntos de dados de imagem médica mais comuns. Este projeto começou como uma tese de mestrado e está atualmente sob desenvolvimento adicional. Embora este trabalho tenha sido inicialmente focado na segmentação de ressonância magnética do cérebro multimodal 3D, estamos adicionando lentamente mais arquiteturas e carregadores de dados.

[ATUALIZAÇÃO] 21-07 Acabamos de receber uma GPU nova. O projeto do projeto foi adiado devido à falta de recursos computacionais. Voltaremos com mais atualizações. Assista ao nosso repositório do GitHub para que os lançamentos sejam notificados. Estamos sempre em busca de contribuições apaixonados de código aberto. Créditos completos serão dados.

Se você deseja entender rapidamente os conceitos fundamentais para o aprendizado profundo em imagens médicas, aconselhamos fortemente a verificação da nossa postagem no blog. Fornecemos uma visão geral de alto nível de todos os aspectos da segmentação de imagens médicas e aprendizado profundo. Para uma visão geral mais ampla dos aplicativos de ressonância magnética, encontre meu artigo de revisão mais recente.

Para compreender conceitos de imagem médica mais fundamentais, confira nosso post sobre sistemas de coordenadas e imagens DICOM.

Para uma abordagem mais holística para o aprendizado profundo na ressonância magnética, você pode aconselhar minha tese.

Como alternativa, você pode criar um ambiente virtual e instalar os requisitos. Verifique a pasta de instalação para obter mais instruções.

Você também pode dar uma rápida olhada no manual.

Se você não tiver um ambiente ou dispositivo capaz para executar esses projetos, experimente o Google Colab. Ele permite que você execute o projeto usando um dispositivo GPU, gratuitamente. Você pode tentar nossa demonstração do Colab usando este notebook:

| Tarefa | Informações sobre dados/ modalidades | Trem/teste | Tamanho do volume | Classes | Tamanho do conjunto de dados (GB) |

|---|---|---|---|---|---|

| ISEG 2017 | T1, T2 | 10/10 | 144x192x256 | 4 | 0,72 |

| ISEG 2019 | T1, T2 | 10/13 | 144x192x256 | 4 | 0,75 |

| Miccai Brats2018 | Flair, T1W, T1GD, T2W | 285 / - | 240x240x155 | 9 ou 4 | 2.4 |

| Miccai Brats2019 | Flair, T1W, T1GD, T2W | 335 /125 | 240x240x155 | 9 ou 4 | 4 |

| MRBRAINS 2018 | Flair, T1W, T1GD, T2W | 8 | 240x240x48 | 9 ou 4 | 0,5 |

| Conjunto de dados de desenvolvimento cerebral ixi | T1, T2 Sem rótulos | 581 | (110 ~ 150) x256x256 | - | 8.7 |

| Desafio Miccai Gleason 2019 | Imagens de patologia 2D | ~ 250 | 5k x 5k | - | 2.5 |

| Modelo | # Params (m) | Macs (G) | ISEG 2017 DSC (%) | MR-Brains 4 Classes DSC (%) |

|---|---|---|---|---|

| UNET3D | 17 m | 0,9 | 93.84 | 88.61 |

| Vnet | 45 m | 12 | 87.21 | 84.09 |

| Densenet3d | 3 m | 5.1 | 81.65 | 79.85 |

| Skipdensenet3d | 1,5 m | 31 | - | - |

| Densevoxelnet | 1,8 m | 8 | - | - |

| HyperdensEnet | 10,4 m | 5.8 | - | - |

python ./examples/train_iseg2017_new.py --args

python ./examples/train_mrbrains_4_classes.py --args

python ./examples/train_mrbrains_9_classes.py --args

python ./examples/test_miccai_2019.py --args

python ./tests/inference.py --args

Fornecemos algumas implementações em torno do Covid-19 para fins humanitários. Em detalhes:

Conjunto de dados CoVID-CT

Conjunto de dados COVIDX

Se você realmente gosta deste repositório e achar útil, considere (★) estrelado , para que ele possa atingir um público mais amplo de pessoas que pensam da mesma forma. Seria muito apreciado :)!

Se você encontrar um bug, criar um problema do GitHub ou, melhor ainda, envie uma solicitação de tração. Da mesma forma, se você tiver dúvidas, basta publicá -las como problemas do GitHub. Mais informações sobre o diretório de contribuir.

Por favor, aconselhe o arquivo licença.md . Para o uso de bibliotecas e repositórios de terceiros, informe os respectivos termos distribuídos. Seria bom citar os modelos e conjuntos de dados originais . Se você quiser, você também pode citar este trabalho como:

@MastersThesis{adaloglou2019MRIsegmentation,

author = {Adaloglou Nikolaos},

title={Deep learning in medical image analysis: a comparative analysis of

multi-modal brain-MRI segmentation with 3D deep neural networks},

school = {University of Patras},

note="url{https://github.com/black0017/MedicalZooPytorch}",

year = {2019},

organization={Nemertes}}

Em geral, na comunidade de código aberto, o reconhecimento de serviços públicos de terceiros aumenta a credibilidade do seu software. Na aprendizagem profunda, os acadêmicos tendem a pular reconhecer repositórios de terceiros por algum motivo . Em essência, usamos qualquer recurso que precisássemos para tornar esse projeto auto-preenchido, que foi bem escrito. No entanto, foram realizadas modificações para corresponder à estrutura e requisitos do projeto . Aqui está a lista dos principais trabalhos : Modelo HyperDensenet. A maioria das perdas de segmentação daqui. Modelo 3D-SKIPDENSENET daqui. Modelo base 3D-RESNET A partir daqui. Classe de modelo abstrato do projeto de imitação. Treinador e aula de escritor do modelo Pytorch. A implementação do Covid-19 com base em nosso trabalho anterior daqui. Miccai 2019 Gleason Challenge Carregadores de dados com base em nosso trabalho anterior daqui. Implementação 2D básica de aqui.VNET Modelo daqui