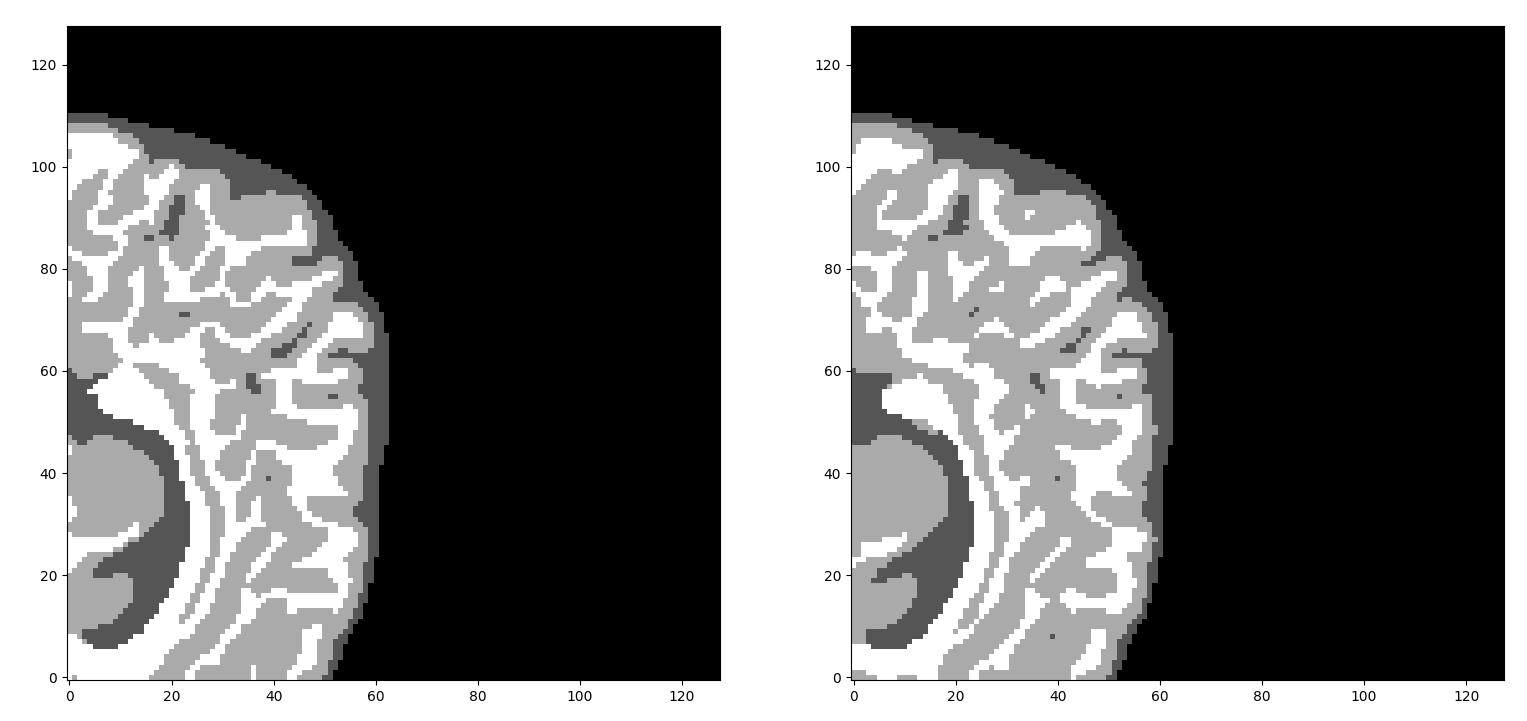

Nous croyons fermement à la recherche ouverte et reproductible en Deep Learning . Notre objectif est de mettre en œuvre une bibliothèque de segmentation d'image médicale open source Open de statut des réseaux de neurones profonds 3D à Pytorch . Nous avons également implémenté un tas de chargeurs de données des ensembles de données d'image médicale les plus courants. Ce projet a commencé comme une thèse MSC et est actuellement en cours de développement. Bien que ce travail ait été initialement axé sur la segmentation 3D de l'IRM cérébrale multimodale, nous ajoutons lentement plus d'architectures et de chargeurs de données.

[MISE À JOUR] 21-07 Nous venons de recevoir un tout nouveau GPU. Le projet développé a été reporté en raison du manque de ressources informatiques. Nous reviendrons avec plus de mises à jour. Veuillez regarder notre référentiel GitHub pour les versions à notifier. Nous recherchons toujours des contributions passionnées open-source. Des crédits complets seront accordés.

Si vous souhaitez comprendre rapidement les concepts fondamentaux de l'apprentissage en profondeur dans l'imagerie médicale, nous conseillons fortement de consulter notre article de blog. Nous fournissons un aperçu général de haut niveau de tous les aspects de la segmentation des images médicales et de l'apprentissage en profondeur. Pour un aperçu plus large des applications d'IRM, trouvez mon dernier article de revue.

Pour saisir des concepts d'imagerie médicale plus fondamentaux, consultez notre article sur les systèmes de coordonnées et les images DICOM.

Pour une approche plus holistique sur l'apprentissage en profondeur dans l'IRM, vous pouvez conseiller ma thèse ceci.

Alternativement, vous pouvez créer un environnement virtuel et installer les exigences. Vérifiez le dossier d'installation pour plus d'instructions.

Vous pouvez également jeter un coup d'œil au manuel.

Si vous n'avez pas un environnement ou un appareil capable pour exécuter ces projets, vous pouvez essayer Google Colab. Il vous permet d'exécuter gratuitement le projet à l'aide d'un appareil GPU. Vous pouvez essayer notre démo Colab en utilisant ce cahier:

| Tâche | Informations / modalités de données | Train / test | Volume | Classes | Taille de l'ensemble de données (GB) |

|---|---|---|---|---|---|

| ISEG 2017 | T1, T2 | 10/10 | 144x192x256 | 4 | 0,72 |

| ISEG 2019 | T1, T2 | 10/13 | 144x192x256 | 4 | 0,75 |

| Miccai Brats2018 | Flair, T1W, T1GD, T2W | 285 / - | 240x240x155 | 9 ou 4 | 2.4 |

| Miccai Brats2019 | Flair, T1W, T1GD, T2W | 335/125 | 240x240x155 | 9 ou 4 | 4 |

| MRBRAINS 2018 | Flair, T1W, T1GD, T2W | 8 | 240x240x48 | 9 ou 4 | 0,5 |

| Ensemble de données de développement du cerveau ixi | T1, T2 pas d'étiquettes | 581 | (110 ~ 150) x256x256 | - | 8.7 |

| Miccai Gleason 2019 Challenge | Images de pathologie 2D | ~ 250 | 5k x 5k | - | 2.5 |

| Modèle | # Params (m) | MACS (G) | DSC ISEG 2017 (%) | MR-BRAINS 4 classes DSC (%) |

|---|---|---|---|---|

| Unet3d | 17 m | 0.9 | 93.84 | 88,61 |

| Vnet | 45 m | 12 | 87.21 | 84.09 |

| Densenet3d | 3 m | 5.1 | 81,65 | 79.85 |

| Skipdeneset3d | 1,5 m | 31 | - | - |

| Densevoxelnet | 1,8 m | 8 | - | - |

| Hyperdensenet | 10,4 m | 5.8 | - | - |

python ./examples/train_iseg2017_new.py --args

python ./examples/train_mrbrains_4_classes.py --args

python ./examples/train_mrbrains_9_classes.py --args

python ./examples/test_miccai_2019.py --args

python ./tests/inference.py --args

Nous fournissons certaines implémentations autour de Covid-19 à des fins humanitaires. En détails:

Ensemble de données Covid-CT

Ensemble de données Covidx

Si vous aimez vraiment ce référentiel et que vous le trouvez utile, veuillez considérer (★) en le avec, afin qu'il puisse atteindre un public plus large de personnes partageant les mêmes idées. Ce serait très apprécié :)!

Si vous trouvez un bogue, créez un problème GitHub, ou même mieux, soumettez une demande de traction. De même, si vous avez des questions, publiez-les simplement en tant que problèmes de github. Plus d'informations sur le répertoire Contribue.

Veuillez conseiller le fichier licence.md . Pour l'utilisation des bibliothèques et des référentiels tiers, veuillez conseiller les termes distribués respectifs. Ce serait bien de citer les modèles et ensembles de données originaux . Si vous le souhaitez, vous pouvez également citer ce travail comme:

@MastersThesis{adaloglou2019MRIsegmentation,

author = {Adaloglou Nikolaos},

title={Deep learning in medical image analysis: a comparative analysis of

multi-modal brain-MRI segmentation with 3D deep neural networks},

school = {University of Patras},

note="url{https://github.com/black0017/MedicalZooPytorch}",

year = {2019},

organization={Nemertes}}

En général, dans la communauté open source, la reconnaissance des services publics tiers augmente la crédibilité de votre logiciel. Dans le Deep Learning, les universitaires ont tendance à ignorer les référentiels de tiers pour une raison quelconque . Essentiellement, nous avons utilisé la ressource dont nous avions besoin pour rendre ce projet à bien sûr, qui a été bien écrit. Cependant, des modifications ont été effectuées pour correspondre à la structure et aux exigences du projet . Voici la liste des œuvres les plus basses : HyperdenseNet Model. La plupart des pertes de segmentation d'ici. Modèle 3D-SkipDensenet d'ici. Modèle de base 3D-Resnet d'ici. Classe de modèle abstrait du projet mimétisme. Classe d'entraîner et d'écrivain du modèle Pytorch. Implémentation Covid-19 basée sur nos travaux précédents à partir d'ici. Miccai 2019 Gleason Challenge Data-chargers en fonction de nos travaux précédents à partir d'ici. Implémentation de base 2D Unet à partir d'ici le modèle Vnet à partir d'ici