OpenAi는 최근 AI 프로그래밍 기능에 대한 평가 보고서를 발표하여 100 만 달러의 실제 개발 프로젝트를 통해 소프트웨어 개발 분야에서 AI의 현재 상태를 밝혀 냈습니다. SWE-Lancer라고하는 벤치 마크는 Upwork의 1,400 개의 실제 프로젝트를 다루며 직접 개발 및 프로젝트 관리에서 AI의 성능을 종합적으로 평가합니다. 이 테스트는 프로그래밍 작업에서 AI의 잠재력을 보여줄뿐만 아니라 미래의 기술 개발에 대한 중요한 참조를 제공합니다.

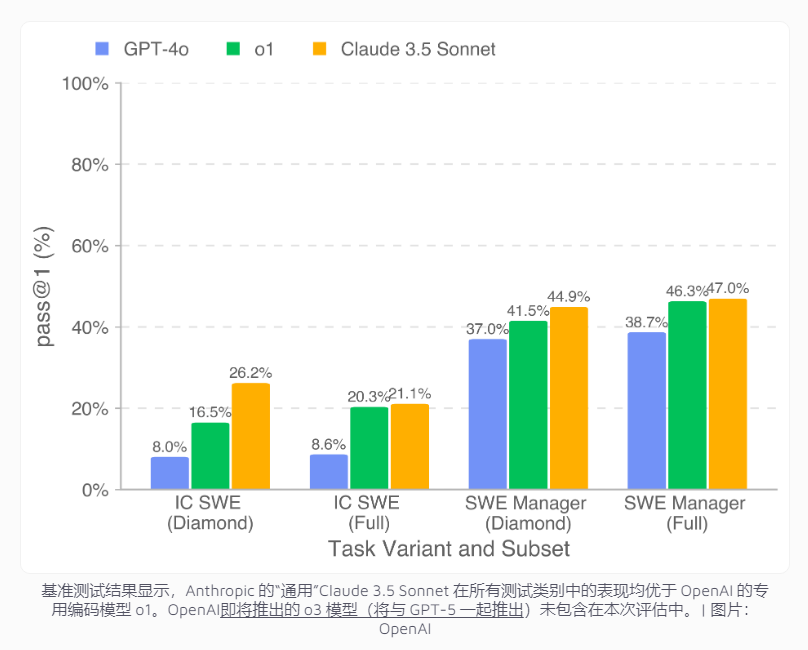

테스트 결과에 따르면 최상의 성과의 AI 모델 인 Claude3.5Sonnet은 코딩 작업에서 26.2%, 프로젝트 관리 의사 결정에서 44.9%의 성공률을 보였습니다. 이 성과는 여전히 인간 개발자의 성과와는 거리가 멀지 만 경제적 이익 측면에서 상당한 잠재력을 보여주었습니다. 특히 공개 다이아몬드 데이터 세트 에서이 모델은 프로젝트 개발에서 $ 208,050를 완료 할 수 있습니다. 전체 데이터 세트로 확장되면 AI는 40 만 달러 이상의 작업을 처리 할 것으로 예상되며, 이는 기업이 소프트웨어 개발에 많은 비용을 절약 할 수있는 가능성을 제공합니다.

그러나 연구에 따르면 복잡한 개발 작업에서 AI의 명백한 한계가 나타납니다. AI는 중복 API 통화 수정과 같은 간단한 버그 수정에 유능하지만, 심층적 인 이해가 필요한 복잡한 프로젝트와 교차 플랫폼 비디오 재생 기능 개발과 같은 포괄적 인 솔루션이 필요한 복잡한 프로젝트에 직면 할 때 성능이 저하됩니다. AI가 종종 문제 코드를 식별 할 수 있다는 것은 특히 주목할 만하지 만 근본 원인을 이해하고 포괄적 인 솔루션을 제공하기는 어렵습니다. 이는 소프트웨어 개발에서 AI의 적용에 여전히 추가 기술 혁신이 필요하다는 것을 보여줍니다.

이 분야의 연구를 홍보하기 위해 OpenAi는 SWE-Lancer Diamond DataSet 및 GitHub의 관련 도구를 공개하여 연구원이 통합 표준을 기반으로 다양한 프로그래밍 모델의 성능을 평가할 수있었습니다. 이러한 움직임은 AI 프로그래밍 기능의 추가 개선을위한 중요한 참조를 제공 할뿐만 아니라 글로벌 개발자 커뮤니티에 귀중한 리소스를 제공하고 일반적인 기술 진보를 촉진합니다.