Openaiは最近、AIプログラミング機能に関する評価レポートをリリースし、100万ドルの実際の開発プロジェクトを通じてソフトウェア開発の分野におけるAIの現在の状況を明らかにしました。 SWE-Lancerと呼ばれるベンチマークは、アップワークから1,400の実際のプロジェクトをカバーし、直接開発とプロジェクト管理の両方においてAIのパフォーマンスを包括的に評価しています。このテストは、プログラミングタスクにおけるAIの可能性を実証するだけでなく、将来の技術開発のための重要な参照も提供します。

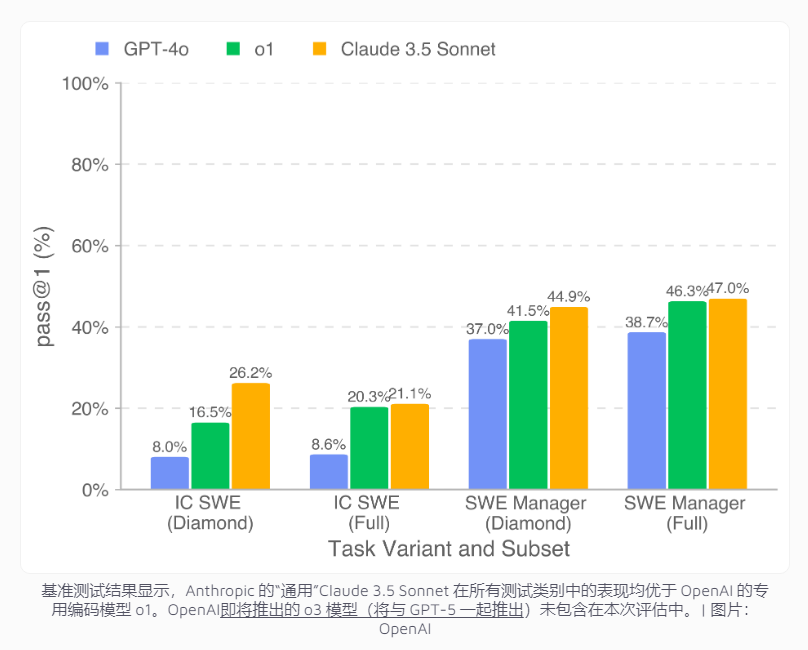

テスト結果は、最高のパフォーマンスのAIモデルであるClaude3.5Sonnetが、コーディングタスクで26.2%、プロジェクト管理の意思決定で44.9%の成功率を示したことを示しています。この成果はまだ人間の開発者の成果とはほど遠いものの、経済的利益の点でかなりの可能性を示しています。特に公共のダイヤモンドデータセットでは、モデルはプロジェクト開発で208,050ドルを完了することができます。完全なデータセットに拡張された場合、AIは400,000ドルを超えるタスクを処理することが期待されています。これにより、企業がソフトウェア開発のコストを多く節約できる可能性があります。

ただし、研究により、複雑な開発タスクにおけるAIの明らかな限界も明らかになりました。 AIは、冗長なAPI呼び出しの修正など、簡単なバグ修正の能力がありますが、クロスプラットフォームのビデオ再生機能開発など、詳細な理解と包括的なソリューションを必要とする複雑なプロジェクトに直面すると、パフォーマンスが低下します。 AIが多くの場合問題コードを特定できることは特に注目に値しますが、根本原因を理解し、包括的なソリューションを提供することは困難です。これは、ソフトウェア開発におけるAIの適用には、さらに技術的なブレークスルーが必要であることを示しています。

この分野での研究を促進するために、OpenaiはGitHubのSWE-Lancerダイヤモンドデータセットと関連ツールを開いており、研究者は統一された基準に基づいてさまざまなプログラミングモデルのパフォーマンスを評価できるようにしました。この動きは、AIプログラミング機能をさらに改善するための重要なリファレンスを提供するだけでなく、グローバルな開発者コミュニティに貴重なリソースを提供し、共通の技術の進歩を促進します。