최근에는 인공 지능 (AI)이 프로그래밍 분야에서 점점 더 널리 사용되고 있지만 그 기능에는 여전히 특정 제한 사항이 있습니다. 최근 BuzzFeed의 선임 데이터 과학자 인 Max Woolf는 일련의 실험을 통해 AI가 생성 한 코드 품질이 LLM (Lange Language Model)에 대한 팁을 지속적으로 제공함으로써 크게 향상 될 수 있음을 발견했습니다. 이 발견은 기술 서클에서 격렬한 토론을 불러 일으킬뿐만 아니라 많은 AI 과학자들의 관심을 끌었으며 AI 프로그래밍에서 반복 최적화와 신속한 단어 설계의 중요성을 더욱 강조했습니다.

Woolf의 실험에서 그는 AI 모델 Claude3.5sonnet을 연구 대상으로 선택했습니다. 실험의 첫 번째 단계는 모델이 비교적 간단한 프로그래밍 문제를 해결하도록하는 것입니다. 각 숫자의 합의 최소값과 최대 값의 차이를 찾는 방법은 백만 백만의 임의 정수에서 30입니다. 작업을 수신 한 후 Claude는 요구 사항을 충족하는 코드를 신속하게 생성했지만 Woolf는이 코드에 여전히 개선의 여지가 있다고 생각합니다.

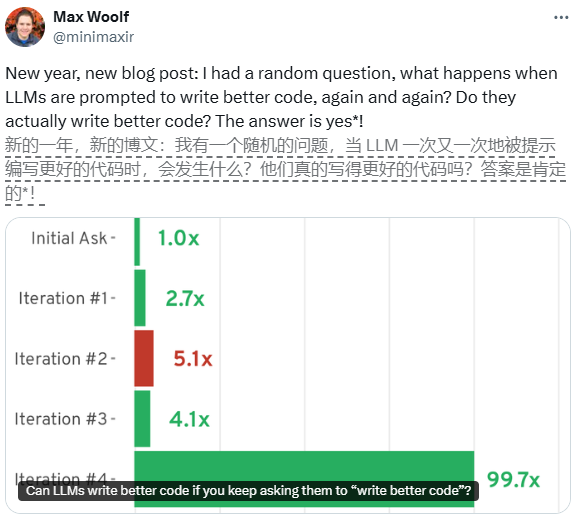

코드를 추가로 최적화하기 위해 Woolf는 각 세대의 코드 후 Claude에게 반복적으로 반복적으로 최적화하도록 요청하기로 결정했습니다. 첫 번째 반복 후 Claude는 코드를 객체 지향 Python 클래스로 리팩토링하고 두 가지 중요한 최적화를 구현하여 코드를 2.7 배 더 빠르게 증가 시켰습니다. 두 번째 반복에서 Claude는 멀티 스레드 처리 및 벡터 화 컴퓨팅을 추가로 도입하여 궁극적으로 코드가 기본 버전보다 5.1 배 더 빠르게 실행할 수있게했습니다.

그러나 반복 횟수가 증가함에 따라 코드 품질의 개선이 점차 느려집니다. 이 모델은 후속 반복에서 JIT 컴파일 및 비동기 프로그래밍과 같은보다 복잡한 기술을 시도했지만 이러한 최적화는 예상 성능 향상을 가져 오지 않았으며 경우에 따라 성능 저하로 이어졌습니다. 이 현상은 반복적 인 힌트가 초기 단계에서 코드 품질을 크게 향상시킬 수 있지만 특정 수준에 도달 한 후에도 그 효과가 점차 약화 될 것임을 보여줍니다.

Woolf의 실험은 프로그래밍 분야에서 AI의 큰 잠재력을 보여줄뿐만 아니라 실제 응용 분야의 한계를 보여줍니다. AI는 반복적으로 코드를 최적화 할 수 있지만, 신속한 단어를 설계 할 때 성능과 복잡성의 균형을 맞추는 방법은 여전히 심층적으로 논의 해야하는 문제입니다. 이 연구는 향후 AI 프로그래밍에 대한 새로운 아이디어를 제공하며 AI가 전능하지 않으며 합리적인 사용 및 최적화 전략이 핵심임을 상기시킵니다.